YB

Size: a a a

2016 November 15

to goof — make a mistake

AB

так вот и вопрос, что же он выдал в таком случае. то, что "(I convinced her children) + are noisy" - это возможное грамматически предложение?

YB

нет, аграмматическое

YB

"On the other hand, it goofed on:" — парсер просто неправильно их разобрал

YB

второго значения там нет, парсер просто делает ошибку на таких предложениях, пытаясь сначала собрать первую часть предложения и потом к этой части прилепить вторую часть. конечно же, получается хреново.

YB

автоматический переводчик тем более сделает эту же ошибку — можно сказать, что, по сути, парсеры считают, что пользователь дал предложение с ошибкой, и они исправили ошибку.

AB

нет, аграмматическое

с точки зрения tensorflow?

YB

с т.з. syntaxnet нет такого понятия

YB

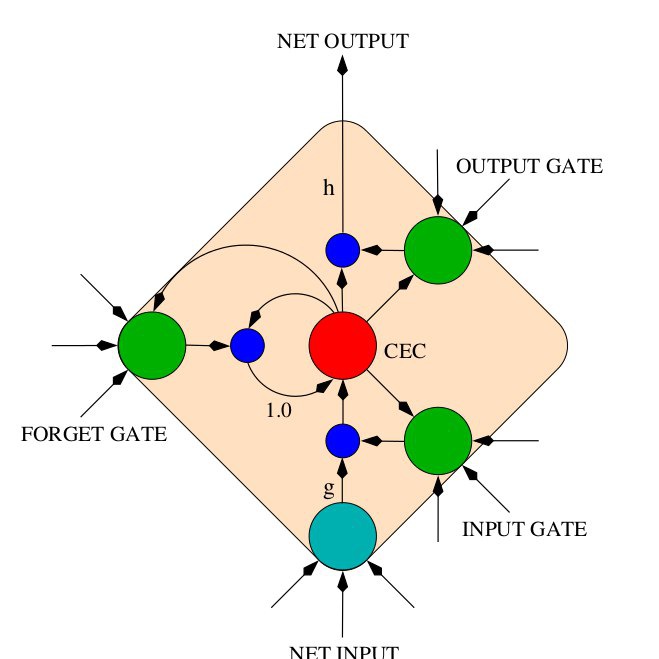

там shift-reduce внутри

YB

проход почти линейный (кажется, хранится несколько вариантов всё же) — в каждый момент нужно принимать решение между shift и reduce.

AB

второго значения там нет, парсер просто делает ошибку на таких предложениях, пытаясь сначала собрать первую часть предложения и потом к этой части прилепить вторую часть. конечно же, получается хреново.

то есть он не выбирает из двух возможных древ одно (и неверное), а просто генерирует одно (и неверное)?

AB

ну вот так и вернемся к CFG.

YB

но при генерации он же на все окружающие слова смотрит.

YB

в CFG/lexicalised CFG такого всё же нет, есть правила свёртки, а не вероятности правил.

AB

может, у них как и у Link Grammar от OpenCog проблема с распознаванием и выявлением phantom nodes?

Полностью же предложение "I convinced her THAT children are noisy"

Полностью же предложение "I convinced her THAT children are noisy"

YB

ну, garden path sentence это лишь способ проиллюстрировать проблему

YB

двойные отрицания, выбор валентного слова — это та же проблема: нелинейность представления

YB

нейросети умеют нелинейность, но ограниченно

AB

тогда это практически та же болезнь, что и у phrase structure grammar. С английским еще ничего, а русский уже не подходит.