YB

Size: a a a

2016 November 15

скажем так, это проблема взвешивания. требуется много мозгов, чтобы правильно учесть все факторы и взвесить их. если мозгов мало, то взвешивание будет не всегда давать правильный результат.

YB

в случае LinkGrammar — правила взвешивания зашиваются в правила. я тоже так делал, когда свой парсер пытался писать.

YB

а какая разметка будет — грамматика составляющих или зависимостей, phrase grammar или link grammar — не так важно.

YB

важно, чтобы у модели было достаточно мозгов выбираться из тупиков в нелинейных ситуациях и правильно делать учёт факторов.

YB

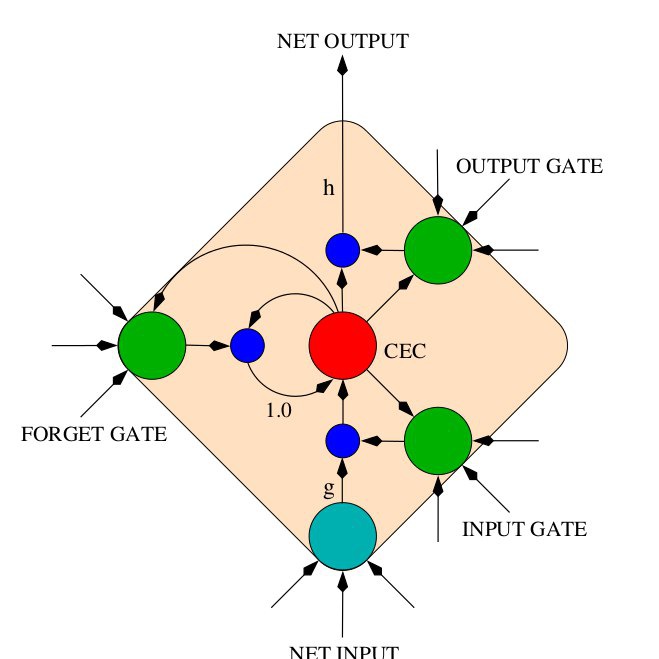

и вот иерархия LSTM, которая в seq2seq моделях — она, с одной стороны, позволяет внутри последние N слов держать в памяти и их учитывать для принятия решений. но всё равно нелинейностей слишком много, чтобы в 100M параметров модели их уместить (и при этом оттюнить веса для принятия решений).

AB

всё-таки раз несколько древ tensorflow в уме держит, то должен выпутываться. может кэша не хватает держать много вариантов?😄

YB

а щас посмотрим, я не помню, несколько ли

YB

но даже если несколько — если вес "I convinced her children" очень высокий, то модель стремится связать именно их друг с другом.

YB

в этом проблема взвешивания

YB

и она забивает на маленький штрафной вес остальных связей.

AB

просто странно. если она выдает такой парсинг, то где подобные древа в других предложениях? ведь в этом предложении просто грубо говоря strict typing нарушен.

Как "I convinced her children" может быть актантом глагола "to be noisy"???

Как "I convinced her children" может быть актантом глагола "to be noisy"???

YB

ага, "beam size of 8", задаётся при построении модели (видимо beam factor нужен для rescoring).

YB

просто странно. если она выдает такой парсинг, то где подобные древа в других предложениях? ведь в этом предложении просто грубо говоря strict typing нарушен.

Как "I convinced her children" может быть актантом глагола "to be noisy"???

Как "I convinced her children" может быть актантом глагола "to be noisy"???

вопрос баланса штрафа за прикрепление. можно в онлайне посмотреть кстати как оно работает.

YB

а может и нет

YB

я завтра пример этого разбора для тебя сделаю (если у меня всё ещё syntaxnet работает).

YB

а, онлайн-демо было у spacy

YB

"On the time-honoured benchmark for this task, Parsey McParseface achieves over 94% accuracy, at around 600 words per second. On the same task, spaCy achieves 92.4%, at around 15,000 words per second"

AB

а, онлайн-демо было у spacy

думаю, там вряд ли beam size можно менять :)

YB

так у parsey тоже...