MK

Size: a a a

2020 May 07

да у меня также бывает, вот прям только что ) c 0.3 работало, удалил фичи некоторые и сразу переобучаться начал, уменшил lr и пошло

MK

просто другой lr поставь или SEED попробуй другой

OT

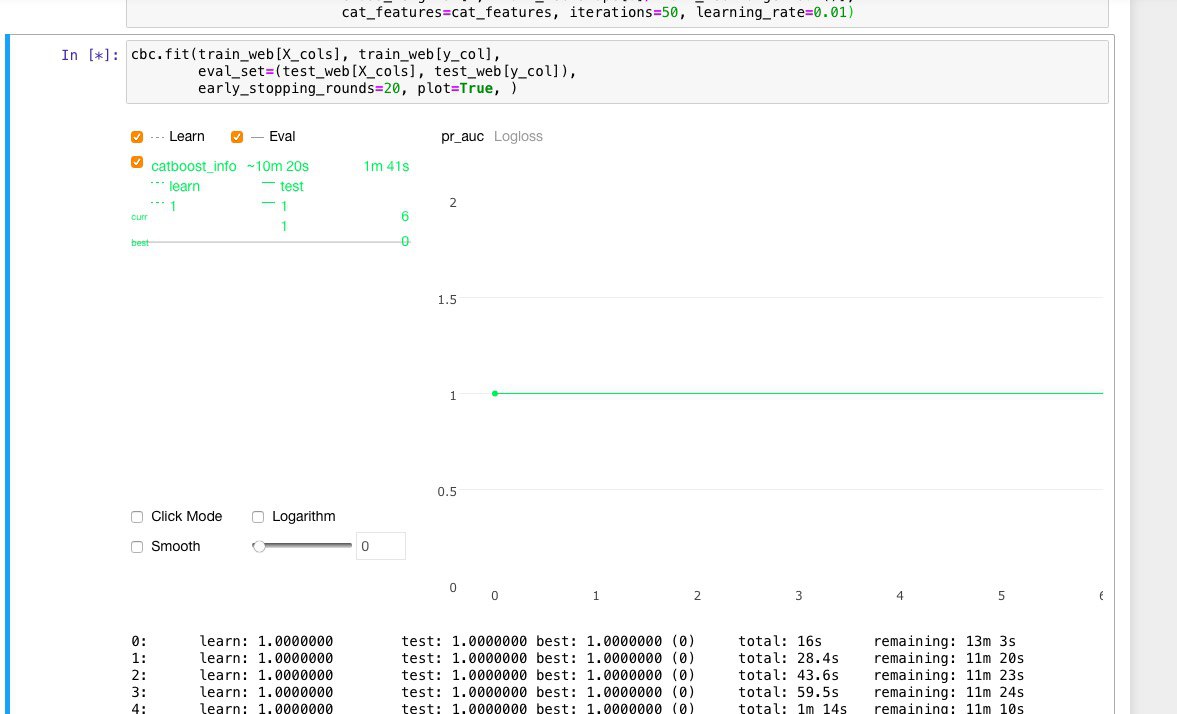

random_state менял, lr поставил 0.01 b и все равно

OT

и на трейне и на тесте одинаково идеальные результаты

MK

ну таргет не удалил значит

MK

да, может таргет в фичи попал

NT

важность фичей посмотри

OT

да, так и сделал. Все, тайна разгадана)) Перепутал название фичей и забыл что таргет формировался на основании как раз этой фичи

A

Здравствуйте, в predict можно указать ntree_start и ntree_end. Если взять с 100 по 200. То будет ли прогноз осмысленным? Из теории бустинга, каждое следующее дерево обучается на ошибке всех предыдущих. Если мы выкинем первые 100 деревьев, то не будет ли прогноз хаотичным? Ведь ошибка первых 100 будет неизвестна. А вторая сотня обучена на этой ошибке первых 100. Например первые 100 улучшили модель до 90%. А вторая сотня ещё на 2%. Выкинув первые 100, не получим ли точность около 50% т.е. случайный результат?

AD

Alexey Kuznetsov

Здравствуйте, в predict можно указать ntree_start и ntree_end. Если взять с 100 по 200. То будет ли прогноз осмысленным? Из теории бустинга, каждое следующее дерево обучается на ошибке всех предыдущих. Если мы выкинем первые 100 деревьев, то не будет ли прогноз хаотичным? Ведь ошибка первых 100 будет неизвестна. А вторая сотня обучена на этой ошибке первых 100. Например первые 100 улучшили модель до 90%. А вторая сотня ещё на 2%. Выкинув первые 100, не получим ли точность около 50% т.е. случайный результат?

Ненулевой ntree_start нужно использовать только в том случае, если ты по каким-то причинам решил посмотреть на предсказания без скольких-то первых деревьев. Большинству пользователей это не нужно.

A

У вас последующие деревья учатся на ошибках предыдущих?

AU

Это вполне осмысленная операция, если используется model shrinkage, например

A

У вас последующие деревья учатся на ошибках предыдущих?

AU

А как можно иначе?

A

Хорошо. Спасибо. Тогда в прогнозе на средних деревьях без первых смысла точно нет, как и в shrink- е. Может быть они что то и дадут при eta =0.0001. но при 0.1 и выше без 10 первых деревьев результат прогноза будет плохой

AU

Не всегда, повторю, при model shrinkage первые деревья почти нулевые получаются

AU

Это если выставлена опция —model-shrink-rate

A

Поизучаю... Спасибо

2020 May 08

IP

Будет ли поддержка

plot в PyCharm?2020 May 09

b

Не всегда, повторю, при model shrinkage первые деревья почти нулевые получаются

А почему?