SK

Size: a a a

2020 April 29

Спасибо

SK

По поводу баги с кастомной квантизацией - там же у тебя в этой колонке правда есть Nan?

MK

SK

Ok, фикс будет в следующем миноре

MK

спасибо)

2020 April 30

OT

подскажите где в коде катбуста найти реализацию eval_metric для AUC

OT

хочу понять как мне PR AUC реализовать в качестве кастомной метрики. Примеры из документации я видел

AD

pr auc сейчас на ревью в пулреквесте

OT

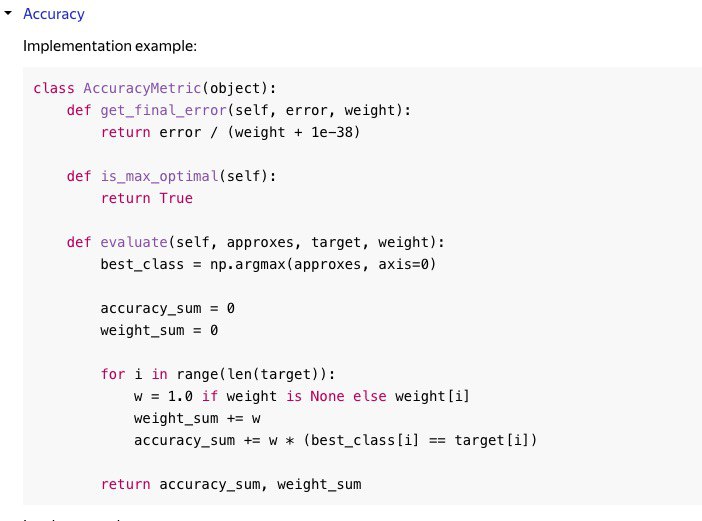

еще вопрос про кастомные метрики: заметил в примере реализации accuracy что вычисление идет итеративно через цикл, почему это не делается по "питоновски" когда используется numpy или просто через слайсы производятся операции ?

OT

AD

это пример в документации же, его задача - показать, как лосс написать

AD

но вообще кастомные метрики лучше писать в плюсах, будет работать намного быстрее

AD

по тому, как это сделать, есть туториал в репозитории

2020 May 02

TN

Всем привет, делаю бинарную классификацию с параметром Logloss, в обучаюшей выборке примеров одного класса значительно больше примеров второго класса (на пару порядков), и в результате обучения модель везде предсказывает только первый класс. Есть ли какие-то общие методы как готовить данные / указать какие-то параметры чтобы объекты второго класса тоже нормально детектились моделью? Кажется странным в обучающей выборке откидывать часть данных, относящихся к первому классу, но другого способа я пока не нашел.

М

самое унылое, что можно сделать - выкинуть большинство элементов с одного класса, что б было поровну)

М

гуглите imbalanced data

М

кстати, выкинуть почти весь датасет, это хоть и уныло, но рабочий вариант))

TN

Спасибо )

AU

Еще вариант поварьировать порог, у вас, скорее всего, класс 1 предсказывается, если модель выдала предсказание > 0.5, можно получить другие предсказания, если вы будете относить к первому классу по другому порогу

AU

Подобрать порог можно по ошибке классификации на валидации