AU

Size: a a a

2020 May 02

Руками перебрав какое-то множество порогов

AU

Например

М

Подобрать порог можно по ошибке классификации на валидации

Прошу прощения, что вмешиваюсь, но мне интересен этот подход тоже. Можете объяснить подробнее механику сие действия

SK

Предсказываете не метку класса, а вероятность

SK

Потом ищете такую граничную вероятность между классами, что fpr примерно равен tpr

SK

По умолчанию модель считает, что такая граница - вероятность 0.5

SK

То есть как сказал Алексей - пройдитесь по сетке границ с каким-то шагом и выберите лучшую

М

А для этого нужно использовать матрицу ошибок? Т.е. чтобы количество объектов fpr tpr было одинаковым? Правильно понял?

М

Переслано от Stanislav Kirillov

Потом ищете такую граничную вероятность между классами, что fpr примерно равен tpr

TN

я надеялся что есть специальные алгоритмы для таких случаев )

IP

Можно ли конвертировать готовую модель в if-else? Если да, то можно доку/гайд

SK

Можно ли конвертировать готовую модель в if-else? Если да, то можно доку/гайд

Можно сконвертировать в json, pyhon или cpp код

IP

@kizill cpp код будет требовать каких либо сторонних(не дефолтных либ). Нужен код без сторонних зависимостей

SK

Нет, там как раз ни от чего кроме std:: не зависящий код генерируется

M

Кто-то дплоил фитинг моделей в amazon sqs как воркеры? Как лучше сделать?

И вопрос, когда aws считает, что отработала таска? Когда вернул ответ 200?

Просто, если напишу так(внизу код), то я так понимаю, что не дожидаясь фитинга очередь зафлудит воркер?

И вопрос, когда aws считает, что отработала таска? Когда вернул ответ 200?

Просто, если напишу так(внизу код), то я так понимаю, что не дожидаясь фитинга очередь зафлудит воркер?

from fastapi import BackgroundTasks, FastAPI

app = FastAPI()

async def train():

pass # very long

@app.post("/train_model/")

async def train_model(background_tasks: BackgroundTasks):

background_tasks.add_task(train)

return {"message": "Fitting the model in progress..."}

2020 May 03

NT

Всем привет, делаю бинарную классификацию с параметром Logloss, в обучаюшей выборке примеров одного класса значительно больше примеров второго класса (на пару порядков), и в результате обучения модель везде предсказывает только первый класс. Есть ли какие-то общие методы как готовить данные / указать какие-то параметры чтобы объекты второго класса тоже нормально детектились моделью? Кажется странным в обучающей выборке откидывать часть данных, относящихся к первому классу, но другого способа я пока не нашел.

Используйте параметр scale_pos_weight как-то так называется. В это число внутри модели будет увеличиваться пропорция самого маленького класса

TN

Используйте параметр scale_pos_weight как-то так называется. В это число внутри модели будет увеличиваться пропорция самого маленького класса

Спасибо) Попробую

2020 May 04

O

не подскажите, раннее был метод get_group_id, но в версии 0.16.2 был удален, сейчас есть какой то аналог этого метода?

MF

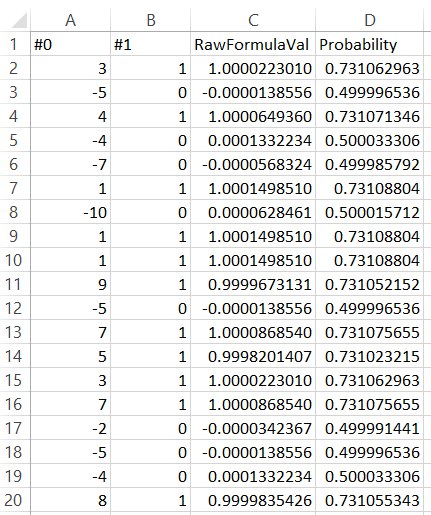

Добрый день! Создал обуч мнво из 100 объектов. Одна фича - число от -10 до +10. Метка 0, если число отрицательное, иначе 1. Обучил модель. Применил модель. По колонке RawFormulaVal вижу, что модель хорошо понимает, какое число положительное, какое отрицательное. Но колонка Probability вызывает удивление. Почему для числа 3 вероятность быть положительным всего 72%? Ожидалась вероятность очень близкая к 100%. Понятно, что применили сигмоид. Но в чем физический смысл такой вероятности? Например, если я предсказываю вероятность дождя завтра, модель поняла, что вероятность 100%, то какой смысл превращать 100% в 72%?