R

Size: a a a

2019 August 20

Ну если на отвали то через мерджи как предложили. А если по уму решать проблему то через конкретные утм метки, client id в аналитике и т д. А то у вас самый эффективный пост будет когда блогер ушел в запой и неделю не выкладывал контент

AM

Роман тут не то что бы на отвали, просто мы для клиентов размещаем, есть еще id поста но он не всегда учитывается, клиентов много у каждого свои предпочтения, если мы бы для себя все это постили то естественно более систематизированно подошли к вопросу, а в таких условиях выживаем как могём 😃

DS

А кто-нибудь выгружает из пандас в csv чтобы потом загрузить в какую-нибудь СУБД? Столкнулся с этим вот багом и не могу придумать хорошего решения https://github.com/pandas-dev/pandas/issues/14122

Если кратко в ситуации когда в строковом поле встречается escapechar, то он никак не экранируется, а потом такую csv неверно интерпретирует тот же mysql

Например если quotechar - двойные кавычки, а escapechar - слэш, то когда строка кончается на слэш, в csv записывается что-то вроде

Если кратко в ситуации когда в строковом поле встречается escapechar, то он никак не экранируется, а потом такую csv неверно интерпретирует тот же mysql

Например если quotechar - двойные кавычки, а escapechar - слэш, то когда строка кончается на слэш, в csv записывается что-то вроде

"foo\" и mysql думает что слэш экранирует кавычкуИО

а нельзя сразу обратиться к БД? использовать insert/create table запрос с передачей данных?

R

Роман тут не то что бы на отвали, просто мы для клиентов размещаем, есть еще id поста но он не всегда учитывается, клиентов много у каждого свои предпочтения, если мы бы для себя все это постили то естественно более систематизированно подошли к вопросу, а в таких условиях выживаем как могём 😃

Да делайте как хотите. Просто даже в вашем посте читается я бы делал по другому, но клиенты не знают чё хотят, делаем как сказали. А если вы им бы рассказали как правильно, то мб и было бы по другому.

ФК

кто-нибудь знает, какой лимит запросов к АПИ гугла для забора отзывов? Я эксериментировал с пагинацией и стал получать ошибку "Review query quota exceeded"

DS

а нельзя сразу обратиться к БД? использовать insert/create table запрос с передачей данных?

Через CSV сильно быстрее. Ну и если в один запрос пытаться собрать вставку всех записей, придётся менять различные лимиты у СУБД, вроде максимальной длины запроса. Или разбивать на батчи и тогда разница с вставкой через CSV будет ещё заметнее

ИО

Dmitriy Shashkin

Через CSV сильно быстрее. Ну и если в один запрос пытаться собрать вставку всех записей, придётся менять различные лимиты у СУБД, вроде максимальной длины запроса. Или разбивать на батчи и тогда разница с вставкой через CSV будет ещё заметнее

почему?

ИО

вы получили датафрейм

ИО

и вызываете команду insert

DS

Не совсем понял вашу мысль

ИО

у вас запрос будет минимален

ИО

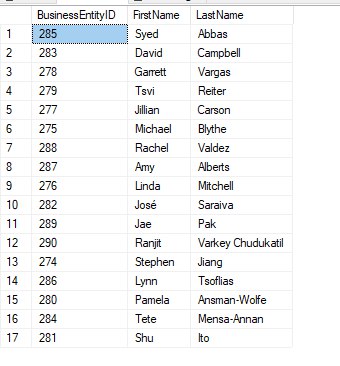

вот еще пример, тут нагляднее

ИО

DS

Грубо говоря запрос на вставку двух записей выглядит так

insert into bla_bla (field_1, field_2) values (1, 2), (4,6); В values перечисляется каждая строка фрейма, больше строк -> длинней запрос. Я что-то упускаю?ИО

посмотрите вторую ссылку что я вам кинул

ИО

вот даже под mysql

ИО

DS

А, ну там один ряд - один инсерт. Проще тогда to_sql пользоваться. Но это ужасно с тз производительности