DK

Size: a a a

2020 December 29

Vladimir Manko

я знаю что взлетит, на стенде гонял и проверял, надо теперь увидеть что оно в железе мне даст, по скоростям, прежде всего под большие диски виртуалок

под большие диски виртуалок тоже норм

VM

Буду очень благодарен, если поделитесь резулльтатом.

На пачке гигабитных линков, верно?

На пачке гигабитных линков, верно?

уже нет, будет 10 гигабит под сторажд

DK

я базы на ceph вешаю остальной шлак на gluster

NU

LINSTOR is a configuration management system for storage on Linux systems. It manages LVM logical volumes and/or ZFS ZVOLs on a cluster of nodes. It leverages DRBD for replication between different nodes and to provide block storage devices to users and applications. It manages snapshots, encryption and caching of HDD backed data in SSDs via bcache.

Я так понимаю, что всяческие drbd, glusterfs и т.п. создадут меньше накладных расходов, чем тот же ceph? Или просто это единственные варианты, в случае когда у нас нет выделенных блочных устройств?

Я так понимаю, что всяческие drbd, glusterfs и т.п. создадут меньше накладных расходов, чем тот же ceph? Или просто это единственные варианты, в случае когда у нас нет выделенных блочных устройств?

DK

но уменя сетка 10 G

П

мы тоже гоняли Linstor — в целом вроде норм, там задержки ниже чем у CEPH, насколько помню, т.е. IOPS можно выжать больше с того же железа, но остановились все равно на CEPH, в конце концов, работает — клиенты не жаловались

VM

LINSTOR is a configuration management system for storage on Linux systems. It manages LVM logical volumes and/or ZFS ZVOLs on a cluster of nodes. It leverages DRBD for replication between different nodes and to provide block storage devices to users and applications. It manages snapshots, encryption and caching of HDD backed data in SSDs via bcache.

Я так понимаю, что всяческие drbd, glusterfs и т.п. создадут меньше накладных расходов, чем тот же ceph? Или просто это единственные варианты, в случае когда у нас нет выделенных блочных устройств?

Я так понимаю, что всяческие drbd, glusterfs и т.п. создадут меньше накладных расходов, чем тот же ceph? Или просто это единственные варианты, в случае когда у нас нет выделенных блочных устройств?

цеф лучше когда у тебя куча серверов и в них небольшое кол-во дисков (ну так серверов 7, и в каждом по 4-8 дисков), гластер когда мало серверов, но внутри дисков вагон (как у меня сейчас 3 сервака по 36 дисков), самые низкие накладные расходы у линстора, но там необходимость держать базу и контроллер который всем управляет, ну и приезжают иногда глюки непонятные, а без платного саппорта (который стоит вагон денег) тяжеловато.

П

думаю, что там где важны IOPS высокие, лучше Linstor таки попробовать, но в остальном — вопрос скорее что умеете лучше обслуживать, как обычно. Не скажу, что CEPH сильно лучше хоть в чем-то, но по нему вроде как больше инсталляций и значит всяких случаев. Хотя ceph все равно несколько переусложненный, как по мне

VM

думаю, что там где важны IOPS высокие, лучше Linstor таки попробовать, но в остальном — вопрос скорее что умеете лучше обслуживать, как обычно. Не скажу, что CEPH сильно лучше хоть в чем-то, но по нему вроде как больше инсталляций и значит всяких случаев. Хотя ceph все равно несколько переусложненный, как по мне

согласен

П

да, ceph наверное туда где нужны большие по настоящему хранилища, там эта его сложность будет окупаться

П

для небольших инсталляций (5-7 узлов хранилища) — скорее будет избыточен, лучше в сторону linstor

NU

Ясн, не убежать от линстора.

Буду развёртывать. Благодарю.

Буду развёртывать. Благодарю.

VM

да, ceph наверное туда где нужны большие по настоящему хранилища, там эта его сложность будет окупаться

я бы добавил цеф туда где будет постоянный рост и расширение, с гластером не все так просто когда надо накинуть серваков, с цефом все банальнее\

П

ну gluster меня вообще как-то тревожит )

VM

с линстором все ок, но там внизу либо лвм либо зфс и долбанный контроллер которому надо обеспечивать собственную отказоустойчивость, чего не надо делать в цеф и гластер

П

мне linstor который на DRBD (с 9 версии вроде как там нормальная уже версия) — надежнее

П

контролле легкий у них, насколько я помню, поправьте если что, и легко дублируется и восстанавливается...

П

тут же в ceph вся эта штука про отсутствие контроллера — во многом иллюзия, т.е. оно конечно работает, но дается очень серьезными издержками и необходимостью отрабатывать сложные ситуации расщепления сети и все такое... как по мне, для большинства случаев отдельный контроллер даже скорее плюс, одна контроллируемая точка отказа

VM

контролле легкий у них, насколько я помню, поправьте если что, и легко дублируется и восстанавливается...

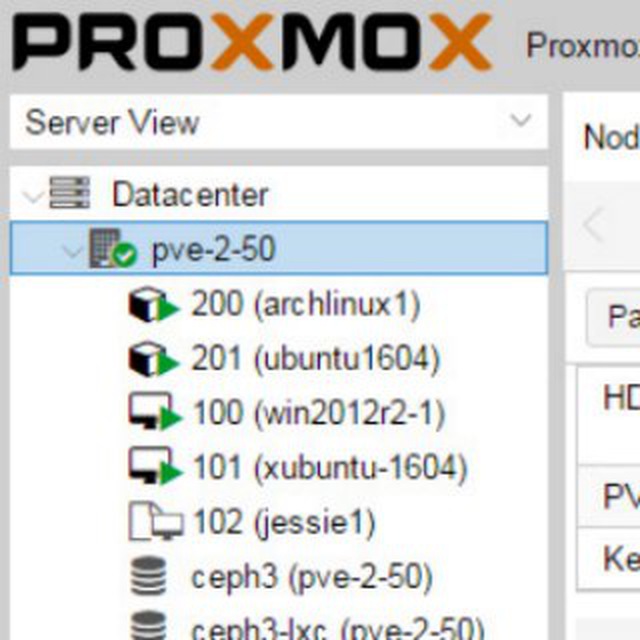

основная проблема не в контролле а в холодном старте хранилища, т.е. если все по тем или иным причинам вырубилось, то без контроллера хранилище не стартанет и прокс тупо не увидит диски виртуалок. Поэтому для контроллера надо решение по обеспечению его HA, то что у линстора в доке, у меня в предыдущей версии не заработало как надо при имитации полного отключения питания на всех нодах.

VM

Линсторовцы предлагают держать контроллер локально в самом проксе (редхатовцы к слову у себя в доке по гиперконвергнетной виртуализации пишут что так делать не надо), после холодного старта стартует локальный доступ к хранилищу, запускается виртуалка контрллера, и он восстанавливает хранилище для нод. Вот у меня оно не работало =( Хз как в 6-м проксе (я делал в 5-м) и с обновленным контроллером. Еще не тестил. kvaps говорил что много чего пофиксили.