V

Size: a a a

2020 August 09

ну обфускация в теории же существует

питона?

OS

питона?

кода, да

N

ну типа поднимаешь сервак, на нем зашифрованная убунта, от неё ключ только у тебя

N

или так не пойдет?

AP

ну типа поднимаешь сервак, на нем зашифрованная убунта, от неё ключ только у тебя

обходится легко :)

N

обходится легко :)

Например

N

Если у тебя есть свой образ убунты, который ты до этого шифранул и просто забекапил, как сломать?

AP

Если у тебя есть свой образ убунты, который ты до этого шифранул и просто забекапил, как сломать?

он в незашифрованном виде будет крутиться на машине с прямым физическим доступом )

N

он в незашифрованном виде будет крутиться на машине с прямым физическим доступом )

А как они к ней подключатся без пасса и логина?

N

Там же не прямо файлы лежат

AP

А как они к ней подключатся без пасса и логина?

По тому же принципу как с хоста можно доступ к виртуалке получить ;)

AK

Надо в общем подумать. Как собрать корпусы.

Мб имеет смысл к unsupervised MT копать?

V

По тому же принципу как с хоста можно доступ к виртуалке получить ;)

скажите как это все погуглить, именно чтобы не просто обфускацию, а чтобы в дата саенс индустрии

AP

скажите как это все погуглить, именно чтобы не просто обфускацию, а чтобы в дата саенс индустрии

Если плотно - то это уже про безопасность, криптографию и т.п. Как прям точно гуглить сходу не скажу потому что довольно широкая тема, но если на сервере будет крутиться "шифрованная" виртуалка - то получить к ней доступ не составит труда :)

AP

единственный вариант это пожалуй применить Гомоморфное шифрование, но у него свои подводные камни в виде лютой избыточности

SP

на самом деле есть большой корпус переводов текстов в национальной библиотеке, но их давать на опенсюрс проект никто не хочет

Заберите через США и университетский аккаунт

V

спс, про pysift слышал но не юзал, и про гомоморфное, но так кажется инач задача ставится, чтобы данные при тернировке не утекали

AK

Продолжение серии постов про проект Natasha. Что за Наташа? Почему в этот чат? См. https://t.me/natural_language_processing/16962

1. http://natasha.github.io/ner Natasha — качественное компактное решение для извлечения именованных сущностей из новостных статей на русском языке

2. https://t.me/natural_language_processing/17369 Почему Natasha не использует Transformers. BERT в 100 строк.

3. https://natasha.github.io/navec/ Navec — компактные эмбединги для русского языка

4. https://t.me/natural_language_processing/18186 BERT-модели Slovnet

5. https://t.me/natural_language_processing/18450 Corus — коллекция русскоязычных NLP-датасетов

6. https://t.me/natural_language_processing/18673 Ламповый стрим про историю проекта Natasha

#natasha

1. http://natasha.github.io/ner Natasha — качественное компактное решение для извлечения именованных сущностей из новостных статей на русском языке

2. https://t.me/natural_language_processing/17369 Почему Natasha не использует Transformers. BERT в 100 строк.

3. https://natasha.github.io/navec/ Navec — компактные эмбединги для русского языка

4. https://t.me/natural_language_processing/18186 BERT-модели Slovnet

5. https://t.me/natural_language_processing/18450 Corus — коллекция русскоязычных NLP-датасетов

6. https://t.me/natural_language_processing/18673 Ламповый стрим про историю проекта Natasha

#natasha

AK

Razdel — сегментация русскоязычного текста на токены и предложения

https://natasha.github.io/razdel

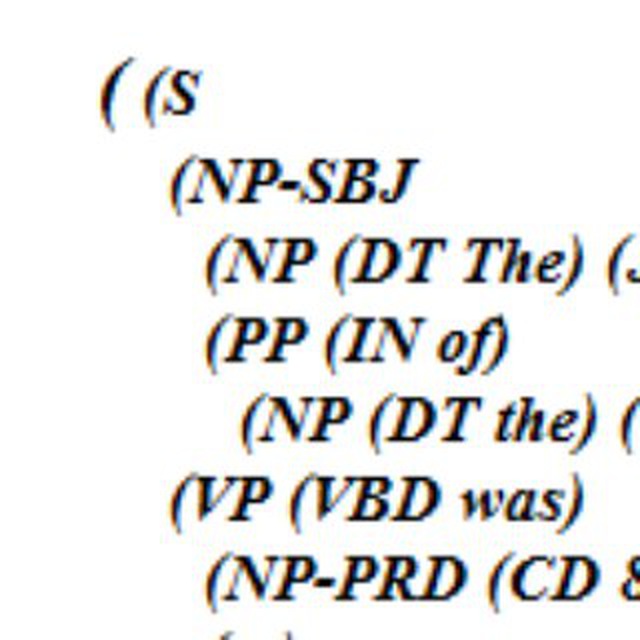

Современные модели часто пропускают этап сегментации, используют BPE-кодировку, показывают замечательные результаты, вспомним GPT и весь зоопарк BERTов. Но, например, задачи определения морфологии и синтаксиса имеют смысл только для отдельных слов внутри одного предложения.

На новостях, нормальное качество сегментации на предложения даёт регулярочка [.?!]\s+. Правда, она будет ошибаться на сокращениях и инициалах: "аудиторией от 3 тыс.| |человек", "В.А.| |Моцарта". Для русского существует несколько хороших решений, которые учитывают эти нюансы, например, ru_sentence_tokenizer от DeepPavlov https://github.com/deepmipt/ru_sentence_tokenizer.

Единственный недостаток готовых решений — их нельзя настроить. Например, есть текст судебного акта, нужно выделить в нём результативную часть и поделить её на параграфы. Естественно готовые решения так не умеют. Библиотека razdel https://github.com/natasha/razdel — на самом деле, это не просто готовое решение для разделения на токены и предложения, а небольшой сегментационный движок на правилах. Как упороться и сделать на нём топовое решение стандартной задачи сегментации читайте в http://natasha.github.io/razdel. Как писать свои правила читайте в исходниках https://github.com/natasha/razdel/blob/master/razdel/segmenters/sentenize.py =)

https://natasha.github.io/razdel

Современные модели часто пропускают этап сегментации, используют BPE-кодировку, показывают замечательные результаты, вспомним GPT и весь зоопарк BERTов. Но, например, задачи определения морфологии и синтаксиса имеют смысл только для отдельных слов внутри одного предложения.

На новостях, нормальное качество сегментации на предложения даёт регулярочка [.?!]\s+. Правда, она будет ошибаться на сокращениях и инициалах: "аудиторией от 3 тыс.| |человек", "В.А.| |Моцарта". Для русского существует несколько хороших решений, которые учитывают эти нюансы, например, ru_sentence_tokenizer от DeepPavlov https://github.com/deepmipt/ru_sentence_tokenizer.

Единственный недостаток готовых решений — их нельзя настроить. Например, есть текст судебного акта, нужно выделить в нём результативную часть и поделить её на параграфы. Естественно готовые решения так не умеют. Библиотека razdel https://github.com/natasha/razdel — на самом деле, это не просто готовое решение для разделения на токены и предложения, а небольшой сегментационный движок на правилах. Как упороться и сделать на нём топовое решение стандартной задачи сегментации читайте в http://natasha.github.io/razdel. Как писать свои правила читайте в исходниках https://github.com/natasha/razdel/blob/master/razdel/segmenters/sentenize.py =)

AK

Напишите в личку @alexkuk кому интересно почитать статьи для natasha.github.io до публикации. Следующий про сравнение отрытых решений задач NLP для русского. С меня ссылочка до публикации, с вас ревью что непонятно.