СС

Size: a a a

2021 April 13

Привет! На прошлом голосовом чате один из выступающих (не запомнил, кто именно :( ) рассказывал, что общался с ребятами из ai dungeon и знает примерно, что и как они там делают (и что у них специфичная надстройка над обычным gpt). Я не прошу рассказывать их инсайды, но можете хотя бы подсказать, в какую сторону копать?

OM

Есть блог команды AI dungeon на medium: https://aidungeon.medium.com/ и еще есть старый опенсорс репозиторий https://github.com/Latitude-Archives/AIDungeon

Я не был на голосовом чате, просто мимо проходил

Я не был на голосовом чате, просто мимо проходил

Е

http://arxiv.org/abs/2104.03474

Вот свежая статья, где получили хороший результат при конкатенации

Вот свежая статья, где получили хороший результат при конкатенации

RS

Привет!

Столкнулся с проблемой. Она связана с конкретной задачей, но полагаю, что общие советы по тренировке Трансформеров будут полезны

В дипломе решаю задачу distractor generation (генерация неправильных опций в вопросах с несколькими вариантами ответов).

Делаю на базе статьи о модели BDG, сейчас играюсь с имплементацией от авторов

В оригинале авторы тренировали BERT, подавая ему на вход

У меня в наличии только P100 / V100. Чтобы уменьшить скорость обучения, я заменил bert на distilbert и уменьшил батч сайз до 12. Тем не менее, тренировка все занимает большое время (10 часов на эпоху).

1. На какие трансформеры еще стоит обратить внимание? Хочется, чтобы модель были сравнима с оригинальным Бертом по качеству, но тренировались гораздо быстрее (чтобы быстро запускать разные эксперименты)

2. Что еще можно изменить в тренировке для ускорения?

Батч сайз увеличить не получается, не хватает памяти gpu. Если уменьшать maxlen, то придется сокращать большое количество семплов

Столкнулся с проблемой. Она связана с конкретной задачей, но полагаю, что общие советы по тренировке Трансформеров будут полезны

В дипломе решаю задачу distractor generation (генерация неправильных опций в вопросах с несколькими вариантами ответов).

Делаю на базе статьи о модели BDG, сейчас играюсь с имплементацией от авторов

В оригинале авторы тренировали BERT, подавая ему на вход

textparagraph <sep> question <sep> corectanswer <sep> distractor[0:i] <mask>. Авторы тренировали bert-base-cased на RTX Titan, 6 эпох, 30 размер батчаУ меня в наличии только P100 / V100. Чтобы уменьшить скорость обучения, я заменил bert на distilbert и уменьшил батч сайз до 12. Тем не менее, тренировка все занимает большое время (10 часов на эпоху).

1. На какие трансформеры еще стоит обратить внимание? Хочется, чтобы модель были сравнима с оригинальным Бертом по качеству, но тренировались гораздо быстрее (чтобы быстро запускать разные эксперименты)

2. Что еще можно изменить в тренировке для ускорения?

Батч сайз увеличить не получается, не хватает памяти gpu. Если уменьшать maxlen, то придется сокращать большое количество семплов

FF

Не подскажете какие есть качественные решения для разбиения текста на предложения? (кроме razdel)

C

коль скоро никто не ответил,то предложу свой вариант. Без явной нейронной сети. Регулярки + морфологический анализ

умеет разбивать в предложения и в клаузы

https://github.com/constantin50/separatrice

умеет разбивать в предложения и в клаузы

https://github.com/constantin50/separatrice

РН

@constantin50, тупиковый путь развития. Модели на Tensorflow (TF) скоро помрут. Присмотритесь в том же маркетплейсе к моделям на PyTorch.

C

не спорю, просто нужно обучать на TPU, а в pytorch пока что нестабильно (у вас был опыт? все без проблем запускалось?)

РН

PyTorch - стабильная библиотека. Опыт Сбера по обучению GPT-3 на базе Pytorch о многом говорит. На одном авторитетном портале видел мнение Бурцева (МФТИ, deeppavlov), что за этой тензорной библиотекой будущее.

C

речь идет об обучении на TPU transformer-моделей

C

так-то я согласен, что Pytorch наше светлое будущие

C

если Вы именно это и имели виду (обучение на TPU), то ок, попробую ещё раз.

SМ

Смешно

SМ

Мы в сбере сберты на тф делаем)) и не забывайте тф2 который имеет уже нетерпеливое исполнение и градиент тейп

SМ

В общем все это вкусовщина

РН

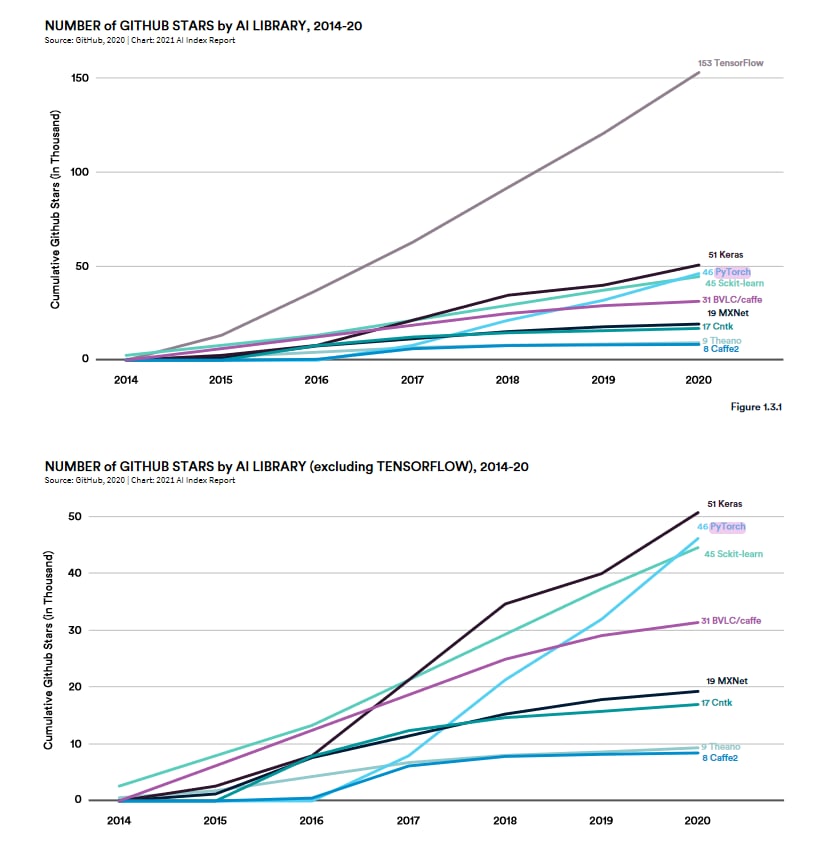

Спасибо за комментарий)) Поговорим в 2030 или 2035 году (горизонт планирования китайцев, может все подсядем на их фреймворки). Если серьёзно, то динамика и открытость PyTorch пока больше импонирует. Прикладываю картинку из Стэнфордского универа для привлечения внимания. p.s. Полный текст отчёта по ссылке: https://aiindex.stanford.edu/wp-content/uploads/2021/03/2021-AI-Index-Report_Master.pdf

SМ

Тф керас все еще могет

SМ

и если сравнить так же вырос +- как торч по отношению к чистому тф))

SМ

Его динамику вы решили не заметить?)

SМ

Да конечно Шоллет вошел в команду Гугла но это не показатель ли его признания)