A

Size: a a a

2021 April 13

😁Ага, прям можно вычислять такие штуки.

FF

А что такое TFXMLRoBERTa ? как-то плохо гуглится

FF

Новый трансформер на базе роберты?

SM

это модель от Huggingface, если я не путаю ничего

FF

А это tensorflow версия xml-roberta

SM

так точно

SM

не знаю, совпала ли я с каким-то хакатоном, но я диплом с ней пишу. буду рада и очень благодарна, если кто-то ответит или поможет

MK

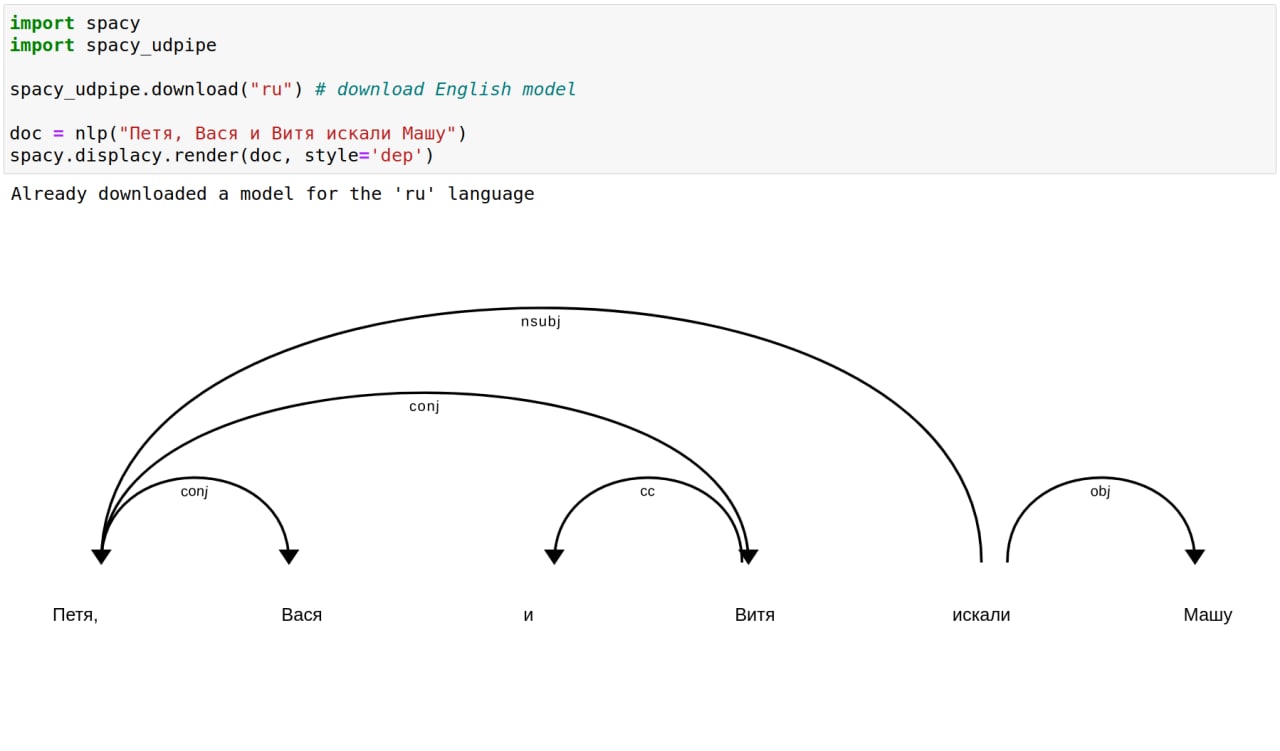

А это нормально что spacy_udpipe из коробки прилепляет запятые к словам при токенизации?

MK

И если не нормально, есть ли простой способ пофиксить?

AL

так только в рендере, на деле запятые отдельными токенами

A

А что значит - размеченные данные на выходе для ner?

MK

Спасибо!

AL

from transformers import XLMRobertaTokenizer, TFXLMRobertaModel

import tensorflow as tf

tokenizer = XLMRobertaTokenizer.from_pretrained('xlm-roberta-base')

model = TFXLMRobertaModel.from_pretrained('xlm-roberta-base')

inputs = tokenizer("Hello, my dog is cute", return_tensors="tf")

outputs = model(inputs)

last_hidden_states = outputs.last_hidden_state

last_hidden_states - готовые эмбеддинги из последнего слоя роберты, дальше можно их использовать как вход для какой-нибудь модели NERаsource: https://huggingface.co/transformers/model_doc/xlmroberta.html#tfxlmrobertamodel

SM

коряво написала, согласна, но сообщением выше прислали точно то, что мне было нужно

SM

спасибо огромное!

SM

нужно учиться нормально документацию читать

И

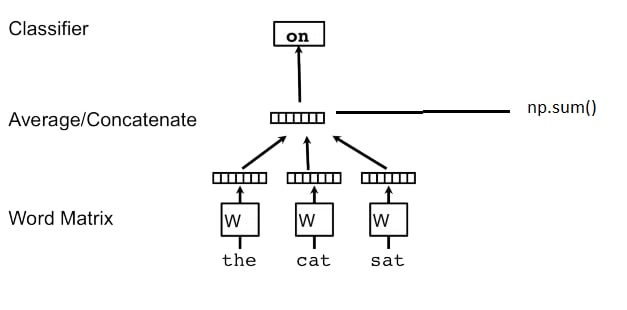

Привет. Список векторов (матрица), полученные из word2vec, я суммирую, потом подаю на классификатор. Есть ли практический смысл использовать k-means для конкатенации векторов? И как это, примерно, должно работать

AL

Лучше все-таки не суммировать, а усреднять. Есть смысл в усреднении векторов с tf-idf весами (see IDF-weighted word2vec), или со взвешиванием SIF. Еще можно пройтись по векторам RNNкой (+ опциональный attention) и сделать mean pooling стейтов, если ресурсы позволяют