VS

Size: a a a

2021 January 21

Если не ошибаюсь, подписка на скриншоте распространяется только на этот курс (специализацию). Есть крутая подписка coursera plus, которая содержит определенное количество курсов, которые можно проходить на выбор. Также можно подать мат помощь, подробности в FAQ

То есть я плачу, у меня есть месяц на то, чтобы пройти этот курс, а чтобы делать диплом - ещё раз заплатить, верно?

AR

То есть я плачу, у меня есть месяц на то, чтобы пройти этот курс, а чтобы делать диплом - ещё раз заплатить, верно?

Лучше спросить у техподдержки курсеры для надежности

VS

Лучше спросить у техподдержки курсеры для надежности

Хорошо, спасибо за ответы!

N

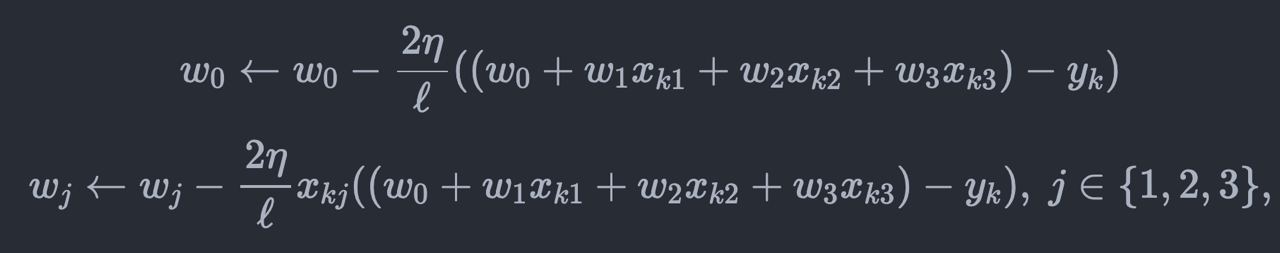

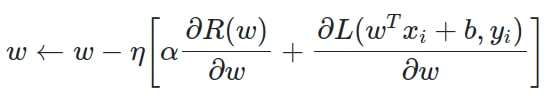

Всем привет! Подскажите пожалуйста тут точно должно быть деление на l ?

SS

можно делить, можно не делить, все равно это константа, можно перенести её в "эта"

A

Посоветуйте пожалуйста курсы или что-то такого планы чтоб заботать алгоритмы на уровне собесов

Рассматривал курс алгоритмов яндекс практикума, но дороговато(

Рассматривал курс алгоритмов яндекс практикума, но дороговато(

DB

Посоветуйте пожалуйста курсы или что-то такого планы чтоб заботать алгоритмы на уровне собесов

Рассматривал курс алгоритмов яндекс практикума, но дороговато(

Рассматривал курс алгоритмов яндекс практикума, но дороговато(

leetcode

собственно говоря, для этого эта платформа и сделана. там огромный скоп задач , разбитых по темам + разборы/discussion...

собственно говоря, для этого эта платформа и сделана. там огромный скоп задач , разбитых по темам + разборы/discussion...

M

И куча книг и статей с примерами и чего угодно вплоть до примеров собеседований на ютубе

Ю

Вроде в нотации курса за

l обозначен размер обучающей выборки, поэтому нет, логично его из этой записи убрать. Иначе, формально, эффективный learning rate при SGD будет зависеть от размера выборки, что странно.N

Вроде в нотации курса за

l обозначен размер обучающей выборки, поэтому нет, логично его из этой записи убрать. Иначе, формально, эффективный learning rate при SGD будет зависеть от размера выборки, что странно.Хорошо, спасибо

SS

зависит от того, что мы минимизируем, если среднее сумм, то там l есть, если просто сумму, то без l.

SS

если размер выборки изменился, то надо подбирать не только новый lr, но и другие параметры

Ю

Sergey Salnikov

зависит от того, что мы минимизируем, если среднее сумм, то там l есть, если просто сумму, то без l.

Да, как раз при SGD нет суммы по всем примерам в выборке, поэтоме нет и

lSS

l - это усреднение

Ю

Sergey Salnikov

l - это усреднение

Да, усреднение. Или Вы к тому, что всегда пишем

l, только в SGD оно равно 1?SS

в общем, делают без всяких расшаркиваний, просто:

weights.data -= lr * weights.grad

GW

Sergey Salnikov

если размер выборки изменился, то надо подбирать не только новый lr, но и другие параметры

О, а я думал то я жопорук и не получается как у дядек с интернета: тот же код, дефолтный, для всех задач

SS

если размер выборки увеличился в 2 раза, то мы просто делаем lr в 2 раза больше, это всё барахло, типа 2 и l, уходит в lr

Ю

Sergey Salnikov

если размер выборки увеличился в 2 раза, то мы просто делаем lr в 2 раза больше, это всё барахло, типа 2 и l, уходит в lr

Похоже это вопрос договоренностей) Например, sklearn утверждает, что не делит на l

Ю

Я понимаю, что мы оба правы и говорим про одно и то же)