Size: a a a

2018 June 04

2018 June 12

Program Synthesis Through Reinforcement Learning Guided Tree Search

https://arxiv.org/pdf/1806.02932.pdf

🕐 Когда - 8 июня 2018

👓 В чем понт

Модель на основе обучения с подкреплением и поиска по дереву, умеющая писать программный код и обгоняющая остальные SOTA подходы до 400%

🔎 Подробности

С точки зрения RL задачу можно поставить так: у нас есть агент - алгоритм-программист. Действия - это строки программного кода, который он может писать, состояния - память до и после написания кода. Реворд обратно пропорционален сумме действий, которые пришлось совершить агенту (хотим писать короткий код) и расстоянию между желаемым и наблюдаемым состоянием памяти. После того, как мы набираем некий пороговый реворд, программа считается решенной. В результате обучения мы получаем политику - то, с какой вероятностью из текущего состояния памяти нужно писать каждую возможную строку кода. Оптимизируемся мы алгоритмом Q-learning - предсказываем будущий реворд из определенного состояния и действия. Однако процесс решения долгий и, чтобы его ускорить, увеличив количество решенных программ за фиксированное число попыток, применяется поиск по дереву. Сначала мы с учетом политики случайно выбираем следующие состояния, считаем для них реворд, обучаемся на этом, делаем так 100 раз. Затем мы считаем Q-функцию для всех состояний, в которые мы случайно не попали, а потом жадно (сэмплируем из политики не вероятностно, а наиболее оптимально) выбираем следующия состояния, обучаемся на них, делаем так еще 100 раз. Это позволяет не упереться в локальный минимум и быстрее обучиться. Именно поиск по дереву - одна из главных фишек статьи, дающая прирост во всех экспериментах на 70%-100%.

🖋 Что в итоге

Шаг навстречу автоматизации программирования, модель заметно лучшего качества, решает до 400% больше программ, чем ее предшественники(например, MCMC - стохастический поиск, основанный на эвристике), не делает дополнительных предположений о языке программирования, отправлена на NIPS 2018.

https://arxiv.org/pdf/1806.02932.pdf

🕐 Когда - 8 июня 2018

👓 В чем понт

Модель на основе обучения с подкреплением и поиска по дереву, умеющая писать программный код и обгоняющая остальные SOTA подходы до 400%

🔎 Подробности

С точки зрения RL задачу можно поставить так: у нас есть агент - алгоритм-программист. Действия - это строки программного кода, который он может писать, состояния - память до и после написания кода. Реворд обратно пропорционален сумме действий, которые пришлось совершить агенту (хотим писать короткий код) и расстоянию между желаемым и наблюдаемым состоянием памяти. После того, как мы набираем некий пороговый реворд, программа считается решенной. В результате обучения мы получаем политику - то, с какой вероятностью из текущего состояния памяти нужно писать каждую возможную строку кода. Оптимизируемся мы алгоритмом Q-learning - предсказываем будущий реворд из определенного состояния и действия. Однако процесс решения долгий и, чтобы его ускорить, увеличив количество решенных программ за фиксированное число попыток, применяется поиск по дереву. Сначала мы с учетом политики случайно выбираем следующие состояния, считаем для них реворд, обучаемся на этом, делаем так 100 раз. Затем мы считаем Q-функцию для всех состояний, в которые мы случайно не попали, а потом жадно (сэмплируем из политики не вероятностно, а наиболее оптимально) выбираем следующия состояния, обучаемся на них, делаем так еще 100 раз. Это позволяет не упереться в локальный минимум и быстрее обучиться. Именно поиск по дереву - одна из главных фишек статьи, дающая прирост во всех экспериментах на 70%-100%.

🖋 Что в итоге

Шаг навстречу автоматизации программирования, модель заметно лучшего качества, решает до 400% больше программ, чем ее предшественники(например, MCMC - стохастический поиск, основанный на эвристике), не делает дополнительных предположений о языке программирования, отправлена на NIPS 2018.

2018 June 19

Improving Language Understanding by Generative Pre-Training

https://blog.openai.com/language-unsupervised/

🕐Когда - препринт

👓 В чем понт

Пайплайн от OpenAI, включающий в себя тренировку на неразмеченных данных, а потом тюнинг под конкретную задачу, который значительно улучшает качество на 9 из 12 рассмотренных NLP задач, например на 9 процентов в задаче понимания текста (датасет подбора подходящего окончания под часть текста Stories Cloze Test) и на 6 процентов в задаче ответа на вопросы (датасет RACE - вопросы с экзаменов)

🔎 Подробности

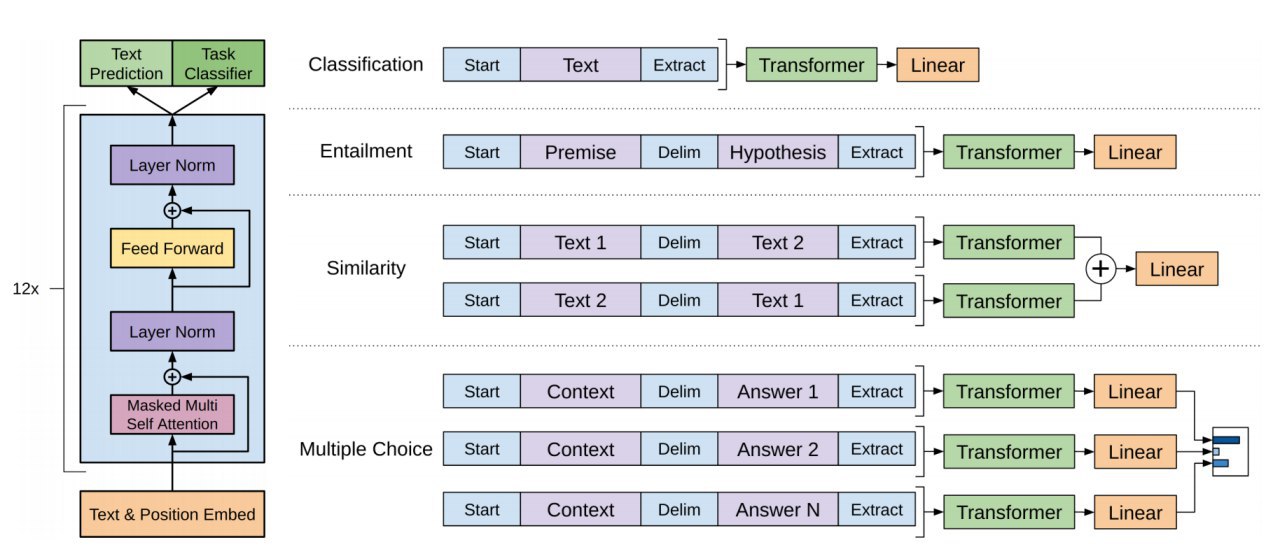

🔗Предобучение без учителя.

Перед тем как учить конкретную задачу NLP, тренируется модель, основанная на нашумевшей архитектуре Transformer, в которой входные токены, слитые с номерами своих позиций в предложении, обрабатываются с помощью аттеншна - учатся веса, с которыми нужно усреднять эти вектора. В процессе обучения мы предсказываем вероятность каждого токена(например слова) при условии предыдущих. На выходе получаем языковую модель - представление текста в информативном векторном пространстве.

🗝Тюнинг на конкретных задачах

Берем наше представление и доучиваем на размеченной выборке конкретной задачи, лосс тюнинга усредняем с лоссом предобучения без учителя. В каждой задаче используется специфическая предобработка данных, например, для задачи ответа на вопросы мы сливаем вектора вопроса, предложения и каждого ответа отдельно, получая для каждого такого объекта свою вероятность. Вся архитектура показана на рисунке под постом.

🖋 Что в итоге

Простой и эффективный стек для улучшения качества на своей задаче с помощью неразмеченных данных, подтверждает курс в NLP на обьединение разных задач, использование неразмеченных данных и attention.

https://blog.openai.com/language-unsupervised/

🕐Когда - препринт

👓 В чем понт

Пайплайн от OpenAI, включающий в себя тренировку на неразмеченных данных, а потом тюнинг под конкретную задачу, который значительно улучшает качество на 9 из 12 рассмотренных NLP задач, например на 9 процентов в задаче понимания текста (датасет подбора подходящего окончания под часть текста Stories Cloze Test) и на 6 процентов в задаче ответа на вопросы (датасет RACE - вопросы с экзаменов)

🔎 Подробности

🔗Предобучение без учителя.

Перед тем как учить конкретную задачу NLP, тренируется модель, основанная на нашумевшей архитектуре Transformer, в которой входные токены, слитые с номерами своих позиций в предложении, обрабатываются с помощью аттеншна - учатся веса, с которыми нужно усреднять эти вектора. В процессе обучения мы предсказываем вероятность каждого токена(например слова) при условии предыдущих. На выходе получаем языковую модель - представление текста в информативном векторном пространстве.

🗝Тюнинг на конкретных задачах

Берем наше представление и доучиваем на размеченной выборке конкретной задачи, лосс тюнинга усредняем с лоссом предобучения без учителя. В каждой задаче используется специфическая предобработка данных, например, для задачи ответа на вопросы мы сливаем вектора вопроса, предложения и каждого ответа отдельно, получая для каждого такого объекта свою вероятность. Вся архитектура показана на рисунке под постом.

🖋 Что в итоге

Простой и эффективный стек для улучшения качества на своей задаче с помощью неразмеченных данных, подтверждает курс в NLP на обьединение разных задач, использование неразмеченных данных и attention.

2018 June 27

Insights on representational similarity in neural networks with canonical correlation

https://arxiv.org/abs/1806.05759

⏱Когда - 21 июня 2018

🕶 В чем понт

Алгоритм исследования поведения нейронных сетей на основе метода, считающего сходство между слоями(CCA - Canonical correlation analysis), очищенного от шума. Исследовали этим методом поведение сетей, нашли особенности генерализующих сетей, сетей с одинаковой топологией, но разным learning rate, реккурентных сетей.

🔍 Подробности

🖇 CCA

CCA - математический метод, который позволяет находить лучшую линейную комбинацию, связывающую два массива, и таким образом считать сходство между ними (в нашем случае массивы это активации двух слоёв сети). В результате мы получаем коэффициенты корреляции между векторами разложения массива (CCA - векторами) для наших слоев. Чем больше эти коэффициенты, тем ближе слои , расстояние - единица минус среднее между коэффициентами корреляции.

🔦 Отделение шума от сигнала

Возможно, некоторые CCA векторы активации шумовые и нам не нужны. Посмотрим, как меняются эти вектора, когда лосс сети выходит на константу - некоторые вектора тоже принимают постоянные значения, а некоторые хаотично меняются - их логично считать за шум и не учитывать корреляцию между ними в расстоянии.

🖋 Выводы, к которым пришли

С помощью метода выше сравнивали слои в нейронках и сделали выводы:

1. Сети, которые генерализуют сходятся к более похожим репрезентациям, чем те, которые запоминают

2. Широкие сети сходятся к более похожим решениям, в отличие от узких

3. Сети с одинаковой топологией и разными learning rate сходятся к маленькому набору разных решений

4. Между временными шагами в RNN репрезентации значительно меняются

5. Таким методом можно и дальше смотреть, что происходит внутри нейронок, осознанно, а не алхимически улучшая их обучение

https://arxiv.org/abs/1806.05759

⏱Когда - 21 июня 2018

🕶 В чем понт

Алгоритм исследования поведения нейронных сетей на основе метода, считающего сходство между слоями(CCA - Canonical correlation analysis), очищенного от шума. Исследовали этим методом поведение сетей, нашли особенности генерализующих сетей, сетей с одинаковой топологией, но разным learning rate, реккурентных сетей.

🔍 Подробности

🖇 CCA

CCA - математический метод, который позволяет находить лучшую линейную комбинацию, связывающую два массива, и таким образом считать сходство между ними (в нашем случае массивы это активации двух слоёв сети). В результате мы получаем коэффициенты корреляции между векторами разложения массива (CCA - векторами) для наших слоев. Чем больше эти коэффициенты, тем ближе слои , расстояние - единица минус среднее между коэффициентами корреляции.

🔦 Отделение шума от сигнала

Возможно, некоторые CCA векторы активации шумовые и нам не нужны. Посмотрим, как меняются эти вектора, когда лосс сети выходит на константу - некоторые вектора тоже принимают постоянные значения, а некоторые хаотично меняются - их логично считать за шум и не учитывать корреляцию между ними в расстоянии.

🖋 Выводы, к которым пришли

С помощью метода выше сравнивали слои в нейронках и сделали выводы:

1. Сети, которые генерализуют сходятся к более похожим репрезентациям, чем те, которые запоминают

2. Широкие сети сходятся к более похожим решениям, в отличие от узких

3. Сети с одинаковой топологией и разными learning rate сходятся к маленькому набору разных решений

4. Между временными шагами в RNN репрезентации значительно меняются

5. Таким методом можно и дальше смотреть, что происходит внутри нейронок, осознанно, а не алхимически улучшая их обучение

2018 July 09

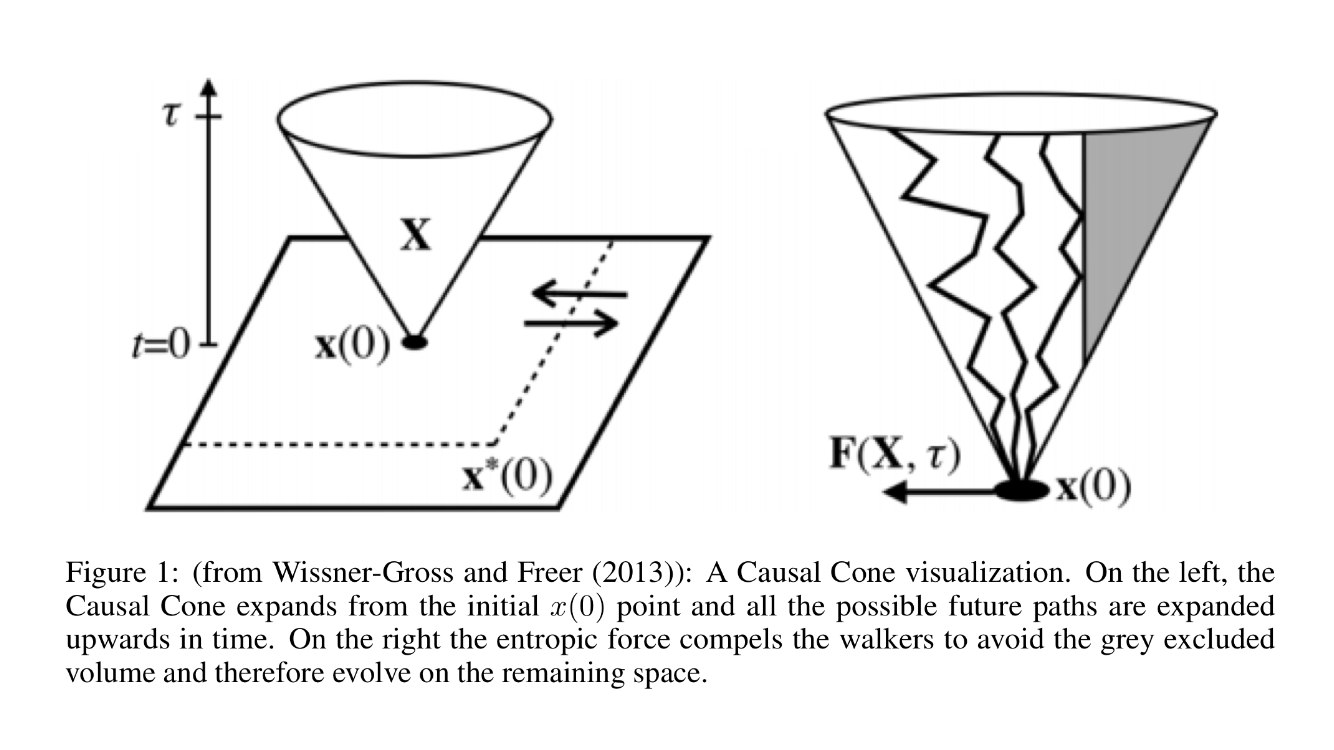

Solving Atari Games Using Fractals And Entropy

⏱Когда - 3 июля 2018 год

🕶В чем понт

Алгоритм, использующий фрактальную теорию ИИ, бьющую sota в 49 из 55 играх атари.

http://telegra.ph/Solving-Atari-Games-Using-Fractals-And-Entropy-07-09

⏱Когда - 3 июля 2018 год

🕶В чем понт

Алгоритм, использующий фрактальную теорию ИИ, бьющую sota в 49 из 55 играх атари.

http://telegra.ph/Solving-Atari-Games-Using-Fractals-And-Entropy-07-09

2018 July 20

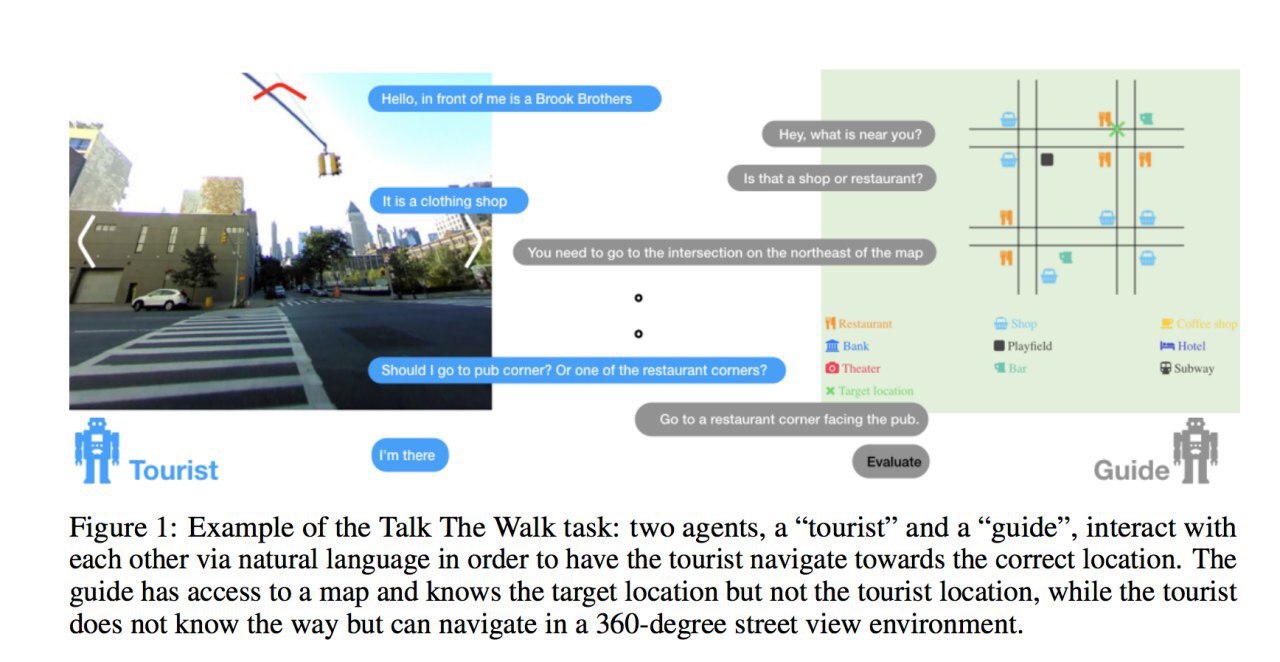

Talk the Walk: Navigating New York City through Grounded Dialogue

@tldr_arxiv

🕐 Когда - 13 июля 2018 год

👓 В чем понт

Алгоритм, позволяющий коммуницировать двум агентам - туристу, который видит мир вокруг себя и должен добраться до финальной точки, но где она, турист не знает, и гида, который не видит мир вокруг туриста и по описанию должен рассказать туристу, что сделать дальше, чтобы дойти до цели. С рядом предположений алгоритм бьет качество решения этой задачи людьми.

Ссылка на обзор - http://telegra.ph/Talk-the-Walk-Navigating-New-York-City-through-Grounded-Dialogue-07-20

@tldr_arxiv

🕐 Когда - 13 июля 2018 год

👓 В чем понт

Алгоритм, позволяющий коммуницировать двум агентам - туристу, который видит мир вокруг себя и должен добраться до финальной точки, но где она, турист не знает, и гида, который не видит мир вокруг туриста и по описанию должен рассказать туристу, что сделать дальше, чтобы дойти до цели. С рядом предположений алгоритм бьет качество решения этой задачи людьми.

Ссылка на обзор - http://telegra.ph/Talk-the-Walk-Navigating-New-York-City-through-Grounded-Dialogue-07-20

2018 July 31

Extracting a biologically relevant latent space from cancer transcriptomes with variational autoencoders

https://www.ncbi.nlm.nih.gov/pmc/articles/PMC5728678/

😎 В чем понт

Новости по нейронкам от коллег-биоинформатиков, спасибо Даше Романовской @dariaromanovskaia.

Ежегодно от рака умирает 8 млн человек. Часто причина в плохой диагностике - врачи неправильно определяют особенности опухоли и назначают неподходящее лечение. С помощью вариационного автоэнкодера авторы научились сжимать информацию о РНК клетки и интерпретировать результат. По полученным признакам можно классифицировать, к какому типу относится рак, и какой ткани принадлежит опухоль.

🔎 Подробности

☘️ Немного биологии или зачем это надо

Традиционно, врачи лечат всех онкологических пациентов по одинаковой схеме, вне зависимости от индивидуальных особенностей, что приводит к огромному числу ошибок. Поэтому хорошо иметь признаковое описание конкретного пациента, понимать, какие молекулы есть в его организме и сколько их. Информация о том, какие белки(основной тип молекул) потенциально могут вырабатываться в клетке содержится в ДНК (генах). А вот то, какие белки реально вырабатываются в каждый момент времени (или экспрессируются), а значит, вид рака пациента, можно понять по последовательности РНК. РНК - молекула, передающая информацию от ДНК к белку. С помощью процедуры, которая называется РНК-секвенированием можно определять, какие именно молекулы РНК сейчас есть в клетках, то есть какие гены “работают”, экспрессируются и насколько эффективно - уровень экспрессии. Если научиться извлекать из данных об уровне экспрессии генов важные характеристики пациента и его рака, то это заметно улучшит диагностику и позволит индивидуально подойти к лечению.

🗒 Данные+алгоритм или причем тут VAE

Авторы взяли данные о более чем 10,000 различных опухолях в 33 типах рака. Данные об экспрессии самых вариабельных 5000 генов были сжаты в пространство признаков размерности 100, а затем с помощью декодера восстановлены обратно в 5000. Вариационный автоэнкодер позволяет не просто сжимать данные в какое-то скрытое представление, а сжимать их сначала в 2 параметра для каждого признака - дисперсию и матожидание, из них генерить скрытое представление, а потом уже засовывать в декодер. Матожидание и дисперсию штрафуем за отклонение от нуля и единицы. Такой трюк позволяет гарантировать одинаковый масштаб всех признаков и их независимость, что хорошо. Валидировали эмбеддинги следующим образом - брали образцы для разных типов рака и смотрели межгрупповое и внутригрупповое кластерные расстояния - межгрупповое было больше, раки разделялись. Веса декодера использовались для определения вклада каждого гена в полученное скрытое представление.

✏️ Что в итоге

Сделали классные эмбеддинги. По выделенным эмбеддингам возможно определить типы тканей, в которых образуются опухоли и непосредственно типы рака. Полученный набор признаков не является избыточным и алгоритм чувствителен к различным вариациям в данных (например, различим пол пациентов). Выделили важные признаки для классификации типов рака, например стадию развития клеток, на которых находились образцы.

https://www.ncbi.nlm.nih.gov/pmc/articles/PMC5728678/

😎 В чем понт

Новости по нейронкам от коллег-биоинформатиков, спасибо Даше Романовской @dariaromanovskaia.

Ежегодно от рака умирает 8 млн человек. Часто причина в плохой диагностике - врачи неправильно определяют особенности опухоли и назначают неподходящее лечение. С помощью вариационного автоэнкодера авторы научились сжимать информацию о РНК клетки и интерпретировать результат. По полученным признакам можно классифицировать, к какому типу относится рак, и какой ткани принадлежит опухоль.

🔎 Подробности

☘️ Немного биологии или зачем это надо

Традиционно, врачи лечат всех онкологических пациентов по одинаковой схеме, вне зависимости от индивидуальных особенностей, что приводит к огромному числу ошибок. Поэтому хорошо иметь признаковое описание конкретного пациента, понимать, какие молекулы есть в его организме и сколько их. Информация о том, какие белки(основной тип молекул) потенциально могут вырабатываться в клетке содержится в ДНК (генах). А вот то, какие белки реально вырабатываются в каждый момент времени (или экспрессируются), а значит, вид рака пациента, можно понять по последовательности РНК. РНК - молекула, передающая информацию от ДНК к белку. С помощью процедуры, которая называется РНК-секвенированием можно определять, какие именно молекулы РНК сейчас есть в клетках, то есть какие гены “работают”, экспрессируются и насколько эффективно - уровень экспрессии. Если научиться извлекать из данных об уровне экспрессии генов важные характеристики пациента и его рака, то это заметно улучшит диагностику и позволит индивидуально подойти к лечению.

🗒 Данные+алгоритм или причем тут VAE

Авторы взяли данные о более чем 10,000 различных опухолях в 33 типах рака. Данные об экспрессии самых вариабельных 5000 генов были сжаты в пространство признаков размерности 100, а затем с помощью декодера восстановлены обратно в 5000. Вариационный автоэнкодер позволяет не просто сжимать данные в какое-то скрытое представление, а сжимать их сначала в 2 параметра для каждого признака - дисперсию и матожидание, из них генерить скрытое представление, а потом уже засовывать в декодер. Матожидание и дисперсию штрафуем за отклонение от нуля и единицы. Такой трюк позволяет гарантировать одинаковый масштаб всех признаков и их независимость, что хорошо. Валидировали эмбеддинги следующим образом - брали образцы для разных типов рака и смотрели межгрупповое и внутригрупповое кластерные расстояния - межгрупповое было больше, раки разделялись. Веса декодера использовались для определения вклада каждого гена в полученное скрытое представление.

✏️ Что в итоге

Сделали классные эмбеддинги. По выделенным эмбеддингам возможно определить типы тканей, в которых образуются опухоли и непосредственно типы рака. Полученный набор признаков не является избыточным и алгоритм чувствителен к различным вариациям в данных (например, различим пол пациентов). Выделили важные признаки для классификации типов рака, например стадию развития клеток, на которых находились образцы.

2018 August 14

A Dual Approach to Scalable Verification of Deep Networks

⏱Когда - 3 августа 2018

🕶В чем понт

Когда мы учим сетку, хочется не просто хорошего среднего качества на данных, но и безопасности предсказаний-чтобы входы и выходы сети удовлетворяли определенным условиям. Например, были устойчивы к adversarial примерам- объектам выборки, которые при очень маленьких изменениях в значении признаков меняют класс(например, меняем всего один пиксель на картинке и сеть говорит, что теперь это кошка, а не собака). Авторы сделали метод, который в отличие от других, позволяет 1) верифицировать сеть с любой архитектурой 2) работать с дискретными входами 3) остановить тренировку в любое время, когда условия перестают выполняться 4) побить sota по устойчивости к adversarial атакам на mnist и cifar-10 5) взять приз за лучшую статью на конференции UAI.

🔍Подробности

🔦Оптимизация

Задачу верификации можно сформулировать так - мы хотим, чтобы на каком-то наборе объектов (например adversarial) получались определенные выходы. Потребуем, чтобы набор линейных комбинаций от выходов сети был больше нуля - любое выпуклое ограничение представимо в таком виде. Например, мы хотим чтобы картинка с кошкой и ее adversarial всегда классифицировались как что-то близкое к кошке - подмножество входов картинок с кошкой и adversarial должны давать выходы, близкие (область в виде линейных ограничений) к выходам кошки.

Авторы показали, что если в пространстве входов можно найти максимум линейной комбинации, то их алгоритм применим.

🔨Эксперименты

Авторы сравнивали свой алгоритм с другими sota в 3 задачах 1) классификации mnist и cifar при условии устойчивости к adversarial. 2) стабильности классификатора на данных из github по мере добавления данных из разных комитов 3) суммы цифр mnist-на вход даётся 2 картинки с цифрами, нужно понять насколько сильно их сумма может отличаться от суммы этих картинок, деформированных adversarial. На всех задачах качество авторов оказалось выше.

🖋Что в итоге

Важный шаг в сторону безопасности ИИ- в будущем сети, особенно от которых зависят жизни людей(беспилотные автомобили к примеру) должны тренироваться не только с оптимизацией качества, но и с постоянной проверкой на заданные условия(например, устойчивость к adversarial примерам).

⏱Когда - 3 августа 2018

🕶В чем понт

Когда мы учим сетку, хочется не просто хорошего среднего качества на данных, но и безопасности предсказаний-чтобы входы и выходы сети удовлетворяли определенным условиям. Например, были устойчивы к adversarial примерам- объектам выборки, которые при очень маленьких изменениях в значении признаков меняют класс(например, меняем всего один пиксель на картинке и сеть говорит, что теперь это кошка, а не собака). Авторы сделали метод, который в отличие от других, позволяет 1) верифицировать сеть с любой архитектурой 2) работать с дискретными входами 3) остановить тренировку в любое время, когда условия перестают выполняться 4) побить sota по устойчивости к adversarial атакам на mnist и cifar-10 5) взять приз за лучшую статью на конференции UAI.

🔍Подробности

🔦Оптимизация

Задачу верификации можно сформулировать так - мы хотим, чтобы на каком-то наборе объектов (например adversarial) получались определенные выходы. Потребуем, чтобы набор линейных комбинаций от выходов сети был больше нуля - любое выпуклое ограничение представимо в таком виде. Например, мы хотим чтобы картинка с кошкой и ее adversarial всегда классифицировались как что-то близкое к кошке - подмножество входов картинок с кошкой и adversarial должны давать выходы, близкие (область в виде линейных ограничений) к выходам кошки.

Авторы показали, что если в пространстве входов можно найти максимум линейной комбинации, то их алгоритм применим.

🔨Эксперименты

Авторы сравнивали свой алгоритм с другими sota в 3 задачах 1) классификации mnist и cifar при условии устойчивости к adversarial. 2) стабильности классификатора на данных из github по мере добавления данных из разных комитов 3) суммы цифр mnist-на вход даётся 2 картинки с цифрами, нужно понять насколько сильно их сумма может отличаться от суммы этих картинок, деформированных adversarial. На всех задачах качество авторов оказалось выше.

🖋Что в итоге

Важный шаг в сторону безопасности ИИ- в будущем сети, особенно от которых зависят жизни людей(беспилотные автомобили к примеру) должны тренироваться не только с оптимизацией качества, но и с постоянной проверкой на заданные условия(например, устойчивость к adversarial примерам).

2018 September 01

Exploring Shared Structures and Hierarchies for Multiple NLP Tasks

https://arxiv.org/pdf/1808.07658.pdf

🕐 Когда - 23 августа 2018

🍓 В чем понт

Часто разные задачи обработки текстов (и не только текстов) могут потенциально очень помочь друг другу. Например, в индустрии почти одни и те же тексты часто ранжируют, классифицируют на разные классы разными способами одновременно, при этом информация из одной задачи может восполнять пробелы в другой. Вопрос - как обьединить модели с наилучшим качеством и без усилий человека? На него отвечает статья, в который авторы делают это с помощью RL.

🔎 Подробности

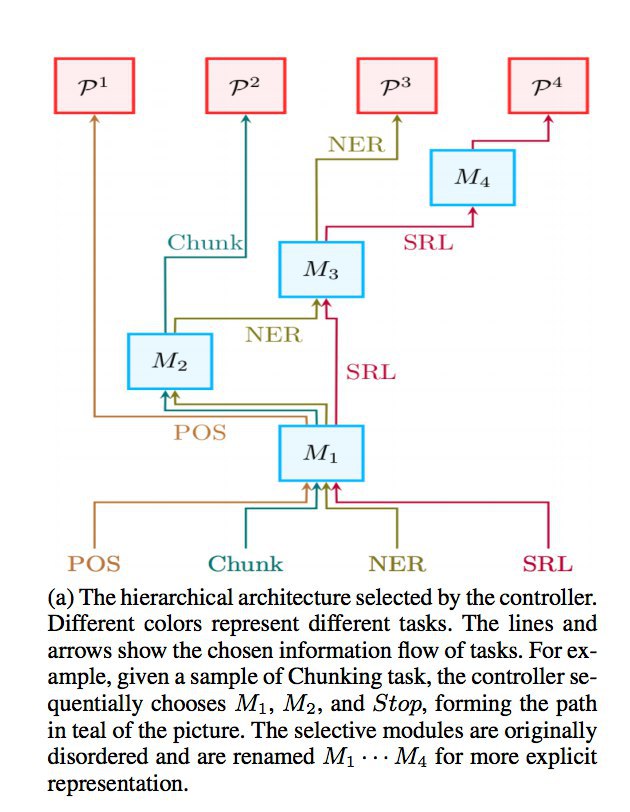

🛠 Модель

Подбираем архитектуру модели с помощью RL. У нас есть заранее заготовленные модули (какие-то слои сети), которые мы хотим правильно соединить. Действия - это то, с каким моделей соединять каждый следующий модуль для конкретной задачи. Оптимизируем политику - то, с какой вероятностью из текущего модуля нужно перейти в следующий. Нашим ревордом - оценкой того, насколько мы молодцы, будет качество решения задач, которые мы клеим.

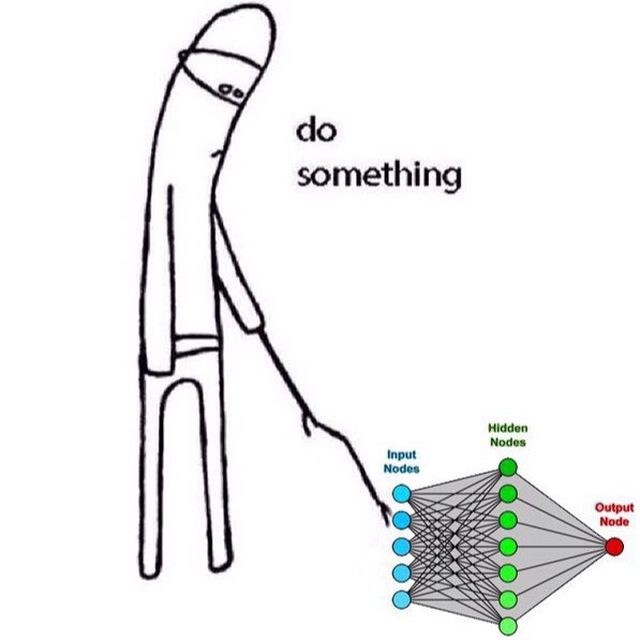

Учились клеить вместе 4 классические задачи NLP (POS, Chunk, NER, SRL) - получили прирост по качеству по сравнению со всеми предыдущими моделями. Пример архитектуры, построенной RL в картинке под постом.

🗒 Анализ архитектур.

Посмотрели на архитектуры и проанализировали, что получается, когда RL занимается дизайном модели. Увидели, что похожие задачи кластеризуются в пространстве переходов между модулями, а более высокоуровневые задачи выстраиваются в логичную иерархию с низкоуровневыми.

🥂 Что в итоге

Сделали способ делать способ клеить модели с максимальным качеством. Перспектива - если склеить все модели в мире вместе очень хорошо, может получиться не слабый такой ИИ:)

https://arxiv.org/pdf/1808.07658.pdf

🕐 Когда - 23 августа 2018

🍓 В чем понт

Часто разные задачи обработки текстов (и не только текстов) могут потенциально очень помочь друг другу. Например, в индустрии почти одни и те же тексты часто ранжируют, классифицируют на разные классы разными способами одновременно, при этом информация из одной задачи может восполнять пробелы в другой. Вопрос - как обьединить модели с наилучшим качеством и без усилий человека? На него отвечает статья, в который авторы делают это с помощью RL.

🔎 Подробности

🛠 Модель

Подбираем архитектуру модели с помощью RL. У нас есть заранее заготовленные модули (какие-то слои сети), которые мы хотим правильно соединить. Действия - это то, с каким моделей соединять каждый следующий модуль для конкретной задачи. Оптимизируем политику - то, с какой вероятностью из текущего модуля нужно перейти в следующий. Нашим ревордом - оценкой того, насколько мы молодцы, будет качество решения задач, которые мы клеим.

Учились клеить вместе 4 классические задачи NLP (POS, Chunk, NER, SRL) - получили прирост по качеству по сравнению со всеми предыдущими моделями. Пример архитектуры, построенной RL в картинке под постом.

🗒 Анализ архитектур.

Посмотрели на архитектуры и проанализировали, что получается, когда RL занимается дизайном модели. Увидели, что похожие задачи кластеризуются в пространстве переходов между модулями, а более высокоуровневые задачи выстраиваются в логичную иерархию с низкоуровневыми.

🥂 Что в итоге

Сделали способ делать способ клеить модели с максимальным качеством. Перспектива - если склеить все модели в мире вместе очень хорошо, может получиться не слабый такой ИИ:)

2018 September 14

Merging Datasets Through Deep learning

https://arxiv.org/pdf/1809.01604.pdf

🕐 Когда - 5 сентября 2018

🍒 В чем понт

Очень большую и не самую приятную часть работы аналитика составляет работа по обьединению таблиц. Например, нужно проанализировать прибыль, которую приносят клиенты в зависимости от разных характеристик. Прибыль находится в одной таблице, описание клиента в 20 других, все колонки в таблицах называются по-разному, а данные представлены в разном формате. Знакомая ситуация? Авторы статьи придумали архитектуру, в которой нейронка по распределению признаков понимает, какие данные в колонках относятся к одной и той же сущности, даже если они записаны немного по-разному.

🔎 Подробности

Для того, чтобы понять, какие данные в колонках таблицы относятся к одним и тем же понятиям, представим их в виде векторов с помощью нейронной сети, на вход ей будем давать три вектора - понятие, это же перефразированное понятие и понятие, которое не является синонимом. Сетка будет одновременно учиться считать расстояние между синонимыми как можно ближе, а между разными словами - как можно дальше. Учиться и проверяться будем на Wikidata - датасет содержащий имена 213 тыс людей и 71 тыс компаний, а синонимами будем считать имена, которые в базе отделяются от оригинальных имен через ''also known as''. Также статье авторы исследовали разные виды лоссов, например, смотрели на improved loss, который рассматривает расстояние не только от положительного примера до оригинального, но и от негативного до положительного, пытаясь выравнять эти расстояния. Удалось достичь точности и полноты одновременно на уровне 80 процентов.

🖋 Что в итоге

Достаточно простые алгоритмически, но важные шаги в сторону автоматизации большой части аналитики.

https://arxiv.org/pdf/1809.01604.pdf

🕐 Когда - 5 сентября 2018

🍒 В чем понт

Очень большую и не самую приятную часть работы аналитика составляет работа по обьединению таблиц. Например, нужно проанализировать прибыль, которую приносят клиенты в зависимости от разных характеристик. Прибыль находится в одной таблице, описание клиента в 20 других, все колонки в таблицах называются по-разному, а данные представлены в разном формате. Знакомая ситуация? Авторы статьи придумали архитектуру, в которой нейронка по распределению признаков понимает, какие данные в колонках относятся к одной и той же сущности, даже если они записаны немного по-разному.

🔎 Подробности

Для того, чтобы понять, какие данные в колонках таблицы относятся к одним и тем же понятиям, представим их в виде векторов с помощью нейронной сети, на вход ей будем давать три вектора - понятие, это же перефразированное понятие и понятие, которое не является синонимом. Сетка будет одновременно учиться считать расстояние между синонимыми как можно ближе, а между разными словами - как можно дальше. Учиться и проверяться будем на Wikidata - датасет содержащий имена 213 тыс людей и 71 тыс компаний, а синонимами будем считать имена, которые в базе отделяются от оригинальных имен через ''also known as''. Также статье авторы исследовали разные виды лоссов, например, смотрели на improved loss, который рассматривает расстояние не только от положительного примера до оригинального, но и от негативного до положительного, пытаясь выравнять эти расстояния. Удалось достичь точности и полноты одновременно на уровне 80 процентов.

🖋 Что в итоге

Достаточно простые алгоритмически, но важные шаги в сторону автоматизации большой части аналитики.

2018 October 09

Quantum Statistics-Inspired Neural Attention

https://arxiv.org/abs/1809.06205

🕐 Когда - 17 сентября 2018

👓 В чем понт

Attention механизм недавно сделал шума в мире deep learning, например показал sota на задаче перевода. Но у существующего метода есть ограничение - вычисление весов основывается на предположении, что каждое слово, в фразе, которую мы переводим, независимо от остальных. Это предположение не учитывает зависимости более высокого порядка, которые могут встречаться в реальных данных. Новый метод, вдохновенный квантовой физикой, позволяет обойти это предположение и показать лучшее качество.

🔎 Подробности

🌱 Classic attention

Seq2seq архитектура состоит из энкодера и декодера. Например, в задаче машинного перевода, энкодер получает на вход набор эмбеддингов для слов, и на каждом временном шаге(слове) генерирует скрытое представление на основе всех предыдущих слов, которое передает дальше. Декодер на каждом этапе декодирования получает на вход предыдущее декодированное слово и вектор контекста, который отражает важную информацию из энкодера. Контекст - это среднее скрытых состояний энкодера с выученными весами, причем для каждого слова в декодере эти веса разные. Веса - это функция от скрытых состояний энкодера и декодера с параметрами, которые учатся attention моделью.

💫 Причем тут квантовая физика?

Когда мы бросаем кубик, часто мы подразумеваем, что он может лежать только на 1 своей грани (как обычный attention считаем веса для каждого отдельного слова в энкодере). В квантовой физике мы добавляем также вероятности того, что кубик может лежать на двух гранях одновременно (аналогия с квантовым attention).

🌈 Quantum attention

В квантовом attention, как сказано выше, мы рассматриваем не только веса отдельных скрытых состояний в энкодере, но и веса для их сумм. Для каждого слова в декодере мы усредняем attention функции этого слова от всех пар с этим словом. Это важно, когда в одном языке комбинация слов вместе создает другой эффект, чем порознь. Например, устойчивое выражение 'козел отпущения' на английский переводится как scapegoat. Слово 'отпущение' вне контекста значит совсем другое и только в комбинации со словом 'козел' может приобрести свой финальный смысл

🔧 Эксперименты

Провели эксперименты, показали, что модель лучше переводит редкие слова, чем обычный attenton и показывает более высокий BLEU на задачах машинного перевода.

🖋 Что в итоге

Сделали логичное усложнение attention, улучшили метрики в задаче машинного перевода, и все это при небольших вычислительных затратах.

https://arxiv.org/abs/1809.06205

🕐 Когда - 17 сентября 2018

👓 В чем понт

Attention механизм недавно сделал шума в мире deep learning, например показал sota на задаче перевода. Но у существующего метода есть ограничение - вычисление весов основывается на предположении, что каждое слово, в фразе, которую мы переводим, независимо от остальных. Это предположение не учитывает зависимости более высокого порядка, которые могут встречаться в реальных данных. Новый метод, вдохновенный квантовой физикой, позволяет обойти это предположение и показать лучшее качество.

🔎 Подробности

🌱 Classic attention

Seq2seq архитектура состоит из энкодера и декодера. Например, в задаче машинного перевода, энкодер получает на вход набор эмбеддингов для слов, и на каждом временном шаге(слове) генерирует скрытое представление на основе всех предыдущих слов, которое передает дальше. Декодер на каждом этапе декодирования получает на вход предыдущее декодированное слово и вектор контекста, который отражает важную информацию из энкодера. Контекст - это среднее скрытых состояний энкодера с выученными весами, причем для каждого слова в декодере эти веса разные. Веса - это функция от скрытых состояний энкодера и декодера с параметрами, которые учатся attention моделью.

💫 Причем тут квантовая физика?

Когда мы бросаем кубик, часто мы подразумеваем, что он может лежать только на 1 своей грани (как обычный attention считаем веса для каждого отдельного слова в энкодере). В квантовой физике мы добавляем также вероятности того, что кубик может лежать на двух гранях одновременно (аналогия с квантовым attention).

🌈 Quantum attention

В квантовом attention, как сказано выше, мы рассматриваем не только веса отдельных скрытых состояний в энкодере, но и веса для их сумм. Для каждого слова в декодере мы усредняем attention функции этого слова от всех пар с этим словом. Это важно, когда в одном языке комбинация слов вместе создает другой эффект, чем порознь. Например, устойчивое выражение 'козел отпущения' на английский переводится как scapegoat. Слово 'отпущение' вне контекста значит совсем другое и только в комбинации со словом 'козел' может приобрести свой финальный смысл

🔧 Эксперименты

Провели эксперименты, показали, что модель лучше переводит редкие слова, чем обычный attenton и показывает более высокий BLEU на задачах машинного перевода.

🖋 Что в итоге

Сделали логичное усложнение attention, улучшили метрики в задаче машинного перевода, и все это при небольших вычислительных затратах.

2018 November 15

Linguistically-Informed Self-Attention for Semantic Role Labeling

https://arxiv.org/abs/1804.08199

🕐 Когда - 28 августа 2018

За наводку спасибо @annapotapenko

👓 В чем понт

Выделение семантических ролей - одна из самых сложных, высокоуровневых и известных задач nlp. Нам интересно узнать, какие части предложения отвечает на вопросы ‘Кто?’, ‘Зачем?’, ‘Где?’, ‘За сколько?' и так далее. Авторы статьи, используя мультитаск на 4 задачи и свое ноу-хау - синтаксически информированный атеншн, бьют SOTA.

🔎 Подробности

Обычный атеншн

Атеншн нужен, чтобы получить для слов в предложении эмбеддинги, учитывая контекст. Или усреднить все слова в предложении с весами, которые пропорциональны близости к исходному слову в этом же предложении. Например в предложении ‘Я читаю про NLP, мне это нравится’, для слова ’это’ эмбеддинг будет средним от суммы эмбеддингов всех остальных слов, причем у слова ’NLP’ будет максимальный вес - слово ‘это' по сути и есть отсылка к ’NLP’ .

Синтаксически информированный атеншн

Обычный атеншн запускают несколько раз, чтобы веса разных атеншнов были ответственны за разные признаки - разные смыслы, синтаксис и тд. Сами не выбираем, за что будет отвечать каждый конкретный атеншн - сеть учит это сама. В синтаксическом атеншне авторы заставляют один из атеншнов обозначать синтаксис. Они берут разметку предложения по тому, какие слова являются предикатами(главными словами, обычно это глаголы) и учат атеншн так, чтобы вес между 2 словами был вероятностью, что одно слово предикат другого.

🛠 Мультитаск

Плюс к синтаксическому атеншну мы учим сеть параллельно еще на 3 задачи - парсинг зависимостей, выделение частей речи и определение предикатов. Hard-шарим веса модели на нижних слоях.

🖋 Что в итоге

Побили SOTA на задаче SRL и придумали новый крутой вид атеншна. Его можно масштабировать на все задачи, в которых есть дополнительная бинарная разметка по другим признакам. (Как в определении семантических ролей - разметка по определению предиката). Качество на задачах растет!

https://arxiv.org/abs/1804.08199

🕐 Когда - 28 августа 2018

За наводку спасибо @annapotapenko

👓 В чем понт

Выделение семантических ролей - одна из самых сложных, высокоуровневых и известных задач nlp. Нам интересно узнать, какие части предложения отвечает на вопросы ‘Кто?’, ‘Зачем?’, ‘Где?’, ‘За сколько?' и так далее. Авторы статьи, используя мультитаск на 4 задачи и свое ноу-хау - синтаксически информированный атеншн, бьют SOTA.

🔎 Подробности

Обычный атеншн

Атеншн нужен, чтобы получить для слов в предложении эмбеддинги, учитывая контекст. Или усреднить все слова в предложении с весами, которые пропорциональны близости к исходному слову в этом же предложении. Например в предложении ‘Я читаю про NLP, мне это нравится’, для слова ’это’ эмбеддинг будет средним от суммы эмбеддингов всех остальных слов, причем у слова ’NLP’ будет максимальный вес - слово ‘это' по сути и есть отсылка к ’NLP’ .

Синтаксически информированный атеншн

Обычный атеншн запускают несколько раз, чтобы веса разных атеншнов были ответственны за разные признаки - разные смыслы, синтаксис и тд. Сами не выбираем, за что будет отвечать каждый конкретный атеншн - сеть учит это сама. В синтаксическом атеншне авторы заставляют один из атеншнов обозначать синтаксис. Они берут разметку предложения по тому, какие слова являются предикатами(главными словами, обычно это глаголы) и учат атеншн так, чтобы вес между 2 словами был вероятностью, что одно слово предикат другого.

🛠 Мультитаск

Плюс к синтаксическому атеншну мы учим сеть параллельно еще на 3 задачи - парсинг зависимостей, выделение частей речи и определение предикатов. Hard-шарим веса модели на нижних слоях.

🖋 Что в итоге

Побили SOTA на задаче SRL и придумали новый крутой вид атеншна. Его можно масштабировать на все задачи, в которых есть дополнительная бинарная разметка по другим признакам. (Как в определении семантических ролей - разметка по определению предиката). Качество на задачах растет!

2018 December 16

Answerer in Questioner’s Mind: Information Theoretic Approach to Goal-Oriented Visual Dialog

http://papers.nips.cc/paper/7524-answerer-in-questioners-mind-information-theoretic-approach-to-goal-oriented-visual-dialog.pdf

👓В чем понт?

Свежая статья с NIPS 2018 (извините, NeurIPS😇), в которой авторы учат спрашивающего агента за минимальное число вопросов узнать у отвечающего агента класс обьекта на картинке, и бьют текущую SOTA. Главная фишка - спрашивающий выбирает такой вопрос, который минимизирует энтропию нужного класса, заранее подготавливая возможные вопросы.

🔎Подробности

Предыдущие SOTA состояли из отвечающего агента - простая сеть, генерящая ответ при условии вопроса и правильного класса, и спрашивающего агента - две реккурентный сетки, одна из которых генерит вопрос, вторая на основании ответа угадывает класс. Отвечающий в модели авторов не изменился, зато спрашивающий агент стал умнее. Теперь спрашивающий агент до начала игры генерит набор возможных вопросов. Потом из этих вопросов, зная набор классов и ответ, спрашивающий выбирает вопрос, который минимизирует энтропию по всему набору классов. Правильный класс при условии ответа выражается, как максимум вероятности из всех классов при условии ответа, состояния системы и вопроса (апостериорной вероятности). Чтобы все это посчитать, спрашивающему нужно знать модель отвечающего - вероятность ответа при условии вопрос и класса, так как параметры мы не шарим. Поэтому спрашивающий сеткой аппроксимирует эту вероятность.

🖋 Что в итоге?

Сделали модель, которая угадывает правильный класс в 63% случаях при 3 попытках и 79% случаев при 10 попытках, а ближайщие конкуренты дают качество 52% при 4 попытках. Так как голосовые помощники должны не только правдоподобно изображать человека, но и помогать отвечать на конкретные вопросы, улучшение очень важно. От вопросов и ответов о том, что изображено на картинке, можно перейти, например к генерации диалогов в ресторане - “Would you like to order?”- “Two coffees, please”.

http://papers.nips.cc/paper/7524-answerer-in-questioners-mind-information-theoretic-approach-to-goal-oriented-visual-dialog.pdf

👓В чем понт?

Свежая статья с NIPS 2018 (извините, NeurIPS😇), в которой авторы учат спрашивающего агента за минимальное число вопросов узнать у отвечающего агента класс обьекта на картинке, и бьют текущую SOTA. Главная фишка - спрашивающий выбирает такой вопрос, который минимизирует энтропию нужного класса, заранее подготавливая возможные вопросы.

🔎Подробности

Предыдущие SOTA состояли из отвечающего агента - простая сеть, генерящая ответ при условии вопроса и правильного класса, и спрашивающего агента - две реккурентный сетки, одна из которых генерит вопрос, вторая на основании ответа угадывает класс. Отвечающий в модели авторов не изменился, зато спрашивающий агент стал умнее. Теперь спрашивающий агент до начала игры генерит набор возможных вопросов. Потом из этих вопросов, зная набор классов и ответ, спрашивающий выбирает вопрос, который минимизирует энтропию по всему набору классов. Правильный класс при условии ответа выражается, как максимум вероятности из всех классов при условии ответа, состояния системы и вопроса (апостериорной вероятности). Чтобы все это посчитать, спрашивающему нужно знать модель отвечающего - вероятность ответа при условии вопрос и класса, так как параметры мы не шарим. Поэтому спрашивающий сеткой аппроксимирует эту вероятность.

🖋 Что в итоге?

Сделали модель, которая угадывает правильный класс в 63% случаях при 3 попытках и 79% случаев при 10 попытках, а ближайщие конкуренты дают качество 52% при 4 попытках. Так как голосовые помощники должны не только правдоподобно изображать человека, но и помогать отвечать на конкретные вопросы, улучшение очень важно. От вопросов и ответов о том, что изображено на картинке, можно перейти, например к генерации диалогов в ресторане - “Would you like to order?”- “Two coffees, please”.

2019 January 01

Cети на графах становятся все популярнее как в науке, так и в индустрии. Краткий обзор по методам и конкретным примерам применения графовых нейронок для тех, кто давно хотел разобраться, но стеснялся загуглить. Графовые нейросети используются не только при обработке соцсетей, молекул и в физических задачах, но и в более неочевидных ситуациях - например, при zero-shot learning на картинках.

https://telegra.ph/Nejronnye-seti-na-grafah-01-01

https://telegra.ph/Nejronnye-seti-na-grafah-01-01

2019 January 21

Emergent Communication through Negotiation

https://openreview.net/pdf?id=Hk6WhagRW

👓 В чем понт?

Как нужно организовывать переговоры, чтобы достичь цели? Чем переговоры с несколькими людьми отличаются от переговоров с конкретным человеком? Кто предоставляет больше информации - тот, кто начинает говорить первым или последним? Когда переговаривающиеся могут пойти на компромисс? На эти и многие другие вопросы можно ответить используя RL-среду с агентами как пробирку.

🔎 Подробности

👯♂️ Агенты и задача

Зададим 2 агентов и 3 продукта - перец, клубнику и вишню. Зададим каждому агенту фиксированный коэффициент "любви" к каждому продукту - от 0 до 5. В результате игры агентам нужно договориться, какое количество (от 0 до 10) каждого продукта они выбирают. Сделаем 2 вида агентов. Для эгоистичных агентов наградой будет "любовь" умноженная на количество каждого продукта только для себя, а у каждого из коллективных агентов - сумма таких наград для обоих агентов. Будем также штрафовать агентов за длину переговоров. Дадим агентам 2 канала коммуникации - предложение, где они спрашивают другого агента, устраивает ли их выбранное количество продуктов, и лингвистический - набор символов в свободной форме, который агенты учат сами ( они могутдаже врать друг другу). Будим учить 3 политики - для получения предложения, лингвистического сообщения и для того, чтобы закончить коммуникацию.

🗒 Анализ

Авторы анализируют поведение агентов и отвечают на будоражащие вопросы. Например...

🍽 Могут ли эгоистичные агенты честно делить награду?

Да, могут. После того, как агенты выучиваются обнаруживается, что их награды примерно одинаковые. Причем учатся они лучше по каналу предложения, лингвистический канал слишком шумный.

🔗 Могут ли агенты пойти на компромисс?

Зададим агентам немного другую награду - суммарную награду агентов, нормированную на максимальную награду, которую можно получить с исходными коэффициентами "любви" агентов к конкретным продуктам. В таком сетапе выясняется, что роль лингвистического сообщения в свободной форме возрастает и агенты начинают кооперироваться, сдвигать свой реворд в сторону агента с большими коэффициентами "любви".

🖋 О чем пишут агенты, и кто именно пишет?

Посмотрим на набор лингвистических сообщений и обнаружим, что их большое разнообразие и информативность присутствует только у агента, который начал говорить вторым - агенты автоматически разделяются на слушающего и говорящего. По сообщениям, которые передают агенты будем предсказывать, к какому решению они пришли в итоге - это получается хорошо, значит в сообщениях есть семантический контекст.

👨👩👧👦 Имитация социума.

Теперь зафиксируем слушающего и говорящего агента, и на каждую итерацию тренировки будем давать ему не одного уникального агента, а нового агента из набора из 10 агентов. Попробуем передавать информацию об ID агента. Занимательно, что ID больше поможет эгоистичному агенту, чем кооперативному. Интересно также, что в процессе тренировки агенты формируют единый язык, который позволяет поднять качество.

🍢Что в итоге

Выводы полученные в статье, коррелируют с наработками из теории игр. Кажется, что подобные среды могут стать способом изучать психологию "in silico" (в вычислительной симуляции).

https://openreview.net/pdf?id=Hk6WhagRW

👓 В чем понт?

Как нужно организовывать переговоры, чтобы достичь цели? Чем переговоры с несколькими людьми отличаются от переговоров с конкретным человеком? Кто предоставляет больше информации - тот, кто начинает говорить первым или последним? Когда переговаривающиеся могут пойти на компромисс? На эти и многие другие вопросы можно ответить используя RL-среду с агентами как пробирку.

🔎 Подробности

👯♂️ Агенты и задача

Зададим 2 агентов и 3 продукта - перец, клубнику и вишню. Зададим каждому агенту фиксированный коэффициент "любви" к каждому продукту - от 0 до 5. В результате игры агентам нужно договориться, какое количество (от 0 до 10) каждого продукта они выбирают. Сделаем 2 вида агентов. Для эгоистичных агентов наградой будет "любовь" умноженная на количество каждого продукта только для себя, а у каждого из коллективных агентов - сумма таких наград для обоих агентов. Будем также штрафовать агентов за длину переговоров. Дадим агентам 2 канала коммуникации - предложение, где они спрашивают другого агента, устраивает ли их выбранное количество продуктов, и лингвистический - набор символов в свободной форме, который агенты учат сами ( они могутдаже врать друг другу). Будим учить 3 политики - для получения предложения, лингвистического сообщения и для того, чтобы закончить коммуникацию.

🗒 Анализ

Авторы анализируют поведение агентов и отвечают на будоражащие вопросы. Например...

🍽 Могут ли эгоистичные агенты честно делить награду?

Да, могут. После того, как агенты выучиваются обнаруживается, что их награды примерно одинаковые. Причем учатся они лучше по каналу предложения, лингвистический канал слишком шумный.

🔗 Могут ли агенты пойти на компромисс?

Зададим агентам немного другую награду - суммарную награду агентов, нормированную на максимальную награду, которую можно получить с исходными коэффициентами "любви" агентов к конкретным продуктам. В таком сетапе выясняется, что роль лингвистического сообщения в свободной форме возрастает и агенты начинают кооперироваться, сдвигать свой реворд в сторону агента с большими коэффициентами "любви".

🖋 О чем пишут агенты, и кто именно пишет?

Посмотрим на набор лингвистических сообщений и обнаружим, что их большое разнообразие и информативность присутствует только у агента, который начал говорить вторым - агенты автоматически разделяются на слушающего и говорящего. По сообщениям, которые передают агенты будем предсказывать, к какому решению они пришли в итоге - это получается хорошо, значит в сообщениях есть семантический контекст.

👨👩👧👦 Имитация социума.

Теперь зафиксируем слушающего и говорящего агента, и на каждую итерацию тренировки будем давать ему не одного уникального агента, а нового агента из набора из 10 агентов. Попробуем передавать информацию об ID агента. Занимательно, что ID больше поможет эгоистичному агенту, чем кооперативному. Интересно также, что в процессе тренировки агенты формируют единый язык, который позволяет поднять качество.

🍢Что в итоге

Выводы полученные в статье, коррелируют с наработками из теории игр. Кажется, что подобные среды могут стать способом изучать психологию "in silico" (в вычислительной симуляции).

2019 February 09

A Unified Framework for Marketing Budget Allocation

https://arxiv.org/pdf/1902.01128.pdf

🕐 Когда - 4 февраля 2019

👓 В чем понт?

Вечный вопрос маркетинга - как, куда и сколько нужно потратить денег на рекламу, чтобы получить максимальную отдачу в выручке. Авторы статьи, работающие в исследованиях Alibaba, построили модель, оптимизирующую распределение бюджета на рекламу, и доказали ее эффективность в онлайн эксперименте при планировании бюджета компании.

🖋 Подробности

🔗 Модель

При оптимизации маркетинговых кампаний рынок бьется на сегменты, а для каждого сегмента мы предположительно знаем максимальный обьем дохода, который можно с этого сегмента получить. Пример сегмента - билеты на развлекательный фильм на выходные. Авторы бьют задачу на две части. Первая часть - для каждого сегмента по исторической выборке мы строим модель того, как количество денег, выделенных на рекламу, влияет на прибыль (точнее на коэффициент того, сколько прибыли мы получим от максимального количества прибыли, которое можно выбить на этом сегменте - размер рынка). Мы предполагаем, что этот коэффициент это логистическая функция от рекламного бюджета, с помощью модели ML нам остается подогнать коэффициенты этой функции для каждого сегмента. Вторая часть - с помощью найденной модели мы распределяем рекламный бюджет максимально эффективно с точки зрения прибыли, имея какое-то ограничение на этот бюджет.

🗒 Данные

В качестве обучающей выборки авторы взяли датасет компании Taopiaopiao4 - крупнейшей платформы для продажи билетов в кино в Китае.В данных содержалось 60 тысяч сегментов рынка за более чем 152 дня. Для каждого сегмента рынка объем продаж накапливался ежедневно, а размер рынка был предоставлен государственным органом. Датасет содержал дополнительную информацию- кино, день недели, город и т. д.

🛠 Эксперименты

В аб тесте авторы сравнивали прибыль и расходы на маркетинг для рекламной кампании сделанной по модели и со стандартным равномерным распределением бюджета. Модель дала профит на 6% больше прибыли при на 40% меньших затратах на маркетинг.

🗝 Что в итоге?

Сделали крутую модель, увеличили эффективность рекламной кампании в АлиБабе в аб тесте. В модели авторы круто совместили экономические идеи с нейросетками. Кажется, такой гибридный подход с использованием машинного обучения будет становится все популярней, так как данных про эффективность рекламных кампаний становится все больше, с ростом рынка и переходом продаж в онлайн.

https://arxiv.org/pdf/1902.01128.pdf

🕐 Когда - 4 февраля 2019

👓 В чем понт?

Вечный вопрос маркетинга - как, куда и сколько нужно потратить денег на рекламу, чтобы получить максимальную отдачу в выручке. Авторы статьи, работающие в исследованиях Alibaba, построили модель, оптимизирующую распределение бюджета на рекламу, и доказали ее эффективность в онлайн эксперименте при планировании бюджета компании.

🖋 Подробности

🔗 Модель

При оптимизации маркетинговых кампаний рынок бьется на сегменты, а для каждого сегмента мы предположительно знаем максимальный обьем дохода, который можно с этого сегмента получить. Пример сегмента - билеты на развлекательный фильм на выходные. Авторы бьют задачу на две части. Первая часть - для каждого сегмента по исторической выборке мы строим модель того, как количество денег, выделенных на рекламу, влияет на прибыль (точнее на коэффициент того, сколько прибыли мы получим от максимального количества прибыли, которое можно выбить на этом сегменте - размер рынка). Мы предполагаем, что этот коэффициент это логистическая функция от рекламного бюджета, с помощью модели ML нам остается подогнать коэффициенты этой функции для каждого сегмента. Вторая часть - с помощью найденной модели мы распределяем рекламный бюджет максимально эффективно с точки зрения прибыли, имея какое-то ограничение на этот бюджет.

🗒 Данные

В качестве обучающей выборки авторы взяли датасет компании Taopiaopiao4 - крупнейшей платформы для продажи билетов в кино в Китае.В данных содержалось 60 тысяч сегментов рынка за более чем 152 дня. Для каждого сегмента рынка объем продаж накапливался ежедневно, а размер рынка был предоставлен государственным органом. Датасет содержал дополнительную информацию- кино, день недели, город и т. д.

🛠 Эксперименты

В аб тесте авторы сравнивали прибыль и расходы на маркетинг для рекламной кампании сделанной по модели и со стандартным равномерным распределением бюджета. Модель дала профит на 6% больше прибыли при на 40% меньших затратах на маркетинг.

🗝 Что в итоге?

Сделали крутую модель, увеличили эффективность рекламной кампании в АлиБабе в аб тесте. В модели авторы круто совместили экономические идеи с нейросетками. Кажется, такой гибридный подход с использованием машинного обучения будет становится все популярней, так как данных про эффективность рекламных кампаний становится все больше, с ростом рынка и переходом продаж в онлайн.

2019 February 24

On Voting Strategies and Emergent Communication

https://arxiv.org/pdf/1902.06897.pdf

🕐 Когда - 19 февраля 2019 года

👓 В чем понт

Как ведут себя кандидаты, когда хотят, чтобы за них проголосовали избиратели (классическая демократия), и как - когда цель каждого кандидата - сделать так, чтобы избиратели проголосовали за одного, заранее выбранного из них кандидата (выборы в России)? Какие есть особенности у языка, которым общаются избиратели и кандидаты? Как передающие свойства среды влияют на это общение? На эти вопросы отвечают авторы в своей статье.

🔎 Подробности

🛠 Задача

Авторы изучали следующую игру: 2 кандидата (но можно распространить и на большее число) передают сообщения своим избирателям и друг другу, в свою очередь избиратели тоже общаются между собой и кандидатами. После стадии общения идет стадия голосования - избиратели выбирают одного из кандидатов и отдают свой голос за него (выбирают того кандидата, чье сообщение было по норме ближе к сообщению избирателя, таким образом агенты говорят на одном языке). В статье использовался трюк Gumbel softmax - поскольку операция выбора конкретного сообщения является недиффиренциируемой, можно стянуть вероятностное распределение к одной из категорий, образуя полностью дифференциируемый алгоритм. Авторы давали

разные награды кандидатам - в одном случае каждому кандидату эгоистичную (поощряют кандидата, если он выиграл), в другом случае - ‘альтруистичную’ - оба агента на самом деле хотят, чтобы выиграл один из кандидатов. Награда голосующих - то, насколько в среднем они уверенно голосуют за кандидатов (норма разности сообщений)

🗒 Результаты

Когда кандидаты способствуют тому, чтобы избиратели выбрали только одного из них, часто один из кандидатов начинает молчать. Плюс выбирать нужного кандидата избирателям становится трудней, когда плотность сети, по которой передаются сигналы об общении кандидатов и избирателей, избирателей друг с другом и кандидатов друг с другом начинает возрастать - сообщения избирателей начинают больше влиять на других избирателей, а сообщениям кандидатов становится тяжелее дойти.

Также авторы изучали язык, который используют кандидаты. Кандидаты использовали одинаковые частотные выражения и разные - редкие (аналогия c служебными словами ‘и’, ‘тут’, ‘вот’ в нашем языке). Язык сообщений, которые используют избиратели, авторы кластеризовали и выделили два устойчивых кластера, в которых язык существенно отличался. Это напоминает информационный пузырь, который образуется вокруг приверенженцов какой-либо партии.

🖋 Что в итоге

Сделана пробирка для изучения поведения очень интересной системы, с которой мы сталкиваемся регулярно - выборами. В задаче можно добавить еще много всего - увеличивать число кандидатов, вводить разные награды, накладывать ограничения на язык и добавить эгоистичную награду избирателям.

https://arxiv.org/pdf/1902.06897.pdf

🕐 Когда - 19 февраля 2019 года

👓 В чем понт

Как ведут себя кандидаты, когда хотят, чтобы за них проголосовали избиратели (классическая демократия), и как - когда цель каждого кандидата - сделать так, чтобы избиратели проголосовали за одного, заранее выбранного из них кандидата (выборы в России)? Какие есть особенности у языка, которым общаются избиратели и кандидаты? Как передающие свойства среды влияют на это общение? На эти вопросы отвечают авторы в своей статье.

🔎 Подробности

🛠 Задача

Авторы изучали следующую игру: 2 кандидата (но можно распространить и на большее число) передают сообщения своим избирателям и друг другу, в свою очередь избиратели тоже общаются между собой и кандидатами. После стадии общения идет стадия голосования - избиратели выбирают одного из кандидатов и отдают свой голос за него (выбирают того кандидата, чье сообщение было по норме ближе к сообщению избирателя, таким образом агенты говорят на одном языке). В статье использовался трюк Gumbel softmax - поскольку операция выбора конкретного сообщения является недиффиренциируемой, можно стянуть вероятностное распределение к одной из категорий, образуя полностью дифференциируемый алгоритм. Авторы давали

разные награды кандидатам - в одном случае каждому кандидату эгоистичную (поощряют кандидата, если он выиграл), в другом случае - ‘альтруистичную’ - оба агента на самом деле хотят, чтобы выиграл один из кандидатов. Награда голосующих - то, насколько в среднем они уверенно голосуют за кандидатов (норма разности сообщений)

🗒 Результаты

Когда кандидаты способствуют тому, чтобы избиратели выбрали только одного из них, часто один из кандидатов начинает молчать. Плюс выбирать нужного кандидата избирателям становится трудней, когда плотность сети, по которой передаются сигналы об общении кандидатов и избирателей, избирателей друг с другом и кандидатов друг с другом начинает возрастать - сообщения избирателей начинают больше влиять на других избирателей, а сообщениям кандидатов становится тяжелее дойти.

Также авторы изучали язык, который используют кандидаты. Кандидаты использовали одинаковые частотные выражения и разные - редкие (аналогия c служебными словами ‘и’, ‘тут’, ‘вот’ в нашем языке). Язык сообщений, которые используют избиратели, авторы кластеризовали и выделили два устойчивых кластера, в которых язык существенно отличался. Это напоминает информационный пузырь, который образуется вокруг приверенженцов какой-либо партии.

🖋 Что в итоге

Сделана пробирка для изучения поведения очень интересной системы, с которой мы сталкиваемся регулярно - выборами. В задаче можно добавить еще много всего - увеличивать число кандидатов, вводить разные награды, накладывать ограничения на язык и добавить эгоистичную награду избирателям.