RR

Size: a a a

2021 October 08

спасибо за идею

p

вот да, ощущение что иная работа с данными и приходится больше заниматься методами обучения,

2021 October 09

АК

Хорошо, если получится)

2021 October 11

B

Кто-нибудь пользовался этой библиотекой для создания сред для model-based RL?

https://github.com/jazlab/moog.github.io

https://github.com/jazlab/moog.github.io

p

я нет.

Много аналогичных библиотек существует, для model-based RL?

Много аналогичных библиотек существует, для model-based RL?

B

Автор сравнивает ее с DM-Lab, Mujoco, VizDoom, но их конечно нельзя назвать специализированными для model-based. Библиотека по ссылке в общем случае предназначена для object-oriented RL, но я предполагаю, что она разработана отчасти как продолжение исследования Data-Efficient Model-Based RL through Unsupervised Object Discovery and Curiosity-Driven Exploration https://arxiv.org/abs/1905.09275

B

Короче, я пробовал запускать демо на win10 и ubuntu 20.04, состояние среды должно рендериться через tkinter, окно появляется, но оно пустое. Под виндой все работает, если зажать левую кнопку мыши на title bar окна с игрой)) Но это явно не то, как оно должно работать

IM

Не подскажите, какие хорошие подходы для контроля одним агентов варьирующегося числа юнитов разного типа?

И как эта парадигма называется? Это же не мультиагентность, я так понимаю (агент один, варьируется action space)?

Игра напоминает старкрафт, но намного проще - lux ai challenge на кегл, пытаюсь сделать дизайн end to end rl agent, чтобы один контролил всех своих юнитов, тк подход где каждый юнит сам принимает решения кажется неполноценным, хоть и популярный среди rl приложений

И как эта парадигма называется? Это же не мультиагентность, я так понимаю (агент один, варьируется action space)?

Игра напоминает старкрафт, но намного проще - lux ai challenge на кегл, пытаюсь сделать дизайн end to end rl agent, чтобы один контролил всех своих юнитов, тк подход где каждый юнит сам принимает решения кажется неполноценным, хоть и популярный среди rl приложений

A

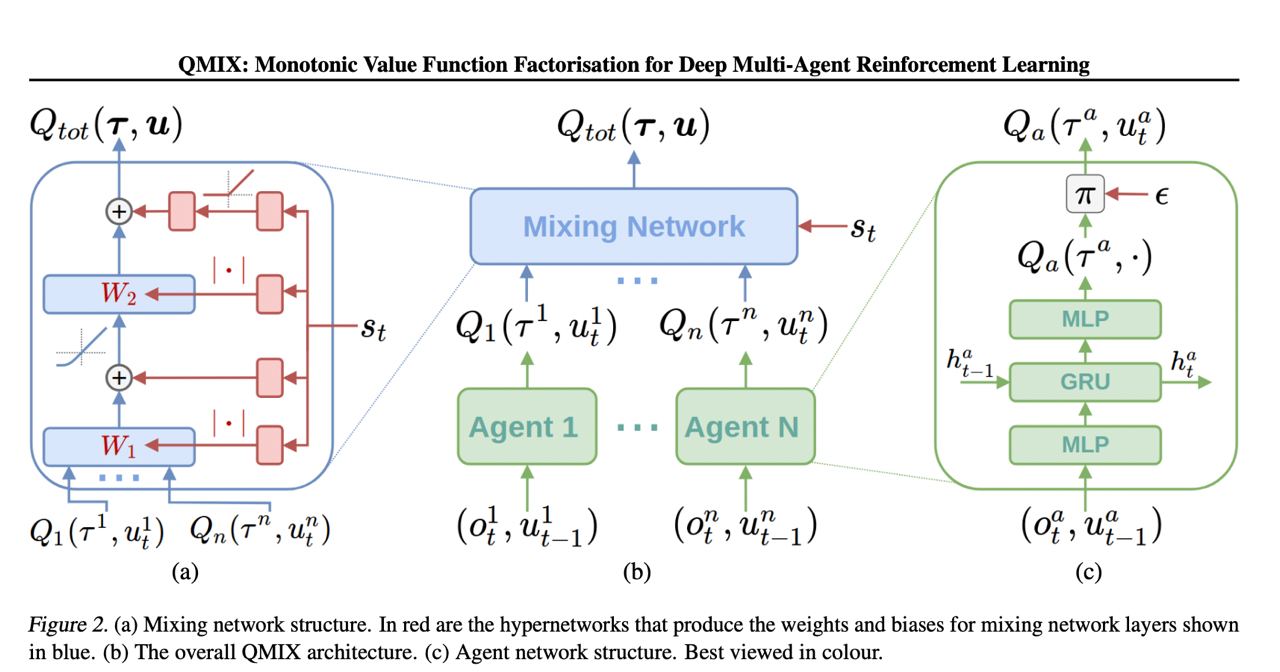

Посмотри qmix статью и там во введении или в первых главах есть описание

IM

спасибо, я прочитаю

2021 October 14

A

Всем привет, кто-нибудь сталкивался с проблемой гпу внутри среды рллиба?

Рекомендация на сайте @ray.remote() и use_gpu() работает только вне среды (и иногда срабатывает внутри, ведёт себя нестабильно и при запуске тех же ячеек выдаёт разный результат)

Рекомендация на сайте @ray.remote() и use_gpu() работает только вне среды (и иногда срабатывает внутри, ведёт себя нестабильно и при запуске тех же ячеек выдаёт разный результат)

2021 October 18

EZ

S

Наконец-то!

P

раньше лицензия достаточно больших денег стоила

ID

при этом с edu мейлом без проблем можно было получить

IK

кто-то знает какие-то хорошие курсы по mujoco? желательно, конкретно по коллаборативным манипуляторам

KS

нет - там были проблемы)

нельзя было юзать для ресерча например)

нельзя было юзать для ресерча например)

SS

Интересно, сколько заплатили

P

А вот да?

2021 October 22

IM

архитектура qmix больше подходит для сеттинга, где количество юнитов постоянно, а не варьируется т.к. 1) mixing network, которая берет на вход q-values юнитов это mlp, и 2) предполагается выучивание q-value для каждого юнита

Мб если модифицировать qmix mixing network в какую то рекурентность, то можно переделать метод для варьирующегося числа юнитов

еще меня чуть смущает, что такой сильный акцент на partial observability между самими юнитами, per unit q-values, которые они как бы фиксят через hypernetwork от state для весов mixing net, чтобы интегрировать оценку q-value на основе всей доступной инфы, как будто есть недостаток в изначальной архитектуре с q-values per unit, а это костыль поверх этого недостатка (относительно их же примеров с игрой в табличку и маленькие файты в старкрафт, где нет этой partial obervability per unit), имхо, мб моя критика от непонимания чего-то

возможно в старкрафт и тд сеттингах (fully cooperative, shared team reward) centralized policy мне кажется лучше, чем decentralized

Мб если модифицировать qmix mixing network в какую то рекурентность, то можно переделать метод для варьирующегося числа юнитов

еще меня чуть смущает, что такой сильный акцент на partial observability между самими юнитами, per unit q-values, которые они как бы фиксят через hypernetwork от state для весов mixing net, чтобы интегрировать оценку q-value на основе всей доступной инфы, как будто есть недостаток в изначальной архитектуре с q-values per unit, а это костыль поверх этого недостатка (относительно их же примеров с игрой в табличку и маленькие файты в старкрафт, где нет этой partial obervability per unit), имхо, мб моя критика от непонимания чего-то

возможно в старкрафт и тд сеттингах (fully cooperative, shared team reward) centralized policy мне кажется лучше, чем decentralized