c

Size: a a a

2020 April 02

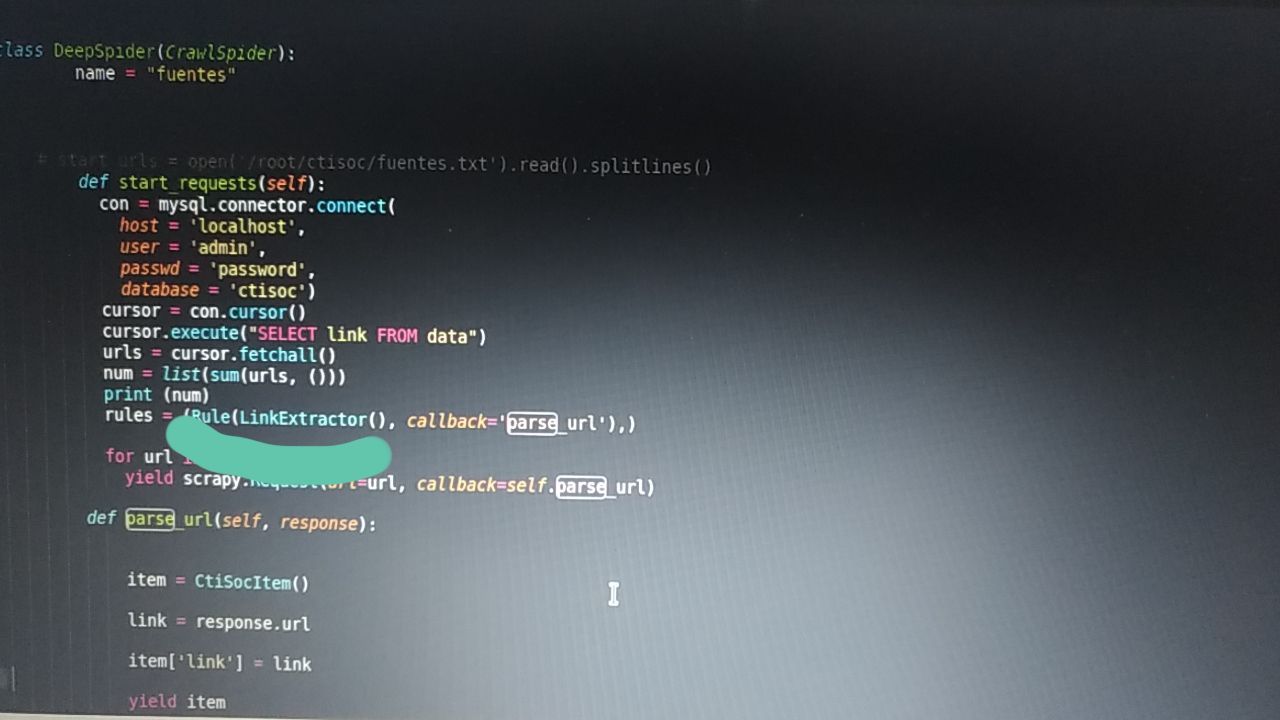

LinkExtractor doesn't work

AR

camilo

@wrar42 could you help me please?

other people already helped you, if that wasn't enough please describe the problem again, after fixing the problems people pointed you at

c

The problem is that LinkExtractor doesn't work

AR

you aren't even using it, why would it "work"

c

you aren't even using it, why would it "work"

AR

yeah, you just created an empty LinkExtractor object and put it into a Rule object which you never use

AR

this isn't supposed to "work"

c

Do I use the Rule object?

AR

I just said that you don't...

c

I change the question, How does Crawlspider with start_requests?

AR

it doesn't use start_requests()

c

Can't I use Crawlspider with start_requests?

AR

you probably can, if you reimplement parts of it (at least the ones that handle start_urls and start the CrawlSpider machinery)

c

Thank you

AC

Всем привет! А как правильно парсить через скрапи с помощью селениума?

Пробовал через

Пробовал через

scrapy_selenium import SeleniumRequest но тогда некоторые домены не парсятся, а вот если напрямую в parse ф-ии обрабатывать урл с помощью selenium webdriver то гораздо больше доменов удается спарсить. Но минус в другом - создается 10к процессов хрома2020 April 03

AБ

Alexander Chaptykov

Всем привет! А как правильно парсить через скрапи с помощью селениума?

Пробовал через

Пробовал через

scrapy_selenium import SeleniumRequest но тогда некоторые домены не парсятся, а вот если напрямую в parse ф-ии обрабатывать урл с помощью selenium webdriver то гораздо больше доменов удается спарсить. Но минус в другом - создается 10к процессов хромаа driver.pagesource что не канает?

AБ

или я чего то не допонимаю

AБ

Народ, подскажите можно как то сделать типа "динамического" кода

типа

webdriver.arg1().arg2() и что бы вместо arg1 и arg2 подставлять find id, css, name и т.д

типа

webdriver.arg1().arg2() и что бы вместо arg1 и arg2 подставлять find id, css, name и т.д