i

Size: a a a

2020 April 02

c

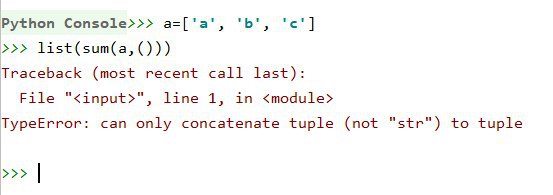

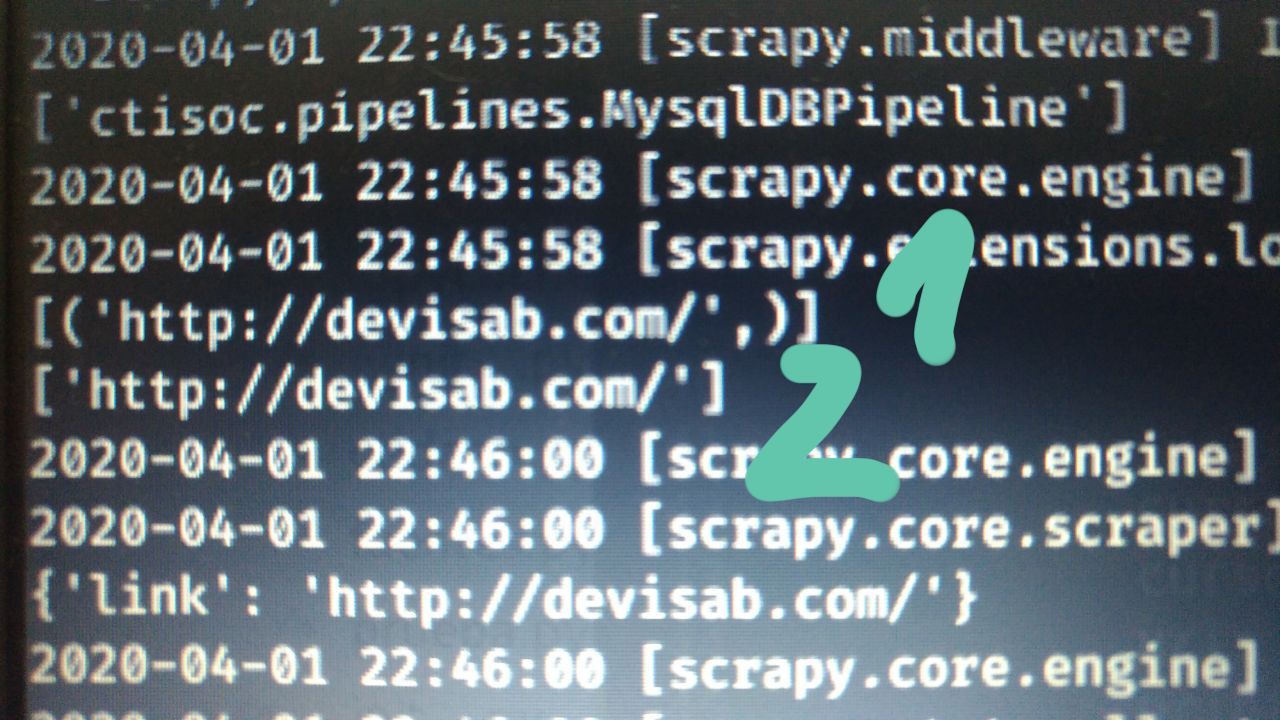

I am converting urls to a list of tuples and then iterate on this

AБ

ребят, мне нужно две вещи. Запись нажатых ссылок и вводимых данных. Как это можно сделать?

AБ

В дальнейшем аналогичные действия будут повторяться в селениуме, только с другими вводимыми данными.

Видел iMacros. В целом как бы и вариант, но несколько более замороченный, придётся приеобразовывать тэги, потом искать их. Хотелось бы просто ссылки сразу получать

Видел iMacros. В целом как бы и вариант, но несколько более замороченный, придётся приеобразовывать тэги, потом искать их. Хотелось бы просто ссылки сразу получать

AБ

хотя щяс полазил, у iMacros несколько способов записи, так что можно выбрать нужный