r

Size: a a a

2020 April 02

B

Подскажите, есть сеты табличных данных в консоли показано количество td в сете. (название ячейки и значение)

Таких сетов почти 15к. Есть решение лучше чем на ходу создавать колонки под название ячейки чтобы сохранить в нормальном виде ?

(проверять наличие колонки, сохранять значение)

Таких сетов почти 15к. Есть решение лучше чем на ходу создавать колонки под название ячейки чтобы сохранить в нормальном виде ?

(проверять наличие колонки, сохранять значение)

Например можно писать в формат с разделителем - csv

B

Тот случай когда парсинг делал по одной странице и пустил на все остальные ) теперь думаю как нормализовать эту дичь

Может лучше заново спарить в нормальный вид?

r

Может лучше заново спарить в нормальный вид?

да там сами данные такие, у одного объекта могут быть разные комплектации. Можно конечно повозиться, но не думаю что это сильно упростит задачу

B

да там сами данные такие, у одного объекта могут быть разные комплектации. Можно конечно повозиться, но не думаю что это сильно упростит задачу

Тогда можно писать в json, к каждому объекту добавлять значения

r

Тогда можно писать в json, к каждому объекту добавлять значения

С json сильная просадка по скорости в таких объёмах

B

я всеравно я не очень понимаю что не так с данными, покажите пример. Ну или можно кто другой подскажет.

МС

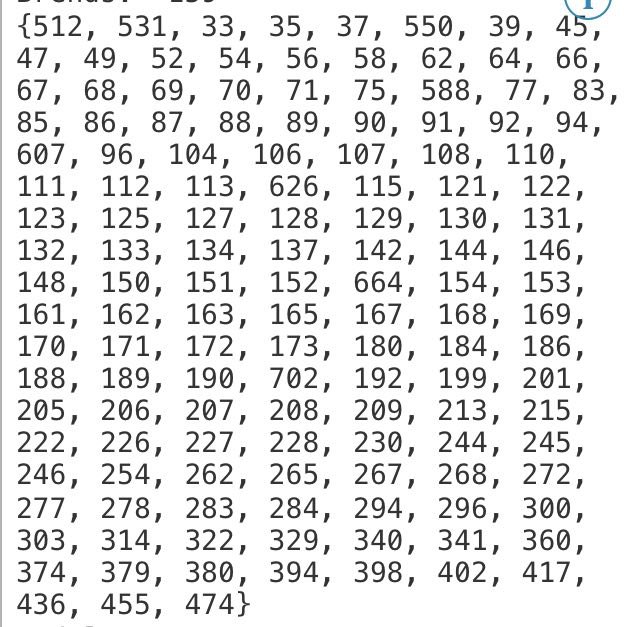

Это по сути количество типов таблиц, под каждый парсить тот ещё гем. А так это один объект, просто у одного меньше полей у другого больше. Просто перед тем как парсить на основе пары страниц посмотрел что они вроде одинаковые, а спарсил получил такой разбег в объёме полей.

А какие объемы? Если не секрет. Ну и, никто не отменял базы. Либо типа монги

r

я всеравно я не очень понимаю что не так с данными, покажите пример. Ну или можно кто другой подскажет.

Brand;model;year;modifications; у модификации 20–100 полей (key, value)

Думаю собрать все названия полей, в sqlite создать колонки, а потом по совпадению записывать данные.

Думаю собрать все названия полей, в sqlite создать колонки, а потом по совпадению записывать данные.

r

А какие объемы? Если не секрет. Ну и, никто не отменял базы. Либо типа монги

15к объектов

МС

15к объектов

Шта? Это "много"

Обычный json и не забивай голову

Обычный json и не забивай голову

АД

Добрый день, коллеги, прошу подсказать хороший ресурс для быстрого входа. Ни как концепцию понять не могу. Спасибо

r

Шта? Это "много"

Обычный json и не забивай голову

Обычный json и не забивай голову

Проблема не в скорости, чтения записи, а возможности быстро чистить и проверять данные.

МС

Добрый день, коллеги, прошу подсказать хороший ресурс для быстрого входа. Ни как концепцию понять не могу. Спасибо

Концепцию чего? Самого скрапи? Или парсинга?

АД

самого скрапи

МС

Проблема не в скорости, чтения записи, а возможности быстро чистить и проверять данные.

Вообще, я говорил и про то и про другое