i

Size: a a a

2020 July 22

не, это не про нас, мы не пишем туда, в нашем случае это обычный гипервизор KVM, там всегда есть резерв места для бэкапа снапшотами, тонкий LVM не используем, ибо в нашем случае от него одни минусы.

От него плюсы только при оверселле, но это плохая практика, стор не настолько дорогой, чтобы рисковать данными клиентов

NS

Для теста делал два диска по тб, затем расширил основной до двух и релоцировал. Заняло где-то час, несмотря на то, что данных почти не было.

фс была поверх? если да, то чситай что ему пришлось весь массив мувить.

i

фс была поверх? если да, то чситай что ему пришлось весь массив мувить.

Да, знаю, просто было интересно, учитывает ли sparse области при перемещении, или нет.

A

Для теста делал два диска по тб, затем расширил основной до двух и релоцировал. Заняло где-то час, несмотря на то, что данных почти не было.

непонятно. это stripe что ли на 2 диска был исходно?

A

делать миррор или страйп средствами lvm вообще беда

i

непонятно. это stripe что ли на 2 диска был исходно?

2 PV в VG, и LV поверх.

A

там с этим все плоооохо

A

md с этим гораздо лучше работает

A

lvm поверх md

i

Нормальный кейс, если поверх единички, но не стоит объединять устройства с разной производительностью, например 15kRPM и 10kRPM

i

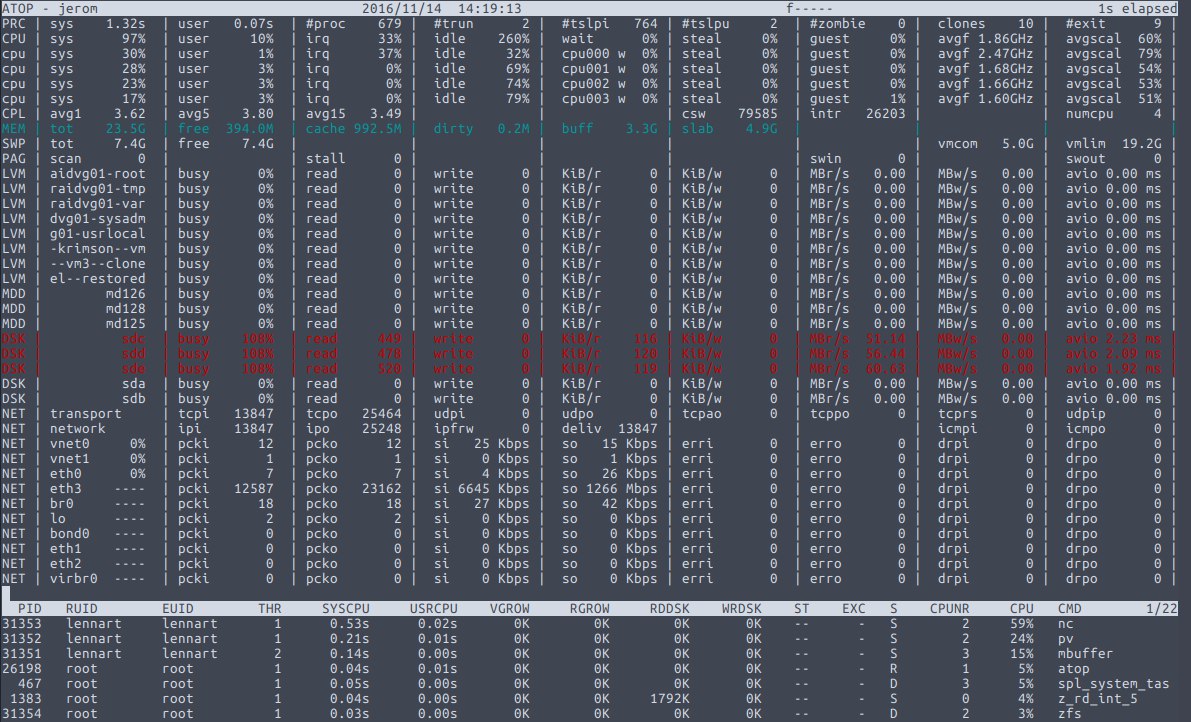

Ситуёвина есть такая, может кто сталкивался.

Есть дедик в хетцнере, на нём гипер-параша, надо мигрировать виртуалки к себе в ЦОД. В плане железа на передающей стороне - PX92, контроллер Adaptec 8405, к нему подключены 2 SSD в единичке и два 6TB HDD в нуле. Бэкап на StorageBox медленный, но в хорошую погоду где-то 320...800mbps.

При передаче в рашу скорость передачи образа ограничивается 8-10mbps, при этом если отправлять несколько одновременных, то на полосу это не влияет, а так же стабильно 8...10mbps на каждый. Проверил полосу с iperf - там гораздо больше в пике. Пинг - 41...44мс. Замерил последовательную запись на принимающей стороне - там тоже не упираюсь в полосу интерфейса и массива (ZFS RAID10 на 8 дисков). С чем ещё это может быть связано?

Есть дедик в хетцнере, на нём гипер-параша, надо мигрировать виртуалки к себе в ЦОД. В плане железа на передающей стороне - PX92, контроллер Adaptec 8405, к нему подключены 2 SSD в единичке и два 6TB HDD в нуле. Бэкап на StorageBox медленный, но в хорошую погоду где-то 320...800mbps.

При передаче в рашу скорость передачи образа ограничивается 8-10mbps, при этом если отправлять несколько одновременных, то на полосу это не влияет, а так же стабильно 8...10mbps на каждый. Проверил полосу с iperf - там гораздо больше в пике. Пинг - 41...44мс. Замерил последовательную запись на принимающей стороне - там тоже не упираюсь в полосу интерфейса и массива (ZFS RAID10 на 8 дисков). С чем ещё это может быть связано?

2020 July 23

A

сколько много умных слов :-) записываю , StorageBox какой-то там

A

ivdok - размер окна tcp увеличь

A

Полоса пропускания (бит/сек) * RTT (круговое время передачи по сети) = размер окна в битах

A

100 000 000 бит * 0.045 сек / 8 = 562500 байт размер окна . с таким в идеальных условиях достигнешь 100мбит

A

когда размер окна ( считай приемный буфер ) меньше , оно в него больше не наваливает, ждет пока подтверждения по прошлым обратно долетят

A

nc -l 8000 | \

mbuffer -q -s 128k -m 1G | \

pv -rtab | \

sudo zfs receive -vF backups/home

mbuffer -q -s 128k -m 1G | \

pv -rtab | \

sudo zfs receive -vF backups/home

A

sudo zfs send -I storage/home@2016-06-01_monthly storage/home@2016-09-01_monthly | \

mbuffer -q -s 128k -m 1G | \

pv -b | \

nc 192.168.20.3 8000

mbuffer -q -s 128k -m 1G | \

pv -b | \

nc 192.168.20.3 8000