MT

Size: a a a

2020 July 14

"Мы показали, что в рамках контекстно-смыслового подхода можно реализовать и объединить механизмы формальных грамматик и рекуррентных нейронных сетей с долгой краткосрочной памятью. Мы продемонстрировали это на примере парсинга произвольных текстов на русском языке."

SP

Ну, продемонстрировали, надо посмотреть.

MT

Возможно после тредов про биморф я стал более подозрительным конечно

DD

Переслано от Anton Kolonin

А в этот четверг в 18-00 по Москве - очередной семинар AGI-по-русски:

Алексей Редозубов, автор концепции, TrueBrainComputing http://truebraincomputing.com

"Мы претендуем на то, что создали модели сильного ИИ, и нам удалось показать, что мозг работает именно так.

Ключевым в этом стало определение понятия смысла."

https://www.facebook.com/groups/agirussia/?multi_permalinks=3289682267736995 - для участия отпишитесь в ФБ, а я попрошу сюда ссылку продублировать

Алексей Редозубов, автор концепции, TrueBrainComputing http://truebraincomputing.com

"Мы претендуем на то, что создали модели сильного ИИ, и нам удалось показать, что мозг работает именно так.

Ключевым в этом стало определение понятия смысла."

https://www.facebook.com/groups/agirussia/?multi_permalinks=3289682267736995 - для участия отпишитесь в ФБ, а я попрошу сюда ссылку продублировать

А есть какой-нибудь текст на эту тему, чтобы заранее ознакомиться?

AK

А есть какой-нибудь текст на эту тему, чтобы заранее ознакомиться?

Это не ко мне 😊 Можно у коллег на сайте порыться http://truebraincomputing.com/

MT

Я думаю у них на сайте в разделе публикаций можно глянуть

I

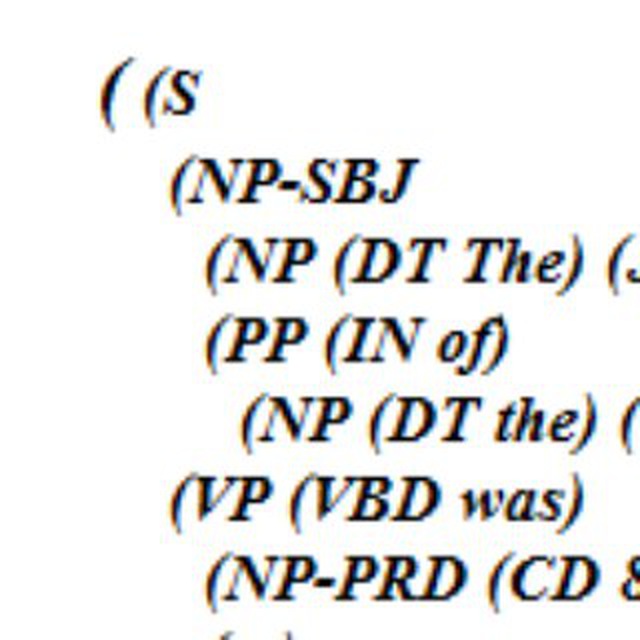

"Мы показали, что в рамках контекстно-смыслового подхода можно реализовать и объединить механизмы формальных грамматик и рекуррентных нейронных сетей с долгой краткосрочной памятью. Мы продемонстрировали это на примере парсинга произвольных текстов на русском языке."

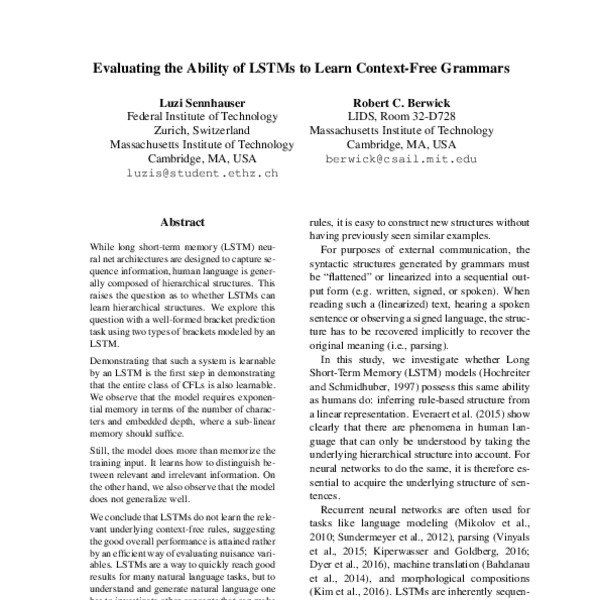

звучит как что-то про CFG + LSTM.

https://www.aclweb.org/anthology/W18-5414/

https://www.aclweb.org/anthology/W18-5414/

MT

звучит как что-то про CFG + LSTM.

https://www.aclweb.org/anthology/W18-5414/

https://www.aclweb.org/anthology/W18-5414/

Не читал, спасибо, ознакомлюсь

I

Не читал, спасибо, ознакомлюсь

не. не то, чтобы я рекомендую. это я угадать пытаюсь. первый шаг изучения чужой работы — угадать методы и пайпланы) а потом по возможности проверить догадки.

MT

не. не то, чтобы я рекомендую. это я угадать пытаюсь. первый шаг изучения чужой работы — угадать методы и пайпланы) а потом по возможности проверить догадки.

Если пробежаться по диагонали по работе автора концепции последней (из их списка публикаций), то такое себе впечатление остается, на самом деле. Мб за 2 года у них что-то изменилось, расскажите, если послушаете их доклад xD

MT

не. не то, чтобы я рекомендую. это я угадать пытаюсь. первый шаг изучения чужой работы — угадать методы и пайпланы) а потом по возможности проверить догадки.

А так все выглядит как:

1) Есть красивая концепция, которой автор занимается много лет, ищут вдохновение в биологии и мозге

2) Как то пытаются реализовать ее, используя современные архитектуры сетей

3) Успехов особо не добиваются (это надо проверить конечно), из-за небольшого штата, которого не хватает

В принципе, да, какая бы риторика не была, если концепция интересная, то может быть и полезно ее послушать, ибо копать всем в одном направлении (трансформеры сюда туда так этак) не особо хорошо.

1) Есть красивая концепция, которой автор занимается много лет, ищут вдохновение в биологии и мозге

2) Как то пытаются реализовать ее, используя современные архитектуры сетей

3) Успехов особо не добиваются (это надо проверить конечно), из-за небольшого штата, которого не хватает

В принципе, да, какая бы риторика не была, если концепция интересная, то может быть и полезно ее послушать, ибо копать всем в одном направлении (трансформеры сюда туда так этак) не особо хорошо.

SP

А так все выглядит как:

1) Есть красивая концепция, которой автор занимается много лет, ищут вдохновение в биологии и мозге

2) Как то пытаются реализовать ее, используя современные архитектуры сетей

3) Успехов особо не добиваются (это надо проверить конечно), из-за небольшого штата, которого не хватает

В принципе, да, какая бы риторика не была, если концепция интересная, то может быть и полезно ее послушать, ибо копать всем в одном направлении (трансформеры сюда туда так этак) не особо хорошо.

1) Есть красивая концепция, которой автор занимается много лет, ищут вдохновение в биологии и мозге

2) Как то пытаются реализовать ее, используя современные архитектуры сетей

3) Успехов особо не добиваются (это надо проверить конечно), из-за небольшого штата, которого не хватает

В принципе, да, какая бы риторика не была, если концепция интересная, то может быть и полезно ее послушать, ибо копать всем в одном направлении (трансформеры сюда туда так этак) не особо хорошо.

+

NG

Hello I am biggner in NLP can I ask you question ,but I cant talk russian

VF

Hello I am biggner in NLP can I ask you question ,but I cant talk russian

sure, ask away

NG

sure, ask away

Thank you

GZ

Друзья,

У меня есть много объявлений, в которых указан адрес полностью, в некоторых частично, в некоторых указан район и название ЖК.

Подскажите пожалуйста, каким образом можно эффективней всего определять местоположение?

На данный момент у меня есть список из ЖК, городов и улиц.

Я пытаюсь брать название и искать его в тексте объявления, но точность хромает.

Допустим есть «ЖК Нева Тауэрс», я его ищу в тексте объявления, а там написано «жилищный комплекс Нева на кутузовском» и в таком случае получается что я уже пропускаю это объявление.

Как мне быть? Записывать в синонимы к «ЖК Нева Тауэрс» различные варианты написания?

А как быть, если в тексте объявления будет написано «рядом с жилищным комплексом Нева».

Как мне понять что речь идёт не об этом ЖК?

У меня есть много объявлений, в которых указан адрес полностью, в некоторых частично, в некоторых указан район и название ЖК.

Подскажите пожалуйста, каким образом можно эффективней всего определять местоположение?

На данный момент у меня есть список из ЖК, городов и улиц.

Я пытаюсь брать название и искать его в тексте объявления, но точность хромает.

Допустим есть «ЖК Нева Тауэрс», я его ищу в тексте объявления, а там написано «жилищный комплекс Нева на кутузовском» и в таком случае получается что я уже пропускаю это объявление.

Как мне быть? Записывать в синонимы к «ЖК Нева Тауэрс» различные варианты написания?

А как быть, если в тексте объявления будет написано «рядом с жилищным комплексом Нева».

Как мне понять что речь идёт не об этом ЖК?

NG

I am reading a pepers about Aspect based sentiment analysis and I know that word could be represented by word embedding ,tf-idf ,bag of words but I read in some papers they using morphological, syntactic and semantic features without any mention how they encode it what this means how they take the feature how they encode it to number if anayone know blog ,book or video or anything explain it I will be thankful

I

на ум приходит такой форклоу, который кажется типичный:

1) выделяешь сущности в тексте

2) нормализуешь

3) ищешь по нормализованным

1) выделяешь сущности в тексте

2) нормализуешь

3) ищешь по нормализованным