p

Size: a a a

2021 April 27

привет

➔m

Привет 🌸

М

1. добавить дополнительные входы в модель

2. конкатенировать к вектору эмбедингов.

2. конкатенировать к вектору эмбедингов.

➔m

А что значит добавить дополнительные входы в модель? Простите за глупый вопрос. Я почти не занимаюсь ML

AE

значит увеличить размерность входного вектора в модель

AE

Не уверен что стало понятнее ...

➔m

А чем это отличается от сконкатенировать тогда? :/

М

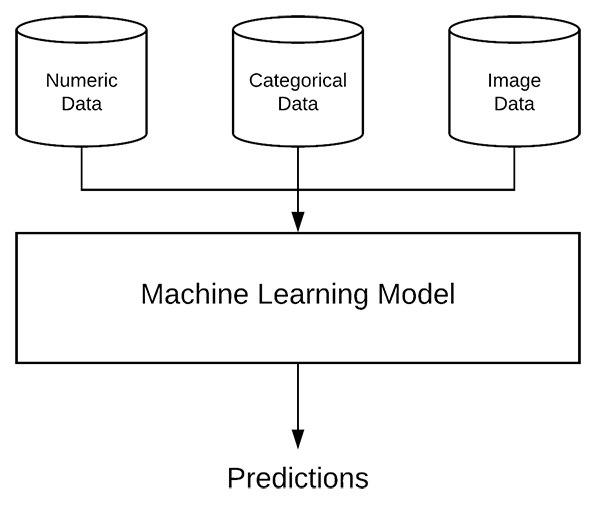

Как пример:

https://www.pyimagesearch.com/2019/02/04/keras-multiple-inputs-and-mixed-data/

Текст не читал, но картинки правильные. 😁

https://www.pyimagesearch.com/2019/02/04/keras-multiple-inputs-and-mixed-data/

Текст не читал, но картинки правильные. 😁

➔m

Спасибо, да, я как-то так и представляла, а какой тогда другой способ вообще? Или вы под цифрами 1 и 2 выше имели в виду шаги, а не разные подходы?

М

Ну по сути это вариации одного и того же.

если вы делаете отдельный вход в модель, то потом все равно решаете что как объединить эмбеддинги внутри модели(конкатенировать, усреднить)

Но технически можно легко получить эмбединги например с помощью https://github.com/UKPLab/sentence-transformers

И потом просто добавить ваши признаки к этому вектору, отправить полученный вектор в новую модель, например логистическую регрессию и получить нужный вам вариант выхода.

если вы делаете отдельный вход в модель, то потом все равно решаете что как объединить эмбеддинги внутри модели(конкатенировать, усреднить)

Но технически можно легко получить эмбединги например с помощью https://github.com/UKPLab/sentence-transformers

И потом просто добавить ваши признаки к этому вектору, отправить полученный вектор в новую модель, например логистическую регрессию и получить нужный вам вариант выхода.

➔m

Спасибо большое за помощь и объяснение

T

Задача называется relation extraction

М

Точно, спасибо!

МП

Добрый день!

Подскажите решения/статьи по исправлению ошибок распознавания речи и восстановление пунктуации.

Слышал люди Берты обучают для этого, но чего-то подробного не нашел

Заранее спасибо!

Подскажите решения/статьи по исправлению ошибок распознавания речи и восстановление пунктуации.

Слышал люди Берты обучают для этого, но чего-то подробного не нашел

Заранее спасибо!

МП

Попробовал, так себе))

2021 April 28

AK

На прошлой неделе прошла конференция Balto-Slavic NLP, на которой, в частности, презентовали несколько интересных работ по русскому языку.

Russian Paraphrasers: Paraphrase with Transformers. Авторы собрали датасет русских парафраз из субтитров, новостных заголовков и диалогов с чатботами (как набирали последние, непонятно). На таких парах дообучили GPT от Сбера и mT5 (T5 работает заметно лучше, чем GPT). При генерации разные варианты парафраз переранжируются по косинусной близости их эмбеддингов предложений. В результате получается около 60-70% хороших парафраз по оценкам авторов, и около 50% - по моим собственным. Пробовали применить парафразеры для аугментации обучающих выборок задач Russian superGLUE, но прироста качества почти не получилось. Нейросетки выложены на huggingface, а готовый пакет для перефразирования - на гитхаб. Моё мнение: результат неидеального качества, но это шаг в очень важном направлении, ибо хорошие парафразеры важны для кучи других задач NLU и NLG.

Creating an Aligned Russian Text Simplification Dataset from Language Learner Data. Авторы взяли книги для иностранцев на упрощённом русском языке и произвели выравнивание их абзацев с оригиналами книг на обычном русском. Получили параллельный корпус, где в более простой версии втрое меньше уникальных слов и вдвое короче предложения. Обучили на этом нейросетку для упрощения текстов, и вроде бы качество хорошее, но ни модель, ни корпус авторы пока не выложили, так что проверить сложно. Но если вам нужна симплификация для русского уже сейчас, берите дорожку с Диалога и модель Дани Анастасьева, занявшую первое место в этой дорожке.

Abusive Language Recognition in Russian. Авторы собрали датасет на 15К абзацев из Твиттера, субтитров к South park, и уже имеющегося датасета с Кэггла, и разметили его на предмет оскорбительности. На этом попробовали обучать разные модели, и tf-idf+SVM показал себя лучше, чем BERT. Видимо, токсичность на этом датасете сводится в основном к использованию плохих слов. Данные выложены, можно пользоваться. Впрочем, непонятно, насколько это лучше, чем данные из соревнования Одноклассников.

Detecting Inappropriate Messages on Sensitive Topics that Could Harm a Company’s Reputation - работа моих коллег по Сколтеху, в каком-то смысле дополняющая предыдущую. Задача - обезопасить диалоги с чатботом, научиться выделять в сообщениях потенциально опасные темы (от наркотиков и терроризма до боди шейминга и суицида), а также конкретные опасные предложения на эти темы. И в общем-то, это две разные задачи, поскольку не любое сообщение на опасную тему само по себе является опасным. Авторы собрали датасеты из двача и ответов mail.ru, пофильтровали эвристиками и разметили на Толоке. На этом обучили два BERTа, ими вполне можно пользоваться для фильтрации сообщений (скомбинировав их со стандартным фильтром на токсичную лексику).

Там же представили статью RuSentEval: Linguistic Source, Encoder Force! о пробинге русских бертов, про которую я уже писал недавно.

Russian Paraphrasers: Paraphrase with Transformers. Авторы собрали датасет русских парафраз из субтитров, новостных заголовков и диалогов с чатботами (как набирали последние, непонятно). На таких парах дообучили GPT от Сбера и mT5 (T5 работает заметно лучше, чем GPT). При генерации разные варианты парафраз переранжируются по косинусной близости их эмбеддингов предложений. В результате получается около 60-70% хороших парафраз по оценкам авторов, и около 50% - по моим собственным. Пробовали применить парафразеры для аугментации обучающих выборок задач Russian superGLUE, но прироста качества почти не получилось. Нейросетки выложены на huggingface, а готовый пакет для перефразирования - на гитхаб. Моё мнение: результат неидеального качества, но это шаг в очень важном направлении, ибо хорошие парафразеры важны для кучи других задач NLU и NLG.

Creating an Aligned Russian Text Simplification Dataset from Language Learner Data. Авторы взяли книги для иностранцев на упрощённом русском языке и произвели выравнивание их абзацев с оригиналами книг на обычном русском. Получили параллельный корпус, где в более простой версии втрое меньше уникальных слов и вдвое короче предложения. Обучили на этом нейросетку для упрощения текстов, и вроде бы качество хорошее, но ни модель, ни корпус авторы пока не выложили, так что проверить сложно. Но если вам нужна симплификация для русского уже сейчас, берите дорожку с Диалога и модель Дани Анастасьева, занявшую первое место в этой дорожке.

Abusive Language Recognition in Russian. Авторы собрали датасет на 15К абзацев из Твиттера, субтитров к South park, и уже имеющегося датасета с Кэггла, и разметили его на предмет оскорбительности. На этом попробовали обучать разные модели, и tf-idf+SVM показал себя лучше, чем BERT. Видимо, токсичность на этом датасете сводится в основном к использованию плохих слов. Данные выложены, можно пользоваться. Впрочем, непонятно, насколько это лучше, чем данные из соревнования Одноклассников.

Detecting Inappropriate Messages on Sensitive Topics that Could Harm a Company’s Reputation - работа моих коллег по Сколтеху, в каком-то смысле дополняющая предыдущую. Задача - обезопасить диалоги с чатботом, научиться выделять в сообщениях потенциально опасные темы (от наркотиков и терроризма до боди шейминга и суицида), а также конкретные опасные предложения на эти темы. И в общем-то, это две разные задачи, поскольку не любое сообщение на опасную тему само по себе является опасным. Авторы собрали датасеты из двача и ответов mail.ru, пофильтровали эвристиками и разметили на Толоке. На этом обучили два BERTа, ими вполне можно пользоваться для фильтрации сообщений (скомбинировав их со стандартным фильтром на токсичную лексику).

Там же представили статью RuSentEval: Linguistic Source, Encoder Force! о пробинге русских бертов, про которую я уже писал недавно.

DK

SМ

Аспа будет?)