VM

Size: a a a

2021 April 26

есть канал ##nlp на Freenode

N

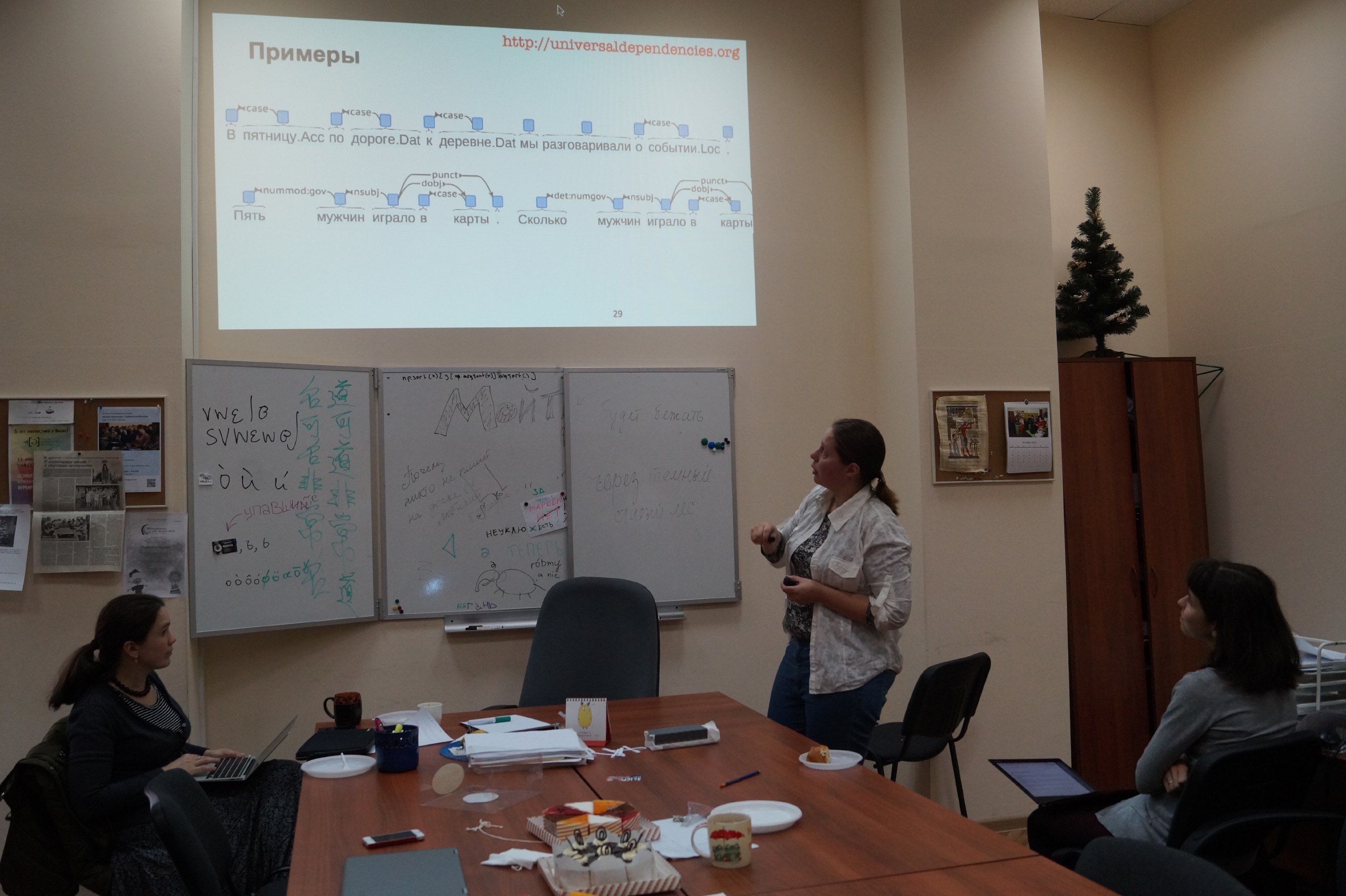

вообще про UD сам Нивре делал доклад аж в Яндексе:

https://events.yandex.ru/events/science-seminars/20-apr-2016?openTalkVideo=919-1

https://events.yandex.ru/events/science-seminars/20-apr-2016?openTalkVideo=919-1

N

это раз

N

Ляшевская тоже рассказывала, это два: https://ling.hse.ru/news/197443947.html

N

ну и три — слайдики отсюда:

http://universaldependencies.org/eacl17tutorial/

http://universaldependencies.org/eacl17tutorial/

YS

Ещё вопрос, как добавить свои паттерны в NewsEmbedding() для natasha

2021 April 27

ПЧ

Здравствуйте. Распознаю текст с документов для дальнейшего анализа, юзаю Тику. После распознавание есть много ошибок - где то буквы в слове не хватает, где то одно слово разбито на два (шам пунь), где то вообще хрень какая то. Есть какие то библиотеки в питоне, которые могут помочь исправить хотя бы часть этих ошибок? Поправить орфографию, там, где есть опечатки и объединить два слова в одно. Стоит ли этим вообще заниматься? Увеличит ли это точность конечной модели (в моём случаи это классификация текстов)

AE

Посмотрите вначале на частоту ошибочных слов, может быть у вас они не единичны, а есть какое-то "спец" слово и для таких придётся добавлять костыли. В целом же, координально ситуация в контексте классификации у вас не поменяется, однако зависит от длины ваших текстов (может быть вы по 1- 2 предложениям строите классификатор).

A

Подскажите, пожалуйста, есть ли fact checker для русского языка?

ПЧ

Так а как я могу оценить частоты ошибочных слов?

AE

Ошибочные слова, как правило будут как раз таки в хвосте вашего списка встречаемости, тут только нужно смотреть прямо на ваш график

ПЧ

Всё равно не понял, чем мне это поможет.

AE

тем что может получится так, что какое-то слово, хоть это и вы могли считать ошибкой, однако оно часто встречается. Волшебной библиотеки я не знаю, все равно придется глазами смотреть на графикии

ПЧ

Ну тогда просто можно исправлять только те слова, которые встречаются 1-3 раза максимума

IS

SPARQL к WikiData 😁

A

Кхм, почему бы и нет)

B

🔫 @evilcoder73 кикнут — вернуть этого пользователя можно только разбаном в настройках чата.

Проголосовавшие за кик:

@wadimiusz, @yolkanazarova, @drum_forrest_drum, @Orzhan, @tzekunosyosha, @FutorioFranklin

При поддержке Золота Бородача

Проголосовавшие за кик:

@wadimiusz, @yolkanazarova, @drum_forrest_drum, @Orzhan, @tzekunosyosha, @FutorioFranklin

При поддержке Золота Бородача

М

Привет всем!

Подскажите правильно ли ставлю задачу.

В резюме кандидата есть текстовый блок с опытом работы в разных компаниях.

Я с помощью NER нахожу "должность", "опыт работы" и "используемые технологии".

Можно ли ставить задачу матчинга сущности "должность" с сущностями "опыт работы" и "технологии" в рамках одного места работы как задачу разрешения кореференции?

Подскажите правильно ли ставлю задачу.

В резюме кандидата есть текстовый блок с опытом работы в разных компаниях.

Я с помощью NER нахожу "должность", "опыт работы" и "используемые технологии".

Можно ли ставить задачу матчинга сущности "должность" с сущностями "опыт работы" и "технологии" в рамках одного места работы как задачу разрешения кореференции?

➔m

Всем привет! Подскажите, как правильно подходить к задаче классификации текстов, если кроме самих текстов хочется использовать дополнительные фичи? Т.е., если у меня есть дополнительные категориальные и числовые признаки для каждого текста.

Имею в виду, архитектурно. Обучить отдельно текстовые эмбеддинги, условно, бертом, отдельно сделать эмбеддинги фич, дальше — эээ склеить эти вектора и засунуть в какую-то еще модель?

Спасибо большое.

Имею в виду, архитектурно. Обучить отдельно текстовые эмбеддинги, условно, бертом, отдельно сделать эмбеддинги фич, дальше — эээ склеить эти вектора и засунуть в какую-то еще модель?

Спасибо большое.