d

Size: a a a

2021 February 27

Я предположил, что человек не очень хочет разбираться и нереальность разобраться по предложенному коду )

E

да, Simpletransformers классные

ИТ

По [CLS] классифицировать не надо, он говно

Если не дообучать, то да. Если дообучить, то он зависит от всех других представлений на предыдущих слоях и "ддобучая" совместную модель "bert" + "klass_me" - то, что он "гавно" теряет смысл

d

Если не дообучать, то да. Если дообучить, то он зависит от всех других представлений на предыдущих слоях и "ддобучая" совместную модель "bert" + "klass_me" - то, что он "гавно" теряет смысл

Выжать из hidden всегда можно больше аналогичным файнтюнингом

Ни на одной соревке [CLS] не используют и я слышал аналогичное про прод

Ни на одной соревке [CLS] не используют и я слышал аналогичное про прод

d

[CLS] всегда будет хуже при нуле бонусов

SМ

Выжать из hidden всегда можно больше аналогичным файнтюнингом

Ни на одной соревке [CLS] не используют и я слышал аналогичное про прод

Ни на одной соревке [CLS] не используют и я слышал аналогичное про прод

Cls токен слабоконтекстный

SМ

Как это понять, достаточно посмотреть как туда складываются эмбеддинги из токенов фразы. Получается зачастую пуллинг стейтов лучше тк более сильный контекст

Sи

коллеги, встречались ли вам проекты, в которых нейронно генерируют текст математических формул или даже теорем?

Переносят стиль с соответствующей терминологией из одной области математики в другую, и генерят на базе 2-х стилей новые тексты?

Переносят стиль с соответствующей терминологией из одной области математики в другую, и генерят на базе 2-х стилей новые тексты?

AO

коллеги, встречались ли вам проекты, в которых нейронно генерируют текст математических формул или даже теорем?

Переносят стиль с соответствующей терминологией из одной области математики в другую, и генерят на базе 2-х стилей новые тексты?

Переносят стиль с соответствующей терминологией из одной области математики в другую, и генерят на базе 2-х стилей новые тексты?

http://www.ramanujanmachine.com/

Машина Рамануджана. Генерирует формулы-гипотезы, проверенные на миллионах случаях, которые потом можно доказывать. Пока вроде генерирует только арифметические формулы со знаменитыми константами.

Машина Рамануджана. Генерирует формулы-гипотезы, проверенные на миллионах случаях, которые потом можно доказывать. Пока вроде генерирует только арифметические формулы со знаменитыми константами.

A

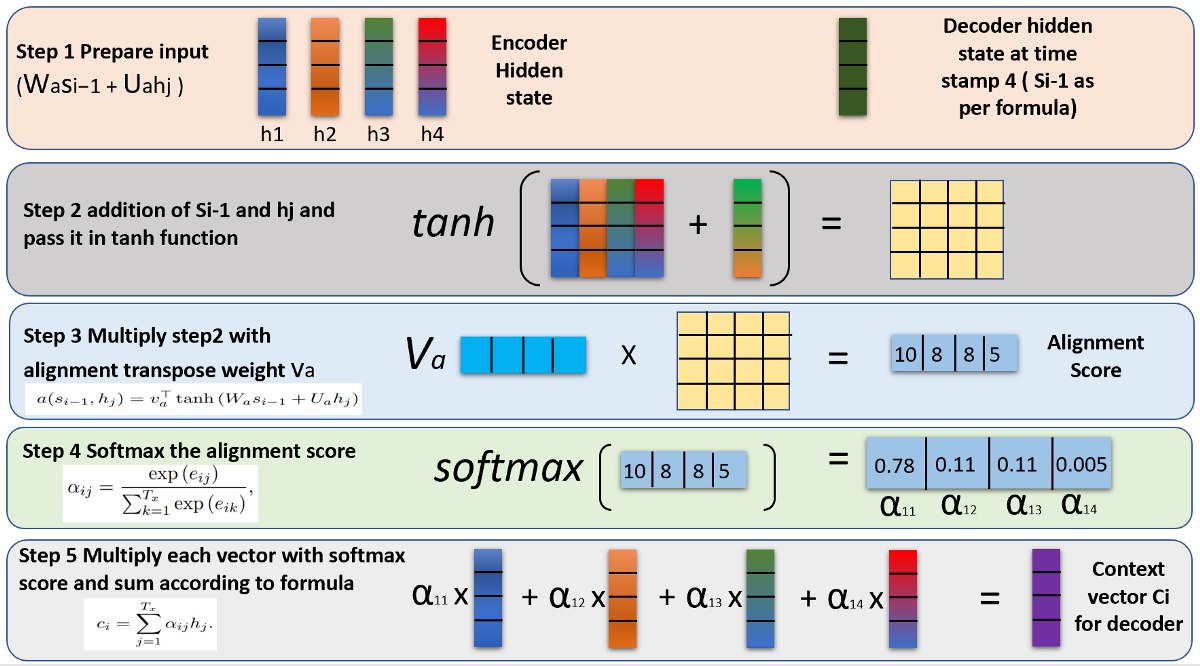

Не могу понять как применили модель mT5 ( GPT и другие генеративные модели) для решения данной задачи https://russiansuperglue.com/tasks/task_info/RUSSE

Может быть у кого есть опыт? Как необходимо сконвертировать инпут в такие типа модели для классификации?

Может быть у кого есть опыт? Как необходимо сконвертировать инпут в такие типа модели для классификации?

IS

Не могу понять как применили модель mT5 ( GPT и другие генеративные модели) для решения данной задачи https://russiansuperglue.com/tasks/task_info/RUSSE

Может быть у кого есть опыт? Как необходимо сконвертировать инпут в такие типа модели для классификации?

Может быть у кого есть опыт? Как необходимо сконвертировать инпут в такие типа модели для классификации?

Ну, теоретически как-то так должно быть в Т5:

input:

output:

input:

WiC sentence1: Бурые ковровые дорожки заглушали шаги. sentence2: Приятели решили выпить на дорожку в местном баре. word: дорожка

output:

false

IS

Ну, и закрывающий токен: </s>

A

WiC - это suffix задачи на которую его обучали? (аналог summarize: + <text>)

IS

WiC - это suffix задачи на которую его обучали? (аналог summarize: + <text>)

Да. если вы обучаете одну модель для нескольких задач, то надо использовать приставку. Если только под одну эту задачу - можно и не указывать.

A

Да, понял. Где-то уже читал про это.

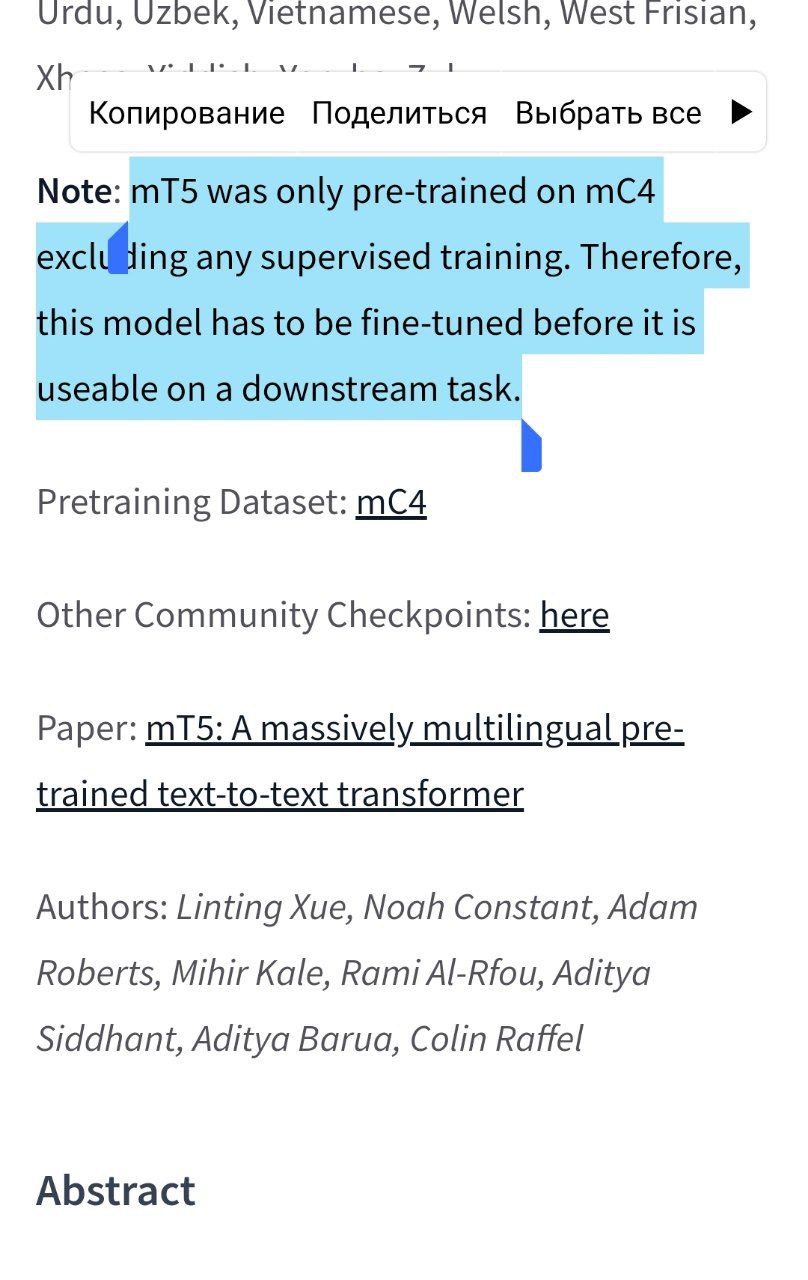

Судя по информации, модели mT5 не были обучены на эти дополнительные задачки (в отличие от Т5)

Судя по информации, модели mT5 не были обучены на эти дополнительные задачки (в отличие от Т5)

A

Нашёл ответ в оригинальной статье.

A

@blanchefort спасибо за ответ про WIC. Я гуглил про WSD

МП

Коллеги, кто-то видел датасет новостей поновее, чем Лента и Риа?