KL

Size: a a a

2021 February 25

KL

В догонку - может кто-то знает тлг чаты исключительно про диалоги и ассистенты?)

AZ

В догонку - может кто-то знает тлг чаты исключительно про диалоги и ассистенты?)

+ подписываюсь, тож интересно

RS

В Pullenti есть ряд функций для решения этой задачи. Например, для "23 яблока" можно Pullenti.Ner.Core.NumberHelper.GetNumberString(23, "яблоко") = "двадцать три яблока". А функцией GetNumberAdjective можно преобразовать число в числительное в нужном роде и числе.

Спасибо! Удалось с помощью Pullenti.GetNumberAdjective и парочки условий достичь нужного результата.

Но в итоге выбрал num2words, так как работает быстрее и поддерживает большие числа (Pullenti ругался на 2021)

Но в итоге выбрал num2words, так как работает быстрее и поддерживает большие числа (Pullenti ругался на 2021)

DD

В догонку - может кто-то знает тлг чаты исключительно про диалоги и ассистенты?)

У меня есть @botcamp_community, но он, если честно, не очень живой

D•

А есть несколько таких, но они не очень живые все почему-то

2021 February 26

AK

Переслано от Darya Moroz

Всем привет!

В честь дня рождения DeepPavlov команда проекта проводит встречу пользователей и разработчиков 🎅. В этом году, к сожалению, она пройдет в онлайн формате 5 марта 2021 года.

На встрече расскажут про участие в Alexa Prize, применении DeepPavlov для бизнес и государственных задач, последние новости из мира NLP, и о том, каким будет DeepPavlov 1.0.

Чтобы попасть на мероприятие 🕺, необходимо зарегистрироваться на сайте:

https://deeppavlov.ai/events/3year

В честь дня рождения DeepPavlov команда проекта проводит встречу пользователей и разработчиков 🎅. В этом году, к сожалению, она пройдет в онлайн формате 5 марта 2021 года.

На встрече расскажут про участие в Alexa Prize, применении DeepPavlov для бизнес и государственных задач, последние новости из мира NLP, и о том, каким будет DeepPavlov 1.0.

Чтобы попасть на мероприятие 🕺, необходимо зарегистрироваться на сайте:

https://deeppavlov.ai/events/3year

YY

здраствуйте в нейронном сете если входные данные текст то надо их преобразовать на цифр ?

AK

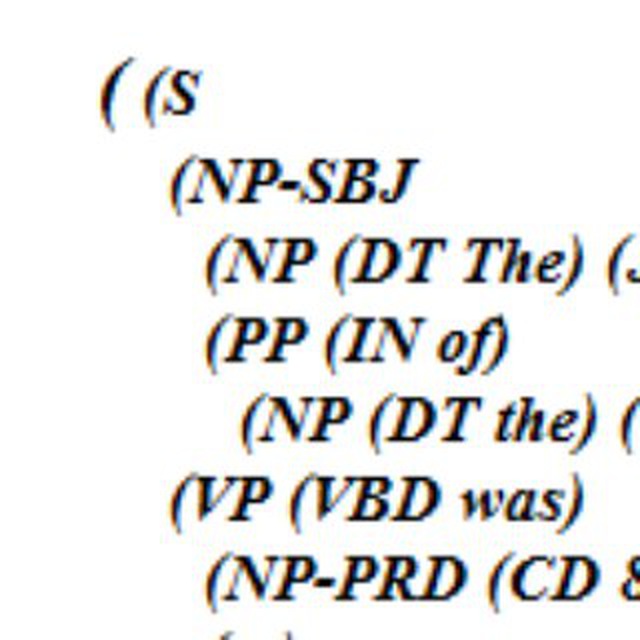

Подскажите, пожалуйста. А почему в NER'ах (не только в Natasha) нет или некорректно работает интеграции с pymorphy/OpenCorpora/словарем?

Дмитрий! содержит PER, но не дмитрий!. ЧЯДНТ?ni

Подскажите, пожалуйста. А почему в NER'ах (не только в Natasha) нет или некорректно работает интеграции с pymorphy/OpenCorpora/словарем?

Дмитрий! содержит PER, но не дмитрий!. ЧЯДНТ?просто тут заглавная буква выступила очень важной фичей, и сетка на ней обучилась. Мы всегда пишем сущности с большой буквы, по крайней мере стараемся.

SS

Вопрос: допустим, делаю свой NER, эмбединги бертовые, для которых не нужна нормализация предложений по большому счету. Вопрос в оптимизации разметки под NER - если я в разметку делаю на нормализованных предложениях (допустим после токенизации все привожу в начальную форму), то могу ли я ожидать: 1. под каждую сущность нужно меньше вариантов, так как нет разных словоформ. 2. на обучении модели, я буду эмбедить бертом уже нормализованные предложения и это не скажется на качестве эмбедингов. 3. качество извлечения будет высокое - если я на инференс буду также подавать нормализованные предложения. ? Или в данном случае это неважно, и модель не будет особо зависить от словоформ?

E

Вопрос: допустим, делаю свой NER, эмбединги бертовые, для которых не нужна нормализация предложений по большому счету. Вопрос в оптимизации разметки под NER - если я в разметку делаю на нормализованных предложениях (допустим после токенизации все привожу в начальную форму), то могу ли я ожидать: 1. под каждую сущность нужно меньше вариантов, так как нет разных словоформ. 2. на обучении модели, я буду эмбедить бертом уже нормализованные предложения и это не скажется на качестве эмбедингов. 3. качество извлечения будет высокое - если я на инференс буду также подавать нормализованные предложения. ? Или в данном случае это неважно, и модель не будет особо зависить от словоформ?

BERT работает лучше с полным, необработанным тестом, потому что часто капитализация важна для смысла

E

но это если он заранее обучен на таком тексте

E

и лемматизация для BERT тоже не нужна, она только искажает все

ДК

Привет всем!

Есть кто-нибудь, кто делал для текстов "мягкую" классификацию? Это делается на BERT?

Спасибо!

Есть кто-нибудь, кто делал для текстов "мягкую" классификацию? Это делается на BERT?

Спасибо!

AK

Привет всем!

Есть кто-нибудь, кто делал для текстов "мягкую" классификацию? Это делается на BERT?

Спасибо!

Есть кто-нибудь, кто делал для текстов "мягкую" классификацию? Это делается на BERT?

Спасибо!

Берт вам даёт признаки, а метод классификации можно выбрать любой

ИТ

Привет всем!

Есть кто-нибудь, кто делал для текстов "мягкую" классификацию? Это делается на BERT?

Спасибо!

Есть кто-нибудь, кто делал для текстов "мягкую" классификацию? Это делается на BERT?

Спасибо!

а что вы вкладываете в "мягкую" ?

ДК

а что вы вкладываете в "мягкую" ?

к одному тексту - несколько лейблов

ДК

аля теги

ДК

Для обучения получается надо таргеты представлять в таком формате:

[0.5, 0.5, 0, 0, 0]

?

[0.5, 0.5, 0, 0, 0]

?