M

Size: a a a

2020 June 18

Oh, yes, you're right here. Initial question was about Kencdec and Vencdec and i thought you're talking about decoder already.

Can you please tell how are those Kencdec and Vencdec calculated?

M

Bcoz it appeared only after the last encoder

M

No where in between

ID

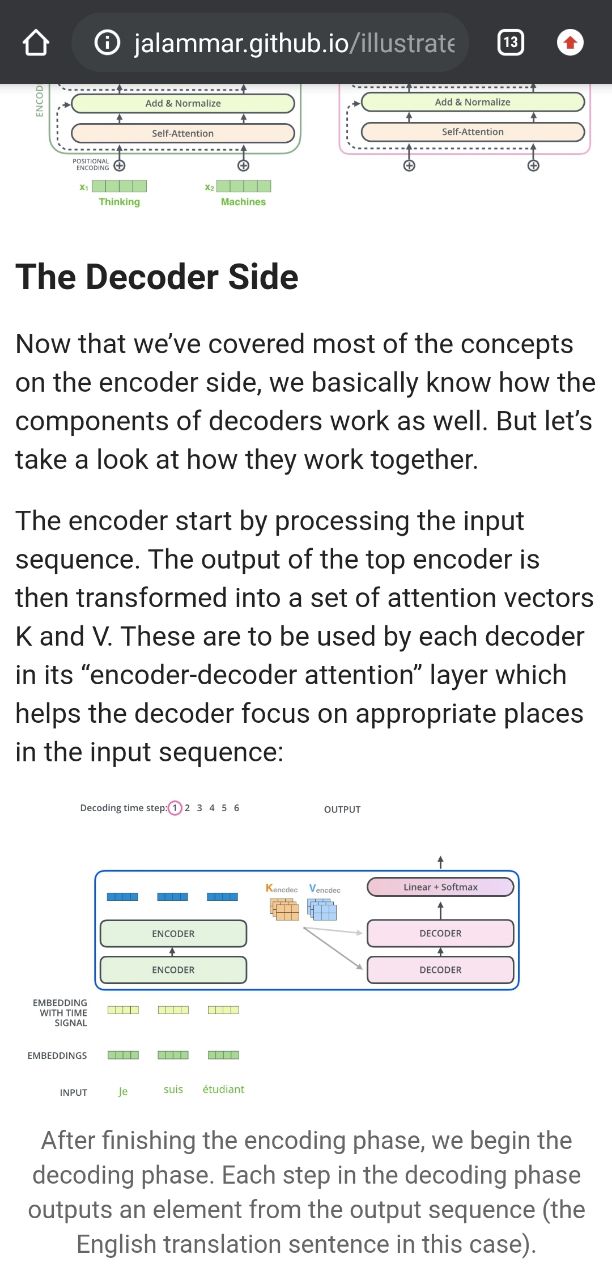

So, you have output from last layer of encoder, lets name it R_out. In decoder you have two types of attentions, as i said before. Kencdec and Vencdec are used only in Encoder Decoder attention. In this layer you calculate K,Q,V as K = R_out * W_k (this is Kencdec), V = R_out*W_v(this is Vencdec) and Q = X * W_q (X - embedding of target sequence).

M

So, you have output from last layer of encoder, lets name it R_out. In decoder you have two types of attentions, as i said before. Kencdec and Vencdec are used only in Encoder Decoder attention. In this layer you calculate K,Q,V as K = R_out * W_k (this is Kencdec), V = R_out*W_v(this is Vencdec) and Q = X * W_q (X - embedding of target sequence).

Ohk. Thanks... I thought these K and V are something different

M

I was confused between K and Kencdec... I thought both of these are different.

M

But these are same

M

Kencdec= K from last encoder

ID

Why? Kencdec is calculated in Decoder part, there are his own weights in W_k matrix, which transform output from encoder.

M

Then let me properly research...becoz in the blog it's written that the outputs of top encoder are transformed into K and V

M

Link to blog:

http://jalammar.github.io/illustrated-transformer/

http://jalammar.github.io/illustrated-transformer/

KD

Ребята, привет.

Подскажите, плз, какими способами из .ann+.txt файла можно получить conll с IOB разметкой?

Гуглил, что-то не нашел толком решения.

Заранее благодарю!

Подскажите, плз, какими способами из .ann+.txt файла можно получить conll с IOB разметкой?

Гуглил, что-то не нашел толком решения.

Заранее благодарю!

R

in fact most of the topic models assign all the topics to a document (with different weights, of course)

Thank you.. Your inputs steered me in the correct direction.

EM

Kabyken Daulet

Ребята, привет.

Подскажите, плз, какими способами из .ann+.txt файла можно получить conll с IOB разметкой?

Гуглил, что-то не нашел толком решения.

Заранее благодарю!

Подскажите, плз, какими способами из .ann+.txt файла можно получить conll с IOB разметкой?

Гуглил, что-то не нашел толком решения.

Заранее благодарю!

я не помню из какого формата - кажется из WebAnno TSV - форматировал сам с помощью питона и NLTK - там есть кое-какой тулинг для Conll IOB

EM

существующих инструментов на тот момент для конвертации не нашел рабочих (года 3 назад)

EM

https://corpus-tools.org/pepper/ вот эта штука выглядела многообещающе, но не получилось завести, может сейчас лучше стало

KD

я не помню из какого формата - кажется из WebAnno TSV - форматировал сам с помощью питона и NLTK - там есть кое-какой тулинг для Conll IOB

спасибо, попробую!

РН

коллеги, из библиотеки tensorflow-text кто-нибудь тестировал токенизаторы и прочий функционал? есть что-то важное для обработки русскоязычных текстов?

2020 June 21

Ю

коллеги, из библиотеки tensorflow-text кто-нибудь тестировал токенизаторы и прочий функционал? есть что-то важное для обработки русскоязычных текстов?

лучше керас. мне кажется проще использовать его