V

Size: a a a

2020 February 27

За то время, что вы пытаетесь получить тут помощь, можно было даже методом тыка это изучить, если настолько сильно надо. Заодно и опыта побольше станет, и более конкретные вопросы появятся, на которые может кто-то и сможет тут ответить, т.к. судя по всему никто всерьёз gpt-2 тут не ковырял

V

Банально запустить у себя на CPU и дебагом пройтись, посмотреть что куда передаётся, откуда принимается и т.д.

D

никто так не делает (это про transformers), вашими бы методами смертность у электриков подскочила бы

V

D

Банально запустить у себя на CPU и дебагом пройтись, посмотреть что куда передаётся, откуда принимается и т.д.

пожалуйста откройте рядом пример и ту дичь и скажите мне видите ли вы разницу

VB

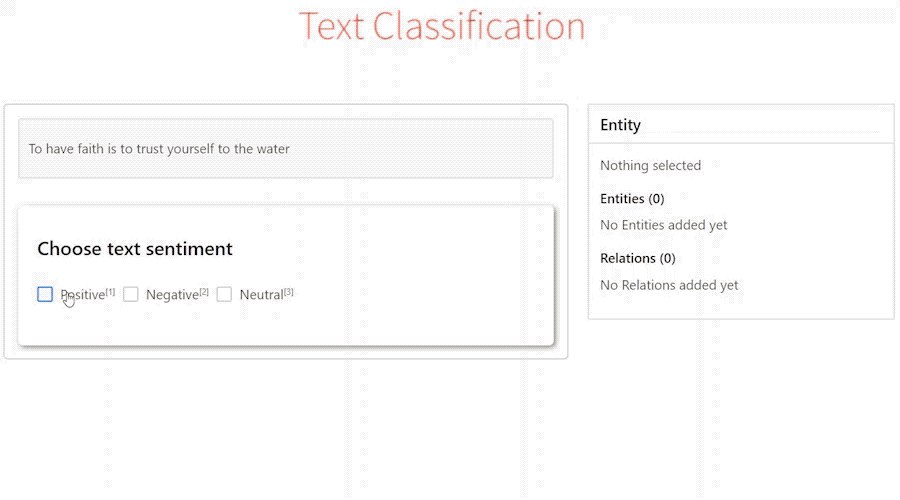

Ребят, есть какие нибудь группы, чаты, форумы по использованию cvat?

И какие ещё есть opensourse продукты по разметке данных, подскажите? Как для computer vision, так и для nlp

И какие ещё есть opensourse продукты по разметке данных, подскажите? Как для computer vision, так и для nlp

OS

ой а что такое кват?

VB

Computer vision annotation tool

MF

Ребят, есть какие нибудь группы, чаты, форумы по использованию cvat?

И какие ещё есть opensourse продукты по разметке данных, подскажите? Как для computer vision, так и для nlp

И какие ещё есть opensourse продукты по разметке данных, подскажите? Как для computer vision, так и для nlp

По нлп есть

https://github.com/doccano/doccano

https://github.com/doccano/doccano

MF

Еще brat есть но он старый и вряд ли лучше

NK

По нлп есть

https://github.com/doccano/doccano

https://github.com/doccano/doccano

Нашей команде жутко не понравился. Правда, у нас была специфическая задача - размечали сущности из сравнительно длинных текстов, из нескольких абзацев. Так вот абзацы при разметке не показываются, что совсем неудобно.

К тому же теряются ID при загрузке/выгрузке, не полностью видна статистика между прользователями... Такое впечатление, что сильно сырое решение.

Для следующего этапа смотрим на brat или на https://towardsdatascience.com/introducing-label-studio-a-swiss-army-knife-of-data-labeling-140c1be92881 но еще не пробовали.

К тому же теряются ID при загрузке/выгрузке, не полностью видна статистика между прользователями... Такое впечатление, что сильно сырое решение.

Для следующего этапа смотрим на brat или на https://towardsdatascience.com/introducing-label-studio-a-swiss-army-knife-of-data-labeling-140c1be92881 но еще не пробовали.

YB

Нашей команде жутко не понравился. Правда, у нас была специфическая задача - размечали сущности из сравнительно длинных текстов, из нескольких абзацев. Так вот абзацы при разметке не показываются, что совсем неудобно.

К тому же теряются ID при загрузке/выгрузке, не полностью видна статистика между прользователями... Такое впечатление, что сильно сырое решение.

Для следующего этапа смотрим на brat или на https://towardsdatascience.com/introducing-label-studio-a-swiss-army-knife-of-data-labeling-140c1be92881 но еще не пробовали.

К тому же теряются ID при загрузке/выгрузке, не полностью видна статистика между прользователями... Такое впечатление, что сильно сырое решение.

Для следующего этапа смотрим на brat или на https://towardsdatascience.com/introducing-label-studio-a-swiss-army-knife-of-data-labeling-140c1be92881 но еще не пробовали.

>Так вот абзацы при разметке не показываются, что совсем неудобно.

так можно же починить было?

так можно же починить было?

YB

в Doccano — django, куда легко подсунуть что угодно в модель и во вьюшки, и vue.js для отображения, легко берёшь и настраиваешь под себя.

я так буду делать active learning, через докидывание в модель и чтение из модели.

а в label studio меня как раз и смущает большее количество самописных частей, где, если что, дольше разбираться, как что чинить. куча самописного кода на Flask, но вроде бы приличного...

и фронт на react, ну тоже норм.

типов моделей в LS побольше написано уже, и есть загрузка файлов.

а так в целом — примерно одно и то же.

надо будет попробовать LS что ли тоже для сравнения.

я так буду делать active learning, через докидывание в модель и чтение из модели.

а в label studio меня как раз и смущает большее количество самописных частей, где, если что, дольше разбираться, как что чинить. куча самописного кода на Flask, но вроде бы приличного...

и фронт на react, ну тоже норм.

типов моделей в LS побольше написано уже, и есть загрузка файлов.

а так в целом — примерно одно и то же.

надо будет попробовать LS что ли тоже для сравнения.

2020 February 28

RB

всем привет! может кто-нибудь подскажет в каких случаях работает поиск сущности Transport в pullenti? согласно найденной информации в доках, это "Транспортные средства, имеющие номера, наименования и\или модели." по такой логике, слово ПОЕЗД, САМОЛЕТ тоже относится к нему. но мне не получилось ни разу заставить либу обнаружить подобную сущность в тексте, хотя пробовал с разными формулировками. Моя конечная цель — находить в тексте средства передвижения (подгружаемые из внешнего словаря). с похожей задачей поиска организаций из внешнего реестра pullenti справился

ND

Доброго времени суток всем. Подскажите, может кто сталкивался с задачей keyword extraction, какие методы существуют для решения данной задачи? И есть ли решения это задачи на основе DNN?

ck

Доброго времени суток всем. Подскажите, может кто сталкивался с задачей keyword extraction, какие методы существуют для решения данной задачи? И есть ли решения это задачи на основе DNN?

как раз читаю статью по схожей теме

https://towardsdatascience.com/deep-learning-for-specific-information-extraction-from-unstructured-texts-12c5b9dceada

https://towardsdatascience.com/deep-learning-for-specific-information-extraction-from-unstructured-texts-12c5b9dceada

YB

Доброго времени суток всем. Подскажите, может кто сталкивался с задачей keyword extraction, какие методы существуют для решения данной задачи? И есть ли решения это задачи на основе DNN?

Textrank обычно рекомендуют... Как DL применить тут -- не очень понятно.

YB

как раз читаю статью по схожей теме

https://towardsdatascience.com/deep-learning-for-specific-information-extraction-from-unstructured-texts-12c5b9dceada

https://towardsdatascience.com/deep-learning-for-specific-information-extraction-from-unstructured-texts-12c5b9dceada

У них по сути NER получился методом велосипедостроения...

ck

У них по сути NER получился методом велосипедостроения...

Согласен. Идея интересная - выделять не заданные типы NERов, а нечто на что стоит обратить внимание. Как keywords. Результаты мне кажутся сомнительными, но почитать интересно.

YB

Согласен. Идея интересная - выделять не заданные типы NERов, а нечто на что стоит обратить внимание. Как keywords. Результаты мне кажутся сомнительными, но почитать интересно.

а как ты задизайнишь целевую функцию и лосс при такой задаче?

вот не выделили слово — это потому что оно менее важное или потому что в прошлый раз рядом было другое важное слово и выделили его?

вот не выделили слово — это потому что оно менее важное или потому что в прошлый раз рядом было другое важное слово и выделили его?