ck

Size: a a a

2019 December 13

это что-то сильно классическое, но совершенно вылетело из головы. как-то бы ускорить процесс чтобы не писать свой велосипед.

Y

это что-то сильно классическое, но совершенно вылетело из головы. как-то бы ускорить процесс чтобы не писать свой велосипед.

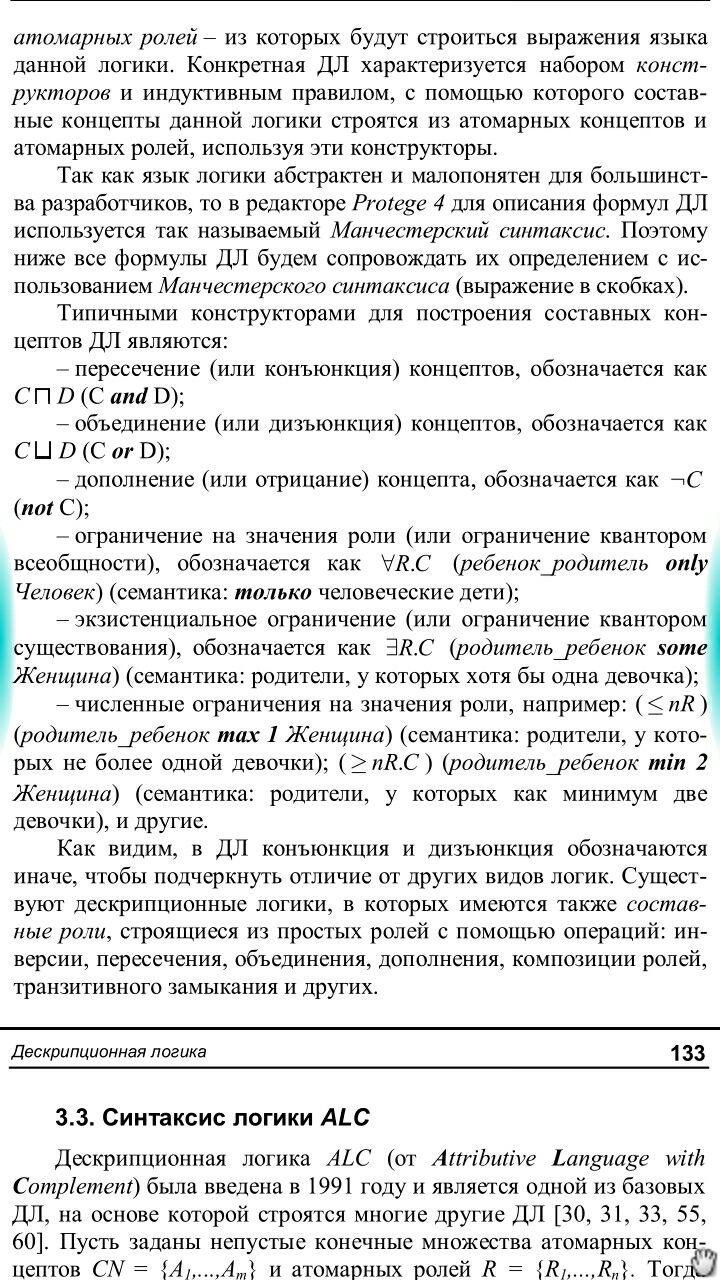

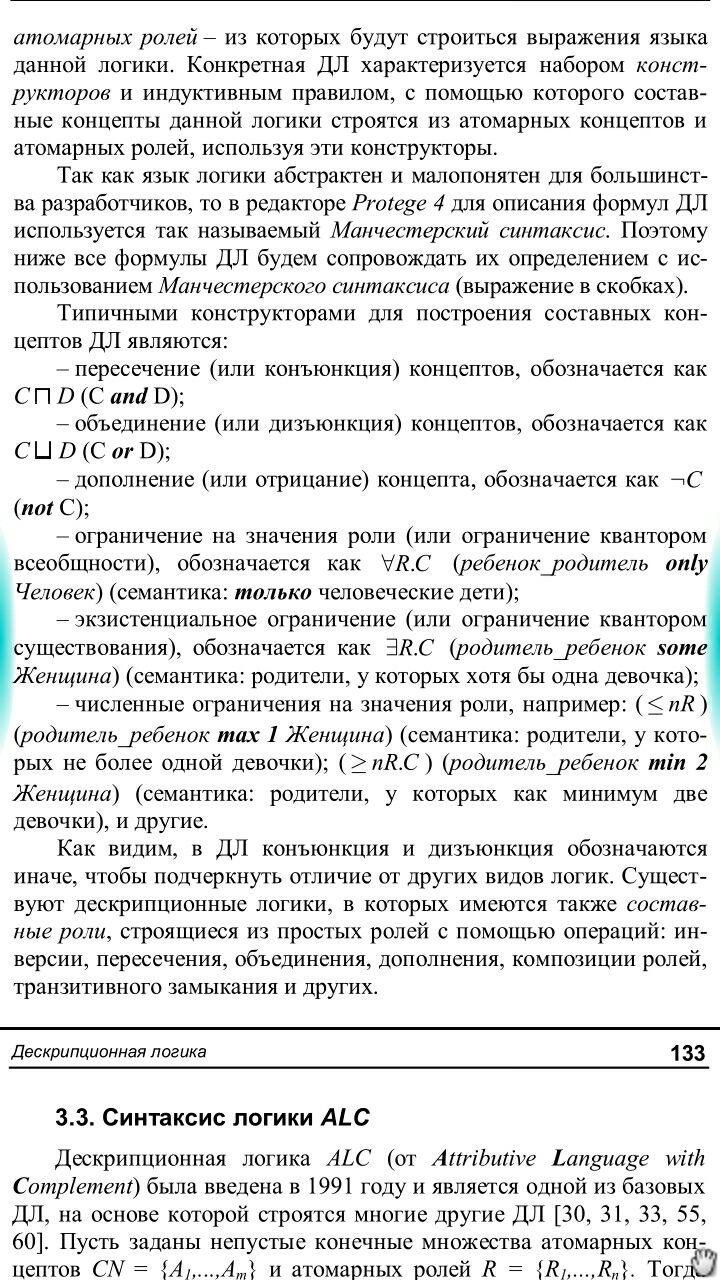

Дескрипционная логика.

YB

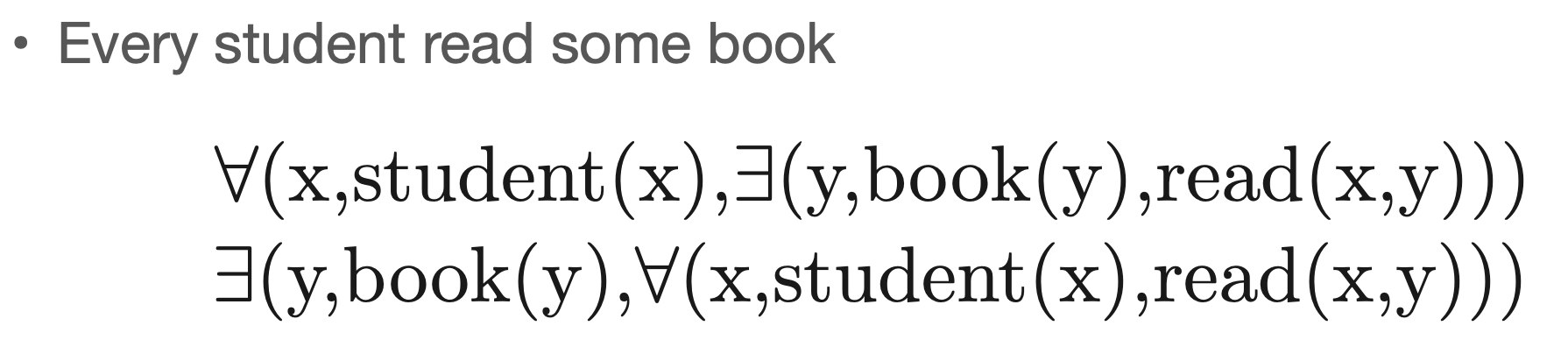

Вот только без добавления времени это всё очень странно выглядит... Наверное, тут read() всё же в прошедшем времени, типа, прочитал. Да и типы бы прописать для каждого функтора.

ck

Вот думаю попробовать в Yargy это описать. Но может быть кто видел готовые сценарии для утверждений типа "все", "ни одного", "один из", "любой", "не менее чем", "как минимум один"

Y

Вот думаю попробовать в Yargy это описать. Но может быть кто видел готовые сценарии для утверждений типа "все", "ни одного", "один из", "любой", "не менее чем", "как минимум один"

ck

Yurii

Оно понятно. Логика первого (вроде первого) порядка, предикаты, кс-грамматиками вполне описывается.

Есть ли готовые сценарии чтобы не писать свои правила?

Я точно это для русского видел, может в какой-то литературе под эгидой какого-нибудь лампового raai.org) но не помню, где.

Есть ли готовые сценарии чтобы не писать свои правила?

Я точно это для русского видел, может в какой-то литературе под эгидой какого-нибудь лампового raai.org) но не помню, где.

ck

Yurii за напоминание про Protege спасибо

Y

Оно понятно. Логика первого (вроде первого) порядка, предикаты, кс-грамматиками вполне описывается.

Есть ли готовые сценарии чтобы не писать свои правила?

Я точно это для русского видел, может в какой-то литературе под эгидой какого-нибудь лампового raai.org) но не помню, где.

Есть ли готовые сценарии чтобы не писать свои правила?

Я точно это для русского видел, может в какой-то литературе под эгидой какого-нибудь лампового raai.org) но не помню, где.

Онтологическая модель представления и организации знаний. Цуканова. Это оттуда.

Y

Эту я не читал, но гляньте мб то.

Y

ck

Спасибо

OS

если я учусь генерировать последовательность по одному вектору, то какой взять лосс?

сгенерированная последовательность может же быть длиннее чем таргет или короче.

паддинг?

сгенерированная последовательность может же быть длиннее чем таргет или короче.

паддинг?

AS

gpt-2 с нуля подлежит обучению?

I

gpt-2 с нуля подлежит обучению?

128 tpu берешь и погнал)

AS

можешь кинуть линк на туториал? везде пишут про дообучение

BZ

если я учусь генерировать последовательность по одному вектору, то какой взять лосс?

сгенерированная последовательность может же быть длиннее чем таргет или короче.

паддинг?

сгенерированная последовательность может же быть длиннее чем таргет или короче.

паддинг?

Как сек2сек

Смотришь максимальную длину второй последовательности и паддишь второй сек до неё (или до вменяемого перцентиля), в crossentropyloss ставишь ignore_index=padding_index

Смотришь максимальную длину второй последовательности и паддишь второй сек до неё (или до вменяемого перцентиля), в crossentropyloss ставишь ignore_index=padding_index

BZ

если я учусь генерировать последовательность по одному вектору, то какой взять лосс?

сгенерированная последовательность может же быть длиннее чем таргет или короче.

паддинг?

сгенерированная последовательность может же быть длиннее чем таргет или короче.

паддинг?

Или ты имеешь в виду на инференсе? Вставь bos и eos токены (begin/end of sentence) и генери пока eos не встретится

У тебя все равно во время обучения хорошо выучится начало и конец последовательности, потому что они встречаются в каждом примере

У тебя все равно во время обучения хорошо выучится начало и конец последовательности, потому что они встречаются в каждом примере

OS

Как сек2сек

Смотришь максимальную длину второй последовательности и паддишь второй сек до неё (или до вменяемого перцентиля), в crossentropyloss ставишь ignore_index=padding_index

Смотришь максимальную длину второй последовательности и паддишь второй сек до неё (или до вменяемого перцентиля), в crossentropyloss ставишь ignore_index=padding_index

Зис

Посеба!

Посеба!

2019 December 14

RD

https://ouo.io/aMtIxI great about machines