t2

Size: a a a

2017 August 22

может даже Толоку попробовать стоит

t2

много текста, кстати?

АМ

Не помню честно говоря

t2

мне препроцессинг срезает 400к токенов

t2

из 600к

АМ

Каких токенов

t2

всех, неуникальных

t2

просто если вынуть все токены из всех обращений и сложить

DV

можно нанять специалистов для разметки

Я как-раз собираюсь делать штуку для полуавтоматической разметки данных. Пока что получается так: в систему загружается plain text, он автоматически разбивается на предложения и токены, потом делается POS-теггинг. Дальше всё это становится доступным по API, к которому можно подключать всякие программные штуки (та же наташа, например) или асессоров - перекрестные результаты (с учетом некоторого кворума, наверное) можно считать правильными и выгружать для обучения. Если я правильно помню, такую же штуку пилят организаторы FactRuEval-2016, только у них как-то глухо там.

Если есть какие-нибудь хотелки (например, возможность помечать документы / предложения, помимо токенов) - смело пишите ;)

Если есть какие-нибудь хотелки (например, возможность помечать документы / предложения, помимо токенов) - смело пишите ;)

NK

Я как-раз собираюсь делать штуку для полуавтоматической разметки данных. Пока что получается так: в систему загружается plain text, он автоматически разбивается на предложения и токены, потом делается POS-теггинг. Дальше всё это становится доступным по API, к которому можно подключать всякие программные штуки (та же наташа, например) или асессоров - перекрестные результаты (с учетом некоторого кворума, наверное) можно считать правильными и выгружать для обучения. Если я правильно помню, такую же штуку пилят организаторы FactRuEval-2016, только у них как-то глухо там.

Если есть какие-нибудь хотелки (например, возможность помечать документы / предложения, помимо токенов) - смело пишите ;)

Если есть какие-нибудь хотелки (например, возможность помечать документы / предложения, помимо токенов) - смело пишите ;)

Создатели spaCy почти сделали похожую штуку.

https://explosion.ai/blog/prodigy-annotation-tool-active-learning

https://explosion.ai/blog/prodigy-annotation-tool-active-learning

2017 August 25

AZ

Я как-раз собираюсь делать штуку для полуавтоматической разметки данных. Пока что получается так: в систему загружается plain text, он автоматически разбивается на предложения и токены, потом делается POS-теггинг. Дальше всё это становится доступным по API, к которому можно подключать всякие программные штуки (та же наташа, например) или асессоров - перекрестные результаты (с учетом некоторого кворума, наверное) можно считать правильными и выгружать для обучения. Если я правильно помню, такую же штуку пилят организаторы FactRuEval-2016, только у них как-то глухо там.

Если есть какие-нибудь хотелки (например, возможность помечать документы / предложения, помимо токенов) - смело пишите ;)

Если есть какие-нибудь хотелки (например, возможность помечать документы / предложения, помимо токенов) - смело пишите ;)

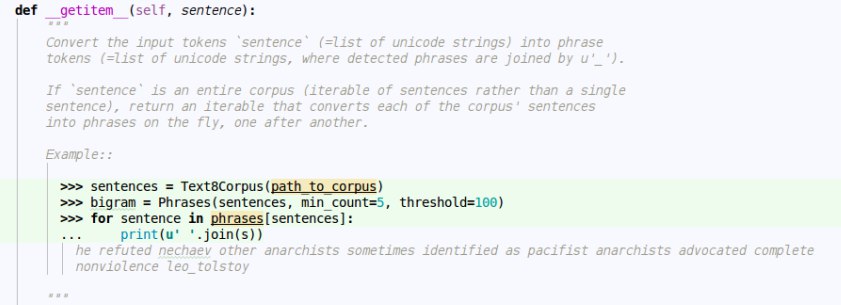

было бы неплохо иметь размечать еще н-граммы

t2

было бы неплохо иметь размечать еще н-граммы

уровня слов или букв?

AZ

уровня слов или букв?

слов

2017 August 28

AZ

а кто нибудь обучал word2vec на dbpedia ?

АМ

так стандартных примерах есть же

АМ

на google news и википедии

dr

Подскажите, пожалуйста, а Natasha уметт искать только персон, организации и локации? Можно ли её научить искать другие сущности (названия товаров и пр.)?