DP

Size: a a a

2021 February 03

тут человек пишет код не для команды и явно учится

я согласен, что гавнокод если он не для тебя одного неприемлем (и даже для себя одного лучше не надо) и сам пишу максимально понятный код

DP

тут человек пишет код не для команды и явно учится

но конкретно в этом случае вы перегибаете

DP

код чистый, переменные не названы a, b, c, d, e. Нет закоменченных огромных кусков. Нет яростного гавнокода

A

да мне пофиг, честно, я ж не разбираю ваш код... просто рекомендации на будущее

i

В какой же это вы школе учились интересно ?

Обычная, думаю это был эксперимент какой то

DP

да мне пофиг, честно, я ж не разбираю ваш код... просто рекомендации на будущее

кому:?

A

тема закрыта. пишите, как хотите, хоть на 1С

DP

еще раз - если мне, то не надо. Если человекуу- то имхо вы зря наехали

SS

да мы не наезжаем, на скрине - не говнокод. просто замечания по стилистике, на будущее пригодится

DP

Sergey Salnikov

да мы не наезжаем, на скрине - не говнокод. просто замечания по стилистике, на будущее пригодится

Andy наезжает)

DP

если это не наезд - то я не знаю определения наезда)

IS

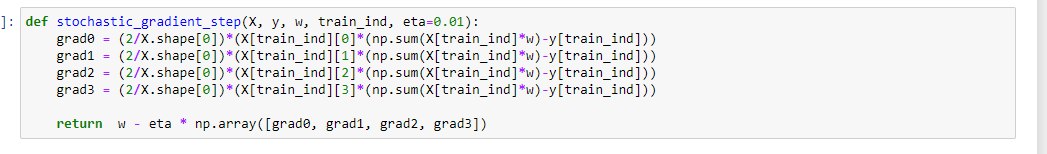

когда я делаю так как предложил Сергей Козлов stochastic_gradient_step(),вместо w0.shape = (4,1 ) я получаю w0.shape = (4,4)

w0: [[0.414696 0.414696 0.414696 0.414696]

[0.014948 0.014948 0.014948 0.014948]

[0.031672 0.031672 0.031672 0.031672]

[0.00148 0.00148 0.00148 0.00148 ]]

и потом метод не сходится...

почему так ?

w0: [[0.414696 0.414696 0.414696 0.414696]

[0.014948 0.014948 0.014948 0.014948]

[0.031672 0.031672 0.031672 0.031672]

[0.00148 0.00148 0.00148 0.00148 ]]

и потом метод не сходится...

почему так ?

SS

Andy - не наезжай

A

Andy наезжает)

я не наезжаю )

A

если это не наезд - то я не знаю определения наезда)

"просто замечания по стилистике, на будущее пригодится"

Y

когда я делаю так как предложил Сергей Козлов stochastic_gradient_step(),вместо w0.shape = (4,1 ) я получаю w0.shape = (4,4)

w0: [[0.414696 0.414696 0.414696 0.414696]

[0.014948 0.014948 0.014948 0.014948]

[0.031672 0.031672 0.031672 0.031672]

[0.00148 0.00148 0.00148 0.00148 ]]

и потом метод не сходится...

почему так ?

w0: [[0.414696 0.414696 0.414696 0.414696]

[0.014948 0.014948 0.014948 0.014948]

[0.031672 0.031672 0.031672 0.031672]

[0.00148 0.00148 0.00148 0.00148 ]]

и потом метод не сходится...

почему так ?

А функция для шага градиента какая?

M

все время задаюсь вопросом: почему в мл идут ДО изучения пайтона...

У нас в университете в таком порядке было:

1) матан, лааг, дискретка

2) теория алгоритмов, численные методы

3) основы анализа данных

4) машинное обучение, анализ данных

5) нейросети, нлп

1) матан, лааг, дискретка

2) теория алгоритмов, численные методы

3) основы анализа данных

4) машинное обучение, анализ данных

5) нейросети, нлп

M

Были конечно другие дисциплины вроде компьютерных сетей, плюсы, шарпы, джава

Но в чем суть: пайтона у нас не было)

Но в чем суть: пайтона у нас не было)

Y

У нас в университете в таком порядке было:

1) матан, лааг, дискретка

2) теория алгоритмов, численные методы

3) основы анализа данных

4) машинное обучение, анализ данных

5) нейросети, нлп

1) матан, лааг, дискретка

2) теория алгоритмов, численные методы

3) основы анализа данных

4) машинное обучение, анализ данных

5) нейросети, нлп

Какая специальность?

M

ИИ