IL

Size: a a a

2020 May 20

Это пофиксили в 0.23.1. Ошибка была в сохранении модели, поэтому, чтобы все заработало, модель должна быть обучена и сохранена версией катбуста не ниже 0.23.1.

AM

Это пофиксили в 0.23.1. Ошибка была в сохранении модели, поэтому, чтобы все заработало, модель должна быть обучена и сохранена версией катбуста не ниже 0.23.1.

Спасибо

2020 May 21

OT

А есть возможность использовать catboost с внешней видеокартой на ноутбуке подключенной как eGPU ?

AK

CatBoost использует CUDA для работы с GPU. Если драйвер nVidia эту видеокарту видит, то скорее всего будет работать.

2020 May 22

OT

Почему у меня очень сильно разнятся результаты встроенной метрики PRAUC на валидационном сете и на кастомной метрике ? Для кастомной метрики использую функции из sklearn

class pr_auc(object):

def is_max_optimal(self):

# Returns whether great values of metric are better

return True

def evaluate(self, approxes, target, weight):

# approxes is a list of indexed containers

# (containers with only len and getitem defined),

# one container per approx dimension.

# Each container contains floats.

# weight is a one dimensional indexed container.

# target is a one dimensional indexed container.

# weight parameter can be None.

# Returns pair (error, weights sum)

assert len(approxes) == 1

assert len(target) == len(approxes[0])

approx = approxes[0]

precision, recall, thresholds = precision_recall_curve(np.asarray(target), np.asarray(approx))

pr_auc = auc(recall, precision)

return pr_auc, 0

def get_final_error(self, error, weight):

# Returns final value of metric based on error and weight

return error

class pr_auc(object):

def is_max_optimal(self):

# Returns whether great values of metric are better

return True

def evaluate(self, approxes, target, weight):

# approxes is a list of indexed containers

# (containers with only len and getitem defined),

# one container per approx dimension.

# Each container contains floats.

# weight is a one dimensional indexed container.

# target is a one dimensional indexed container.

# weight parameter can be None.

# Returns pair (error, weights sum)

assert len(approxes) == 1

assert len(target) == len(approxes[0])

approx = approxes[0]

precision, recall, thresholds = precision_recall_curve(np.asarray(target), np.asarray(approx))

pr_auc = auc(recall, precision)

return pr_auc, 0

def get_final_error(self, error, weight):

# Returns final value of metric based on error and weight

return error

2020 May 25

IP

Всем привет. Порекомендуйте пож ссылку где используют catboost для множественной регрессии и анализируют фичи

MF

Экспериментально видно, что learning rate определяемый на GPU хуже, чем на CPU. Поэтому запускаю catboost-0.23.exe на CPU, из STDOUT зачитываю learning rate, убиваю процесс catboost-0.23.exe, запускаю снова на GPU, явно задавая learning rate опцией.

Вот в такие позы вы ставите своих пользователей )

Вот в такие позы вы ставите своих пользователей )

SK

мы обязательно пофиксим эту багу :)

2020 May 26

В

Добрый день!

Надеюсь, вопрос уместен (он скорее фундаментальный для машинного обучения в целом, но скорее всего ответ зависит от используемых методов, моделей):

Стоит ли использовать при обучении дополнительные данные label (y), то есть предсказываемых значений, которые в не нужно предсказывать? Может ли это повысить точность модели?

Пока, к сожалению, не могу назвать датасет (сроки подачи решений еще не завершились, наверное, это неэтично). В любом случае, участвую только ради опыта.

Фактически нужно предсказать Да или Нет, но есть дополнительная количественная информация по выходным данным.

Попробую описать гипотетическую задачу: если бы речь шла о предсказании интересна пользователю User1 новость A, или нет (по сути у категории только 2 возможных значения), то стоит ли при обучении модели добавлять какие либо доступные данные например учить модель по данным Интересна(1 или 0, это собственно и нужно предсказать), время_просмотра_новости(количество минут).

Мне кажется, что такая информация в предсказываемых данных может повысить точность классификации, но уверенности нет, из прочитанной литературы к сожалению не могу вспомнить, советуют ли такое и тем более в каких случаях это стоит делать...

Сразу скажу, что вполне отдаю себе отчет, что есть более очевидный вариант: конечно, можно наоборот агрегировать подобные данные и использовать как входные: к примеру очевидно, что можно ввести дополнительные поля (как часто этот юзер читает новости, как много на них времени тратит, как часто эту новость читают итд). В этом плане вопросов по сути нет, уверен что такой подход пойдет на пользу.

А вот по поводу первого варианта (тренировка на предсказание 1+n значений и категорий чтобы предсказать только одну категорию) очень хотелось бы узнать, насколько такой подход адекватен?

Простите за избыточный текст. Спасибо!

Надеюсь, вопрос уместен (он скорее фундаментальный для машинного обучения в целом, но скорее всего ответ зависит от используемых методов, моделей):

Стоит ли использовать при обучении дополнительные данные label (y), то есть предсказываемых значений, которые в не нужно предсказывать? Может ли это повысить точность модели?

Пока, к сожалению, не могу назвать датасет (сроки подачи решений еще не завершились, наверное, это неэтично). В любом случае, участвую только ради опыта.

Фактически нужно предсказать Да или Нет, но есть дополнительная количественная информация по выходным данным.

Попробую описать гипотетическую задачу: если бы речь шла о предсказании интересна пользователю User1 новость A, или нет (по сути у категории только 2 возможных значения), то стоит ли при обучении модели добавлять какие либо доступные данные например учить модель по данным Интересна(1 или 0, это собственно и нужно предсказать), время_просмотра_новости(количество минут).

Мне кажется, что такая информация в предсказываемых данных может повысить точность классификации, но уверенности нет, из прочитанной литературы к сожалению не могу вспомнить, советуют ли такое и тем более в каких случаях это стоит делать...

Сразу скажу, что вполне отдаю себе отчет, что есть более очевидный вариант: конечно, можно наоборот агрегировать подобные данные и использовать как входные: к примеру очевидно, что можно ввести дополнительные поля (как часто этот юзер читает новости, как много на них времени тратит, как часто эту новость читают итд). В этом плане вопросов по сути нет, уверен что такой подход пойдет на пользу.

А вот по поводу первого варианта (тренировка на предсказание 1+n значений и категорий чтобы предсказать только одну категорию) очень хотелось бы узнать, насколько такой подход адекватен?

Простите за избыточный текст. Спасибо!

II

Всем привет! Скажите пожалуйста, как правильно подавать на вход эмбеддинги (векторы) параллельно с категориальными фичами и timestamp?

Данные хранятся в pandas, вариант разбить вектор на n столбцов выглядит несколько коряво

Данные хранятся в pandas, вариант разбить вектор на n столбцов выглядит несколько коряво

2020 May 27

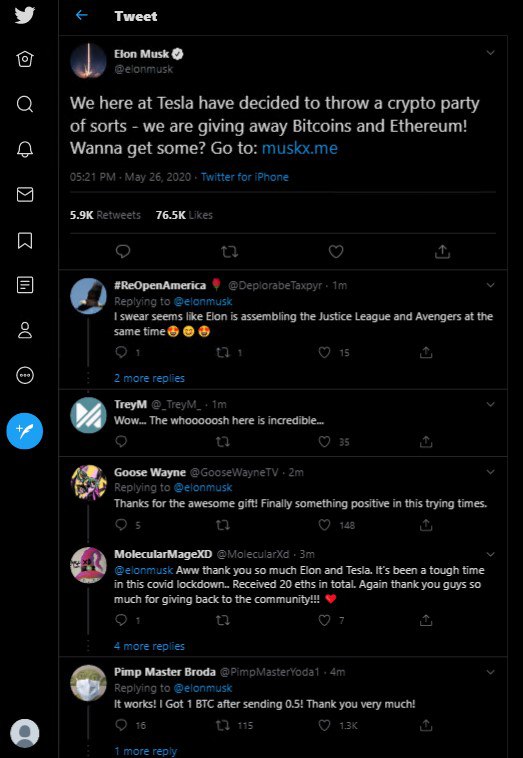

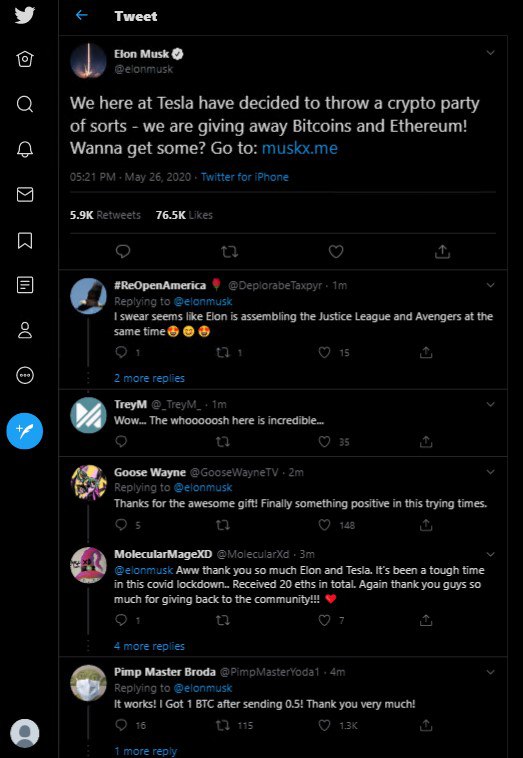

壬C

WOw

KM

壬豪 Cana | CO-INITIATIVE.IO ambassador.

WOw

спам(

MF

Добрый день! Есть ли где-то описание алгоритма, по которому происходит автоматический выбор learning rate? Поделитесь ссылкой.

ND

Всем привет! Скажите пожалуйста, как правильно подавать на вход эмбеддинги (векторы) параллельно с категориальными фичами и timestamp?

Данные хранятся в pandas, вариант разбить вектор на n столбцов выглядит несколько коряво

Данные хранятся в pandas, вариант разбить вектор на n столбцов выглядит несколько коряво

Привет!

Мы прям сейчас работаем над этой функциональностью

А пока - только разбивать на несколько столбцов

Мы прям сейчас работаем над этой функциональностью

А пока - только разбивать на несколько столбцов

II

Под капотом это предполагает независимость каждой фичи, в случае эмбеддингов это не совсем так

ND

Добрый день! Есть ли где-то описание алгоритма, по которому происходит автоматический выбор learning rate? Поделитесь ссылкой.

Привет!

Мы обучили лин модель, которая по статистикам датасета предсказывает лернинг рейт

Мы обучили лин модель, которая по статистикам датасета предсказывает лернинг рейт

SK

Добрый день! Есть ли где-то описание алгоритма, по которому происходит автоматический выбор learning rate? Поделитесь ссылкой.

https://github.com/catboost/catboost/blob/master/catboost/libs/train_lib/options_helper.cpp#L192 - текущие коэффициенты можно подсмотреть в коде

ND

Под капотом это предполагает независимость каждой фичи, в случае эмбеддингов это не совсем так

Все так

На данный момент только так..

Скоро добавим возможность передавать вектор эмбедингов как единую фичу

На данный момент только так..

Скоро добавим возможность передавать вектор эмбедингов как единую фичу

II

Все так

На данный момент только так..

Скоро добавим возможность передавать вектор эмбедингов как единую фичу

На данный момент только так..

Скоро добавим возможность передавать вектор эмбедингов как единую фичу

Спасибо