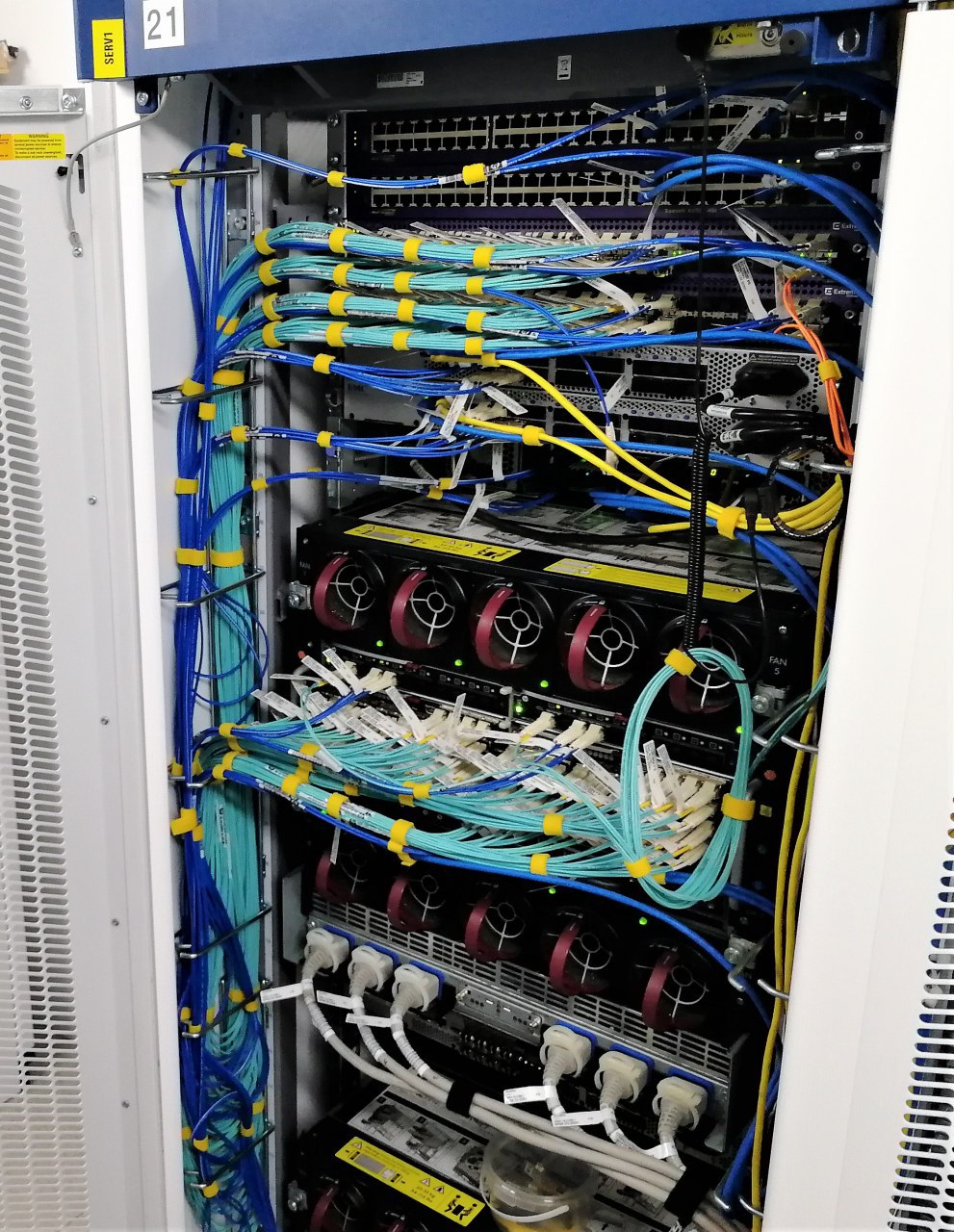

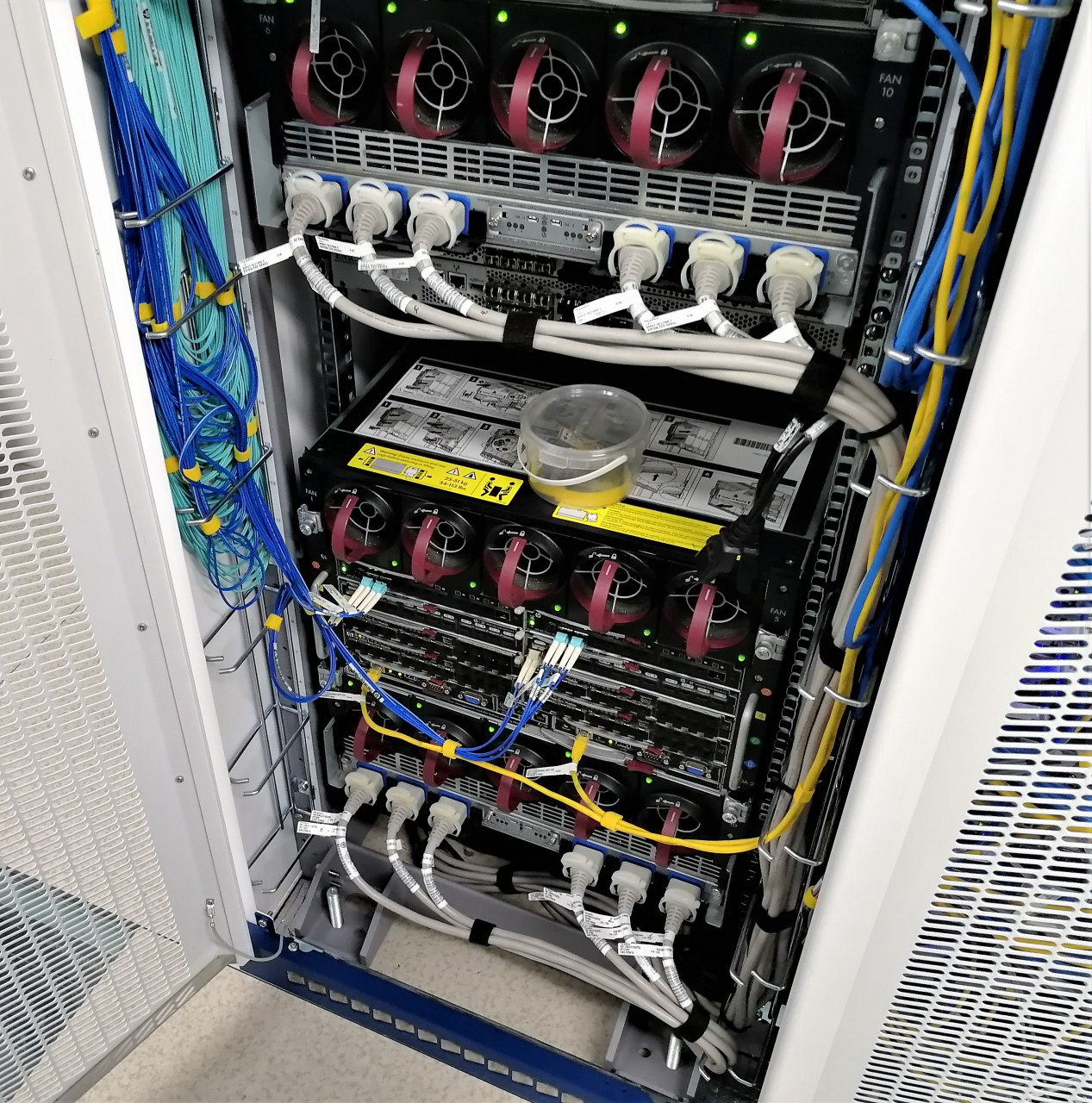

Каждая из "коробочек" содержит в себе подключения 8 портов до 100 Гбит/c оптики. Подключения делаются специальным "толстым" оптическим кабелем, который затем раздваивается (светло-голубого цвета кабель). Это позволяет затем поделить 100 Гбит/c на 10 * 10 Гбит/c.

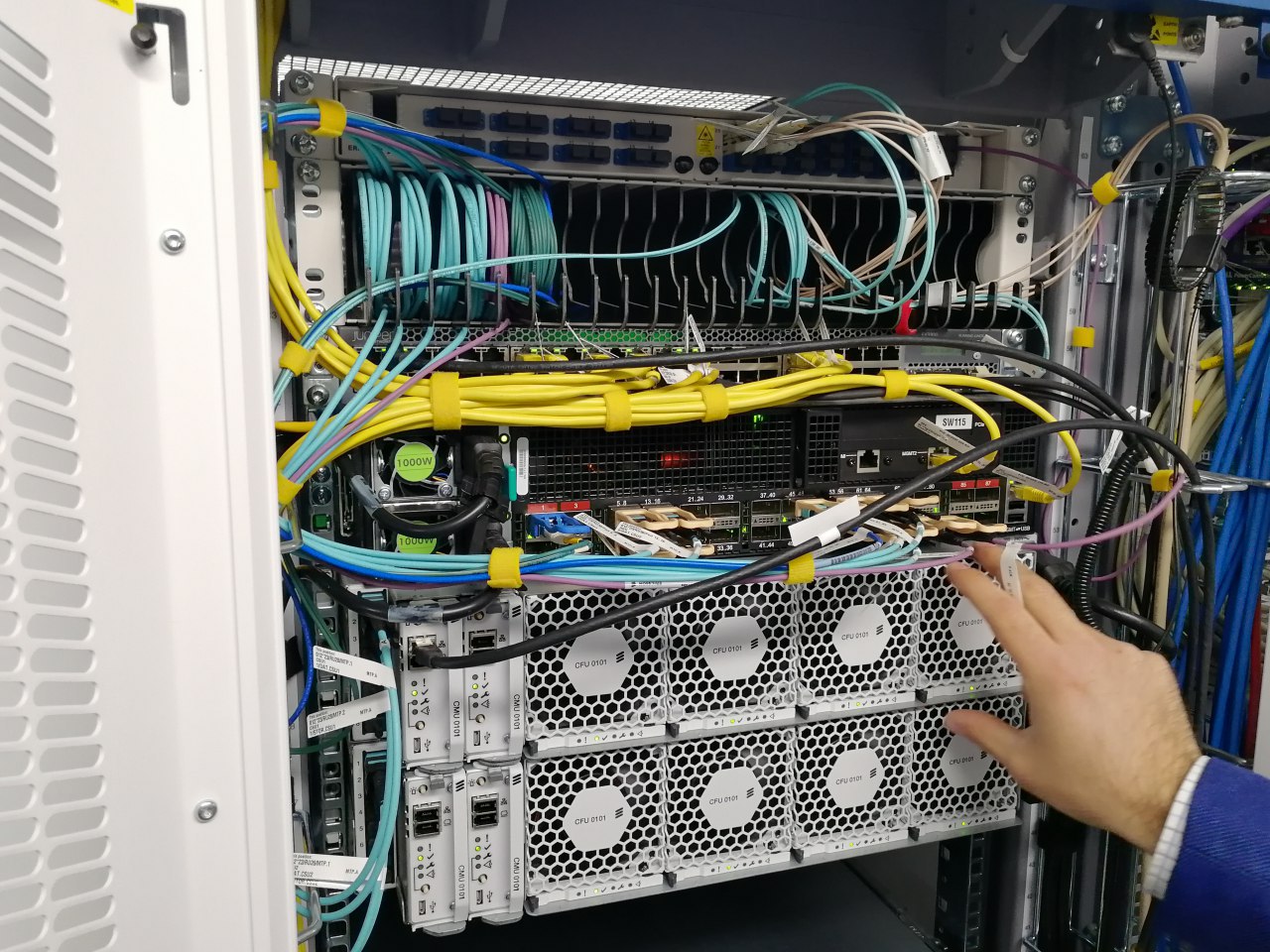

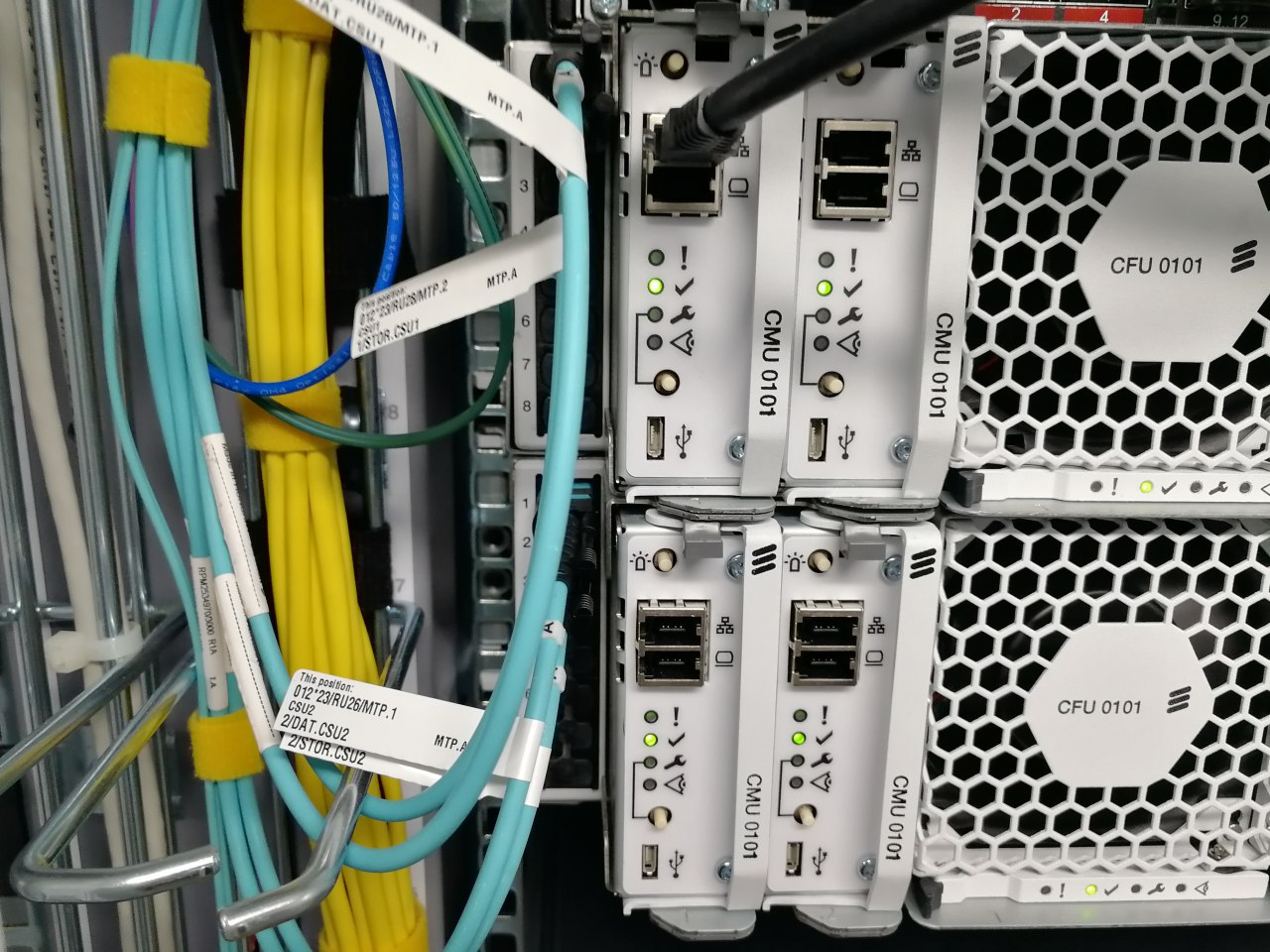

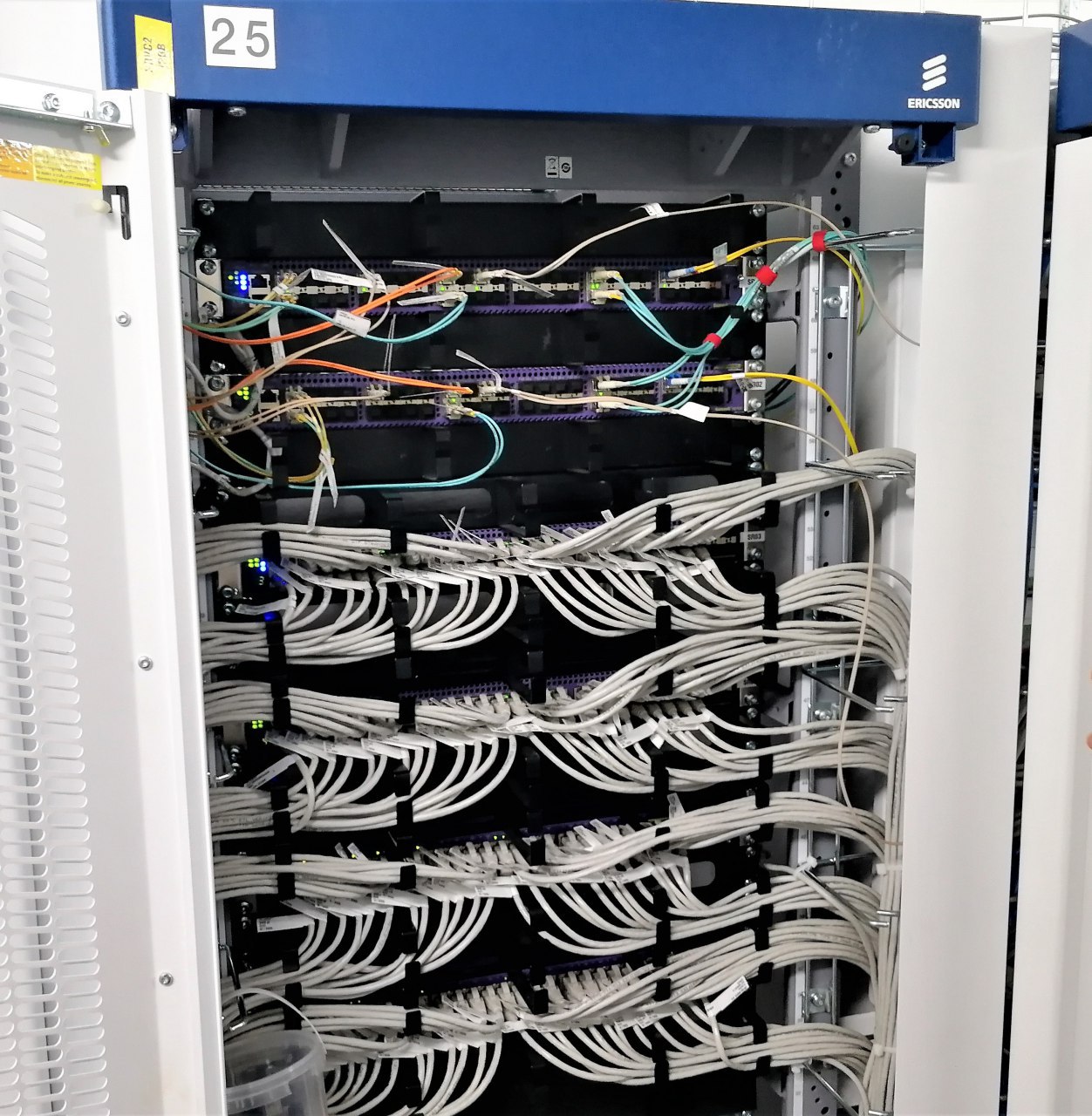

CMU - это контроллер SLEDа. Этот контроллер, во-первых, позволяет организовать работу ПО виртуализации о котором выше говорилось, вторая особенность этой платформы - реализация архитектуры Intel. Так называемая Rack Scale архитектура. В чем ее суть в двух словах. У вас есть память, процессоры, жесткие диски в каждом стандартном сервере. Но вы, например, хотите менять память раз в 2 года, а процессоры - раз в десять лет, а жесткие диски, например, каждые полгода. Сейчас или надо разбирать сервера, что неудобно, если у вас их много, либо заменяете сервер целиком, но тогда не получается долго использовать элементы, которые можно использовать долго, экономя на более длительном использовании ряда компонентов.