A

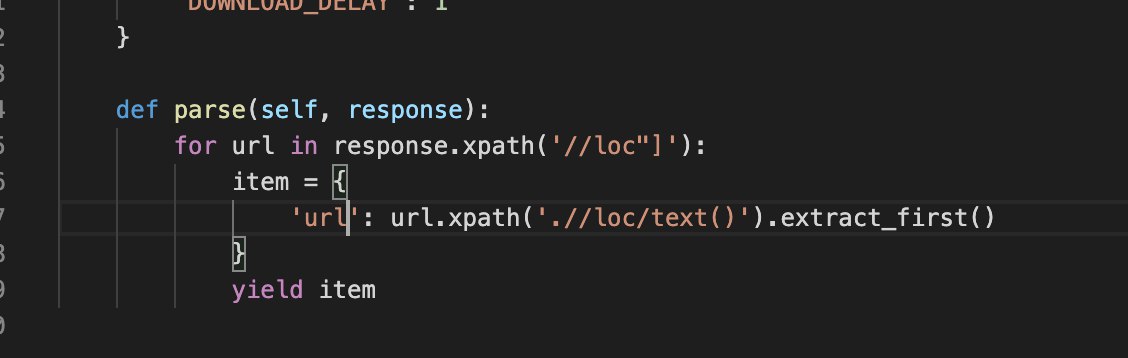

def parse(self, response, ):

items = {}

next_page_url = response.xpath('//a[@class="nfl-o-table-pagination__next"]/@href').get()

part_href = response.xpath('//a[@class="d3-o-media-object"]/a[@class="d3-o-player-fullname nfl-o-cta--link"]/@href').getall()

href = []

for href_str in part_href:

hr = href.append('https://www.nfl.com%sstats/logs/' % href_str)

hr2 = 'https://www.nfl.com%sstats/logs/' % href_str

items['href'] = href

yield items

if next_page_url is not None:

yield scrapy.Request(response.urljoin(next_page_url))