A

Size: a a a

2020 November 06

Ребят привет! Пытаюсь через apscheduler запустить паука через CrawlerProcess , использую TwistedSchaduler(), но как бы без разницы все перепробовал - виснет на telnet console listening on port . Никаких багов , ничего. Запускал в ручную паука все собирает и везде рассовывает как надо. Идеи закончились, что полезно показать? Или может кто то сталкивался?

МС

Ребят привет! Пытаюсь через apscheduler запустить паука через CrawlerProcess , использую TwistedSchaduler(), но как бы без разницы все перепробовал - виснет на telnet console listening on port . Никаких багов , ничего. Запускал в ручную паука все собирает и везде рассовывает как надо. Идеи закончились, что полезно показать? Или может кто то сталкивался?

никогда не работал с apscheduler, но, вангую, что быстрее помогут, если напишешь как делал

8

8

Всем привет народ нужна помощь в разборе роботы парсера. При запуске паучка он соскребает с первой страници и переходит на вторую. Соскребав вторую (там только 2 страници) он возвращается на первую и опять соскребает её. В итоги я получаю две первых страници и одну вторую что не хорошо, по идеи на второй страници он должен остановиться.

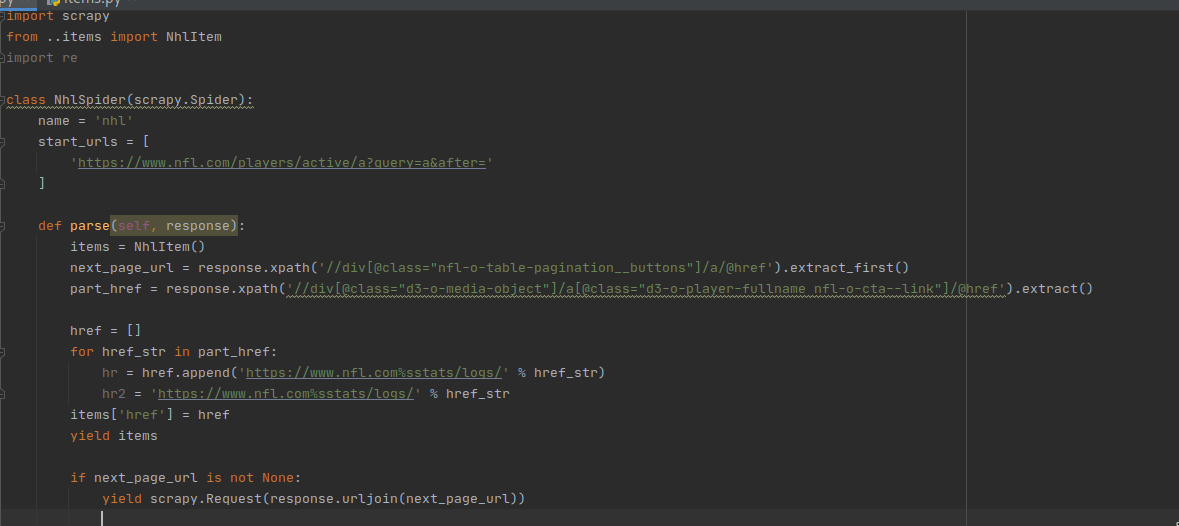

Скрин прикладываю, заранее благодарен.

Скрин прикладываю, заранее благодарен.

A

никогда не работал с apscheduler, но, вангую, что быстрее помогут, если напишешь как делал

Сейчас попробую ещё через CrawlerRunner, если застряну опишу, спасибо!

МС

85345

Всем привет народ нужна помощь в разборе роботы парсера. При запуске паучка он соскребает с первой страници и переходит на вторую. Соскребав вторую (там только 2 страници) он возвращается на первую и опять соскребает её. В итоги я получаю две первых страници и одну вторую что не хорошо, по идеи на второй страници он должен остановиться.

Скрин прикладываю, заранее благодарен.

Скрин прикладываю, заранее благодарен.

1. нахрен скрины

2. первый раз ты заходишь так, как старт_урлс, втрой раз в окончании ?page=1 или как то так

2. первый раз ты заходишь так, как старт_урлс, втрой раз в окончании ?page=1 или как то так

МС

от я щас даже не полезу на сайт, что бы ткнуть в ошибку, ибо лениво адрес набирать

8

1. нахрен скрины

2. первый раз ты заходишь так, как старт_урлс, втрой раз в окончании ?page=1 или как то так

2. первый раз ты заходишь так, как старт_урлс, втрой раз в окончании ?page=1 или как то так

1. Ну как зачем скрин?) Свой чудо код показать и нагляднее к томуже

2. Правильно он старт урл собирает и переходит на другую страничку. Но какого он после другой страници возвращаеться на старт урл?

2. Правильно он старт урл собирает и переходит на другую страничку. Но какого он после другой страници возвращаеться на старт урл?

МС

class PositionSpider(scrapy.Spider):

name = 'position'

allowed_domains = ['wildberries.ru']

start_urls = [

'https://www.wildberries.ru/catalog/zhenshchinam',

'https://www.wildberries.ru/catalog/muzhchinam',

'https://www.wildberries.ru/catalog/detyam',

'https://www.wildberries.ru/catalog/sport',

'https://www.wildberries.ru/promotions'

]

def parse(self, response, **kwargs):

pass

МС

а так совсем низзя, или на пастебин какой если простынь здоровая

МС

если он вернулся на ту же страницу, значит ссыль другая, он по умолчанию фильтрует отдинаковые ссылки

A

а еще лучше кидать весь код паука, что б просто вставить и запустить😐

8

class PositionSpider(scrapy.Spider):

name = 'position'

allowed_domains = ['wildberries.ru']

start_urls = [

'https://www.wildberries.ru/catalog/zhenshchinam',

'https://www.wildberries.ru/catalog/muzhchinam',

'https://www.wildberries.ru/catalog/detyam',

'https://www.wildberries.ru/catalog/sport',

'https://www.wildberries.ru/promotions'

]

def parse(self, response, **kwargs):

pass

Можно и так, не думал что комуто скрин глаза будет резать..

8

85345

Можно и так, не думал что комуто скрин глаза будет резать..

да и кода там ничего

МС

85345

да и кода там ничего

угу, Андрей, вон, уже запустил бы и посмотрел ошибку. А так - нахреннахрен, перенабирать со скрина...

8

import scrapy

from ..items import NhlItem

class NhlSpider(scrapy.Spider):

name = 'nhl'

start_urls = [

'https://www.nfl.com/players/active/a?query=a&after='

]

def parse(self, response):

items = NhlItem()

next_page_url = response.xpath('//div[@class="nfl-o-table-pagination__buttons"]/a/@href').extract_first()

part_href = response.xpath('//div[@class="d3-o-media-object"]/a[@class="d3-o-player-fullname nfl-o-cta--link"]/@href').extract()

href = []

for href_str in part_href:

hr = href.append('https://www.nfl.com%sstats/logs/' % href_str)

hr2 = 'https://www.nfl.com%sstats/logs/' % href_str

items['href'] = href

yield items

if next_page_url is not None:

yield scrapy.Request(response.urljoin(next_page_url))

from ..items import NhlItem

class NhlSpider(scrapy.Spider):

name = 'nhl'

start_urls = [

'https://www.nfl.com/players/active/a?query=a&after='

]

def parse(self, response):

items = NhlItem()

next_page_url = response.xpath('//div[@class="nfl-o-table-pagination__buttons"]/a/@href').extract_first()

part_href = response.xpath('//div[@class="d3-o-media-object"]/a[@class="d3-o-player-fullname nfl-o-cta--link"]/@href').extract()

href = []

for href_str in part_href:

hr = href.append('https://www.nfl.com%sstats/logs/' % href_str)

hr2 = 'https://www.nfl.com%sstats/logs/' % href_str

items['href'] = href

yield items

if next_page_url is not None:

yield scrapy.Request(response.urljoin(next_page_url))

8

Посмотрел детальнее с учетом новой инфы, там рили переходы интересные

8

https://www.nfl.com/players/active/a?query=a&after= Это первая как и эта https://www.nfl.com/players/active/a

а вот это уже вторая https://www.nfl.com/players/active/a?query=a&after=c2ltcGxlLWN1cnNvcjk5

а вот это уже вторая https://www.nfl.com/players/active/a?query=a&after=c2ltcGxlLWN1cnNvcjk5

8

По этому scrapy и путался

A

почему скрапи? логика парсера