YB

Size: a a a

2016 November 15

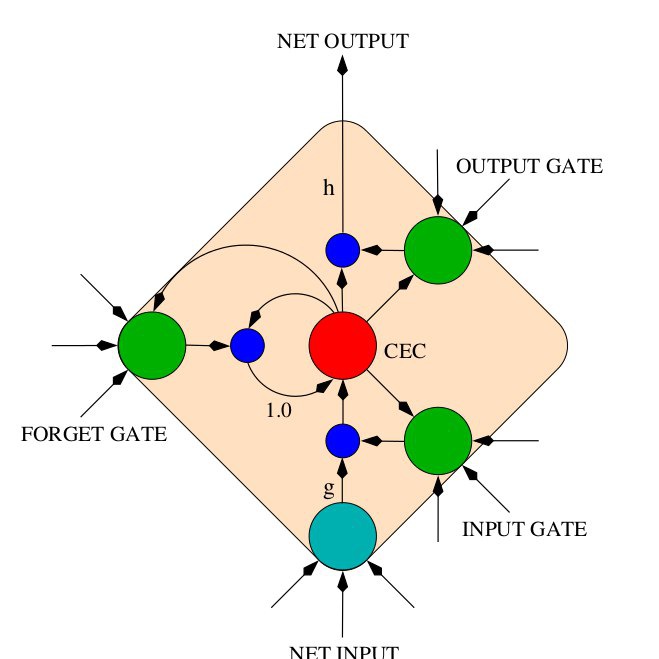

ну а тем кто в теме, вполне можно и модель такую повторить. так-то примерно понятно, что за модель, она там нарисована даже

AB

хм, чо то сложно как-то, не для нубов. Вот Google выпустил Tensorflow и как-то сразу весь github заполнился его применениями.

YB

ну вот представь они свой код на 8 GPU выложат — и кому он нужен?

AB

а кто нить тут пробовал их наработки?

YB

у них тоже модель наверняка на tensorflow, но ты явно хочешь, чтобы они для тебя бесплатно сделали опенсорсный продукт

YB

я пробовал их NLP парсер

YB

YB

для русского модель слабая, т.к. датасет очень маленький (кажется всего порядка 20к предложений), практического смысла использовать нет. да и даже для английского — ну ошибаемость на слово порядка 7%, если пытаться из такого какой-то логический вывод сделать — выведешь противоречие (а из него всё что угодно).

YB

т.е. с одной стороны — да, наилучшее решение из возможных на сегодняшний день, State of the art. С другой стороны, нифига не применимо на практике как компонент намного более сложного продукта.

YB

и это ошибаемость синтаксического разбора порядка 7%, а ещё нужно семантическую омонимию снять, где ещё 30% ошибок на слово запросто будет.

YB

а в machine translation всё это сразу, конечно же: и синтаксические ошибки, и семантические, и логико-прагматические.

AB

работает нормально, только итераций мног онадо

YB

ну это развлекуха, там понятия "качество работы" нет вообще

AB

хотя как всегда всё зависит от качества и объема параллельных текстов

YB

вот если бы можно было бы "направлять" генерированный текст, задавая ему тему...

YB

тогда можно было бы качество оценить хотя бы

YB

а так — чем "человечней" модель выдаёт текст, тем меньше разнообразие текстов, которые она может генерировать (и тем больше они состоят из текстов автора)

YB

вот если бы можно было бы "направлять" генерированный текст, задавая ему тему...

собственно, алгоритм должно быть несложно модифицировать таким образом