Size: a a a

2021 June 05

8-9 июня Snowflake Summit, можно узнать что нового в индустрии и куда cloud analytics двигается.

Сегодня сдал еще один экзамен Azure Data Fundamentals (DP-900), в прошлом комментарии один из читателей про него рассказал.

Оказался довольно простым и практически не про облака, больше про классические аналитические вещи типа ETL/ELT, Batch/Streaming. И часть вопросов про инструменты Azure для аналитики HDIsight, Synapse Analytics, Azure SQL, Azure Blob и Azure Cosmos DB (тут я наугад отвечал).

Материал по подготовки очень хороший и небольшой, стоит того, чтобы проскролить, покрывает базовые вещи по аналитики.

Оказался довольно простым и практически не про облака, больше про классические аналитические вещи типа ETL/ELT, Batch/Streaming. И часть вопросов про инструменты Azure для аналитики HDIsight, Synapse Analytics, Azure SQL, Azure Blob и Azure Cosmos DB (тут я наугад отвечал).

Материал по подготовки очень хороший и небольшой, стоит того, чтобы проскролить, покрывает базовые вещи по аналитики.

2021 June 06

Чувак рассказывает как он стал менеджером по аналитике в Амазон и делится советами как быть начинающему менеджеру.

8 июня Иван Трусов - Solution Architect Databricks в Берлине расскажет нам про платформу Databricks и Lakehouse.

У нас запланирована целая серия вебинаров с русскоговорящими архитекторами Databricks, stay tuned!

Хочу рассказать как со всеми ними познакомился. Так как я внедряю Azure Databricks в Microsoft Gaming/Xbox, то спустя какое-то время я устал париться с поддержкой Azure и ждать неделями их бесполезные ответы, я написал директору Azure Databricks в Microsoft и попросил помочь с CI/CD, в итоге наc соединили с командой архитекторов в Берлине и Амстердаме и я рассказал им про datalearn и попросил выступить. Мир тесен!

PS CI/CD pipeline уже работает!

У нас запланирована целая серия вебинаров с русскоговорящими архитекторами Databricks, stay tuned!

Хочу рассказать как со всеми ними познакомился. Так как я внедряю Azure Databricks в Microsoft Gaming/Xbox, то спустя какое-то время я устал париться с поддержкой Azure и ждать неделями их бесполезные ответы, я написал директору Azure Databricks в Microsoft и попросил помочь с CI/CD, в итоге наc соединили с командой архитекторов в Берлине и Амстердаме и я рассказал им про datalearn и попросил выступить. Мир тесен!

PS CI/CD pipeline уже работает!

2021 June 07

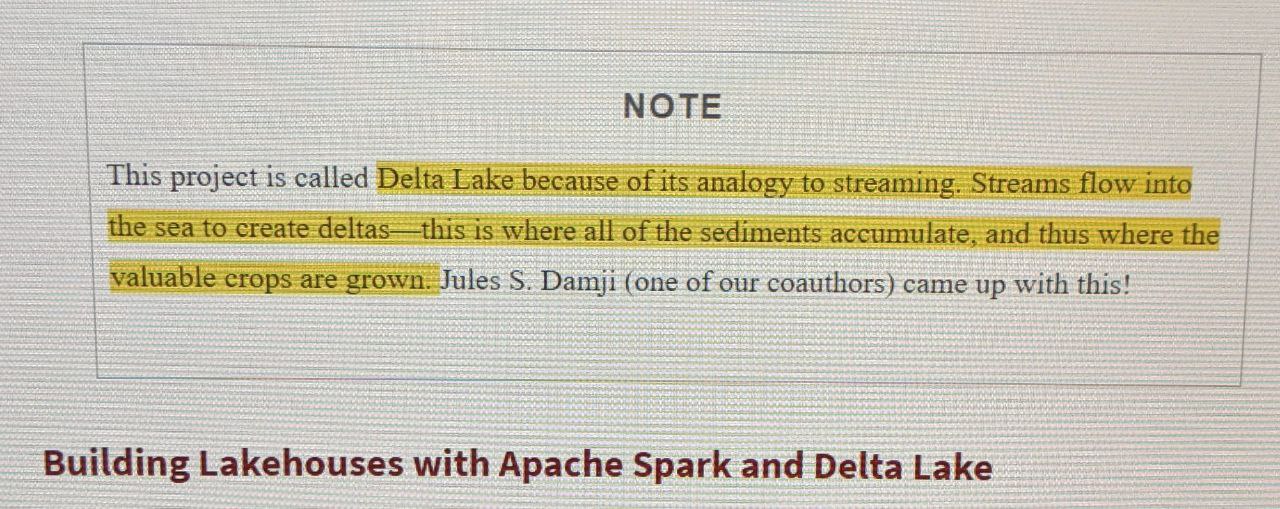

Почему delta lake так называется?

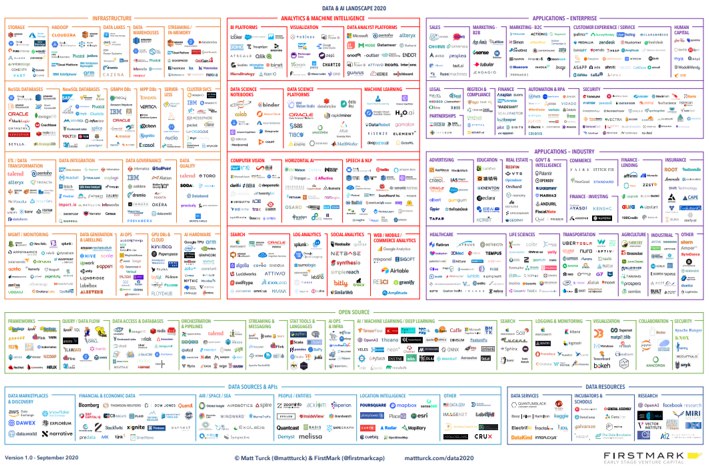

Всем привет. Думаю, предыдущую рубрику можно закрывать. Я постарался охватить все основные направления работы с данными и дать пошаговый план развития с полезными ссылками для каждой позиции.

Теперь я хочу начать следующую рубрику, которая будет посвящена архитектуре аналитических решений. Думаю, что более эффективно изучать материал, двигаясь от общего к частному, от абстракции к конкретике. Такой подход позволяет наиболее быстро и эффективно разобраться в любом предмете. Поэтому, я предлагаю сначала взглянуть на архитектуру решений в целом, а затем подробно разобрать каждый из её элементов.

Сегодня я хочу коснуться базовых вещей - концепций, на которых строится любая аналитическая архитектура. В последующих постах для закрепления я буду брать примеры реальных решений и разбирать их, рассказывая какие инструменты за какую задачу отвечают.

Итак, поговорим о концепциях.

Если абстрагироваться, то любую аналитическую архитектуру можно разделить на 5 слоев:

1) Source Layer (слой источников данных);

2) Data Processing Layer (слой обработки данных);

3) Storage Layer (слой хранения данных);

4) Access Layer (слой доступа к данным);

5) Service Layer (сервисный слой).

Разберём каждый слой подробнее:

Source Layer. Этот слой отвечает за все наши источники данных. Это могут быть OLTP базы данных, которые отвечают за обслуживание операционной деятельности компании, различные файлы, в которых хранятся операционные данные (файлы могут быть различных форматов: csv, xlsx, txt, json, xml и т.д.), API внешних систем, IoT (интернет вещей) и др.

Примеры сервисов и инструментов на этом уровне: MySQL СУБД, Google Analytics, Facebook Ads, FTP/SFTP сервер, Salesforce, Kafka.

Data Processing Layer. Этот слой отвечает за обработку данных. Как раз здесь встречаются такие понятия, как ETL/ELT и data pipelines. Т.е., благодаря этому слою, осуществляется извлечение данных из источников, трансформация данных, движение данных и загрузка их в централизованный слой хранения данных.

Примеры сервисов и инструментов на этом уровне: Python и SQL, Apache Airflow, dbt, Pentaho Data Integration, Matillion ETL, Spark, AWS Glue, Azure Data Factory и др.

Storage Layer. Этот слой отвечает за централизованное хранение данных. Здесь появляются такие понятия как Data Warehouse (DWH), Data Lake и новомодное слово Lakehouse. Какое решение использует компания зависит от её задач. Например, если компании аналитическое решение нужно для конечной визуализации данных в BI-инструменте и для написания SQL-запросов к обработанным данным для поиска инсайтов, то достаточно будет использовать хранилище данных. Если у компании есть Data Science департамент, который строит ML-модели на основе данных для задач бизнеса, то разумным решением будет также использование Data Lake или Lakehouse, так как построение моделей требует обработки большого количества данных и для таких целей используется более сложный non-SQL код; Data Lake в таком случае является более гибким решением, так как обеспечивает быстрый прямой доступ к файлам.

Большим компаниям обычно нужен микс хранилища данных и озера данных, т.е., так называемая, Data Platform. Платформа данных как раз заточена на то, чтобы обслуживать и уровень BI-приложений и Data Science.

Примеры сервисов и инструментов на этом уровне: AWS S3, Azure Data Lake, Google Cloud Storage, AWS Redshift, Azure Synapse, Google BigQuery, HDFS (Hadoop), Vertica, Clickhouse и др.

Access Layer. Слой доступа к данным. Здесь в игру вступают BI-приложения, data-аналитики и data-сайнтисты, которые используют данные (уже находящиеся в Data Lake или DWH) для своих целей. В качестве приёмщика данных может также выступать база данных, которая обслуживает back-end интернет-магазина и позволяет показывать рекомендуемые товары на основе ML-моделей. В общем, этот слой является верхушкой айсберга, ради которой собственно и затевается построение всей системы.

Примеры сервисов и инструментов на этом уровне: Power BI, Tableau, AWS SageMaker, GCP AI Platform и др.

Теперь я хочу начать следующую рубрику, которая будет посвящена архитектуре аналитических решений. Думаю, что более эффективно изучать материал, двигаясь от общего к частному, от абстракции к конкретике. Такой подход позволяет наиболее быстро и эффективно разобраться в любом предмете. Поэтому, я предлагаю сначала взглянуть на архитектуру решений в целом, а затем подробно разобрать каждый из её элементов.

Сегодня я хочу коснуться базовых вещей - концепций, на которых строится любая аналитическая архитектура. В последующих постах для закрепления я буду брать примеры реальных решений и разбирать их, рассказывая какие инструменты за какую задачу отвечают.

Итак, поговорим о концепциях.

Если абстрагироваться, то любую аналитическую архитектуру можно разделить на 5 слоев:

1) Source Layer (слой источников данных);

2) Data Processing Layer (слой обработки данных);

3) Storage Layer (слой хранения данных);

4) Access Layer (слой доступа к данным);

5) Service Layer (сервисный слой).

Разберём каждый слой подробнее:

Source Layer. Этот слой отвечает за все наши источники данных. Это могут быть OLTP базы данных, которые отвечают за обслуживание операционной деятельности компании, различные файлы, в которых хранятся операционные данные (файлы могут быть различных форматов: csv, xlsx, txt, json, xml и т.д.), API внешних систем, IoT (интернет вещей) и др.

Примеры сервисов и инструментов на этом уровне: MySQL СУБД, Google Analytics, Facebook Ads, FTP/SFTP сервер, Salesforce, Kafka.

Data Processing Layer. Этот слой отвечает за обработку данных. Как раз здесь встречаются такие понятия, как ETL/ELT и data pipelines. Т.е., благодаря этому слою, осуществляется извлечение данных из источников, трансформация данных, движение данных и загрузка их в централизованный слой хранения данных.

Примеры сервисов и инструментов на этом уровне: Python и SQL, Apache Airflow, dbt, Pentaho Data Integration, Matillion ETL, Spark, AWS Glue, Azure Data Factory и др.

Storage Layer. Этот слой отвечает за централизованное хранение данных. Здесь появляются такие понятия как Data Warehouse (DWH), Data Lake и новомодное слово Lakehouse. Какое решение использует компания зависит от её задач. Например, если компании аналитическое решение нужно для конечной визуализации данных в BI-инструменте и для написания SQL-запросов к обработанным данным для поиска инсайтов, то достаточно будет использовать хранилище данных. Если у компании есть Data Science департамент, который строит ML-модели на основе данных для задач бизнеса, то разумным решением будет также использование Data Lake или Lakehouse, так как построение моделей требует обработки большого количества данных и для таких целей используется более сложный non-SQL код; Data Lake в таком случае является более гибким решением, так как обеспечивает быстрый прямой доступ к файлам.

Большим компаниям обычно нужен микс хранилища данных и озера данных, т.е., так называемая, Data Platform. Платформа данных как раз заточена на то, чтобы обслуживать и уровень BI-приложений и Data Science.

Примеры сервисов и инструментов на этом уровне: AWS S3, Azure Data Lake, Google Cloud Storage, AWS Redshift, Azure Synapse, Google BigQuery, HDFS (Hadoop), Vertica, Clickhouse и др.

Access Layer. Слой доступа к данным. Здесь в игру вступают BI-приложения, data-аналитики и data-сайнтисты, которые используют данные (уже находящиеся в Data Lake или DWH) для своих целей. В качестве приёмщика данных может также выступать база данных, которая обслуживает back-end интернет-магазина и позволяет показывать рекомендуемые товары на основе ML-моделей. В общем, этот слой является верхушкой айсберга, ради которой собственно и затевается построение всей системы.

Примеры сервисов и инструментов на этом уровне: Power BI, Tableau, AWS SageMaker, GCP AI Platform и др.

Переслано от Freaking Mind

Можно получить любой learning path на Databricks абсолютно бесплатно, если применить код "DB_CE" при чекауте.

https://academy.databricks.com/learning-paths

Доступны следующие треки:

Business Leader

Platform Admin

SQL Analyst

Data Engineer

Data Scientist

Так они стоят, вроде, $2000.

https://academy.databricks.com/learning-paths

Доступны следующие треки:

Business Leader

Platform Admin

SQL Analyst

Data Engineer

Data Scientist

Так они стоят, вроде, $2000.

2021 June 08

Умный дядька рассказывает как они делали крутые вещи много лет назад в FedEx и Netscape

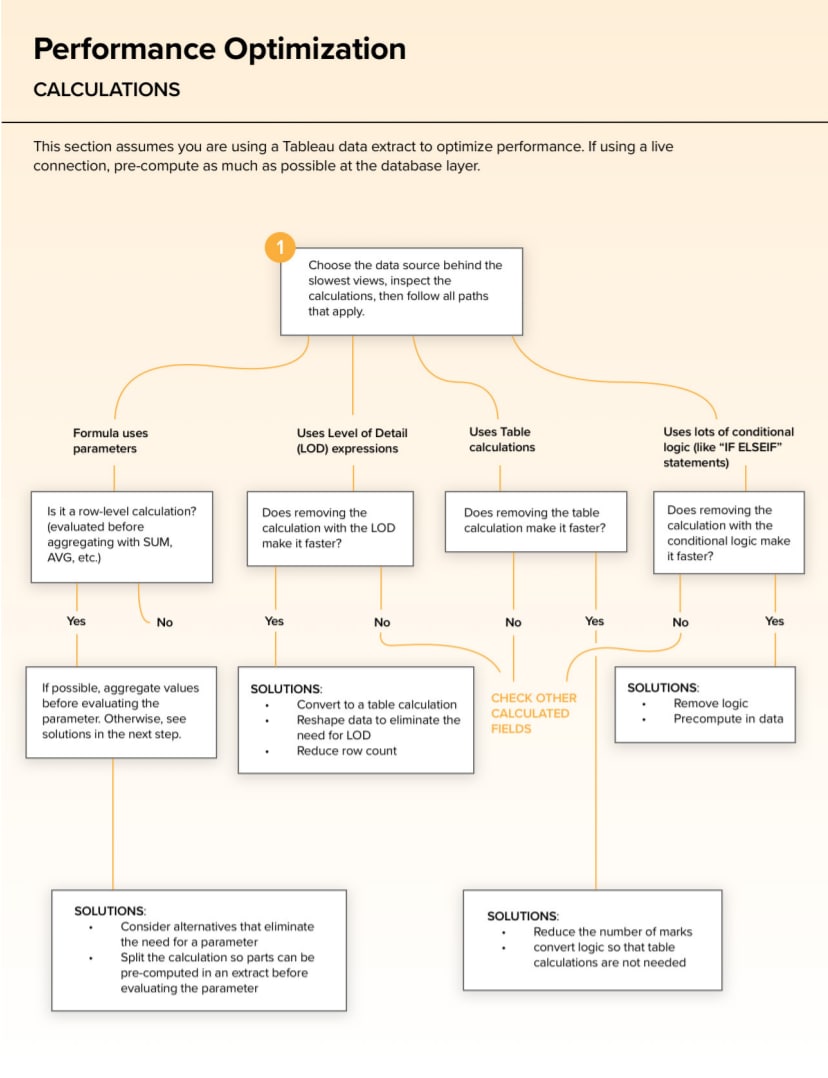

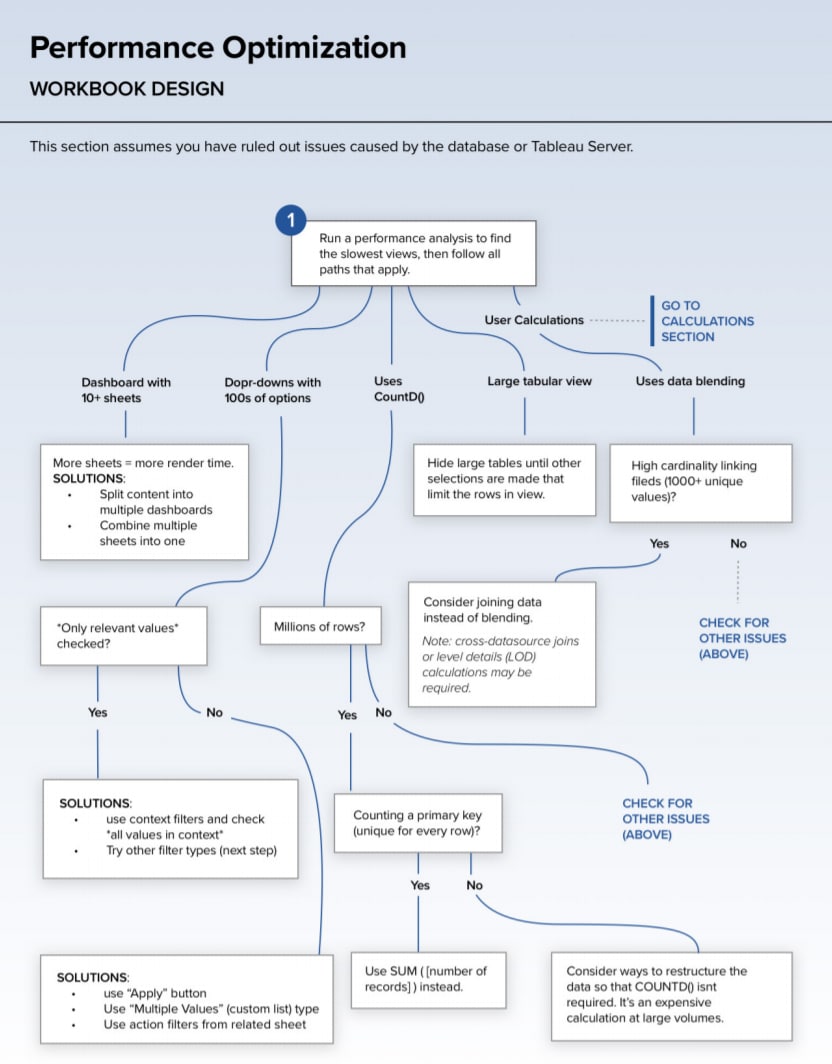

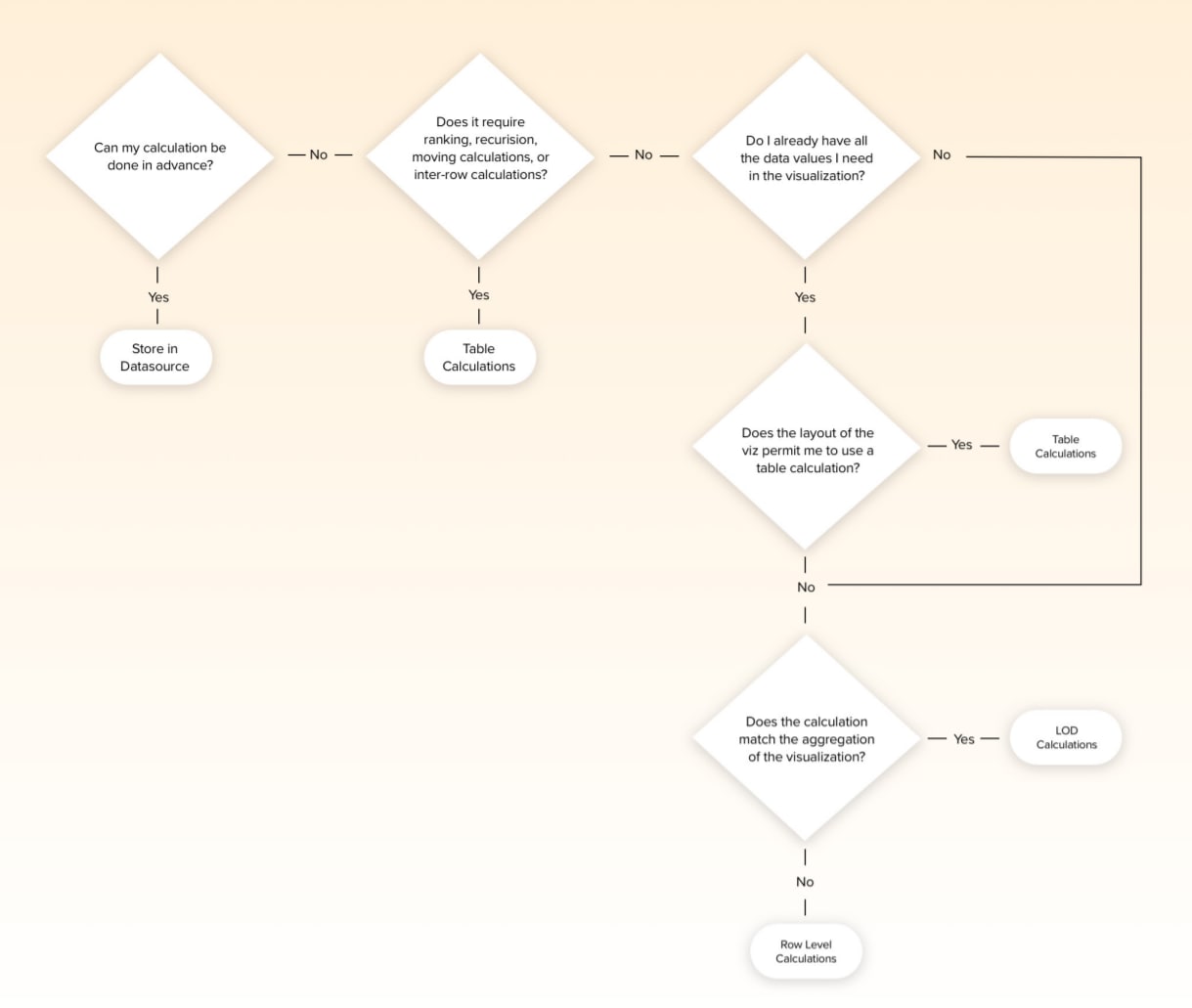

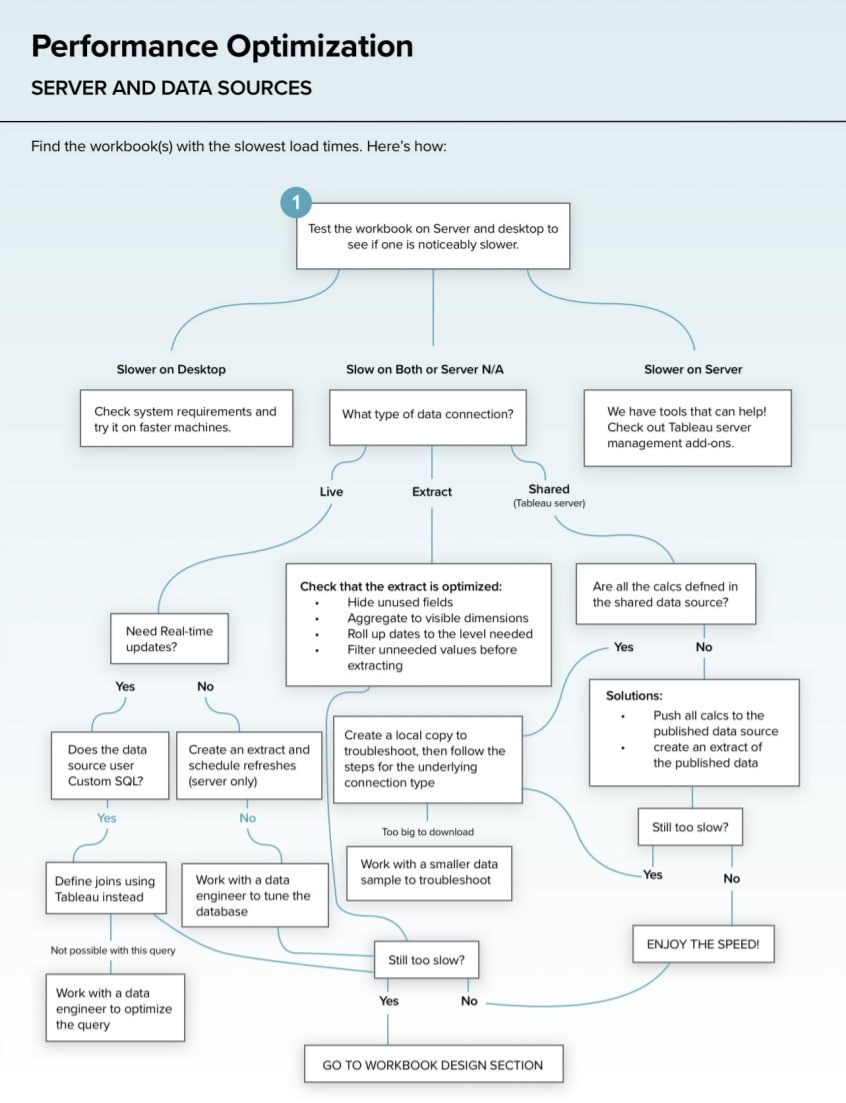

Давно хотел написать пост с небольшой подборкой видео про производительность и скорость загрузки в Табло, а тут такой отличный повод — Табло выложили классный документ про подходы по оптимизации рабочих книг. Мастхев для всех разработчиков Табло.

А вот материалы по этой теме, которые нашёл недавно:

— Свежая Tableau User Group Оклахома по теме производительности

— Детальный разбор какие запросы генерит Табло к БД и как это влияет на перформанс

— Рассказ про оптимизацию дашбордов и чит-шит на Табло Паблик

#ссылка

А вот материалы по этой теме, которые нашёл недавно:

— Свежая Tableau User Group Оклахома по теме производительности

— Детальный разбор какие запросы генерит Табло к БД и как это влияет на перформанс

— Рассказ про оптимизацию дашбордов и чит-шит на Табло Паблик

#ссылка

через 10 минут начинаем:

https://youtu.be/gBq5XarMhfM

https://youtu.be/gBq5XarMhfM

2021 June 09

2021 June 10

Топ 10 анонсов (на самом деле 11) с конференции Data+AI (databricks)

- Delta Lake 1.0 (Полноценное DWH на озере данных)

- Delta Sharing (догоняют Snowflake с их фичей Data Sharing?)

- Delta Live Tables (удобство ETL)

- Early Release: Delta Lake Definitive Guide by O’Reilly (Книга про Delta Lake, уже присылал вам)

- Unity Catalog (каталог данных, must have для любого проекта)

- Databricks SQL: improved performance, administration and analyst experience (SQL наше все!)

- Lakehouse momentum (Lakehouse подход сейчас самый популярный подход в мировых компаниях, рецепт просто: DW+Data Lake + Cloud Computing)

- Koalas is being merged into Apache Spark (Koalas это как pandas на стероидах)

- Machine Learning Dashboard (разделили workspace для ML и DE)

- Machine Learning Feature Store (про feature store мы не раз тут обсуждали, нужная и удобная штука)

- AutoML with reproducible trial notebooks (надо быть в тренде!)

- Delta Lake 1.0 (Полноценное DWH на озере данных)

- Delta Sharing (догоняют Snowflake с их фичей Data Sharing?)

- Delta Live Tables (удобство ETL)

- Early Release: Delta Lake Definitive Guide by O’Reilly (Книга про Delta Lake, уже присылал вам)

- Unity Catalog (каталог данных, must have для любого проекта)

- Databricks SQL: improved performance, administration and analyst experience (SQL наше все!)

- Lakehouse momentum (Lakehouse подход сейчас самый популярный подход в мировых компаниях, рецепт просто: DW+Data Lake + Cloud Computing)

- Koalas is being merged into Apache Spark (Koalas это как pandas на стероидах)

- Machine Learning Dashboard (разделили workspace для ML и DE)

- Machine Learning Feature Store (про feature store мы не раз тут обсуждали, нужная и удобная штука)

- AutoML with reproducible trial notebooks (надо быть в тренде!)

У нас уже готово 2ое интервью - DATALEARN | ИНТЕРВЬЮ С ЕВГЕНИЙ РЕБРИКОВОЙ (МЕНЕДЖЕР ПО АНАЛИТИКЕ В "БАЛТИКА"

от нашего сообщества “Women in data” (можно добавиться в отдельный канал slack).

Если вы пропустили прошлое интервью, то вот ссылка - DATALEARN | ИНТЕРВЬЮ С КСЕНИЕЙ ПЕВЗНЕР, РУКОВОДИТЕЛЬ МАРКЕТИНГОВОЙ АНАЛИТИКИ ОНЛАЙН КИНОТЕАТРА ОККО

PS Какие же девушки крутые! 💪🚀

от нашего сообщества “Women in data” (можно добавиться в отдельный канал slack).

Если вы пропустили прошлое интервью, то вот ссылка - DATALEARN | ИНТЕРВЬЮ С КСЕНИЕЙ ПЕВЗНЕР, РУКОВОДИТЕЛЬ МАРКЕТИНГОВОЙ АНАЛИТИКИ ОНЛАЙН КИНОТЕАТРА ОККО

PS Какие же девушки крутые! 💪🚀

В тему про безопасность данных в облаке https://www.wired.com/story/dating-apps-leak-explicit-photos-screenshots