k

Size: a a a

2019 September 25

Radik

да тупо как нфс

через FUSE? - ну так не интересно :-/

R

через FUSE? - ну так не интересно :-/

ну, видимо других вариантов нет

R

а хочется в авс)

i

через FUSE? - ну так не интересно :-/

А FUSE не так уж и плох, sshfs например гигабит точно может утилизировать

2019 September 26

c

А FUSE не так уж и плох, sshfs например гигабит точно может утилизировать

А что будет когда лагнёт сеть?

i

А что будет когда лагнёт сеть?

Трансфер заикнётся, и может упасть по таймауту. Если бзик несколько секунд, то работает дальше. Тут всё от SFTP-сервера зависит

DN

А что будет когда лагнёт сеть?

Вангую LA до неба

DN

И какой нить процесс в D state

VM

Всем добрый вечер!

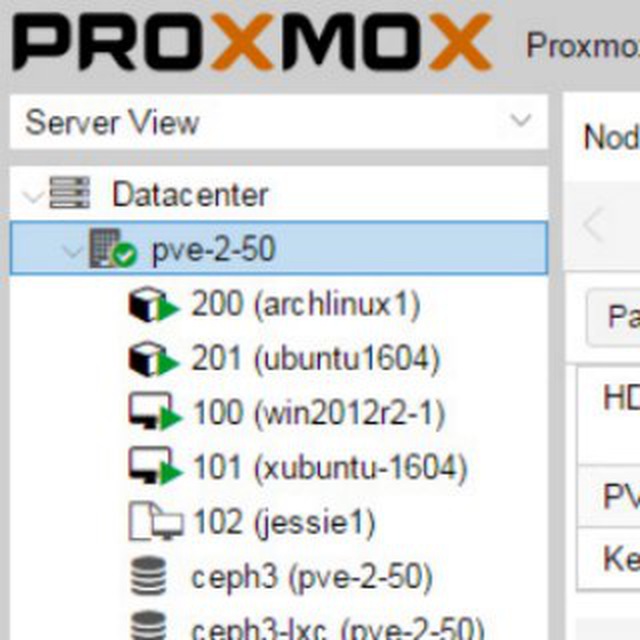

Ехал вот и читал про кластеры, думал) а виртуалки можно как то в кластер объединить, то бишь на разных физ машинах сделать виртуалки с единым хранилищем?)

Ехал вот и читал про кластеры, думал) а виртуалки можно как то в кластер объединить, то бишь на разных физ машинах сделать виртуалки с единым хранилищем?)

Технически ноу проблем, но вопрос зачем? Если для тестов и лаб, то я использую vmware workstation с nested virtualization а внутри кручу что надо - прокс, hyper-v, esxi. Если в продакшн, то тут все немного по другому - стараются кластеризировать не виртуалки а сервисы, но для этого обычно используют другие решения, а не 100% те же что и для кластеризации хостов. Все исходит из задач. Дело в том что когда мы кластеризируем например физические ноды (ну вот кластер виртуализации, для запуска виртуальных машин предоставляющих различные сервисы) мы по сути создаем тип кластера High Available (HA), этот тип кластера не подразумевает полную защиту от сбоев. Он подразумевает высокую доступность, т.е. доступность сервисов предоставляемых класетром с высокой долей возможности запуска после сбоя. Т.е. грубо говоря, при падении ноды на которой крутится виртуалка, виртуалка автоматически стартует на другой доступной ноде при наличии кворума в кластере, но при этом на момент сбоя и до момента автоматического запуска доступ к сервисам предоставляемым виртуалкой останавливается, данные в памяти виртуалки теряются, с возможной потерей части данных которые не были записаны на диск во время сбоя. Многие изначально считают, что кластер (в том числе и вируализации) это Fail Over кластер. Но это не так. Вот как раз фейловер подразумевает отсутсвие простоев во время сбоя, но на текущий момент вменяемых решений Fail Over для той же виртуализации я не знаю (ну там конечно vmware пыталась, но это все дорого и сложно). А вот для сервисов фейловер и есть основное решение. Ну яркий пример это MS SQL AlwaysON - когда есть несколько узлов с запущенным инстансом MS SQL Server, узлы не кластеризированны никак, а вот сами инстансы (сервисы) MS SQL объеденены в фейловер кластер посредством технологии AlwaysOn, т.е. при сбое узла на который идет сейчас запись, сервис не теряется, и продолжает работать в штатном режиме - запись, чтение. Поэтому физические узлы стараются кластеризировать и обеспечить высокую доступность, а вот сервисам стараются обеспечить именно фейловер - т.е. полную доступность при любых сбоях. Например абсолютно нормально иметь решение состоящее из стендэлоун узлов виртуализации, ну никак не использующих общие ресурсы, но при этом иметь фейловер решения для сервисов которые крутятся внутри виртуалок расположенных на разных нода, и таки это решение убдет надежнее HA кластера виртуализации в котором крутится виртуалка с сервисом без феловера. Но тут есть ньюанс, не все сервисы можно реализовать как фейловер решение. Немного сумбурно но как то так. Хотя мнения могут отличаться. Так что добавлю - это не точно =)

DY

ну на голом кластер строить довольно специфическая работа.

для этого есть куча готовой автоматизации, когда я в опенстаке в шапке работал, с полпинка поднимали тестовые кластеры на виртуалках под либвиртом со всеми наворотами

DY

Vladimir Manko

Технически ноу проблем, но вопрос зачем? Если для тестов и лаб, то я использую vmware workstation с nested virtualization а внутри кручу что надо - прокс, hyper-v, esxi. Если в продакшн, то тут все немного по другому - стараются кластеризировать не виртуалки а сервисы, но для этого обычно используют другие решения, а не 100% те же что и для кластеризации хостов. Все исходит из задач. Дело в том что когда мы кластеризируем например физические ноды (ну вот кластер виртуализации, для запуска виртуальных машин предоставляющих различные сервисы) мы по сути создаем тип кластера High Available (HA), этот тип кластера не подразумевает полную защиту от сбоев. Он подразумевает высокую доступность, т.е. доступность сервисов предоставляемых класетром с высокой долей возможности запуска после сбоя. Т.е. грубо говоря, при падении ноды на которой крутится виртуалка, виртуалка автоматически стартует на другой доступной ноде при наличии кворума в кластере, но при этом на момент сбоя и до момента автоматического запуска доступ к сервисам предоставляемым виртуалкой останавливается, данные в памяти виртуалки теряются, с возможной потерей части данных которые не были записаны на диск во время сбоя. Многие изначально считают, что кластер (в том числе и вируализации) это Fail Over кластер. Но это не так. Вот как раз фейловер подразумевает отсутсвие простоев во время сбоя, но на текущий момент вменяемых решений Fail Over для той же виртуализации я не знаю (ну там конечно vmware пыталась, но это все дорого и сложно). А вот для сервисов фейловер и есть основное решение. Ну яркий пример это MS SQL AlwaysON - когда есть несколько узлов с запущенным инстансом MS SQL Server, узлы не кластеризированны никак, а вот сами инстансы (сервисы) MS SQL объеденены в фейловер кластер посредством технологии AlwaysOn, т.е. при сбое узла на который идет сейчас запись, сервис не теряется, и продолжает работать в штатном режиме - запись, чтение. Поэтому физические узлы стараются кластеризировать и обеспечить высокую доступность, а вот сервисам стараются обеспечить именно фейловер - т.е. полную доступность при любых сбоях. Например абсолютно нормально иметь решение состоящее из стендэлоун узлов виртуализации, ну никак не использующих общие ресурсы, но при этом иметь фейловер решения для сервисов которые крутятся внутри виртуалок расположенных на разных нода, и таки это решение убдет надежнее HA кластера виртуализации в котором крутится виртуалка с сервисом без феловера. Но тут есть ньюанс, не все сервисы можно реализовать как фейловер решение. Немного сумбурно но как то так. Хотя мнения могут отличаться. Так что добавлю - это не точно =)

кластеризуют не виртуалки а сервисы, верно. А еще кластеризуют гипервизоры, чтоб сами виртуалки могли получить миграцию, HA и прочие плюшки.

VM

кластеризуют не виртуалки а сервисы, верно. А еще кластеризуют гипервизоры, чтоб сами виртуалки могли получить миграцию, HA и прочие плюшки.

Ну тут опять же , всякие плюшки можно получить и без кластеризации, ну ту же лайф миграцию (hyper-v например это умеет). Смысл кластеризации физических узлов это конечно высокая доступность - HA (или высокая производительность если это HP - high performance - тот же ТОП 500 суперкомпов), ну а сервисов это полная отказоустойчивость, т.е. FO.

VM

Поэтому нет смысла кластеризировать виртуалки, надо обеспечивать отказоустойчивость сервисов внутри виртуалок.

VM

Опять же - не всегда failover достигается кластеризацией того или иного типа - например зеркалирование, вот тут недавно drbd обсуждали, оно как раз зеркалирует, в принципе как и в примере выше делает ms sql alwayson.

VM

Вообще в понятиях HA и FO целая путаница. Вот например майкрософт называет свой hyper-v кластер FailOver, но он нифига не FailOver, он всего лишь HA - high available, потому что подвержен тем же проблемам что и все кластера виртуализации при сбое ноды - потеря данных и временная красткосрочная недосутпность виртуалки и ее сервисов.

VR

Тут больше вопрос для чего человеку это всё.

VM

Тут больше вопрос для чего человеку это всё.

Так вот я ответил, что бы он не ломал себе голову. Не надо кластеризировать виртуалки, это бесполезно если они куртятся на одном узле, и бесмысслено если в кластере виртуализации, надо фейловерить сервисы внутри виртуалок.

VM

Ну только если не собирать лабу для тестов =) Но и про это я упомянул.

k

поэтому виртуалки - не нужны. как и прочее 🙂

VR

Вчера ещё выяснили что учится