SМ

Size: a a a

2021 April 16

У меня все норм было

SМ

Я скоро обновлю наш репо с билдом локальным тф берт под 2+

SМ

И поделюсь тут)

SМ

Всем добра

E

да, было бы круто

🐙

Привет! Пытаюсь в генерацию текста с помощью LSTM сеточки (tf, keras) (чисто ради попробовать-поучиться). Скомпилировал пару туториалов на англ. под свой корпус на русском и качество не очень, и потому есть вопросы:

1) Посимвольная генерация - норм? В одном из туториалов была генерация по токенам, а мой словарь получился на 5 млн где-то - многовато.

2) Количество примеров и продолжительность обучения: учу на CPU, прогоняю 1-2 тысячи (2-5 средних абзацев) по 5 эпох. Насколько это неадекватно мало для того, чтобы ожидать нормальный результат? Есть советы, что в первую очередь поменять - снизить количество текстов и уменьшить количество эпох, или наоборот?

1) Посимвольная генерация - норм? В одном из туториалов была генерация по токенам, а мой словарь получился на 5 млн где-то - многовато.

2) Количество примеров и продолжительность обучения: учу на CPU, прогоняю 1-2 тысячи (2-5 средних абзацев) по 5 эпох. Насколько это неадекватно мало для того, чтобы ожидать нормальный результат? Есть советы, что в первую очередь поменять - снизить количество текстов и уменьшить количество эпох, или наоборот?

DD

Посимвольная генерация норм, но SOTA подходы используют BPE словари размера в несколько тысяч или десятков тысяч сабтокенов.

Количество текстов однозначно надо повышать, чем больше обучающая выборка тем лучше.

Количество эпох можно определять по лоссу на валидационной выборке.

Количество текстов однозначно надо повышать, чем больше обучающая выборка тем лучше.

Количество эпох можно определять по лоссу на валидационной выборке.

🐙

А что в такой задаче валидационная выборка и лосс?

Я по факту предикт после фита ни с чем не сравниваю, просто беру аргмакс индексы токенов.

Я по факту предикт после фита ни с чем не сравниваю, просто беру аргмакс индексы токенов.

🐙

Ну и больше текстов конечно хорошо, но у меня тут скорее два стула, и 1 эпоха учится 4 часа.

DD

Валидационную выборку нужно случайным образом отделить от тестовой.

Лосс - это видимо cross-entropy, который ты минимизируешь и при обучении.

Лосс - это видимо cross-entropy, который ты минимизируешь и при обучении.

DD

Если время ограничено, тогда лучше больше текстов и меньше эпох

🐙

Благодарю за помощь 👍

E

Добрый день! А кто нибудь работал с библиотекой Pullenti для c#?

Как выбирать связи между объектами?

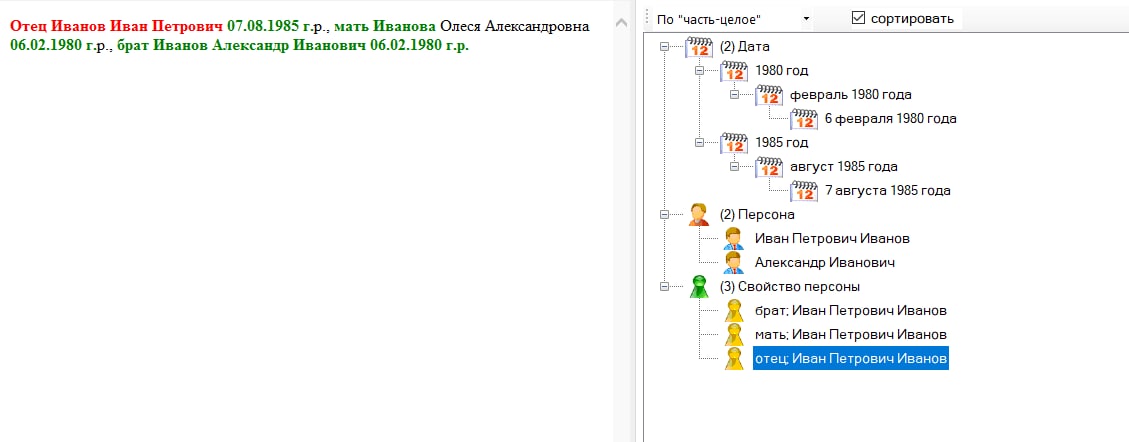

string text = "Отец Иванов Иван Петрович 1898 года рождения, Мать Иванова Олеся Петровна 1980 г.р.";

Например что год рождения относится к маме или отцу.

В демо-приложении Pullenti.TestDesk.exe отлично показывается но там нету примеров)

Как выбирать связи между объектами?

string text = "Отец Иванов Иван Петрович 1898 года рождения, Мать Иванова Олеся Петровна 1980 г.р.";

Например что год рождения относится к маме или отцу.

В демо-приложении Pullenti.TestDesk.exe отлично показывается но там нету примеров)

E

И можно ли как то данные отношения настраивать?

E

И как победить такое что не распознает разных персон

MK

Я игрался с посимвольной генерацией c LSTM. Обучал модель на Евгении Онегине, работало норм, сетка очень быстро выучила всего Евгения Онегина и с "Однажды в студёную зимнюю пору" очень быстро переходила на Пушкина. Учил на GPU, но не долго, как помню.

E

И какой вообще лучший инструмент на текущий момент для выделения отношений, и сущностей как например:

" Отец Иванов Иван Петрович 07.08.1985 г.р., мать Иванова Олеся Александровна 06.02.1980 г.р., брат Иванов Александр Иванович 03.04.1981 г.р."

Сейчас тестирую Pullenti. Очень плохо определяет если слово "Отец" или "Мать" в начале блока.

Если в конце - то прям всё как надо распознает

" Отец Иванов Иван Петрович 07.08.1985 г.р., мать Иванова Олеся Александровна 06.02.1980 г.р., брат Иванов Александр Иванович 03.04.1981 г.р."

Сейчас тестирую Pullenti. Очень плохо определяет если слово "Отец" или "Мать" в начале блока.

Если в конце - то прям всё как надо распознает

KS

Ну этот вопрос решить несложно - нужно сообщить разработчику, прислав примеры неправильных выделений, и всё будет исправлено.

E

Так ведь кажется разработчик в чате)))