N

Size: a a a

2021 March 24

(да, там многоязычный сеттинг, но суть такая — берём лемму и нужные признаки формы, воссоздаём форму)

КМ

а вот тут "из готовых решений нашёл только для английского"

а что это за штука?

а что это за штука?

вот еще нашел

https://github.com/neuspell/neuspell

https://github.com/neuspell/neuspell

A

вот еще нашел

https://github.com/neuspell/neuspell

https://github.com/neuspell/neuspell

типа ему можно подсунуть берта?

надо попробовать)

надо попробовать)

КМ

типа ему можно подсунуть берта?

надо попробовать)

надо попробовать)

у меня больше доверия вызывает идея Давида, но для сравнения так сказать)

TI

Добрый день!

Скажите, пожалуйста, нам для проекта нужно запустить LaserTagger. Для этого мы предобучили BERT в PyTorch, но LaserTagger, кажется, с ним совсем не дружит. Никто не сталкивался с подобным?

Скажите, пожалуйста, нам для проекта нужно запустить LaserTagger. Для этого мы предобучили BERT в PyTorch, но LaserTagger, кажется, с ним совсем не дружит. Никто не сталкивался с подобным?

IN

Добрый день!

Скажите, пожалуйста, нам для проекта нужно запустить LaserTagger. Для этого мы предобучили BERT в PyTorch, но LaserTagger, кажется, с ним совсем не дружит. Никто не сталкивался с подобным?

Скажите, пожалуйста, нам для проекта нужно запустить LaserTagger. Для этого мы предобучили BERT в PyTorch, но LaserTagger, кажется, с ним совсем не дружит. Никто не сталкивался с подобным?

Предобученная модель в формате pytorch_model.bin, а LaserTaggger ест чекпойнты TensorFlow...

ИИ

Всем здравствуйте, нужен совет.

Cейчас ищу библиотечки/статьи по методам исправления контекстуальных ошибок для русского языка (когда род, спряжение, склонения нееправильные в предложении).

Из готовых решений нашел только для английского.

Посоветуйте какие-нибудь библиотеки, статьи, репы, подходы пожалуйста)

Сам думал сделать что-то на трансформерах, тк по опыту всякие марковские модели работают похуже чем нейронки. Например, взять корпус текста, токенизировать, с помощью pymorphy2 изменить форму слова, склонение, род и на этом обучить seq2seq.

Cейчас ищу библиотечки/статьи по методам исправления контекстуальных ошибок для русского языка (когда род, спряжение, склонения нееправильные в предложении).

Из готовых решений нашел только для английского.

Посоветуйте какие-нибудь библиотеки, статьи, репы, подходы пожалуйста)

Сам думал сделать что-то на трансформерах, тк по опыту всякие марковские модели работают похуже чем нейронки. Например, взять корпус текста, токенизировать, с помощью pymorphy2 изменить форму слова, склонение, род и на этом обучить seq2seq.

Привет ! Если получилось найти решение / информацию поделись пожалуйста 🙏

2021 March 25

SM

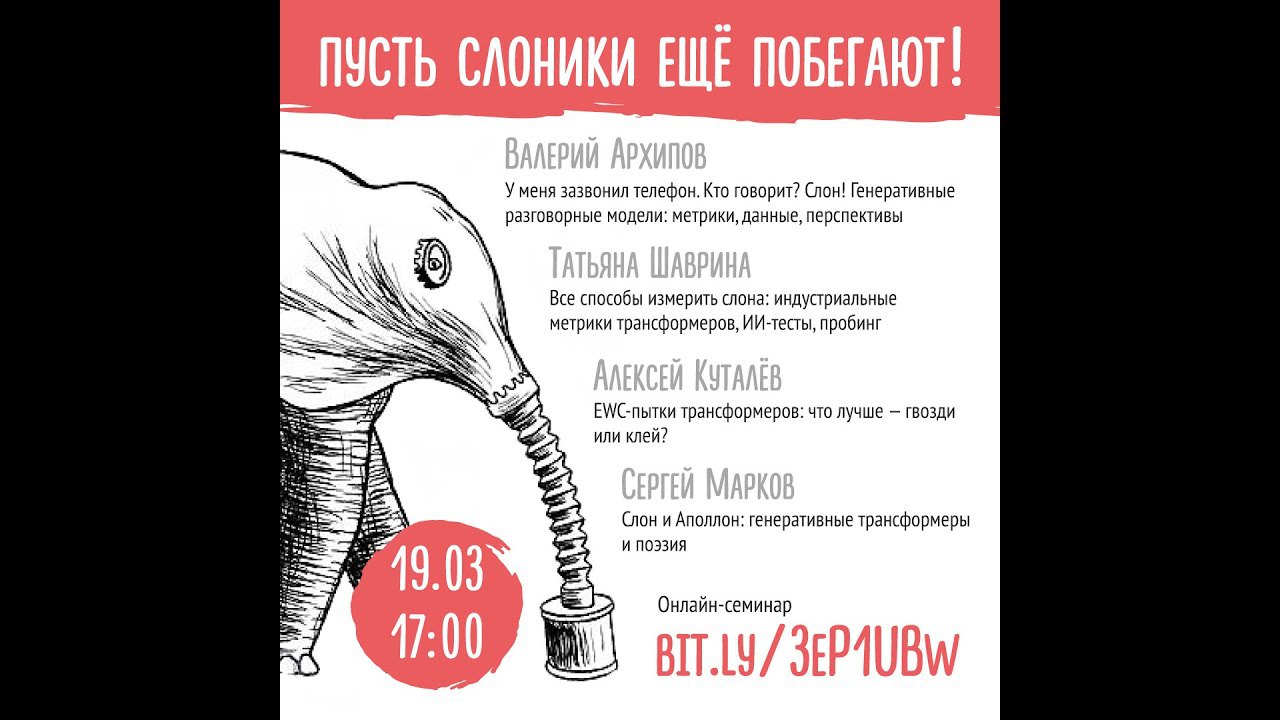

Ссылка на запись семинара: https://www.youtube.com/watch?v=RqPW2E6PhTk

В описании видео слайды и дополнительные материалы.

В описании видео слайды и дополнительные материалы.

И

Привет. С помощью spacy векторизовал (token.vector) датасет (корпус с русскоязычными предложениями с метками [0,1]), для каждого токена получился вектор размерностью 96. Предложение - список векторов. Есть многослойный перцептрон. Как правильно использовать это для задачи классификации? Вычислять выходной слой для каждого токена(вектора), суммируя\умножая результат (что-бы получить результат для целого предложения), или как-то по другому?

Е

Привет. С помощью spacy векторизовал (token.vector) датасет (корпус с русскоязычными предложениями с метками [0,1]), для каждого токена получился вектор размерностью 96. Предложение - список векторов. Есть многослойный перцептрон. Как правильно использовать это для задачи классификации? Вычислять выходной слой для каждого токена(вектора), суммируя\умножая результат (что-бы получить результат для целого предложения), или как-то по другому?

Перед тем, как подаёшь на вход full-connected слоям, нужно получить один вектор/тезор фиксированного размера. Можно сложить/усреднить вложения токенов. Можно склеить все вложения токенов в один вектор, но тогда нужно добивать/обрезать до фиксированного размера. Можно после векторизации слов добавить слой RNN/LSTM/CNN, а результат уже подавать на полносвязанные слои.

NL

Всем привет

Подскажите, пожалуйста, как собрать вывод дерева синтаксиса Наташи с помощью

Встроенный метод

Заранее спасибо

Upd: проблема решилась перенаправлением потока вывода (https://stackoverflow.com/a/25623929), вопрос снят, спасибо)

Подскажите, пожалуйста, как собрать вывод дерева синтаксиса Наташи с помощью

ipymarkup'а в строку для дальнейшего вывода в ui?Встроенный метод

print() выводит в консоль дерево с помощью функции show_dep_ascii_markup, не возвращая строку, а мне нужно сохранить этот лог в строкуЗаранее спасибо

Upd: проблема решилась перенаправлением потока вывода (https://stackoverflow.com/a/25623929), вопрос снят, спасибо)

d

Как вы, в зависимости от размеров вашего датасета, определяете, до каких пор (с учетом аккумуляции градиента) следует наращивать размер батча?

E

Как вы, в зависимости от размеров вашего датасета, определяете, до каких пор (с учетом аккумуляции градиента) следует наращивать размер батча?

что значит, наращивать размер?

КМ

Как вы, в зависимости от размеров вашего датасета, определяете, до каких пор (с учетом аккумуляции градиента) следует наращивать размер батча?

До того как видюха скажет "Многа данных, мне тяжело, памяти не хватает, памагити"

SK

До того как видюха скажет "Многа данных, мне тяжело, памяти не хватает, памагити"

Жиза 😂

DD

До того как видюха скажет "Многа данных, мне тяжело, памяти не хватает, памагити"

Насколько я понял, вопрос был про скорее про то, сколько батчей подряд нужно аккумулировать градиент.

К сожалению, лично у меня ответа нету.

Я сам обычно аккумулирую градиент так, чтобы на один градиентный шаг приходилось хотя бы несколько десятков примеров, но у меня нет убедительного обоснования, почему делать так надо.

К сожалению, лично у меня ответа нету.

Я сам обычно аккумулирую градиент так, чтобы на один градиентный шаг приходилось хотя бы несколько десятков примеров, но у меня нет убедительного обоснования, почему делать так надо.

2021 March 26

NS

Всем привет.

Подскажите, пожалуйста, какие-нибудь хорошие решения, библиотеки или нейронки для сегментации на предложения "сырого" русского текста без какой-либо пунктуации, и мб также ещё библиотеки для восстановления пунктуации в таком тексте.

Подскажите, пожалуйста, какие-нибудь хорошие решения, библиотеки или нейронки для сегментации на предложения "сырого" русского текста без какой-либо пунктуации, и мб также ещё библиотеки для восстановления пунктуации в таком тексте.

AO

Для русского можно сделать по аналогии как для английского через bert :

https://docs.nvidia.com/deeplearning/nemo/user-guide/docs/en/main/nlp/punctuation_and_capitalization.html

https://docs.nvidia.com/deeplearning/nemo/user-guide/docs/en/main/nlp/punctuation_and_capitalization.html

AM

Всем привет. Скажите, а в spacy не появились noun chunks для русского еще?