M

Size: a a a

2021 March 08

Это вроде не совсем то. Я уже трансформировал модель в onnx используя интерфейс transformers. Я хотел использовать оптимизитор моделей (https://pypi.org/project/onnxruntime-tools/), но выглядит что он работает только с бертом и gpt2

A

Any good NLP book ? ( something like springer Elements or ISLR ...)

IS

Mark

Это вроде не совсем то. Я уже трансформировал модель в onnx используя интерфейс transformers. Я хотел использовать оптимизитор моделей (https://pypi.org/project/onnxruntime-tools/), но выглядит что он работает только с бертом и gpt2

Ну, этот пакет, насколько я понимаю, тоже делает экспорт в ONNX.

Можно попробовать так: сначала квантизовать Электру, а потом экспортировать в ONNX, получится, то же самое.

И, может тут что-то найдёте - Микрософт сравнительно недавно выложил примеры использования ONNX: https://www.onnxruntime.ai/

Можно попробовать так: сначала квантизовать Электру, а потом экспортировать в ONNX, получится, то же самое.

И, может тут что-то найдёте - Микрософт сравнительно недавно выложил примеры использования ONNX: https://www.onnxruntime.ai/

KK

скидывай ишьюсом в corus

хорошо, попробую...

Е

Добрый вечер. Не могли бы вы, пожалуйста, подсказать в следующей задаче:

Есть несколько моделей для поиска именованных сущностей (например, только организаций). Есть одни модели с наилучшей прецизиозностью, а другие с наилучшей полнотой.

Отсюда вопрос: можно ли получить лучший результат (F-мера), если каким-то способом ансамблировать две модели (например с наилучшими precision и recall) ? Быть может просто пересечь их результаты.

Есть какие-то исследования, статьи или просто практический опыт по проверке такой методики ?

Есть несколько моделей для поиска именованных сущностей (например, только организаций). Есть одни модели с наилучшей прецизиозностью, а другие с наилучшей полнотой.

Отсюда вопрос: можно ли получить лучший результат (F-мера), если каким-то способом ансамблировать две модели (например с наилучшими precision и recall) ? Быть может просто пересечь их результаты.

Есть какие-то исследования, статьи или просто практический опыт по проверке такой методики ?

A

Я получал наилучшие результаты с помощью трёх моделей обученных на разных датасетах. Если минимум две выделяли одинаковую сущность, то данная сущность считалась корректной. Точность возрастала серьезно (+7-12%). Полнота в таком случае получалась примерно средней полноте по 3 моделям.

Е

Я получал наилучшие результаты с помощью трёх моделей обученных на разных датасетах. Если минимум две выделяли одинаковую сущность, то данная сущность считалась корректной. Точность возрастала серьезно (+7-12%). Полнота в таком случае получалась примерно средней полноте по 3 моделям.

Понял. А вы сравнивали с другими способами комбинирования моделей ?

A

С другими результатами комбинирования не сравнивалось. Только с показателями каждой отдельной модели проводилось сравнение.

Е

Большое спасибо

2021 March 09

E

Доброе утро! Подскажите, пожалуйста, какие есть инструменты/подходы для преобразования вопроса с несколькими вариантами ответа ("Какую оценку получил Вася на экзамене?" "Пятёрку" "Четвёрку" "Тройку" "Двойку") в набор вопросов с вариантами ответа да/нет ("Вася на экзамене получил пятёрку?" "Вася на экзамене получил четвёрку?" ...).

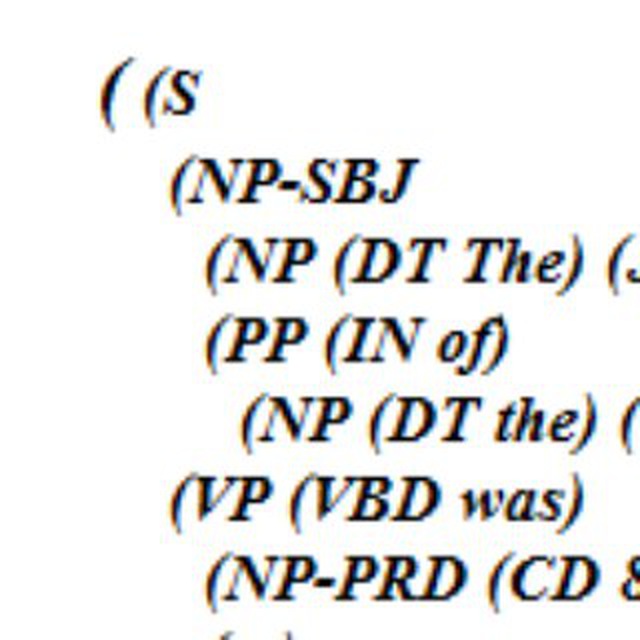

На ум приходит примерно такой подход: выполнить синтаксический разбор вопроса; на его основе по некоему набору правил сформировать вопросы по вариантам ответа.

Выглядит сложновато и не особо конкретно. :-(

На ум приходит примерно такой подход: выполнить синтаксический разбор вопроса; на его основе по некоему набору правил сформировать вопросы по вариантам ответа.

Выглядит сложновато и не особо конкретно. :-(

N

не сложновато как раз

E

Natalia

не сложновато как раз

думаете, стоит так попробовать?

N

ну я не думаю, это довольно очевидный подход. всякие DL-модели нужны обычно там, где как раз ответы не заданы, а если задача очевидно в сопоставлении двух сегментов с одинаковой синт. функцией, то зачем усложнять

N

но всегда всё зависит от ваших данных

RA

Ребзь, всем привет! Подскажите годный спелл корекшн для русского и английского языка, скорость работы в приоритете. Нужно примерно за 5-7 минут прогнать 50к предложений

AK

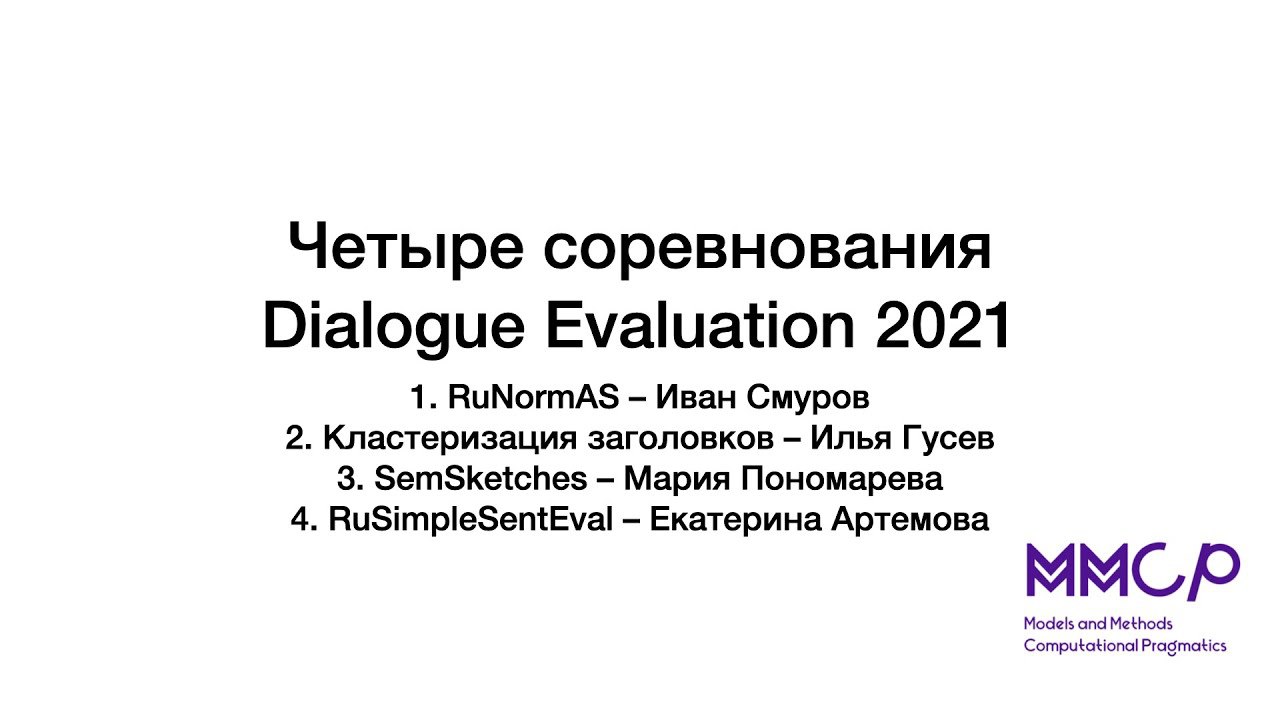

Доклады про соревнования на Диалоге https://www.youtube.com/watch?v=PlNg1u5VEmo. Начинать участвовать уже поздновато, полезно знать про новые датасеты на русском, интересно в конце сорев почитать про топовые решения.

- Почему нормализация именованных сущностей сложнее, чем просто лемматизация. Natasha как бейзлайн

- Кластеризация новостей, выбор заголовков. B2C делают агрегаторы Яндекс, Гугл, Рамблер, Мейл, Сми2. B2B делают мониторинги типа Медиалогии

- Семантические скетчи звучит пугающе, задача научная сложная, практического приложения не видно.

- Как собрать датасет для симплификации. Большой грязный: упрощённая Вики, гугловый перевод. Маленький вручную собранный на Толоке.

- Почему нормализация именованных сущностей сложнее, чем просто лемматизация. Natasha как бейзлайн

- Кластеризация новостей, выбор заголовков. B2C делают агрегаторы Яндекс, Гугл, Рамблер, Мейл, Сми2. B2B делают мониторинги типа Медиалогии

- Семантические скетчи звучит пугающе, задача научная сложная, практического приложения не видно.

- Как собрать датасет для симплификации. Большой грязный: упрощённая Вики, гугловый перевод. Маленький вручную собранный на Толоке.

KA

Доклады про соревнования на Диалоге https://www.youtube.com/watch?v=PlNg1u5VEmo. Начинать участвовать уже поздновато, полезно знать про новые датасеты на русском, интересно в конце сорев почитать про топовые решения.

- Почему нормализация именованных сущностей сложнее, чем просто лемматизация. Natasha как бейзлайн

- Кластеризация новостей, выбор заголовков. B2C делают агрегаторы Яндекс, Гугл, Рамблер, Мейл, Сми2. B2B делают мониторинги типа Медиалогии

- Семантические скетчи звучит пугающе, задача научная сложная, практического приложения не видно.

- Как собрать датасет для симплификации. Большой грязный: упрощённая Вики, гугловый перевод. Маленький вручную собранный на Толоке.

- Почему нормализация именованных сущностей сложнее, чем просто лемматизация. Natasha как бейзлайн

- Кластеризация новостей, выбор заголовков. B2C делают агрегаторы Яндекс, Гугл, Рамблер, Мейл, Сми2. B2B делают мониторинги типа Медиалогии

- Семантические скетчи звучит пугающе, задача научная сложная, практического приложения не видно.

- Как собрать датасет для симплификации. Большой грязный: упрощённая Вики, гугловый перевод. Маленький вручную собранный на Толоке.

Спасибо! Насколько я понимаю, на всех соревнованиях сейчас будут продлевать сроки, так что присоединиться не поздно :)

KA

Семантические скетчи можно воспринимать как бертологию, что непрактично, но полезно :)