Вы правы, тренировочные данные действительно для НЕР, но ведь нлп объект так же включает в себя токенизацию, лемматизацию, пос, депенданси и прочее, необходимое для тренировки NER.

Как, в таком случае, получить полный набор?

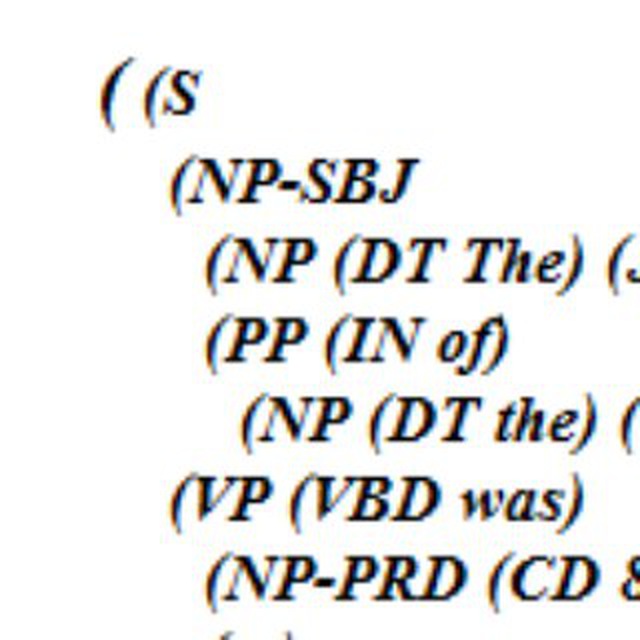

doc = nlp(text)

tags = offsets_to_biluo_tags(doc, entities_cleared)

entities_x = biluo_tags_to_spans(doc, tags)

doc.ents = entities_x

gold_docs.append(doc)

DocBin(docs=gold_docs).to_disk("train_file.spacy")

Здесь докбин сохраняет вместе с остальным?

nlp, являющийся объектом Language необязательно содержит все эти свойства, Вы можете создать модель с нуля, например и оставить там только токенизацию и НЕР, для НЕР эти зависимости не обязательны. Если вы доучиваете готовую модель с частями речи и зависимостями , параметры этих объектов не изменяются, но скорее всего используются при обучении, а обучается только модуль ner модели spacy. Надеюсь меня поправят более знающие товарищи, если я ошибся. Пишу как понимаю