AK

Size: a a a

2020 July 08

В том же spaCy имеется свойство токена ancestors. Позволяет выявить полную группу связанных слов. https://spacy.io/api/token#ancestors

Возможность формального представления (в том числе ручных валидации и корректировки) языковых моделей spacy предоставаляет? Если да - дайте ссылку на английскую грамматику в виде файла.

VO

его недостаточно, он все придаточные предложения и обороты подтянет, нужно ограничиваться по типам связей.

Отсечь эти придаточные паттерном dep_ по условию

YB

Возможность формального представления (в том числе ручных валидации и корректировки) языковых моделей spacy предоставаляет? Если да - дайте ссылку на английскую грамматику в виде файла.

у вас нейронная модель,

вы можете датасет менять как угодно,

но потом модель придётся переучивать целиком (или частично, переобучая для исправленных примеров).

вы можете датасет менять как угодно,

но потом модель придётся переучивать целиком (или частично, переобучая для исправленных примеров).

AK

у вас нейронная модель,

вы можете датасет менять как угодно,

но потом модель придётся переучивать целиком (или частично, переобучая для исправленных примеров).

вы можете датасет менять как угодно,

но потом модель придётся переучивать целиком (или частично, переобучая для исправленных примеров).

Зачем тогда вы это пишете? Я же сразу сказал, что это не интересует еще в прошлой дискуссии. Смысл отвечать на вопросы, которые никто не задавал?

YB

Зачем тогда вы это пишете? Я же сразу сказал, что это не интересует еще в прошлой дискуссии. Смысл отвечать на вопросы, которые никто не задавал?

а, я вас неправильно понял. я думал вам на выходе нужна грамматика, а не синтаксис в явном виде задавать.

AK

а, я вас неправильно понял. я думал вам на выходе нужна грамматика, а не синтаксис в явном виде задавать.

Юрий, уже который раз вы пытаетесь очень бурно, многословно и всесторонне отвечать на вопросы, даже не вникнув в их смысл. Уж извините. Еще раз - вот контекст вопроса https://github.com/aigents/aigents-java/issues/22 - Да - нам нужно как задавать грамматики вручную, так и иметь возможность глазами посматривать и править грамматики полученные из "нейросетевых" моделей.

YB

Юрий, уже который раз вы пытаетесь очень бурно, многословно и всесторонне отвечать на вопросы, даже не вникнув в их смысл. Уж извините. Еще раз - вот контекст вопроса https://github.com/aigents/aigents-java/issues/22 - Да - нам нужно как задавать грамматики вручную, так и иметь возможность глазами посматривать и править грамматики полученные из "нейросетевых" моделей.

"Какие есть альтернативы с формальными (читаемыми и редактируемыми) грамматиками?" вот это я понял неоднозначно.

YB

Юрий, уже который раз вы пытаетесь очень бурно, многословно и всесторонне отвечать на вопросы, даже не вникнув в их смысл. Уж извините. Еще раз - вот контекст вопроса https://github.com/aigents/aigents-java/issues/22 - Да - нам нужно как задавать грамматики вручную, так и иметь возможность глазами посматривать и править грамматики полученные из "нейросетевых" моделей.

после вашего объяснения стало понятнее

AK

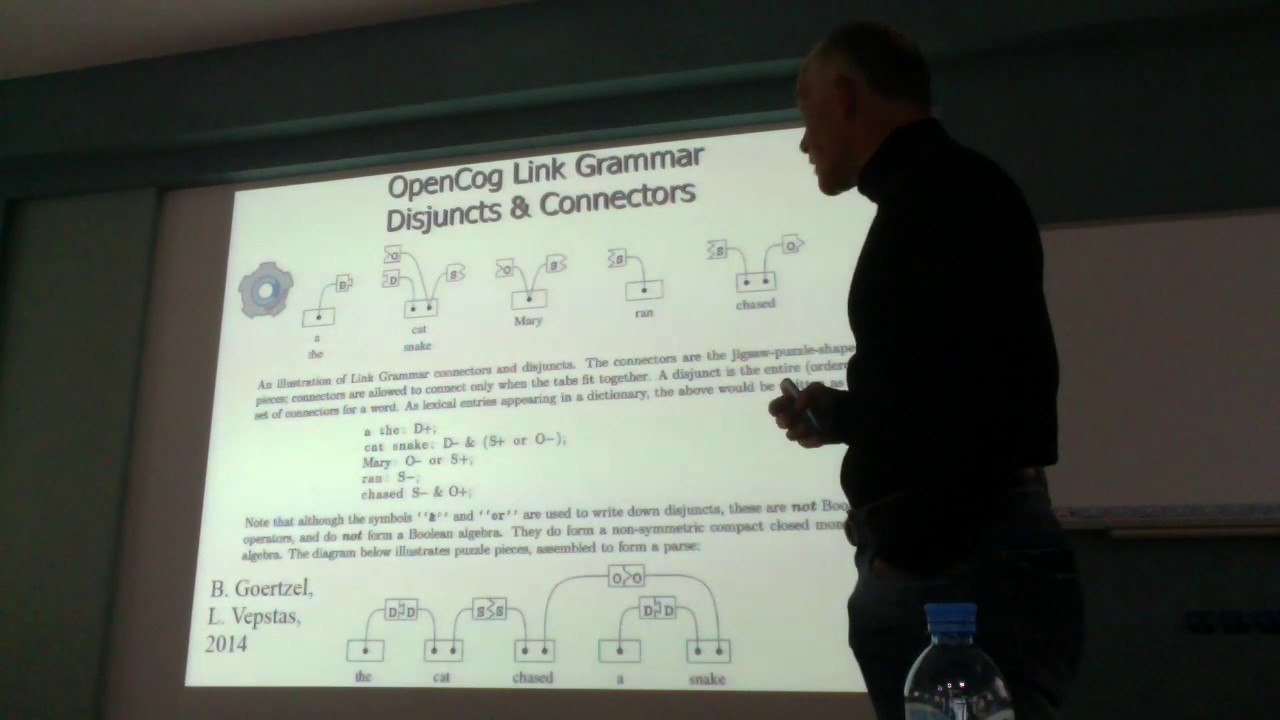

Вот здесь подробно описан наш подход https://www.youtube.com/watch?v=J9u2V2Mn42w - если интерсно - послушайте. Если не интересно, нет смысла тратить время на переписку. Замечу только, что лексическую неоднозначность LG позволяет устранять - изучите матчасть - чем "saw.v" отличается от "saw.n". Семантическую неоднозначность LG не позволяет устранять и это действительно боль, но я в данной дискуссии про это не спрашивал 😊

YB

Вот здесь подробно описан наш подход https://www.youtube.com/watch?v=J9u2V2Mn42w - если интерсно - послушайте. Если не интересно, нет смысла тратить время на переписку. Замечу только, что лексическую неоднозначность LG позволяет устранять - изучите матчасть - чем "saw.v" отличается от "saw.n". Семантическую неоднозначность LG не позволяет устранять и это действительно боль, но я в данной дискуссии про это не спрашивал 😊

а вот если у вас есть есть несколько разных значений в одной части речи ? и у них разная прикрепляемость...

и это всё называется "лексическая неоднозначность", как мне кажется.

и это всё называется "лексическая неоднозначность", как мне кажется.

VO

Возможность формального представления (в том числе ручных валидации и корректировки) языковых моделей spacy предоставаляет? Если да - дайте ссылку на английскую грамматику в виде файла.

К сожалению, данными в виде файла не обладаю. Могу лишь сказать, что spaCy дает возможность вести разработку своих языковых моделей. Обратите внимание на разделы Tag map и Morph rules. Вероятно, это близко к тому, что вы ищете. https://spacy.io/usage/adding-languages

YB

а вот если у вас есть есть несколько разных значений в одной части речи ? и у них разная прикрепляемость...

и это всё называется "лексическая неоднозначность", как мне кажется.

и это всё называется "лексическая неоднозначность", как мне кажется.

там saw.v.1 и saw.v.2 нету, случаем? "видел" vs "пилить".

( i saw with a saw — я пилю пилой)

( i saw with a saw — я пилю пилой)

YB

К сожалению, данными в виде файла не обладаю. Могу лишь сказать, что spaCy дает возможность вести разработку своих языковых моделей. Обратите внимание на разделы Tag map и Morph rules. Вероятно, это близко к тому, что вы ищете. https://spacy.io/usage/adding-languages

напрямую возможные фреймы глаголов в spacy действительно нельзя задавать... (фреймы в русском языке: https://github.com/olesar/framebank )

но я сомневаюсь, что кто-то для всего языка их сможет задать, особенно с учётом размытости норм языка и десятков миллионов частных случаев.

Я.Г. Тестелец целую книгу посвятил таким примерам ( https://studfile.net/preview/2675241/page:5/ и далее )

но я сомневаюсь, что кто-то для всего языка их сможет задать, особенно с учётом размытости норм языка и десятков миллионов частных случаев.

Я.Г. Тестелец целую книгу посвятил таким примерам ( https://studfile.net/preview/2675241/page:5/ и далее )

AK

там saw.v.1 и saw.v.2 нету, случаем? "видел" vs "пилить".

( i saw with a saw — я пилю пилой)

( i saw with a saw — я пилю пилой)

Не помню - откройте сами грамматику по ссылке и посмотрите - в этом вся прелесть 😊 Кстати, вот манускрипт основного текущего идеолога LG https://arxiv.org/abs/1901.01341

AK

напрямую возможные фреймы глаголов в spacy действительно нельзя задавать... (фреймы в русском языке: https://github.com/olesar/framebank )

но я сомневаюсь, что кто-то для всего языка их сможет задать, особенно с учётом размытости норм языка и десятков миллионов частных случаев.

Я.Г. Тестелец целую книгу посвятил таким примерам ( https://studfile.net/preview/2675241/page:5/ и далее )

но я сомневаюсь, что кто-то для всего языка их сможет задать, особенно с учётом размытости норм языка и десятков миллионов частных случаев.

Я.Г. Тестелец целую книгу посвятил таким примерам ( https://studfile.net/preview/2675241/page:5/ и далее )

> но я сомневаюсь, что кто-то для всего языка их сможет задать, особенно с учётом размытости норм языка и десятков миллионов частных случаев.

А это уже другая тема - я её обсуждаю как раз в видео выше. Речь идет не о ручном задании а об интерпретируемом представлении 😉

А это уже другая тема - я её обсуждаю как раз в видео выше. Речь идет не о ручном задании а об интерпретируемом представлении 😉

YB

> но я сомневаюсь, что кто-то для всего языка их сможет задать, особенно с учётом размытости норм языка и десятков миллионов частных случаев.

А это уже другая тема - я её обсуждаю как раз в видео выше. Речь идет не о ручном задании а об интерпретируемом представлении 😉

А это уже другая тема - я её обсуждаю как раз в видео выше. Речь идет не о ручном задании а об интерпретируемом представлении 😉

так интерпретируемое представление и в виде UD может быть, как я вам показал.

просто не будет возможности явно добавлять правила, кроме как через примеры разметки.

просто не будет возможности явно добавлять правила, кроме как через примеры разметки.

YB

да, в русском языке В.А. Тузов создавал подобные фреймовые правила.

у него был парсер, но он в заброшенном виде сейчас.

у него был парсер, но он в заброшенном виде сейчас.

YB

http://www.dialog-21.ru/digest/2001/articles/tuzov/

там был уровень проработки кстати на порядок выше, чем у LinkGrammar

там был уровень проработки кстати на порядок выше, чем у LinkGrammar

AG

Помогите установить fasttext. Создал окружение под анакондой для установки. По умолчанию python 2.7. Установка fasttext не проходит, требует python >= 3.6. Создал другое окружение с python 3.7. Установка завершилась. Но теперь модуль fasttext не найден.

MT

Добрый день!

Возникло желание обучаться на большом количестве данных, которое не влезает в оперативную память, используя pytorch + transformers на нескольких гпу. Сейчас используется де факто код от transformers с DistributedSampler + DataLoader которые работают поверх TensorDataset.

Хочется что-то типа асинхронного подхода, когда данные подгружаются по мере требования, но заранее. Есть ли у кого опыт \ пример подобного подхода?

Возникло желание обучаться на большом количестве данных, которое не влезает в оперативную память, используя pytorch + transformers на нескольких гпу. Сейчас используется де факто код от transformers с DistributedSampler + DataLoader которые работают поверх TensorDataset.

Хочется что-то типа асинхронного подхода, когда данные подгружаются по мере требования, но заранее. Есть ли у кого опыт \ пример подобного подхода?