$

Size: a a a

2020 July 06

Вектора слов близки

$

А смысл разный

K

есть разные способы обойти это

K

самый простой - использовать кодировщики предложений типа USE, LASER и тп

K

они делают эти вектора не очень похожими

AI

самый простой - использовать кодировщики предложений типа USE, LASER и тп

+. Еще можно файнтюнить BERT

AI

У меня LASER эмбеддинги были хуже, чем BERT эмбеддинги.

AK

Продолжение серии постов про проект Natasha. Что за проект? Почему в этот чат? См. https://t.me/natural_language_processing/16962

1. http://natasha.github.io/ner Natasha — качественное компактное решение для извлечения именованных сущностей из новостных статей на русском языке

1. http://natasha.github.io/ner Natasha — качественное компактное решение для извлечения именованных сущностей из новостных статей на русском языке

AK

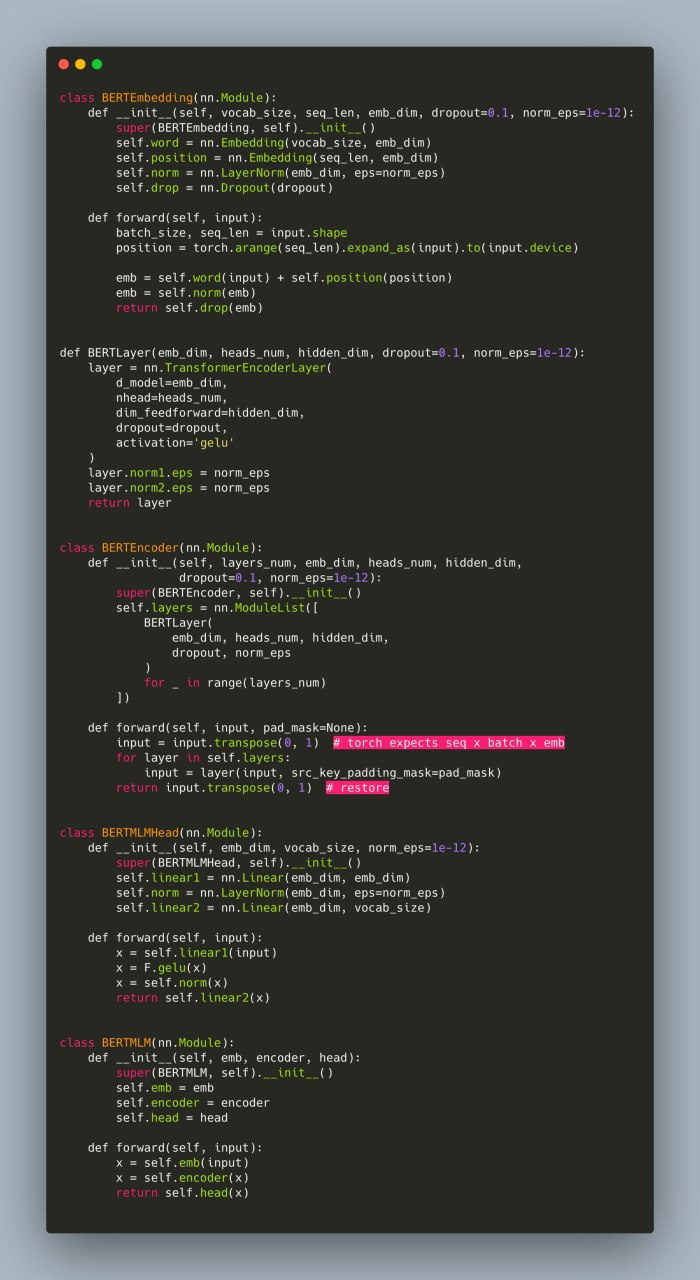

Почему Natasha не использует Transformers. BERT в 100 строк.

По мотивам треда с @mtikhomi https://t.me/natural_language_processing/17253

Сейчас, для обучения моделей с BERT-like архитектурой, принято использовать Transformers от Hugging Face. Transformers — это 100 000 строк кода на Python. Желаю удачи, разобраться, что пошло не так, когда взорвётся loss или на инференсе будет мусор. Ладно, там много кода дублируется. Пускай мы тренируем RoBERTa, довольно быстро локализуем проблему до ~3000 строк кода, но это тоже немало. С современным PyTorch, мне кажется, библиотека Transformers не так актуальна. С torch.nn.TransformerEncoderLayer код RoBERTa-like модели занимает 100 строк:

По мотивам треда с @mtikhomi https://t.me/natural_language_processing/17253

Сейчас, для обучения моделей с BERT-like архитектурой, принято использовать Transformers от Hugging Face. Transformers — это 100 000 строк кода на Python. Желаю удачи, разобраться, что пошло не так, когда взорвётся loss или на инференсе будет мусор. Ладно, там много кода дублируется. Пускай мы тренируем RoBERTa, довольно быстро локализуем проблему до ~3000 строк кода, но это тоже немало. С современным PyTorch, мне кажется, библиотека Transformers не так актуальна. С torch.nn.TransformerEncoderLayer код RoBERTa-like модели занимает 100 строк:

AK

Это не прототип, код скопирован из Slovnet https://github.com/natasha/slovnet/blob/master/slovnet/model/bert.py. Slovnet BERT инциализируется весами из DeepPavlov RuBERT, Slovnet BERT NER, BERT Morph, BERT Sytnax дают SOTA или near-SOTA результаты для русского языка https://github.com/natasha/slovnet#evaluation.

Transformers полезно читать, они делают большую работу, набивают код для статей с Arxiv. Например, только благодаря их коду я разобрался как именно в ALBERT дублируются веса. #natasha

Transformers полезно читать, они делают большую работу, набивают код для статей с Arxiv. Например, только благодаря их коду я разобрался как именно в ALBERT дублируются веса. #natasha

AK

Напишите в личку @alexkuk кому интересно почитать статьи для natasha.github.io до публикации. Следующая будет про компактные эмбединги для русского. С меня ссылочка за неделю до публикации, с вам ревью что непонятно.

AK

Приветы. Подскажите, какой тулзой для русских предложений можно найти подлежащее и сказуемое?

FF

Приветы. Подскажите, какой тулзой для русских предложений можно найти подлежащее и сказуемое?

Syntax parsing для русского языка должен помочь

YB

Приветы. Подскажите, какой тулзой для русских предложений можно найти подлежащее и сказуемое?

https://github.com/natasha/naeval#syntax-parser ( точность и скорость популярных парсеров — в таблице)

AK

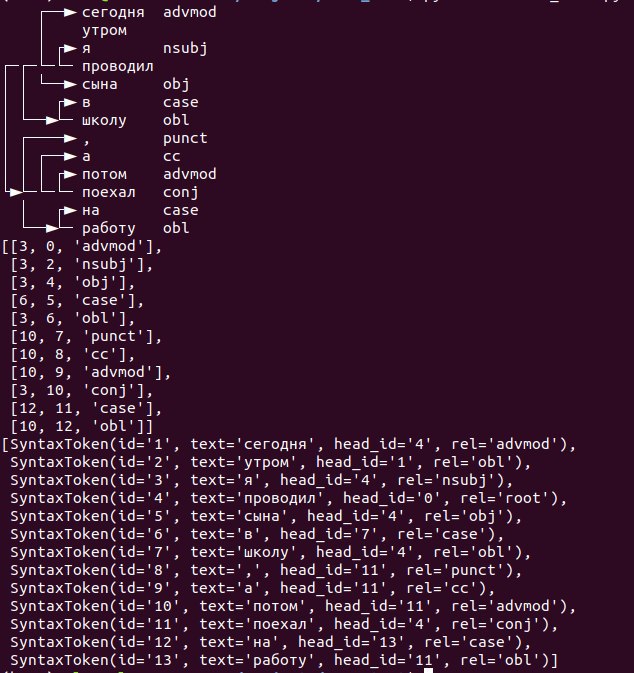

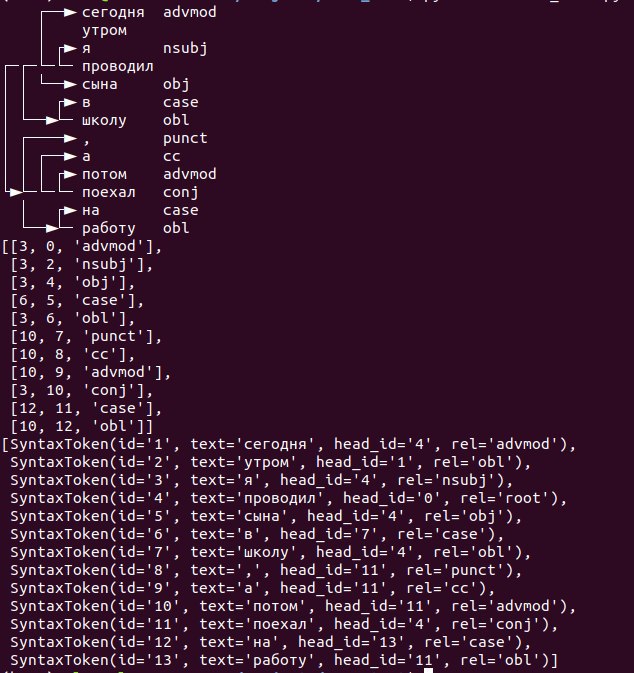

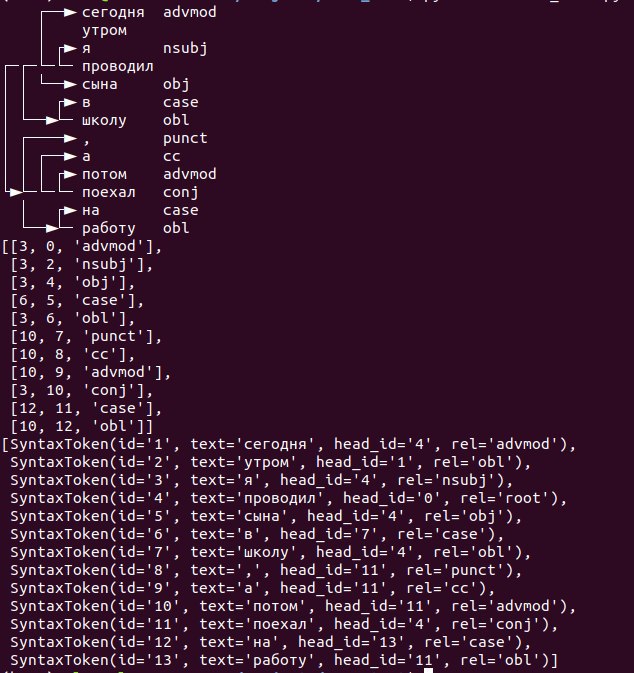

Спасибо за ответы. Я уже тыкаю slovnet и мне не оч ясно, как явно выделить связи, например, "я - проводил" и "я - поехал"

AK

Как сохранять и загружать hArtm правильно?

AK

Спасибо за ответы. Я уже тыкаю slovnet и мне не оч ясно, как явно выделить связи, например, "я - проводил" и "я - поехал"

нужно ещё сделать морфологический разбор, найти подлежащее и сказуемое, в slovnet тоже есть https://github.com/natasha/slovnet#morphology

DK

Спасибо за ответы. Я уже тыкаю slovnet и мне не оч ясно, как явно выделить связи, например, "я - проводил" и "я - поехал"

так conj c root -- это второе сказуемое и есть, надо ехать на эвристиках поверх типов связей

AK

так conj c root -- это второе сказуемое и есть, надо ехать на эвристиках поверх типов связей

А где найти доку по обозначениям типов связей?