VS

Size: a a a

2020 May 29

Как я помню стэмминг лучше

AS

что такое лучше

FF

Vladimir Shebunyaev

Народ напомните а то забыл для русского языка лучше стемминг или лемматизация и если кто помнить дайте ссылку на пруф

https://habr.com/ru/post/334668/ Тут примеры применения стемминга и лемматизации

FF

Стемминг лучше срабатывает для английского, у русского богатая морфология

AY

Недавняя работа продемонстрировала существенный прогресс по многим задачам и контрольным показателям НЛП путем предварительной подготовки большого объема текста с последующей точной настройкой для конкретной задачи. Несмотря на то, что этот метод обычно независим от задач в архитектуре, для этого метода все еще требуются точные наборы данных для конкретных задач, включающие тысячи или десятки тысяч примеров. В отличие от этого, люди обычно могут выполнять новую языковую задачу только из нескольких примеров или из простых инструкций - что-то, что современные системы НЛП все еще в значительной степени пытаются сделать. Здесь мы показываем, что масштабирование языковых моделей значительно улучшает независимую от задач производительность при минимальных затратах, иногда даже достигая конкурентоспособности с помощью более современных подходов тонкой настройки. В частности, мы обучаем GPT-3, модель авторегрессионного языка с 175 миллиардами параметров, что в 10 раз больше, чем у любой предыдущей модели с не разреженным языком, и тестируем ее производительность в условиях минимальных затрат. Для всех задач GPT-3 применяется без каких-либо градиентных обновлений или тонкой настройки, при этом задачи и демонстрации в несколько выстрелов определяются исключительно посредством текстового взаимодействия с моделью. GPT-3 обеспечивает высокую производительность во многих наборах данных НЛП, включая задачи перевода, ответа на вопросы и закрытия, а также несколько задач, требующих оперативного рассуждения или адаптации предметной области, таких как расшифровка слов, с использованием нового слова в предложение или выполнение трехзначной арифметики. В то же время, мы также идентифицируем некоторые наборы данных, в которых обучение GPT-3 по-прежнему сложно, а также некоторые наборы данных, где GPT-3 сталкивается с методологическими проблемами, связанными с обучением в крупных веб-корпусах. Наконец, мы обнаруживаем, что GPT-3 может генерировать образцы новостных статей, которые оценщикам трудно отличить от статей, написанных людьми. Мы обсуждаем более широкие социальные последствия этого открытия и ГПТ-3 в целом.

C

Hi everyone,

I have a >7000 dataset of bibliographic records from a domain-specific search I did in Scopus.

My goal is to group these data (all titles + abstracts) in a meaningful way.

My question is:

Do you recommend me any SOTA framework, workflow, pipeline, article, book, or tutorial, to perform this task?

Moreover, I have several doubts:

(1) I already tried CountVec + HDP, LSI, LDA with GENSIM, and LDA was good enough.

However with TF-IDF + NMF it was "coherent", too.

So, how I justify the use of any of these combinations: e.g., CountVec + LDA or TF-IDF + NMF

Is CountVec or TF-IDF only proper for some of these methods but not all ?

(2) If instead of a BOW approach I use embeddings, are there appropriate combinations whereas some others are not?

For example, Word2Vec + LDA? But not SentVec + NMF?

(3) Finally, are any of these approaches (BOW or embeddings) more appropriate for a specific clustering technique (e.g., BOW + K-Means, embeddings + affinity propagation)?

Moreover, would it be appropriate to perform Topic Modeling in each cluster?

If so, which combination would be appropriate in this case?

I am writing an article, and as you know, reviewers are very picky, and that's why I am very detailed.

I hope my questions make sense.

If you have any advice, I would really appreciate it!

Thank you!

Carlos.

I have a >7000 dataset of bibliographic records from a domain-specific search I did in Scopus.

My goal is to group these data (all titles + abstracts) in a meaningful way.

My question is:

Do you recommend me any SOTA framework, workflow, pipeline, article, book, or tutorial, to perform this task?

Moreover, I have several doubts:

(1) I already tried CountVec + HDP, LSI, LDA with GENSIM, and LDA was good enough.

However with TF-IDF + NMF it was "coherent", too.

So, how I justify the use of any of these combinations: e.g., CountVec + LDA or TF-IDF + NMF

Is CountVec or TF-IDF only proper for some of these methods but not all ?

(2) If instead of a BOW approach I use embeddings, are there appropriate combinations whereas some others are not?

For example, Word2Vec + LDA? But not SentVec + NMF?

(3) Finally, are any of these approaches (BOW or embeddings) more appropriate for a specific clustering technique (e.g., BOW + K-Means, embeddings + affinity propagation)?

Moreover, would it be appropriate to perform Topic Modeling in each cluster?

If so, which combination would be appropriate in this case?

I am writing an article, and as you know, reviewers are very picky, and that's why I am very detailed.

I hope my questions make sense.

If you have any advice, I would really appreciate it!

Thank you!

Carlos.

2020 May 30

TA

Carlos A.

Hi everyone,

I have a >7000 dataset of bibliographic records from a domain-specific search I did in Scopus.

My goal is to group these data (all titles + abstracts) in a meaningful way.

My question is:

Do you recommend me any SOTA framework, workflow, pipeline, article, book, or tutorial, to perform this task?

Moreover, I have several doubts:

(1) I already tried CountVec + HDP, LSI, LDA with GENSIM, and LDA was good enough.

However with TF-IDF + NMF it was "coherent", too.

So, how I justify the use of any of these combinations: e.g., CountVec + LDA or TF-IDF + NMF

Is CountVec or TF-IDF only proper for some of these methods but not all ?

(2) If instead of a BOW approach I use embeddings, are there appropriate combinations whereas some others are not?

For example, Word2Vec + LDA? But not SentVec + NMF?

(3) Finally, are any of these approaches (BOW or embeddings) more appropriate for a specific clustering technique (e.g., BOW + K-Means, embeddings + affinity propagation)?

Moreover, would it be appropriate to perform Topic Modeling in each cluster?

If so, which combination would be appropriate in this case?

I am writing an article, and as you know, reviewers are very picky, and that's why I am very detailed.

I hope my questions make sense.

If you have any advice, I would really appreciate it!

Thank you!

Carlos.

I have a >7000 dataset of bibliographic records from a domain-specific search I did in Scopus.

My goal is to group these data (all titles + abstracts) in a meaningful way.

My question is:

Do you recommend me any SOTA framework, workflow, pipeline, article, book, or tutorial, to perform this task?

Moreover, I have several doubts:

(1) I already tried CountVec + HDP, LSI, LDA with GENSIM, and LDA was good enough.

However with TF-IDF + NMF it was "coherent", too.

So, how I justify the use of any of these combinations: e.g., CountVec + LDA or TF-IDF + NMF

Is CountVec or TF-IDF only proper for some of these methods but not all ?

(2) If instead of a BOW approach I use embeddings, are there appropriate combinations whereas some others are not?

For example, Word2Vec + LDA? But not SentVec + NMF?

(3) Finally, are any of these approaches (BOW or embeddings) more appropriate for a specific clustering technique (e.g., BOW + K-Means, embeddings + affinity propagation)?

Moreover, would it be appropriate to perform Topic Modeling in each cluster?

If so, which combination would be appropriate in this case?

I am writing an article, and as you know, reviewers are very picky, and that's why I am very detailed.

I hope my questions make sense.

If you have any advice, I would really appreciate it!

Thank you!

Carlos.

The combinations are endless. Just describe your methods in a way that shows that is possible to compare other combination of parameters

C

The combinations are endless. Just describe your methods in a way that shows that is possible to compare other combination of parameters

Yes, I will do it. Thanks for your advice Thiago

VS

Недавняя работа продемонстрировала существенный прогресс по многим задачам и контрольным показателям НЛП путем предварительной подготовки большого объема текста с последующей точной настройкой для конкретной задачи. Несмотря на то, что этот метод обычно независим от задач в архитектуре, для этого метода все еще требуются точные наборы данных для конкретных задач, включающие тысячи или десятки тысяч примеров. В отличие от этого, люди обычно могут выполнять новую языковую задачу только из нескольких примеров или из простых инструкций - что-то, что современные системы НЛП все еще в значительной степени пытаются сделать. Здесь мы показываем, что масштабирование языковых моделей значительно улучшает независимую от задач производительность при минимальных затратах, иногда даже достигая конкурентоспособности с помощью более современных подходов тонкой настройки. В частности, мы обучаем GPT-3, модель авторегрессионного языка с 175 миллиардами параметров, что в 10 раз больше, чем у любой предыдущей модели с не разреженным языком, и тестируем ее производительность в условиях минимальных затрат. Для всех задач GPT-3 применяется без каких-либо градиентных обновлений или тонкой настройки, при этом задачи и демонстрации в несколько выстрелов определяются исключительно посредством текстового взаимодействия с моделью. GPT-3 обеспечивает высокую производительность во многих наборах данных НЛП, включая задачи перевода, ответа на вопросы и закрытия, а также несколько задач, требующих оперативного рассуждения или адаптации предметной области, таких как расшифровка слов, с использованием нового слова в предложение или выполнение трехзначной арифметики. В то же время, мы также идентифицируем некоторые наборы данных, в которых обучение GPT-3 по-прежнему сложно, а также некоторые наборы данных, где GPT-3 сталкивается с методологическими проблемами, связанными с обучением в крупных веб-корпусах. Наконец, мы обнаруживаем, что GPT-3 может генерировать образцы новостных статей, которые оценщикам трудно отличить от статей, написанных людьми. Мы обсуждаем более широкие социальные последствия этого открытия и ГПТ-3 в целом.

Не знаю кто эти статьи читать будет. Я уже давно не читаю статьи в инете

AY

Vladimir Shebunyaev

Не знаю кто эти статьи читать будет. Я уже давно не читаю статьи в инете

Пока там ничего интересного. Жду первых примеров на github

DB

Всем привет. Есть живые, знающие пандас?

DB

спасай)

DB

ребят, а кому писать по поводу бана в этой конфе? подскажите контакты админа пожалуйста

AC

Demios Bellator

ребят, а кому писать по поводу бана в этой конфе? подскажите контакты админа пожалуйста

зачем тебе бан?

DB

Петя тут бан словил

DB

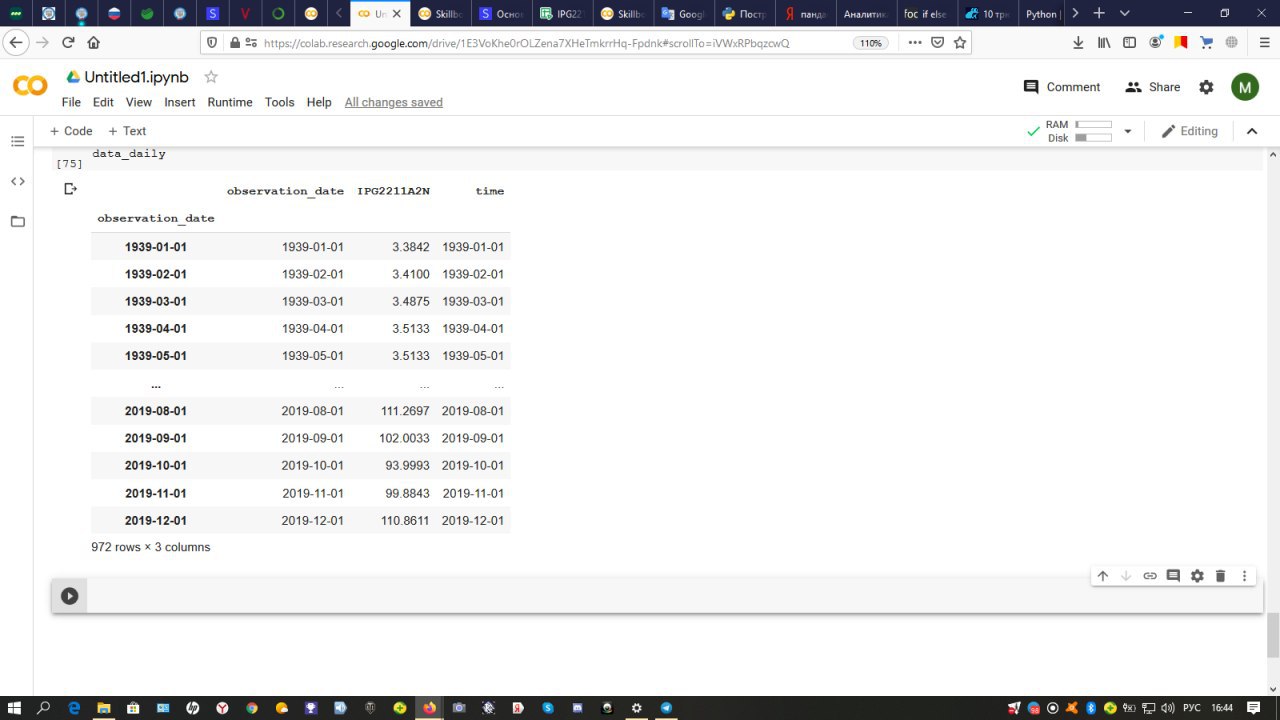

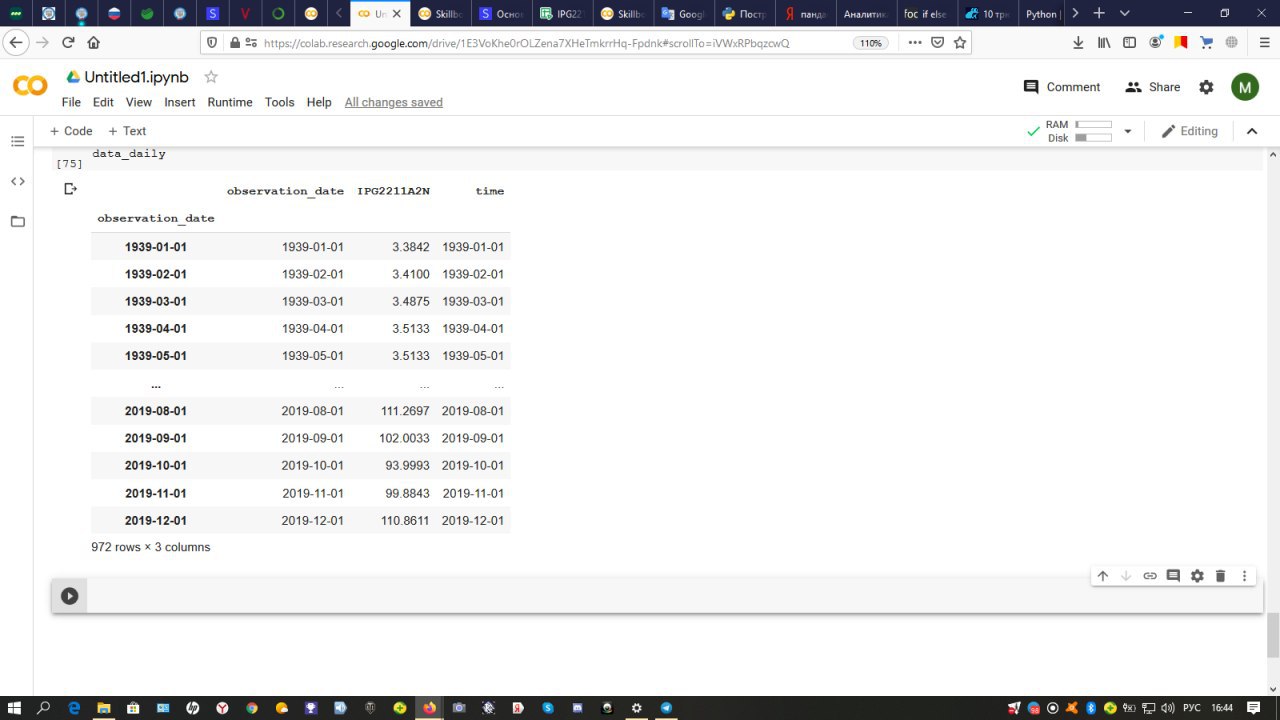

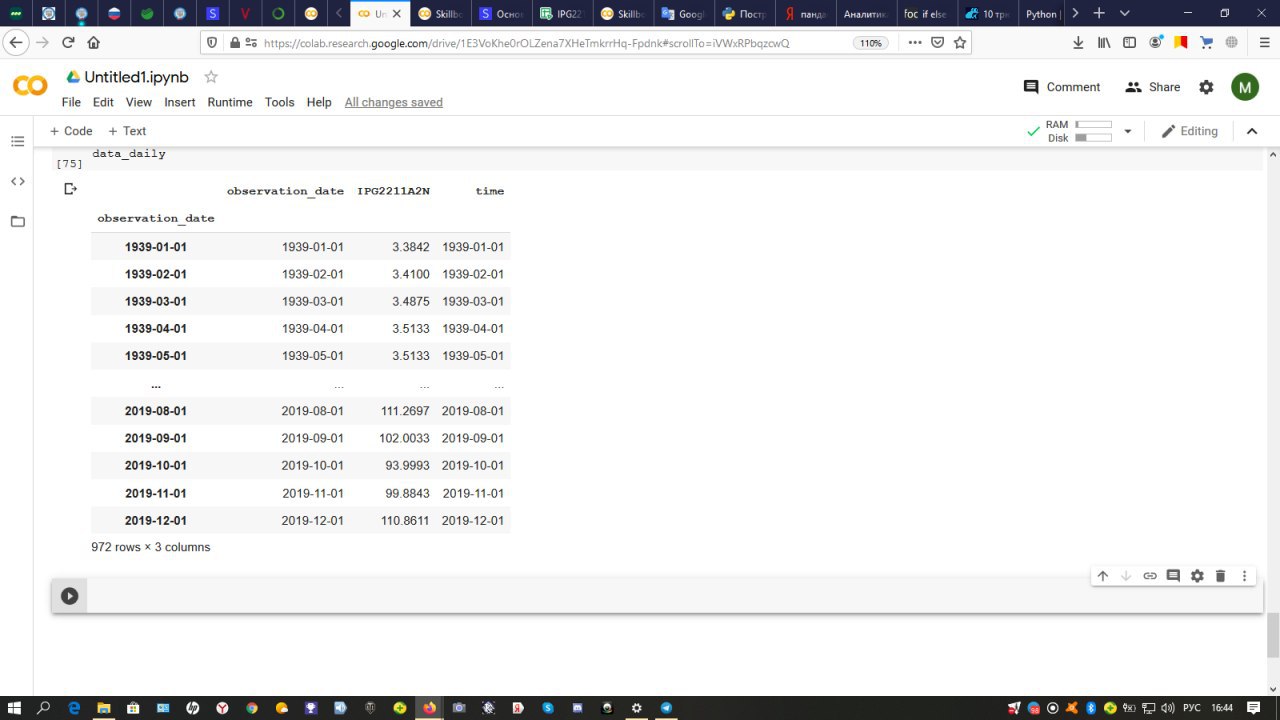

кто сможет объяснить, как надо записать, чтобы получить ожидаемый результат?

суть задачи.

есть таблица excel, в которой данные по производительности за большое количество лет.

имеется прогресс и соответственно имеется регресс.

необходимо определить даты с регрессом (ситуации как с 2019 годом на скрине), для проведения параллели с политическо/экономической ситуацией. математически я понимаю, как это сделать. а код написать не могу. дедлайн на носу (меньше чем через час) весь мозг себе сломала.

суть задачи.

есть таблица excel, в которой данные по производительности за большое количество лет.

имеется прогресс и соответственно имеется регресс.

необходимо определить даты с регрессом (ситуации как с 2019 годом на скрине), для проведения параллели с политическо/экономической ситуацией. математически я понимаю, как это сделать. а код написать не могу. дедлайн на носу (меньше чем через час) весь мозг себе сломала.

AY

Demios Bellator

кто сможет объяснить, как надо записать, чтобы получить ожидаемый результат?

суть задачи.

есть таблица excel, в которой данные по производительности за большое количество лет.

имеется прогресс и соответственно имеется регресс.

необходимо определить даты с регрессом (ситуации как с 2019 годом на скрине), для проведения параллели с политическо/экономической ситуацией. математически я понимаю, как это сделать. а код написать не могу. дедлайн на носу (меньше чем через час) весь мозг себе сломала.

суть задачи.

есть таблица excel, в которой данные по производительности за большое количество лет.

имеется прогресс и соответственно имеется регресс.

необходимо определить даты с регрессом (ситуации как с 2019 годом на скрине), для проведения параллели с политическо/экономической ситуацией. математически я понимаю, как это сделать. а код написать не могу. дедлайн на носу (меньше чем через час) весь мозг себе сломала.

Excel -> csv -> Pandas.read_csv

D

Demios Bellator

кто сможет объяснить, как надо записать, чтобы получить ожидаемый результат?

суть задачи.

есть таблица excel, в которой данные по производительности за большое количество лет.

имеется прогресс и соответственно имеется регресс.

необходимо определить даты с регрессом (ситуации как с 2019 годом на скрине), для проведения параллели с политическо/экономической ситуацией. математически я понимаю, как это сделать. а код написать не могу. дедлайн на носу (меньше чем через час) весь мозг себе сломала.

суть задачи.

есть таблица excel, в которой данные по производительности за большое количество лет.

имеется прогресс и соответственно имеется регресс.

необходимо определить даты с регрессом (ситуации как с 2019 годом на скрине), для проведения параллели с политическо/экономической ситуацией. математически я понимаю, как это сделать. а код написать не могу. дедлайн на носу (меньше чем через час) весь мозг себе сломала.

df['gradient'] = np.gradient(df['IPG2211A2N'].values, df.index)

df['regress'] = df['gradient'] < 0

Я бы делал так, через производную по времени. В зависимости от цели может иметь смысл немного сгладить наблюдения.

df['regress'] = df['gradient'] < 0

Я бы делал так, через производную по времени. В зависимости от цели может иметь смысл немного сгладить наблюдения.