AK

Size: a a a

2020 May 13

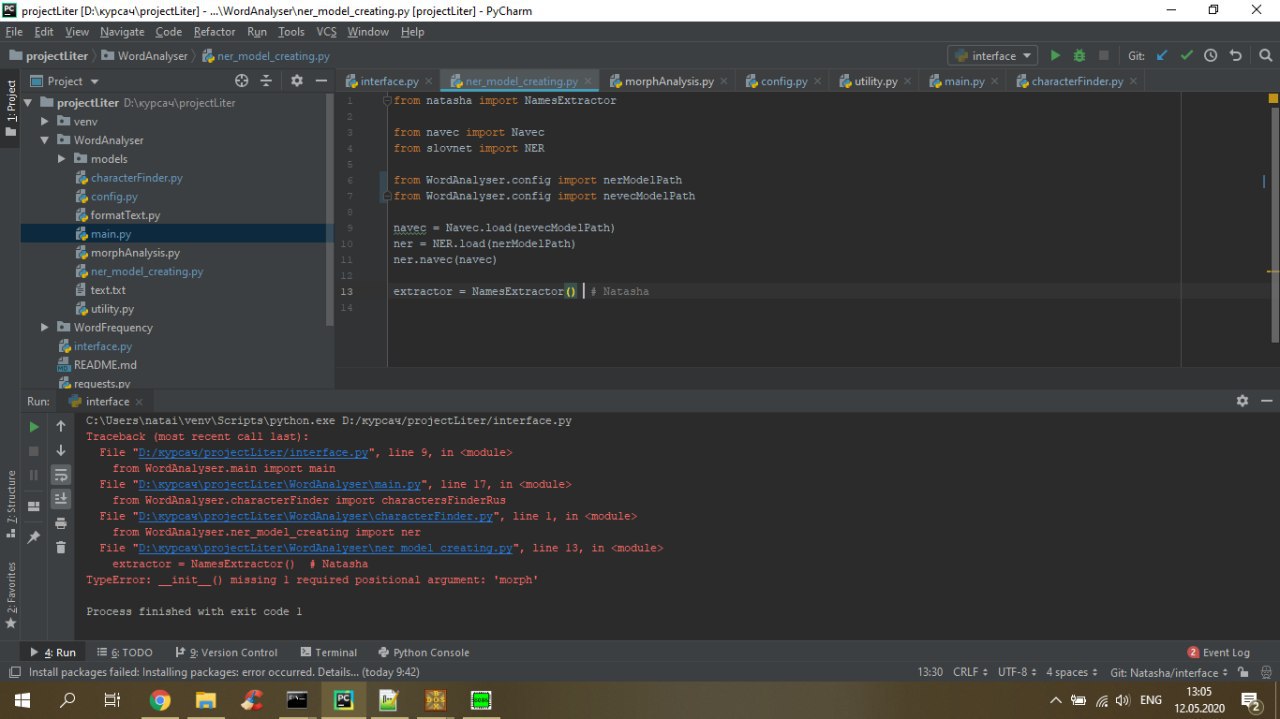

В версии 1.0.0 у библиотеки поменялся интерфейс, либо нужно установить версию до 1 (install natasha<1 yargy<0.13), либо посмотреть пример использования актуальной версии https://github.com/natasha/natasha#usage

AK

Всем привет. Что я не так делаю - сравнил производительность yargy и tomita на Linux, Python3, задача получение физлица и организации(в наташе из коробки, в томите самописные правила), список из 1500 текстов. По данным измерений - в среднем tomita парсит за 0.27 сек, в то время, как наташа - за 0.07 сек. Yargy+Natasha в 3+ раза быстрее, чем Tomita,

с чем это может быть связано, с необходимостью постоянно дергать бинарь томиты или криворукими правилами для томиты, и как тогда другие люди меряют, все те, кто утверждает, что tomita быстрее, чем yargy? Тут кто нибудь сравнивал производительность двух этих инструментов? Подскажите, пзл, кто имел боевой опыт, в какую сторону копать

с чем это может быть связано, с необходимостью постоянно дергать бинарь томиты или криворукими правилами для томиты, и как тогда другие люди меряют, все те, кто утверждает, что tomita быстрее, чем yargy? Тут кто нибудь сравнивал производительность двух этих инструментов? Подскажите, пзл, кто имел боевой опыт, в какую сторону копать

Да, конечно, нужно запускать Томиту в пакетном режиме. Если сравнивать с Наташей версии <1.0 Томита должна быть в ~6 раз быстрее. Это если Наташа запущена под PyPy. Если под обычным Python разница ещё больше. Пример как запускать Томиту в поточном режиме в виде веб-сервиса https://github.com/natasha/naeval/blob/master/docker/tomita-algfio/app.py

IJ

Да, конечно, нужно запускать Томиту в пакетном режиме. Если сравнивать с Наташей версии <1.0 Томита должна быть в ~6 раз быстрее. Это если Наташа запущена под PyPy. Если под обычным Python разница ещё больше. Пример как запускать Томиту в поточном режиме в виде веб-сервиса https://github.com/natasha/naeval/blob/master/docker/tomita-algfio/app.py

О, большое спасибо!

2020 May 14

A

Так я загружаю предобученную модель word2vec:

pre_train_model = gensim.downloader.load('word2vec-ruscorpora-300')

Так я обучаю модель на собственных данных:

model = Word2Vec(my_text, size=32, min_count=5, window=50)

Я хочу взять предобученную модель (pre_train_model) и дополнить ее своими данными(my_text). Как я могу это сделать? Есть минусы от этого подхода?

pre_train_model = gensim.downloader.load('word2vec-ruscorpora-300')

Так я обучаю модель на собственных данных:

model = Word2Vec(my_text, size=32, min_count=5, window=50)

Я хочу взять предобученную модель (pre_train_model) и дополнить ее своими данными(my_text). Как я могу это сделать? Есть минусы от этого подхода?

K

попробуй сделать так:

old_model.build_vocab(your_sentences, update = True)

old_model.train(your_sentences, total_examples=2, epochs = 1)

old_model.build_vocab(your_sentences, update = True)

old_model.train(your_sentences, total_examples=2, epochs = 1)

K

сначала ты апдейтишь словарь старой модели

K

потом дообучаешь ее

K

(параметры во второй строке опциональны)

K

(поправьте меня, я сам второй день!!!)

A

Похоже на правду! Правда получается что я подгружаю не модель, а KeyedVectors. Пойду искать как подгрузить модель. Спасибо!

V

Насколько я помню, word2vec в реализации gensim не поддерживает дообучение. В приведённом выше примере модель будет обучена с нуля на ваших данных, а не дообучена

K

разве там не добавили эту опцию позднее?

A

У меня получилось. А на каких курсах так за два дня учатся?

K

непонятный вопрос. Еще раз плз

DR

2020 May 15

R

hey,

R

I wanted to download TACRED dataset. can someone please tell me how can I do that?

ND

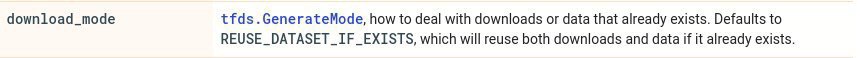

Всем доброго времени суток, если кто-то сталкивался с модулем TensorFlow datasets, скажите пожалуйста, если в Download Config стоит этот флаг, то если прервать работу скрипта который выкачивает данные, то после его повторного запуска сборка данных продолжиться или начнётся заново?

2020 May 16

D(

Друзья, а можете поделиться вашим любимым способом майнить синонимы для [преимущественно русских] слов?

Что пока пришло мне в голову:

1) Воспользоваться готовым тезаурусом. По точности - идеально, но заметно не хватает полноты.

2) Брать ближайших соседей по словным эмбеддингам из языковой модели. Тут, наоборот, с полнотой всё ок, но точность плохая: для "можно" ближайшие соседи "невозможно" и "нельзя".

3) Тоже соседи по эмбеддингам, но не из языковой модели (которая не отличает синонимы от антонимов), а из какой-нибудь модели-переводчика. Кажется, должно быть лучше. Вопрос: какую предобученную модель для русского языка посоветуете?

4) Ваши варианты?

Что пока пришло мне в голову:

1) Воспользоваться готовым тезаурусом. По точности - идеально, но заметно не хватает полноты.

2) Брать ближайших соседей по словным эмбеддингам из языковой модели. Тут, наоборот, с полнотой всё ок, но точность плохая: для "можно" ближайшие соседи "невозможно" и "нельзя".

3) Тоже соседи по эмбеддингам, но не из языковой модели (которая не отличает синонимы от антонимов), а из какой-нибудь модели-переводчика. Кажется, должно быть лучше. Вопрос: какую предобученную модель для русского языка посоветуете?

4) Ваши варианты?

DK

Друзья, а можете поделиться вашим любимым способом майнить синонимы для [преимущественно русских] слов?

Что пока пришло мне в голову:

1) Воспользоваться готовым тезаурусом. По точности - идеально, но заметно не хватает полноты.

2) Брать ближайших соседей по словным эмбеддингам из языковой модели. Тут, наоборот, с полнотой всё ок, но точность плохая: для "можно" ближайшие соседи "невозможно" и "нельзя".

3) Тоже соседи по эмбеддингам, но не из языковой модели (которая не отличает синонимы от антонимов), а из какой-нибудь модели-переводчика. Кажется, должно быть лучше. Вопрос: какую предобученную модель для русского языка посоветуете?

4) Ваши варианты?

Что пока пришло мне в голову:

1) Воспользоваться готовым тезаурусом. По точности - идеально, но заметно не хватает полноты.

2) Брать ближайших соседей по словным эмбеддингам из языковой модели. Тут, наоборот, с полнотой всё ок, но точность плохая: для "можно" ближайшие соседи "невозможно" и "нельзя".

3) Тоже соседи по эмбеддингам, но не из языковой модели (которая не отличает синонимы от антонимов), а из какой-нибудь модели-переводчика. Кажется, должно быть лучше. Вопрос: какую предобученную модель для русского языка посоветуете?

4) Ваши варианты?

В 2) можно предварительно потюнить модель чем-то вроде кантерфиттинга или других видов фитинга

Тогда антонимы отъедут и должно быть плюс-минус ок

Тогда антонимы отъедут и должно быть плюс-минус ок