IM

Size: a a a

2020 February 23

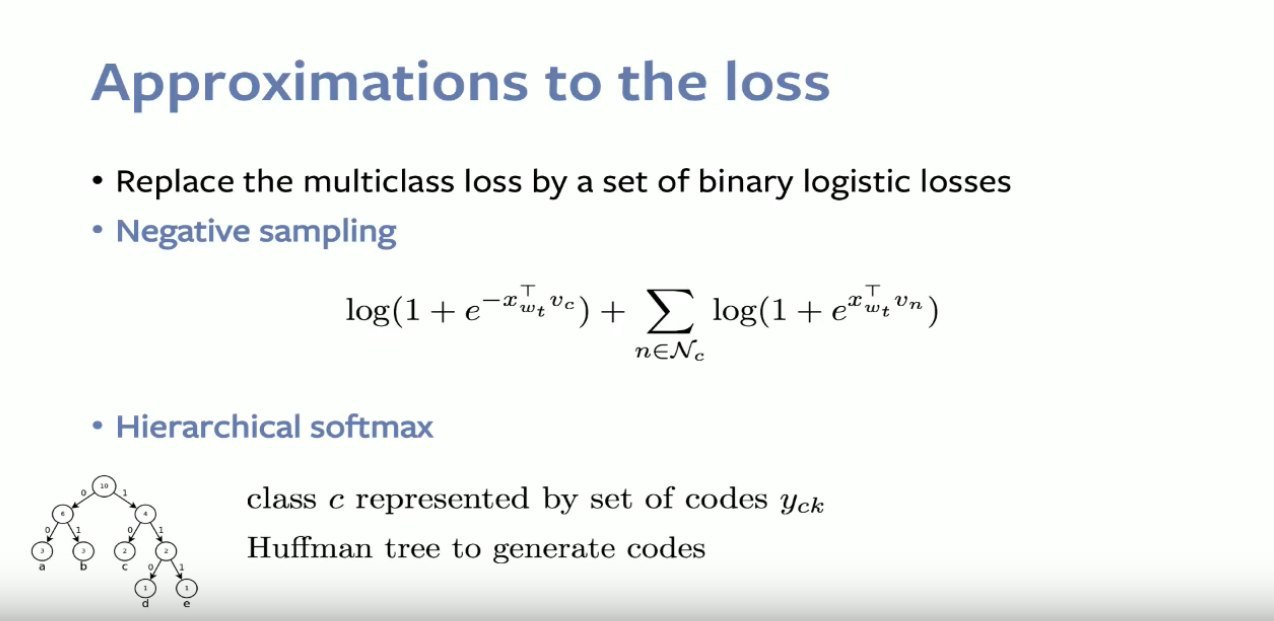

Еще буду рад если разъясните мне один момент про negative sampling и иерархический софтмакс. Как я понял negative sampling точно используется и в изначальной сишной реализации и в gensim. А иерархический софтмакс и там, и там используется?

и там и там, просто параметризуешь модель нужным режимом

NO

и там и там, просто параметризуешь модель нужным режимом

Что значит параметризуешь режимом? Это можно как-то настраивать в параметрах перед обучением?

IM

Что значит параметризуешь режимом? Это можно как-то настраивать в параметрах перед обучением?

да, перед обучением ты указываешь, что ты хочешь использовать (негатив семплинг или софтмакс)

NO

А так это выбор строго или одно или другое? Оба нельзя?

IM

https://radimrehurek.com/gensim/models/word2vec.html параметр

hs. Строго одно или другое, тут оба и не нужны, они же взаимоисключающиеNO

Спасибо, понял.

NO

Значит в изначальном сишном коде иерархического софтмакса не было или там оба способа были реализованы?

IM

Значит в изначальном сишном коде иерархического софтмакса не было или там оба способа были реализованы?

нет, ещё раз, оба способа есть в обоих реализациях

NO

Понятно. Просто у Миколова есть две (?) изначальных статьи по v2w, вышедшие с разницей в месяц и я пытаюсь понять какое они имеют отношение одна к другой и к сишной реализации и к gensim. https://arxiv.org/pdf/1301.3781.pdf https://arxiv.org/pdf/1310.4546.pdf

IM

Понятно. Просто у Миколова есть две (?) изначальных статьи по v2w, вышедшие с разницей в месяц и я пытаюсь понять какое они имеют отношение одна к другой и к сишной реализации и к gensim. https://arxiv.org/pdf/1301.3781.pdf https://arxiv.org/pdf/1310.4546.pdf

всё, что есть в этих статьях, реализовано как в миколовском варианте, так и в gensim

NO

Как в фасттексте используются подслова? Скиньте ссылочку на статью или видос где это подробно объясняется.

YB

Как в фасттексте используются подслова? Скиньте ссылочку на статью или видос где это подробно объясняется.

примерно так:

r = emb[w]

n = 1

for s in subwords(w):

r += emb[s]

n += 1

return r / n

r = emb[w]

n = 1

for s in subwords(w):

r += emb[s]

n += 1

return r / n

NO

emb is undefined

YB

emb is undefined

emb — матрица эмбеддингов.

NO

Если серьезно, то меня интересует более подродное объяснение. Например как это все обучается, как берутся подслова и т.д.

YB

Если серьезно, то меня интересует более подродное объяснение. Например как это все обучается, как берутся подслова и т.д.

ну, погугли, материалов много есть по каждому твоему конкретному вопросу

2020 February 24

NO

Это круто, что по моему вопросу уже есть ответ в интернете. Ты же хорошо в НЛП разбираешься, так может подскажешь мне конкретную ссылке, а то что-то нагуглить не получается.

YB

Это круто, что по моему вопросу уже есть ответ в интернете. Ты же хорошо в НЛП разбираешься, так может подскажешь мне конкретную ссылке, а то что-то нагуглить не получается.

"subwords fasttext", третья сссылка: https://stackoverflow.com/a/49827568/217895