Sи

Size: a a a

2020 January 26

2-е слова, типа "дисковый" путают её

YB

примеров 24 тысячи

ну это может быть маловато, хотя на каждый класс вроде бы достаточно. у меня на 24 тысячах и 100 классах была точность 80-85%, но там метки были смещены относительно текстов и разделение не оптимальное.

YB

2-е слова, типа "дисковый" путают её

ну, чтобы не путало, надо, чтобы по остальным словам уверенно опознавалось.

2020 January 27

YB

она ж не зря берёт слово "дисковый" и смотрит наиболее популярную категорию с этим словом — так ей проще

Sи

80-85 по-лучше, чем мои 75%, идеи разбить на кластеры и задать character-level фичи мне нравятся, буду копать туда. Тут еще плохо, что текст маленький: 1-2 слово и огроменные наборы букв/цифр всяких. Я очистил от знаков '&*, качество улучшилось, но не критично

YB

1) ну если однотипные наборы букв/цифр — классифицирующий признак, то это хорошо, можно сделать "частичную нормализацию" и может даже этого будет достаточно

2) а что, нет биграмм? нож_дисковый — это отличная биграмма!

2) а что, нет биграмм? нож_дисковый — это отличная биграмма!

Sи

слушайте, раз уж вы помочь решили, буду нескромным и еще вопросим задам: задачка мучает уже неделю: есть набор данных, но кол-во классов равно кол-ву примеров, задача по новому примеру определить его класс

Sи

решаю методом 1 ближайшего соседа

YB

слушайте, раз уж вы помочь решили, буду нескромным и еще вопросим задам: задачка мучает уже неделю: есть набор данных, но кол-во классов равно кол-ву примеров, задача по новому примеру определить его класс

KNN-like. то есть, смотрим дистанцию до всех примеров, да.

чем лучше функция дистанции — тем лучше будет работать

чем лучше функция дистанции — тем лучше будет работать

Sи

но точность совсем плохая 20% максимум, перепробовал вообще все методы

YB

но точность совсем плохая 20% максимум, перепробовал вообще все методы

улучшать функцию дистанции надоть

YB

фичи там получше найти для дистанции... или популярные-слова выкинуть... или взвесить по TF-IDF

Sи

метрика? брал разную, от эвклидовой и косинуса до Махаланобиса. А это уже не про слова, там разреженные данные и 500 мерное пространство признаков

Sи

или функция дистанции - про что-то другое?

CT

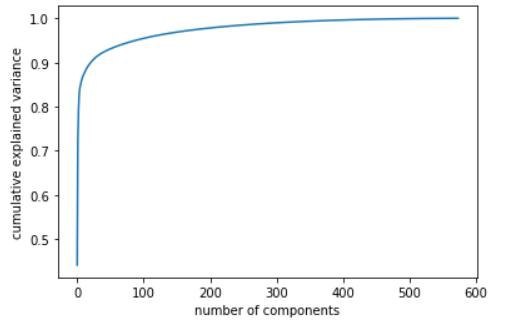

Если данные сильно разрежены, может стоит попробовать размерность сжать?

Sи

пробовал, куда уж без этого, там на 100 мерности дисперсия понижается, сжимал до 150

Sи

при том разными методами понижал

Sи

вот график

YB

метрика? брал разную, от эвклидовой и косинуса до Махаланобиса. А это уже не про слова, там разреженные данные и 500 мерное пространство признаков

Ну, если не про слова, то может быть уже что угодно не так. Для слов типичные параметры пайплайна более-менее подобрали. У вас же с каждым элементом пайплайна можно играться и дебагать ошибки. Какой смысл их просто перебирать, не понимая, что происходит?