GP

Size: a a a

2017 September 28

2017 October 03

TB

всем привет. я тут начал копаться со structured streaming и есть несколько вещей, которые меня смущают в его работе. кто-то уже использовал это в проде?

используем, что смущает?

PE

Коллеги, добрый день =)

Вопрос про spark-streaming + kafka

Пытаюсь оптимизировать существующую обработку.

Использую *Level of Parallelism in Data Receiving* (https://spark.apache.org/docs/2.1.1/streaming-programming-guide.html#level-of-parallelism-in-data-receiving)

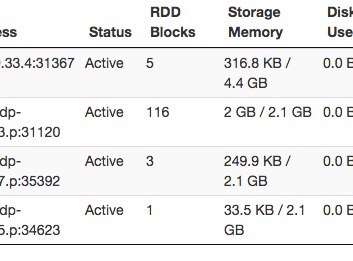

Но по SparkUI вижу что сосет только в одну ноду

Вопрос про spark-streaming + kafka

Пытаюсь оптимизировать существующую обработку.

Использую *Level of Parallelism in Data Receiving* (https://spark.apache.org/docs/2.1.1/streaming-programming-guide.html#level-of-parallelism-in-data-receiving)

numStreams = 3

kafkaStreams = [KafkaUtils.createStream(...) for _ in range (numStreams)]

unifiedStream = streamingContext.union(*kafkaStreams)Но по SparkUI вижу что сосет только в одну ноду

PE

PE

spark 2.1.1, kafka 0.10.1.0, 50 партиций

PE

при этом видно что стримов несколько

PE

2017 October 09

PK

Всем привет, тухловато было в чатике последнее время, пришло время его взбодрить. Мы с коллегами из Яндекса, Одноклассников и Физтеха запустили специализацию на курсере https://www.coursera.org/specializations/big-data-engineering

PK

Она будет полезна не только новичкам, но и практикующим специалистам, которые могут углубить отдельные области знаний.

NK

вот вы молодцы

Ds

Павел, вы уже в яндексе?

Ds

Специализация интересная. Спасибо.

PK

Павел, вы уже в яндексе?

Не, я все еще в Rambler&Co )

R

курс полностью на английском?

PK

R

ок, спасибо, уже купил

PK

2017 October 10

AA

А 1й курс начался уже? Почему то у меня не активен.

R

и у меня

AD

и у меня до сих пор не активен ((