П

Size: a a a

2020 March 02

Норм

П

У меня 93.5 было, максимум 96

А я не попал на регистрацию, ибо был озабочен сменой работы...

Ты использовал sgp4/sdp4?

Ты использовал sgp4/sdp4?

ИБ

Я руками оптимизатор написал

ИБ

Там же синусоида везде со всякими искривлениями

ИБ

Топ решения это линейная регрессия

П

Я руками оптимизатор написал

https://github.com/shkolnick-kun/texts/blob/master/story5/kalman_tle_estimator.ipynb А вот мои потуги, не законченные, и не на тех данных...

ИБ

Да ты бы там дал жару, если бы участвовал

П

Да ты бы там дал жару, если бы участвовал

Оно не доделано, фильтр Калмана иногда такие значения bstar выдает, что спутники падает/улетает в космос.

П

Да ты бы там дал жару, если бы участвовал

Попробую за выходные в другую систему параметров перейти и учесть ограничения по bstar

ИБ

Не думаю что там что то можно интересное найти, но вот мой код

JS

Alexey Tikhonov

Нет, это не важно, значит что-то падает у тебя на новых данных

Но этот же контейнер на локальном докере отрабатывает ок, что там может быть, память?

AT

Да просто что-то к чему ты не готов, 0, не те разделители, новые числа и прочее

GE

JS

Аааа, точно-точно, не подумал об этом

RY

Ω, [02.03.20 12:06]

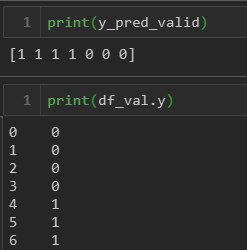

Добрый день. При бинарной классификации не сбалансированных данных у меня f1 практически 90% на тестовых данных. Затем беру валидационные данные(алгоритм векторизации тот же самый что и с обучающей и тестовой выборкой) и провожу классификацию. При этом f1=0, данные были классифицированы с обратными значениями(0й класс определился как 1й и 1й класс как 0й). Валидационные данные после векторизации проверил - 1му классу соот-т именно 1, с 0ым так же все ок. Попробовал поменять метки классов перед классификацией(0 на 1, 1 на 0) - f1 на уровне 99%. Что я сделал не так?

Добрый день. При бинарной классификации не сбалансированных данных у меня f1 практически 90% на тестовых данных. Затем беру валидационные данные(алгоритм векторизации тот же самый что и с обучающей и тестовой выборкой) и провожу классификацию. При этом f1=0, данные были классифицированы с обратными значениями(0й класс определился как 1й и 1й класс как 0й). Валидационные данные после векторизации проверил - 1му классу соот-т именно 1, с 0ым так же все ок. Попробовал поменять метки классов перед классификацией(0 на 1, 1 на 0) - f1 на уровне 99%. Что я сделал не так?

A

Ω, [02.03.20 12:06]

Добрый день. При бинарной классификации не сбалансированных данных у меня f1 практически 90% на тестовых данных. Затем беру валидационные данные(алгоритм векторизации тот же самый что и с обучающей и тестовой выборкой) и провожу классификацию. При этом f1=0, данные были классифицированы с обратными значениями(0й класс определился как 1й и 1й класс как 0й). Валидационные данные после векторизации проверил - 1му классу соот-т именно 1, с 0ым так же все ок. Попробовал поменять метки классов перед классификацией(0 на 1, 1 на 0) - f1 на уровне 99%. Что я сделал не так?

Добрый день. При бинарной классификации не сбалансированных данных у меня f1 практически 90% на тестовых данных. Затем беру валидационные данные(алгоритм векторизации тот же самый что и с обучающей и тестовой выборкой) и провожу классификацию. При этом f1=0, данные были классифицированы с обратными значениями(0й класс определился как 1й и 1й класс как 0й). Валидационные данные после векторизации проверил - 1му классу соот-т именно 1, с 0ым так же все ок. Попробовал поменять метки классов перед классификацией(0 на 1, 1 на 0) - f1 на уровне 99%. Что я сделал не так?

Выглядит, как будто ответ в вопросе

RY

Выглядит, как будто ответ в вопросе

На обучающих и тестовых данных все норм. А почему здесь так происходит?

A

Самое очевидное - в данных перепутаны метки