SD

Size: a a a

2019 December 17

гитхаб открой и смело иди 😈

PM

Не отвечают организаторы, пойду спать

+

ИБ

Stanislav Demchenko

гитхаб открой и смело иди 😈

Так вот по этому поводу и не отвечают

PM

Что там результаты?

DN

пока свои сорцы раскрывать все не хочу, ждёмс организаторов

но вот что могу пошарить, так это пост-процессинг который так неплохо накидывает на финальные результаты

https://gist.github.com/Puzer/4c6f9701aa8617d88f10f591e5873c19

но вот что могу пошарить, так это пост-процессинг который так неплохо накидывает на финальные результаты

https://gist.github.com/Puzer/4c6f9701aa8617d88f10f591e5873c19

P

А я ближайших соседей так ни разу до конца и не досчитала... долго казалось

P

пока свои сорцы раскрывать все не хочу, ждёмс организаторов

но вот что могу пошарить, так это пост-процессинг который так неплохо накидывает на финальные результаты

https://gist.github.com/Puzer/4c6f9701aa8617d88f10f591e5873c19

но вот что могу пошарить, так это пост-процессинг который так неплохо накидывает на финальные результаты

https://gist.github.com/Puzer/4c6f9701aa8617d88f10f591e5873c19

А можешь по простому объяснить, что этот постпроцессинг делает?

DN

хер его знает) писалось в 3 часа ночи

я могу только предполагать

—

Основная идея:

доумножили предсказания (y_pred) которые были получены моделью (вне post-processing) на некоторые коэффициенты

мы знаем что в датасете есть дубликаты вопросов

мы знаем что одни и те же дубликаты могут быть как и в y==1 так и в y==0

соотвественно для таких дубликатов мы хотели бы откорректировать предсказания модели

так же хотели бы их откорректировать и для "near-дубликатов"

т.е. мы юзаем некое априорное знание, которого нету у модели, по сути делая корректировку "исходной" модели

almost/exact я думаю self-explanatory

В трейне есть что-то похожее ? ок, докидываем (как в позитивную, так и негативную сторону)

с knn посложнее

1) тут мы задали векторное пространтсов,

2) меру близости

3) нашли расстояние в этом прострастве до ближайшего примера для X_train[y==0] и X_train[y==0]

4) высчитали разницу расстояний

Примеры:

- если и в трейне_pos и трейне_neg есть один и тот же объект (дубликат) - разница равна нулю - пердсказания не меняются

- если это не полные дубликаты, разница будет не нулевой, вытягивает предсказания в эту сторону

я могу только предполагать

—

Основная идея:

доумножили предсказания (y_pred) которые были получены моделью (вне post-processing) на некоторые коэффициенты

мы знаем что в датасете есть дубликаты вопросов

мы знаем что одни и те же дубликаты могут быть как и в y==1 так и в y==0

соотвественно для таких дубликатов мы хотели бы откорректировать предсказания модели

так же хотели бы их откорректировать и для "near-дубликатов"

т.е. мы юзаем некое априорное знание, которого нету у модели, по сути делая корректировку "исходной" модели

almost/exact я думаю self-explanatory

В трейне есть что-то похожее ? ок, докидываем (как в позитивную, так и негативную сторону)

с knn посложнее

1) тут мы задали векторное пространтсов,

2) меру близости

3) нашли расстояние в этом прострастве до ближайшего примера для X_train[y==0] и X_train[y==0]

4) высчитали разницу расстояний

Примеры:

- если и в трейне_pos и трейне_neg есть один и тот же объект (дубликат) - разница равна нулю - пердсказания не меняются

- если это не полные дубликаты, разница будет не нулевой, вытягивает предсказания в эту сторону

DN

вобщем сейчас уже 2 ночи, я тоже уже не соображаю)

возможно это всё можно было сделать как-то проще

возможно это всё можно было сделать как-то проще

MK

а без него какой скор?

P

хер его знает) писалось в 3 часа ночи

я могу только предполагать

—

Основная идея:

доумножили предсказания (y_pred) которые были получены моделью (вне post-processing) на некоторые коэффициенты

мы знаем что в датасете есть дубликаты вопросов

мы знаем что одни и те же дубликаты могут быть как и в y==1 так и в y==0

соотвественно для таких дубликатов мы хотели бы откорректировать предсказания модели

так же хотели бы их откорректировать и для "near-дубликатов"

т.е. мы юзаем некое априорное знание, которого нету у модели, по сути делая корректировку "исходной" модели

almost/exact я думаю self-explanatory

В трейне есть что-то похожее ? ок, докидываем (как в позитивную, так и негативную сторону)

с knn посложнее

1) тут мы задали векторное пространтсов,

2) меру близости

3) нашли расстояние в этом прострастве до ближайшего примера для X_train[y==0] и X_train[y==0]

4) высчитали разницу расстояний

Примеры:

- если и в трейне_pos и трейне_neg есть один и тот же объект (дубликат) - разница равна нулю - пердсказания не меняются

- если это не полные дубликаты, разница будет не нулевой, вытягивает предсказания в эту сторону

я могу только предполагать

—

Основная идея:

доумножили предсказания (y_pred) которые были получены моделью (вне post-processing) на некоторые коэффициенты

мы знаем что в датасете есть дубликаты вопросов

мы знаем что одни и те же дубликаты могут быть как и в y==1 так и в y==0

соотвественно для таких дубликатов мы хотели бы откорректировать предсказания модели

так же хотели бы их откорректировать и для "near-дубликатов"

т.е. мы юзаем некое априорное знание, которого нету у модели, по сути делая корректировку "исходной" модели

almost/exact я думаю self-explanatory

В трейне есть что-то похожее ? ок, докидываем (как в позитивную, так и негативную сторону)

с knn посложнее

1) тут мы задали векторное пространтсов,

2) меру близости

3) нашли расстояние в этом прострастве до ближайшего примера для X_train[y==0] и X_train[y==0]

4) высчитали разницу расстояний

Примеры:

- если и в трейне_pos и трейне_neg есть один и тот же объект (дубликат) - разница равна нулю - пердсказания не меняются

- если это не полные дубликаты, разница будет не нулевой, вытягивает предсказания в эту сторону

Спасибо за объяснение... я даже днем не могда додуматься, как дубликаты, кроме счетчиков использовать.

AT

Так что там давало основные эджи ? Я что-то нарегэкспил и в логрег и 72 и всё....

JS

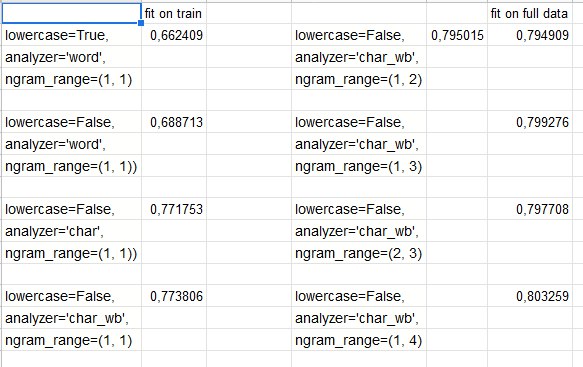

Я ещё векторизировал одно-, би- и три-граммы, прунинг, и тфидф

AT

А по частям есть разбивка ? Например вот именно это сразу с 70 до 75 и т.д.?

SF

А результаты-то будут?

SF

Или там не было прайвата и это конечные результаты?

N

JS

Alexey Tikhonov

А по частям есть разбивка ? Например вот именно это сразу с 70 до 75 и т.д.?

ну tfidf и прочая школо-nlp дает 0.65-0.67 где-то, а вот регэкспы много докидывают, надо было еще и с дубликатами поколдовать - некогда было, ну и топики поэкстрактить, да эмеддинги кластеризовать... короче можно было много чего еще сделать

Р

Не использовал регэкспы вообще. Менял только настройки tfidf, и сверху lgbm.