AS

Size: a a a

2021 July 02

в диаграмме которую я скинул одна и та же вьюха используется дважды -_-

B

Ну так это же от задачи зависит. Может задача одноразовая. А часто используемая материализованная вью - это уже витрина)

A

😂

A

на самом деле если задача большая то такое автоматом появляется)

+ спарк очень не понятно рисует стадии тяжело потом понять где конкретно джоба тормозит

+ спарк очень не понятно рисует стадии тяжело потом понять где конкретно джоба тормозит

А

а кто что с такими планами делает? я любитель материализовать в физические таблицы

А

особенно, если несколько раз 1 и тоже

А

можно еще persist сделать, но чет как то реже

AS

задача не одноразовая, это новый регулярный батч процесс.

размеры всех участвующих в процессе табличек:

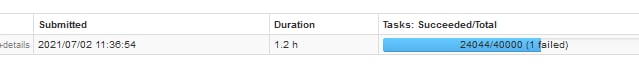

запущено было на 10 хостах

за 1.2 часа джоба не завершилась и ее убили

думаю из эти данных можно сделать заключение о высокой оптимальности архитектурного решения

размеры всех участвующих в процессе табличек:

fdxxx.xxx 200MiBв пике было 300 executors - 3GiB executor memory each

fdxxx.xxx 1.2GiB

fdxxx.xxx 600KiB

lzxxx.xxx 10MiB

lzxxx.xxx 6KiB

lzxxx.xxx 1.9GiB

запущено было на 10 хостах

за 1.2 часа джоба не завершилась и ее убили

думаю из эти данных можно сделать заключение о высокой оптимальности архитектурного решения

AZ

Если объёмы небольшие то наверное не так страшно, в противном случае напомнить ему что это не терадата, тут думать надо!

AS

ну я вот выше расписал что оно с общим объемом инпута в 3GiB на приличном количестве ресурсов не смогло прожевать

D

хороший момент продолжить тот разговор про vault и его джоин на джоине, джоином погоняет :)

AZ

Комментарий про терадату тогда уместен)

NN

Анкор ещё)

А

вероятно, там будут простые join, где оптимизатору негде ошибиться

AZ

Photon надо брать, если так уж хочется в spark api писать свой датаволт

NN

А вертика? Она ж вроде теперь дружит со спарком.

N

В зависимости от сжатия ваши 3гига в памяти легко превращаются в 10-20. Скорее всего тут был обычный перекос и все эти 1.2 часа молотил один экзекьютор с 1.5гиг реальной доступной ему памяти, а остальные отдыхали.

N

И это ни о чем не говорит