AZ

Size: a a a

2021 June 06

Вы держите свои форки ASF проектов с нетривиальными изменениями?

NN

Нет, а что?

AZ

Ну там чтобы нормально в продакшене заработало кое что надо дописать

UD

+++

AZ

Если ресурсы есть - конечно берите, мб что-то полезное для остальных обратно в проект законтрибьютите

NN

А, понял. Считайте, что мы вот только в самом-самом начале пути. При необходимости, если появится понимание, что это то, что нужно, и нужно это как-то адаптировать и продвинуть, то ресурсы на это есть.

Р

😂😂😂

Д

Подскажите как перехватить ошибку выполнения таска и продолжить выполнение дальше. Ошибка при мерже схем паркетов в партиции. Использую spark/scala. Try/cath не помогает на моем уровне понимания.

Д

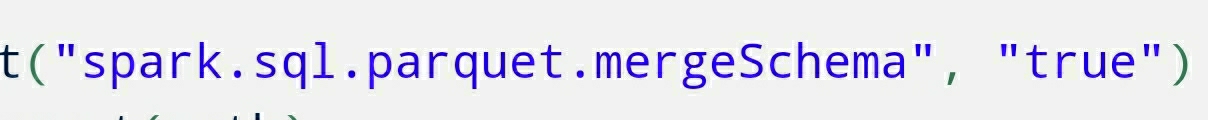

Ошибка возникает при использовании опции

Д

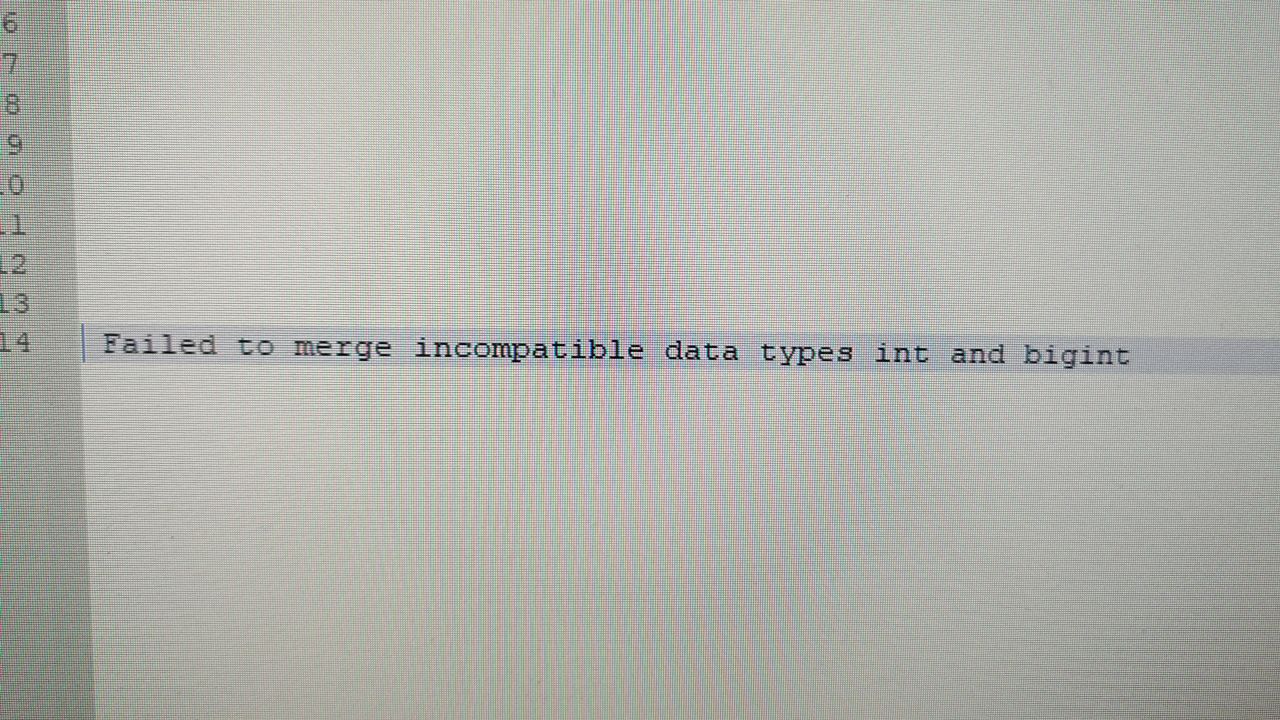

Есть расхождение типов в одном поле, тип может бвть string, int, bigint.

NN

О, Дженкинс

ИК

Какое сообщение у возникающего исключения? И хотя бы пару строк из стека исключений

Д

Но, я уже решил проблему. Вернее обошел ее. Но вопрос поймать падение таска и продолжить выполнение остался.

SK

%spark

val start = Integer.parseInt(z.input("Старт даты", "20210301").toString) // вводим дату и переводим её в целое число для дальнейших операций

val end = Integer.parseInt(z.input("Конец даты", "20210531").toString) // с интервалом времени

val XRange = Range( start, end, 1 )

// val predict = udf((edata: Double) => if (Range(20210301, 20210531, 1 ).contains(edata)) true else false) // Пользовательская функция подсчёта попадания в интервал дат

val predict = udf{ edata: String => if (XRange.contains(edata)) true else false}

val out = b2c_users_table

….

.withColumn("datetime", from_unixtime($"timestamp", "yyyMMdd")) //Урезали шаблон вывода времени по датам (больше для поиска и не надо нам)

.withColumn("Date", predict($"datetime")) // Делаем запрос к UDF функции и тут же называем новое поле "Date"

.filter(!$"Date".contains(false))

//.select($"uid", $"Date")

.groupBy($"uid")

.agg(count("*").as("count"))

.filter($"count" >= 3) // фильтруем тех пользователей, которые аутентифцировались от трёх раз

.select($"uid")

//.show(100, false)

.count()

val start = Integer.parseInt(z.input("Старт даты", "20210301").toString) // вводим дату и переводим её в целое число для дальнейших операций

val end = Integer.parseInt(z.input("Конец даты", "20210531").toString) // с интервалом времени

val XRange = Range( start, end, 1 )

// val predict = udf((edata: Double) => if (Range(20210301, 20210531, 1 ).contains(edata)) true else false) // Пользовательская функция подсчёта попадания в интервал дат

val predict = udf{ edata: String => if (XRange.contains(edata)) true else false}

val out = b2c_users_table

….

.withColumn("datetime", from_unixtime($"timestamp", "yyyMMdd")) //Урезали шаблон вывода времени по датам (больше для поиска и не надо нам)

.withColumn("Date", predict($"datetime")) // Делаем запрос к UDF функции и тут же называем новое поле "Date"

.filter(!$"Date".contains(false))

//.select($"uid", $"Date")

.groupBy($"uid")

.agg(count("*").as("count"))

.filter($"count" >= 3) // фильтруем тех пользователей, которые аутентифцировались от трёх раз

.select($"uid")

//.show(100, false)

.count()

2021 June 07

dz

Всем привет. Подскажите плиз, можно ли в airflow посмотреть DAGи, которые выгружают больше всего данных, то есть как-то понять, в какую базу летит больше всего данных? Например, в логах? Но в логах я не нашел.

ИК

Большому коду - большой разбор))

Ответил в личку

Ответил в личку