Natural Language State Representation for Reinforcement Learning

Erez Schwartz et al. Technion

arxiv.org/abs/1910.02789RL страдает от "проклятья размемерности".

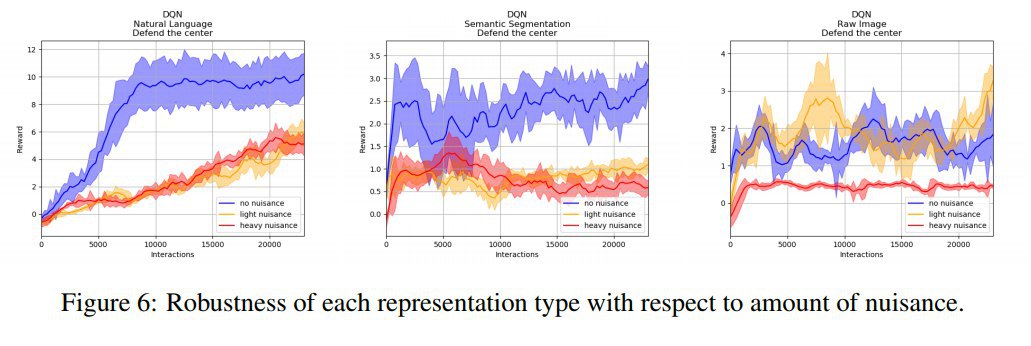

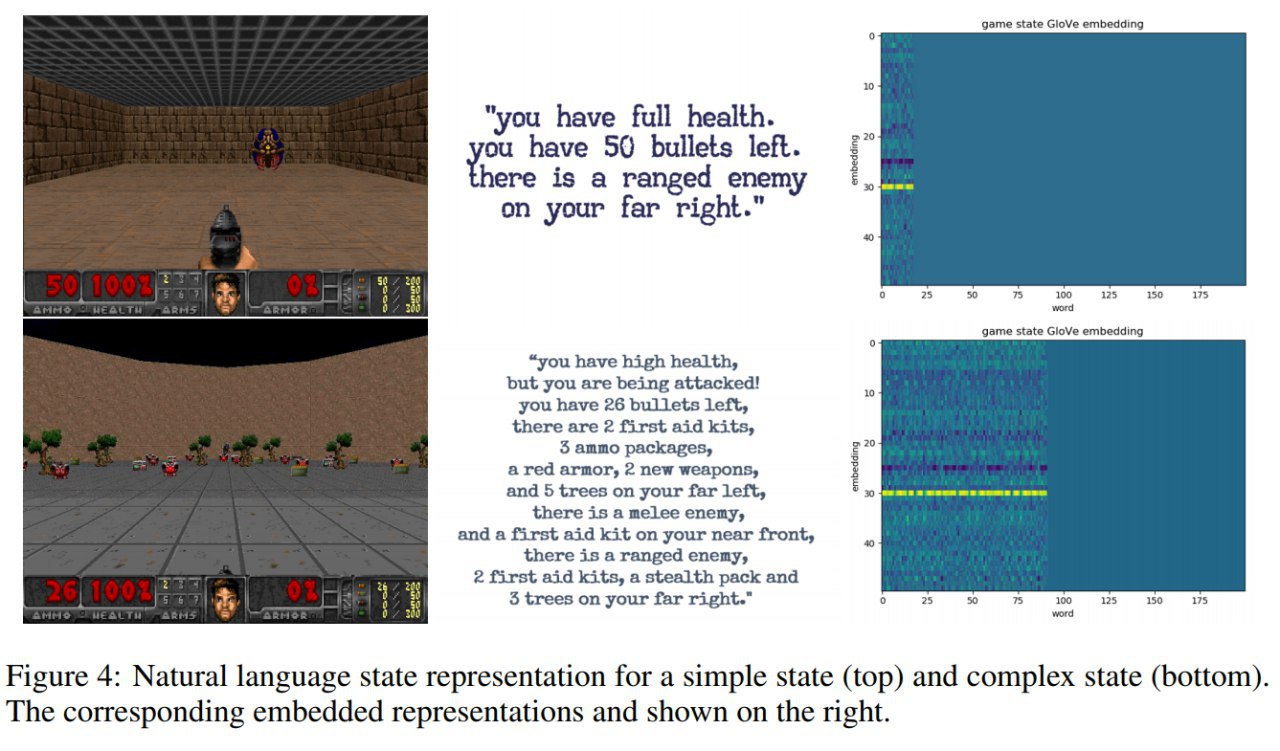

Если использовать естественный язык для семантического представления состояний, например, описывая что просиходит на экране в игре Doom, то в сравнении с vision-based агентами:

- сходимость быстрее

- perform better

- more robust

- better transfer

Информация для представления на естественном языке извлекалась из игровых фич и семантической сегментации с наложенной сеткой для понимания позиции объектов: далеко-близко, правее-левее.

Сравнивались:

▫️

Агенты:

- DQN

- PPO

▫️

Представления:

- Semantic segmentation representations (provided by the environment)

- Natural language representation (features from environment + semantic segmentation + Word2Vec или

GloVe + TextCNN)

- Raw image (CNN)

- Feature vector (features from environment + MLP)

▫️

Игровые сценарии:

- Пристрели монстра

- Не умри от яда собирая аптечки

- Уклоняйся от файерболов

- Defend the center - отстреливайся от набегающих монстров, стоя на месте

- Адище